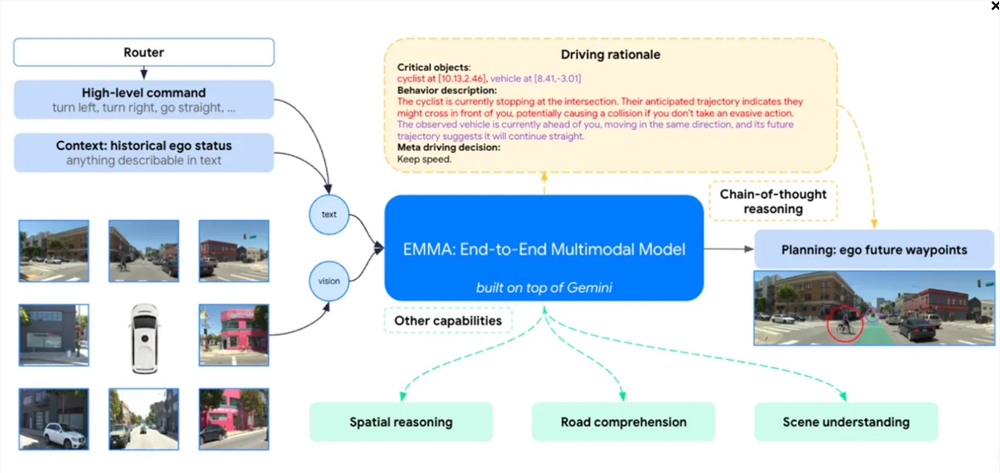

A Waymo anunciou recentemente um grande avanço, desenvolvendo um novo modelo de treinamento baseado no Modelo de Linguagem Multimodal (MLLM) do Google para o seu desenvolvimento de táxi autônomo. Esse novo modelo, chamado Emma (modelo multimodal de ponta a ponta para direção autônoma), é capaz de processar dados do sensor para gerar trajetórias futuras para veículos autônomos, ajudando os carros sem motorista a decidir para onde ir e como evitar obstáculos.

O modelo Emma é um dos primeiros sinais de que os líderes em um plano de direção autônomo de usar MLLMs em suas operações, sugerindo que esses LLMs podem escapar de seus usos atuais como chatbots, gerentes de e -mail e geradores de imagens e, em um ambiente completamente novo na estrada, encontre o Aplicação em.

A equipe de pesquisa de Waymo diz que os MLLs como Gemini fornecem soluções interessantes para sistemas de direção autônomos por dois motivos: os chatbots são um "generalista" que "pode fornecer mais do que isso depois de ser treinado em uma grande quantidade de dados rastejados da Internet" Conhecimento 'do conteúdo contido em toras de direção comuns;

O modelo Emma de Waymo tem um bom desempenho na previsão de trajetória, detecção de objetos e compreensão do roteiro, mas também possui limitações, como a incapacidade de integrar entradas de sensor 3D do Lidar ou Radar e só pode processar um pequeno número de quadros de imagem por vez. O uso da MLLM para treinar táxis autônomos também representa riscos, como modelos podem experimentar alucinações ou não concluir tarefas simples

. Portanto, Waymo disse que são necessárias mais pesquisas para aliviar esses problemas e desenvolver ainda mais as mais recentes tecnologias na arquitetura de modelos de direção autônoma.

O avanço de Waymo demonstra a direção futura de desenvolvimento da tecnologia de direção autônoma e traz novas esperança e desafios à indústria.