A pesquisa mais recente no campo da inteligência artificial revela uma surpreendente semelhança entre grandes modelos de linguagem (LLMS) e estruturas cerebrais humanas. Através da análise aprofundada do espaço de ativação do LLM, os cientistas do MIT descobriram que sua estrutura interna tem uma correspondência significativa com os níveis de micro, meso e macro do cérebro humano. Essa descoberta não apenas fornece uma nova perspectiva para entendermos como a IA funciona, mas também estabelece as bases para o desenvolvimento futuro dos sistemas de IA mais inteligentes.

A IA realmente começou a "cultivar seu cérebro"?! As pesquisas mais recentes do MIT mostram que a estrutura interna de grandes modelos de linguagem (LLMS) tem realmente semelhanças com o cérebro humano!

Este estudo usou a tecnologia de autoencoder esparsa para realizar uma análise aprofundada do espaço de ativação do LLM e descobriu três níveis de características estruturais, o que foi incrível:

Primeiro, no nível microscópico, os pesquisadores descobriram a existência de uma estrutura "cristalina". Os rostos desses "cristais" são compostos de paralelogramas ou trapézios, semelhantes às analogias familiares do vocabulário como "Man: Women: King: Queen".

O que é ainda mais surpreendente é que essas estruturas "cristalinas" se tornam mais claras depois de remover alguns fatores de interferência irrelevantes (como comprimento da palavra) através de técnicas de análise discriminante linear.

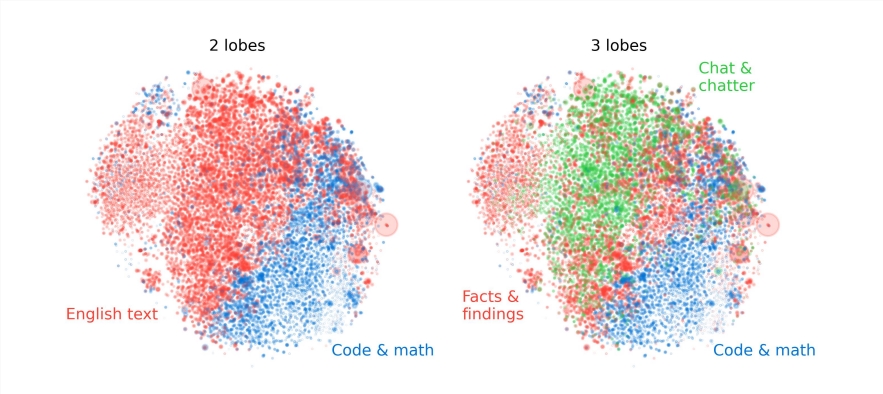

Em segundo lugar, no nível meso, os pesquisadores descobriram que o espaço de ativação do LLM possui uma estrutura modular semelhante à partição funcional do cérebro humano.

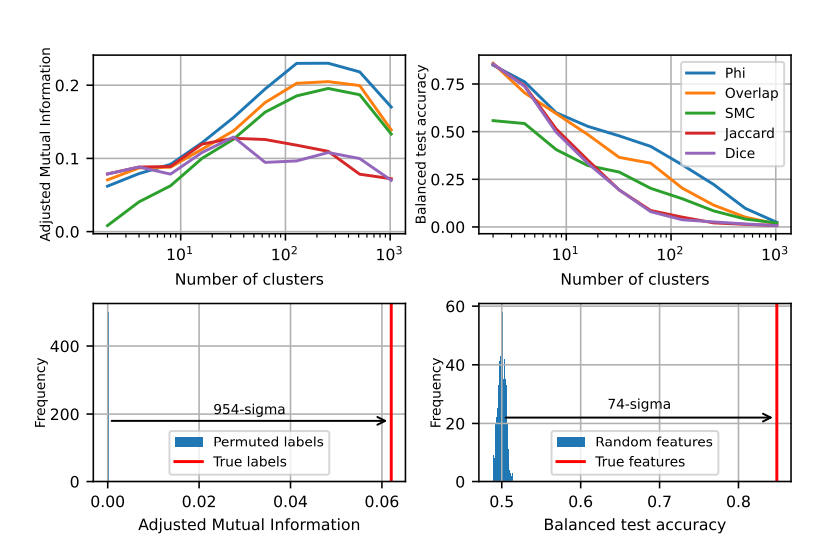

Por exemplo, recursos relacionados à matemática e código se reunirão para formar um "lobo cerebral" semelhante ao lobo funcional do cérebro humano. Através da análise quantitativa por múltiplos indicadores, os pesquisadores confirmaram a localidade espacial desses "lobos cerebrais", indicando que as características co-ocorrentes também são mais concentradas espacialmente, excedendo em muito as expectativas de distribuição aleatória.

No nível macro, os pesquisadores descobriram que a estrutura geral da nuvem de pontos de características LLM não é isotrópica, mas mostra uma distribuição de autovalor de lei do poder, e essa distribuição é mais óbvia na camada intermediária.

Os pesquisadores também quantificaram a entropia de agrupamento em diferentes níveis e descobriram que a entropia de agrupamento da camada intermediária era menor, indicando que a representação dos recursos estava mais concentrada, enquanto a entropia de agrupamento das camadas precoces e tardias foi maior, indicando que a representação do recurso foi mais disperso.

Este estudo fornece uma nova perspectiva para entendermos os mecanismos internos de grandes modelos de idiomas e estabelece as bases para o desenvolvimento futuro de sistemas de IA mais poderosos e mais inteligentes.

Este estudo não apenas revela a semelhança entre a IA e o cérebro humano, mas também fornece uma nova direção para o desenvolvimento futuro da tecnologia de IA, indicando que a IA se tornará mais inteligente e eficiente.