Com o rápido desenvolvimento de modelos de grandes linguagens multimodais (MLLMs), as tarefas relacionadas à imagem e do vídeo foram lançadas em avanços sem precedentes, especialmente nos campos de perguntas e respostas visuais, geração narrativa e edição interativa. No entanto, apesar do progresso significativo nessas tecnologias, alcançar a compreensão do conteúdo de vídeo fino continua sendo um problema difícil a ser resolvido. Esse desafio envolve não apenas a segmentação e o rastreamento no nível de pixels com descrições de idiomas, mas também tarefas complexas, como perguntas e respostas visuais em avisos de vídeo específicos.

Embora os atuais modelos de percepção de vídeo de última geração tenham um bom desempenho nas tarefas de segmentação e rastreamento, eles ainda são inadequados em recursos de entendimento e diálogo em linguagem aberta. O vídeo MLLMS, embora tenha um bom desempenho na compreensão de vídeo e nas tarefas de perguntas e respostas, ainda não conseguem lidar com tarefas perceptivas e pistas visuais. Essa limitação limita seu uso em uma ampla gama de cenários.

As soluções existentes são divididas principalmente em duas categorias: modelos de grandes idiomas multimodais (MLLMs) e sistemas de segmentação de referência. O MLLMS inicialmente se concentrou em melhorar os métodos de fusão multimodal e os extratores de recursos, e gradualmente se transformou em uma estrutura para ajuste de instrução no LLMS, como o LLAVA. Recentemente, os pesquisadores tentaram unificar imagens, vídeos e análises de várias imagens em uma única estrutura, como a Llava-Onevision. Ao mesmo tempo, o sistema de segmentação de referência também passou por uma transformação de módulos básicos de fusão em segmentação e rastreamento integrados. No entanto, essas soluções ainda têm deficiências na integração abrangente dos recursos de percepção e compreensão do idioma.

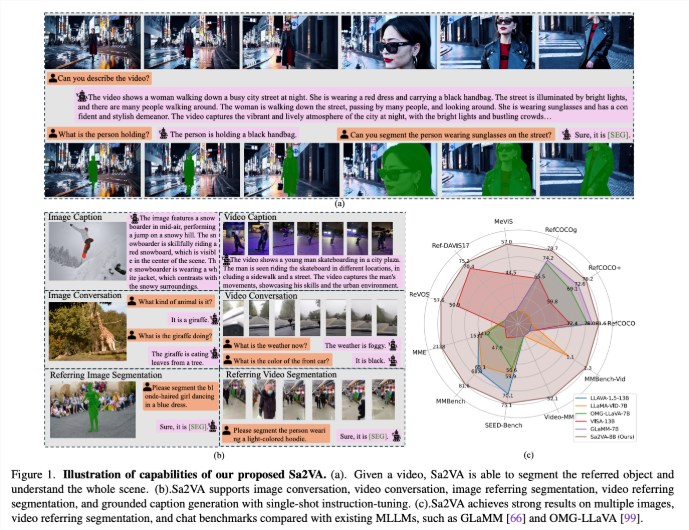

Pesquisadores da UC Merced, Bytedance Seed Team, Wuhan University e Peking University propuseram o SA2VA, um modelo unificado inovador projetado para obter um entendimento básico intensivo de imagens e vídeos. Esse modelo supera as limitações dos modelos multimodais de grandes idiomas existentes, minimizando o ajuste único de instruções e suportando uma ampla gama de tarefas de imagem e vídeo.

O SA2VA integra inovador a SAM-2 com a LLAVA para unificar texto, imagens e vídeo em um espaço de token LLM compartilhado. Além disso, os pesquisadores lançaram um extenso conjunto de dados de anotação automática chamada REF-SAV, que contém expressões de objetos em mais de 72 mil cenários de vídeo complexos, e 2K verificou manualmente objetos de vídeo para garantir recursos robustos de benchmarking.

A arquitetura do SA2VA é composta principalmente por duas partes: um modelo semelhante ao LLAVA e SAM-2 e adota um novo design de desacoplamento. O componente do tipo Llava inclui um codificador visual que processa imagens e vídeos, uma camada de projeção visual e um LLM para previsão de token de texto. O sistema adota um método de desacoplamento exclusivo que permite que o SAM-2 opere ao lado do modelo de LLava pré-treinado sem troca direta de token, mantendo assim a eficiência computacional e permitindo o plug-in e a desconectação com vários MLLMs pré-treinados se conectam.

Os resultados da pesquisa mostram que o SA2VA alcançou resultados de ponta na tarefa de segmentação de citação, com seu modelo SA2VA-8B com pontuações de CIOU no Refcoco, Refcoco+ e Refcocog, respectivamente, superando sistemas anteriores, como o GLAM-7B. Em termos de recursos de diálogo, o SA2VA alcançou excelentes resultados de 2128, 81,6 e 75.1 no MME, MMBEnch e bancada de sementes, respectivamente.

Além disso, o desempenho da SA2VA nos benchmarks de vídeo superou significativamente o estado anterior-Visa-13B do estado de arte, mostrando sua eficiência e eficácia nas tarefas de compreensão de imagem e vídeo.

Papel: https://arxiv.org/abs/2501.04001

Modelo: https://huggingface.co/collections/bytedance/sa2va-model-zoo-677e3084d71b5f108d00e093

Pontos -chave:

O SA2VA é uma nova estrutura de IA unificada que alcança uma compreensão profunda de imagens e vídeos e supera as limitações dos modelos multimodais existentes.

O modelo alcançou resultados de última geração em vários benchmarks, como segmentação de citação e recursos de diálogo, mostrando excelente desempenho.

O design do SA2VA integra efetivamente os recursos de compreensão visual e de linguagem por meio de um método de desacoplamento, suportando uma ampla gama de tarefas de imagem e vídeo.