Com o rápido desenvolvimento da tecnologia de inteligência artificial, o Modelo de Linguagem de Grande Linguagem (LLM) desempenha um papel cada vez mais importante nas aplicações modernas. Seja um chatbot, um gerador de código ou outras tarefas baseadas em processamento de linguagem natural, os recursos do LLM se tornaram o principal driver. No entanto, com a expansão contínua da escala do modelo e o aumento da complexidade, os problemas de eficiência no processo de inferência se tornaram gradualmente proeminentes, especialmente ao processar dados em larga escala e cálculos complexos, o atraso e o consumo de recursos se tornaram gargalos que precisam ser resolvidos urgentemente.

Como o componente principal do LLM, o mecanismo de atenção afeta diretamente a eficiência de inferência do modelo. No entanto, mecanismos de atenção tradicionais, como flashattion e SparsaSeation, geralmente têm um desempenho ruim quando se deparam com diversas cargas de trabalho, modos de entrada dinâmicos e restrições de recursos da GPU. Alta latência, gargalos de memória e baixa utilização de recursos restringiram seriamente a escalabilidade e a velocidade de resposta da inferência de LLM. Portanto, o desenvolvimento de uma solução eficiente e flexível tornou -se o foco da pesquisa atual.

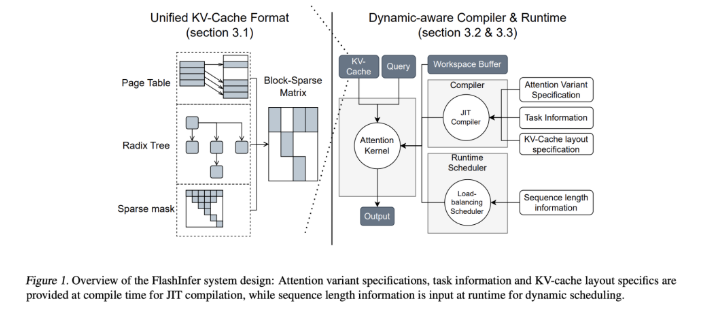

Para enfrentar esse desafio, equipes de pesquisa da Universidade de Washington, Nvidia, Perplexity AI e Carnegie Mellon University desenvolveram em conjunto o Flashinfer. Esta é uma biblioteca de inteligência artificial e um gerador de kernel projetado especificamente para o raciocínio LLM, projetado para otimizar vários mecanismos de atenção, incluindo flashattion, sparsaSeation, pageation e amostragem através de núcleos de GPU de alto desempenho. A filosofia de design do Flashinfer enfatiza a flexibilidade e a eficiência, pode responder efetivamente aos principais desafios nos serviços de inferência da LLM e fornece soluções práticas para inferência em modelos de idiomas em larga escala.

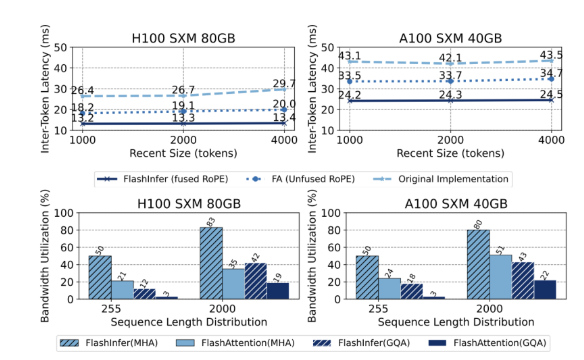

Os principais recursos técnicos do FlashInfer incluem os seguintes aspectos: Primeiro, fornece suporte abrangente no kernel, cobrindo vários mecanismos, como preenchimento, decodificação e atenção adicional. Desempenho dos cenários de solicitação e serviço em lote. Em segundo lugar, através da atenção da consulta agrupada (GQA) e da atenção da posição rotacional fundida (corda), o flashinfer alcança melhorias significativas de desempenho na decodificação rápida longa, 31 vezes mais rápida que a atenção da página da VLLM. Além disso, o agendador de balanceamento dinâmico de carga do FlashInfer pode ajustar dinamicamente de acordo com as alterações de entrada, reduzir o tempo ocioso da GPU e garantir o uso eficiente dos recursos. Sua compatibilidade com os gráficos CUDA aprimora ainda mais sua aplicabilidade em ambientes de produção.

Em termos de desempenho, o FlashInfer tem um bom desempenho em vários benchmarks, especialmente ao lidar com inferência de contexto longa e tarefas de geração paralela, reduzindo significativamente a latência. Na GPU NVIDIA H100, o Flashinfer alcança um aumento de velocidade de 13 a 17% em tarefas de geração paralela. Seu agendador dinâmico e núcleo otimizado melhoram significativamente a largura de banda e a utilização do flop, permitindo a utilização eficiente dos recursos da GPU, seja em comprimentos de sequência desiguais ou uniformes. Essas vantagens tornam o FlashInfer uma ferramenta importante para promover o desenvolvimento da estrutura de serviço LLM.

Como um projeto de código aberto, o FlashInfer não apenas fornece soluções eficientes para os desafios de raciocínio do LLM, mas também incentiva colaboração e inovação adicionais na comunidade de pesquisa. Seus recursos flexíveis de design e integração permitem que ele se adapte à alteração das necessidades de infraestrutura de IA e garantir que ela permaneça à frente de sua liderança no enfrentamento dos desafios emergentes. Através dos esforços conjuntos da comunidade de código aberto, o Flashinfer deve desempenhar um papel mais importante no desenvolvimento futuro da tecnologia de IA.

Entrada do projeto: https://github.com/flashinfer-ai/flashinfer

Pontos -chave:

O FlashInfer é uma biblioteca de inteligência artificial recém -lançada, projetada para um grande raciocínio de modelos de idiomas e pode melhorar significativamente a eficiência.

Esta biblioteca suporta vários mecanismos de atenção, otimiza a utilização de recursos da GPU e reduz a latência da inferência.

Como um projeto de código aberto, o FlashInfer recebe os pesquisadores para participar para promover a inovação e o desenvolvimento da infraestrutura de IA.