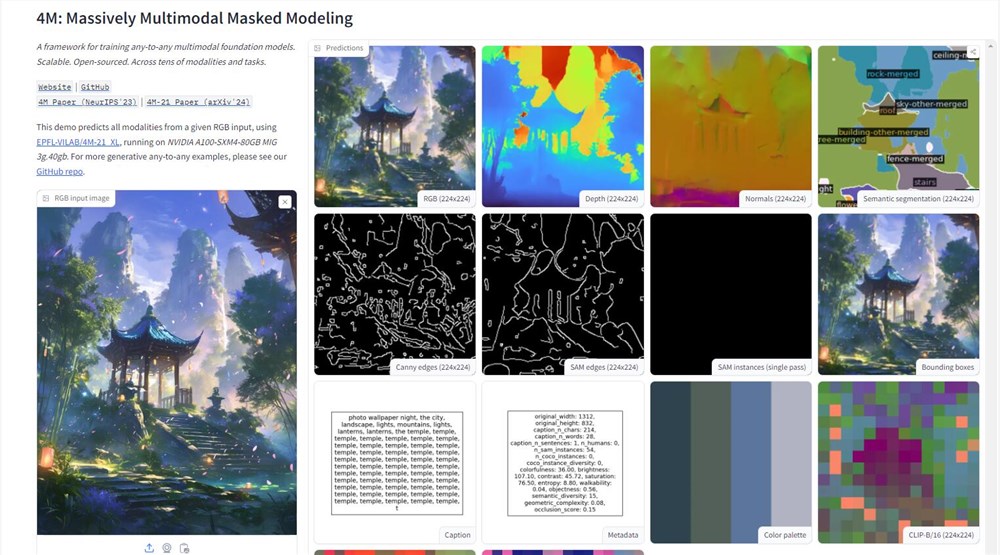

A Apple deu um passo importante no campo da inteligência artificial e revelou uma demonstração do modelo 4M na plataforma de rosto de abraço. Esse modelo de IA multimodal pode processar uma variedade de tipos de dados, como texto, imagens e cenas 3D, demonstrando poderosos recursos de processamento de informações. Ao fazer upload de uma imagem, os usuários podem obter facilmente informações detalhadas, como mapas de profundidade, desenhos de linha, etc. da figura, que marcam um grande avanço no aplicativo de tecnologia da AI da Apple.

O núcleo técnico do modelo 4M reside em seu método de treinamento "Modelagem de blindagem multimodal em larga escala". Esse método permite que o modelo processe várias modalidades visuais simultaneamente, convertendo imagem, informações semânticas e geométricas em tokens unificados, alcançando assim a conexão perfeita entre diferentes modalidades. Esse design não apenas melhora a versatilidade do modelo, mas também abre novas possibilidades para futuros aplicativos de IA multimodais.

A mudança da Apple quebrou sua tradição consistente de confidencialidade no campo de P&D e demonstrou ativamente sua força tecnológica na plataforma de IA de código aberto. Ao abrir o modelo 4M, a Apple não apenas demonstra a natureza avançada de sua tecnologia de IA, mas também estendeu um ramo de azeitona à comunidade de desenvolvedores, na esperança de construir um ecossistema próspero em torno de 4m. Isso anuncia a possibilidade de aplicações mais inteligentes no ecossistema da Apple, como o Siri mais inteligente e o mais eficiente Cut Pro.

No entanto, o lançamento do modelo 4M também trouxe desafios na prática de dados e na ética da IA. Como modelo de IA com uso intensivo de dados, como proteger a privacidade do usuário e promover o progresso tecnológico será um problema que a Apple precisa considerar seriamente. A Apple sempre se considerou um protetor de privacidade do usuário.

Em termos de métodos de treinamento, o 4M adota um método de marcação inovador selecionado aleatoriamente: Participando da marcação como entrada e a outra parte como alvo, alcançando assim a escalabilidade da meta de treinamento. Esse design permite que o 4M trate as imagens e o texto como marcadores digitais, melhorando bastante a flexibilidade e a adaptabilidade do modelo.

Os dados de treinamento do modelo 4M são do CC12M, um dos maiores conjuntos de dados de código aberto do mundo. Embora esse conjunto de dados seja rico em dados, as informações de rotulagem não são perfeitas. Para resolver esse problema, os pesquisadores adotaram um método de pseudo-etiqueta fracamente supervisionado, usaram clipe, maskrcnn e outras tecnologias para fazer previsões abrangentes do conjunto de dados e depois converter os resultados de previsão em tokens, estabelecendo uma base sólida para a compatibilidade multimodal da 4M.

Após uma extensa experimentação e teste, a 4M provou ser capaz de executar tarefas multimodais diretamente sem a necessidade de um grande número de pré-treinamento ou ajuste fino de tarefas específicas. É como dar à IA uma faca multimodal do exército suíço que permite lidar com vários desafios. O lançamento do 4M não apenas demonstra a força técnica da Apple no campo da IA, mas também aponta a direção para o desenvolvimento futuro dos aplicativos de IA.

Endereço da demonstração: https://huggingface.co/spaces/epfl-vilab/4m