Кай Ли 1 , Венди Сан 1 , Чан Цзэн 2 , Жуньсюань Ян 1 , Го Чен 1 , Сяолинь Ху 1

1 Университет Цинхуа, Китай

2 Национальный институт информатики, Япония

Бумага | Демо

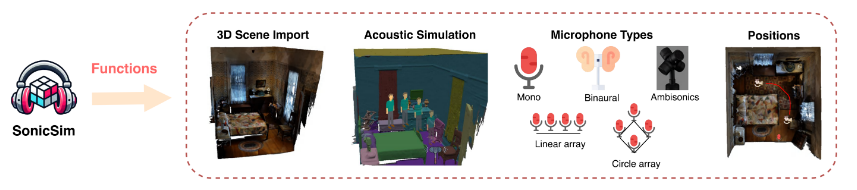

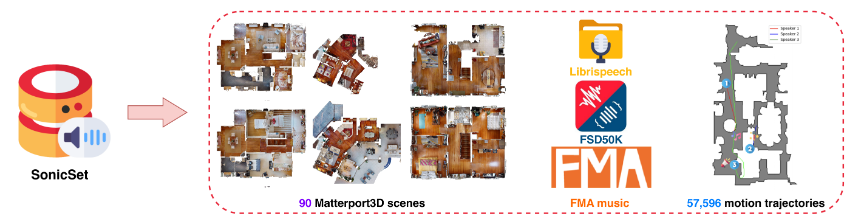

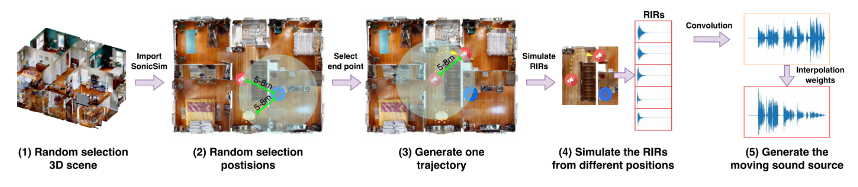

Мы представляем SonicSim, синтетический набор инструментов, предназначенный для генерации настраиваемых данных для движущихся источников звука. SonicSim разработан на основе встроенной платформы моделирования искусственного интеллекта Habitat-sim, поддерживающей многоуровневую настройку параметров, включая уровень сцены, уровень микрофона и уровень источника, тем самым генерируя более разнообразные синтетические данные. Используя SonicSim, мы создали тестовый набор данных движущихся источников звука SonicSet, используя набор данных LibriSpeech, набор данных Freesound 50k (FSD50K) и Free Music Archive (FMA), а также 90 сцен из Matterport3D для оценки моделей разделения и улучшения речи.

[2024-10-30] Мы исправили ошибки при установке среды и обновили обучающий код для моделей разделения речи и улучшения в наборе данных SonicSet.

[2024-10-23] Мы выпускаем training code для моделей разделения и улучшения речи в наборе данных SonicSet.

[2024-10-03] Мы публикуем статью на arxiv

[2024-10-01] Мы выпускаем набор данных о реальном разделении речи, целью которого является оценка эффективности моделей разделения речи в реальных сценариях.

[2024-07-31] Мы выпускаем SonicSim dataset , который включает в себя задачи разделения и улучшения речи.

[2024-07-24] Мы выпускаем скрипты для dataset construction и предварительно обученные модели для speech separation and enhancement .

Импорт 3D-сцен: поддерживает импорт различных 3D-ресурсов из таких наборов данных, как Matterport3D, что позволяет эффективно и масштабируемо создавать сложные акустические среды.

Моделирование акустической среды:

Имитирует отражения звука в геометрии помещения, используя акустическое моделирование в помещении и алгоритмы двунаправленного отслеживания пути.

Сопоставляет семантические метки 3D-сцен со свойствами материала, устанавливая коэффициенты поглощения, рассеяния и пропускания поверхностей.

Синтезирует данные движущегося источника звука на основе траекторий источника, обеспечивая высокую точность воспроизведения в реальных условиях.

Конфигурации микрофонов: предлагает широкий спектр настроек микрофонов, включая моно, бинауральные и Ambisonics, а также поддержку пользовательских линейных и круглых микрофонных решеток.

Расположение источника и микрофона: обеспечивает настройку или рандомизацию положения источника звука и микрофона. Поддерживает траектории движения для моделирования движущихся источников звука, добавляя реалистичности динамическим акустическим сценариям.

Вы можете скачать предварительно созданный набор данных по следующей ссылке:

| Имя набора данных | Onedrive | Байду Диск |

|---|---|---|

| папка поезда (40 разделенных файлов RAR, 377G) | [Ссылка для скачивания] | [Ссылка для скачивания] |

| val.rar (4.9G) | [Ссылка для скачивания] | [Ссылка для скачивания] |

| test.rar (2.2G) | [Ссылка для скачивания] | [Ссылка для скачивания] |

| сентябрьские тестовые данные (8,57G) | [Ссылка для скачивания] | [Ссылка для скачивания] |

| данные enh-теста (7,70G) | [Ссылка для скачивания] | [Ссылка для скачивания] |

| Имя набора данных | Onedrive | Байду Диск |

|---|---|---|

| Реальный набор данных (1.0G) | [Ссылка для скачивания] | [Ссылка для скачивания] |

Набор данных RealMAN: RealMAN

Чтобы создать набор данных самостоятельно, обратитесь к README в папке SonicSim-SonicSet/data-script . В этом документе представлены подробные инструкции по использованию предоставленных сценариев для создания набора данных.

Чтобы настроить среду для обучения и вывода, используйте предоставленный файл YAML:

conda create -n SonicSim-Train python=3.10 Конда активирует SonicSim-Train pip install Cython==3.0.10 numpy==1.26.4 pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r require.txt -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

Перейдите в каталог separation и запустите следующий сценарий, чтобы создать фиксированный набор проверки:

разделение компакт-дисков pythongenerate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-sep-2 --is_mono pythongenerate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

Перейдите в каталог enhancement и запустите следующий сценарий, чтобы сгенерировать фиксированный набор проверки:

улучшение компакт-диска pythongenerate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-enh-noise --is_mono pythongenerate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

Перейдите в каталог separation и запустите сценарий обучения с указанным файлом конфигурации:

разделение компакт-дисков python train.py --conf_dir=configs/afrcnn.yaml

Перейдите в каталог enhancement и запустите сценарий обучения с указанным файлом конфигурации:

улучшение компакт-диска python train.py --conf_dir=config/dccrn.yaml

Пожалуйста, проверьте содержимое README.md в папках sep-checkpoints и enh-checkpoints, загрузите соответствующие предварительно обученные модели в Release и разархивируйте их в соответствующие папки.

Перейдите в каталог separation и запустите сценарий вывода с указанным файлом конфигурации:

разделение компакт-дисков python inference.py --conf_dir=../sep-checkpoints/TFGNet-Noise/config.yaml

Перейдите в каталог enhancement и запустите сценарий вывода с указанным файлом конфигурации:

улучшение компакт-диска python inference.py --conf_dir=../enh-checkpoints/TaylorSENet-Noise/config.yaml

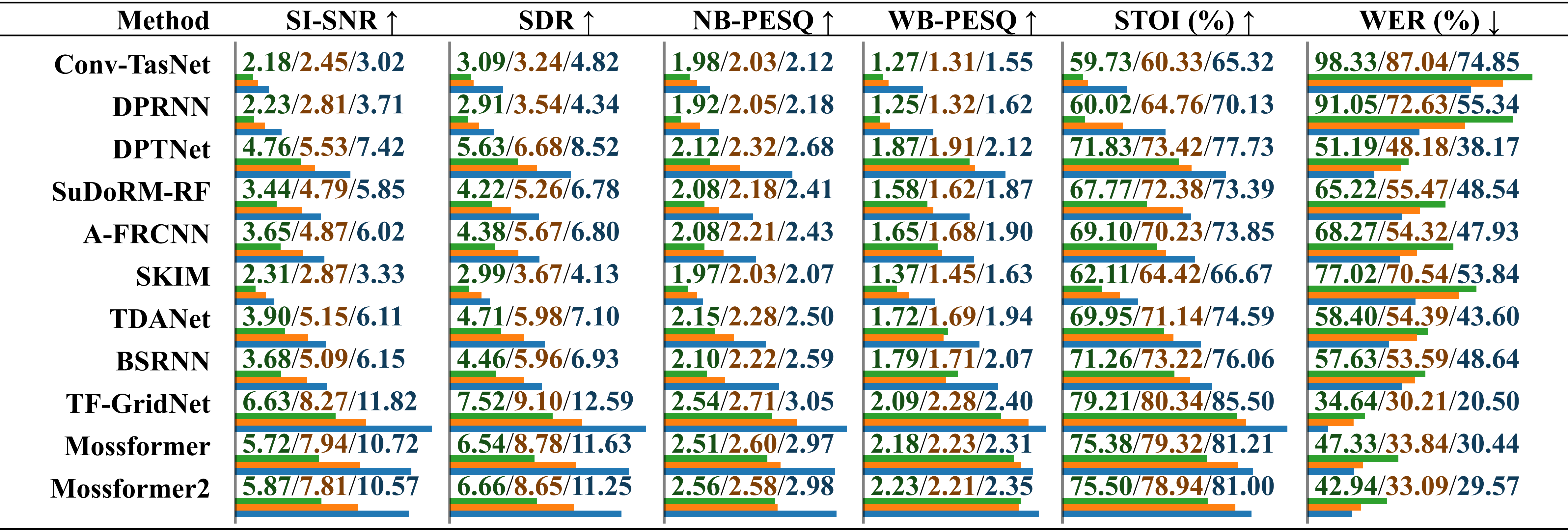

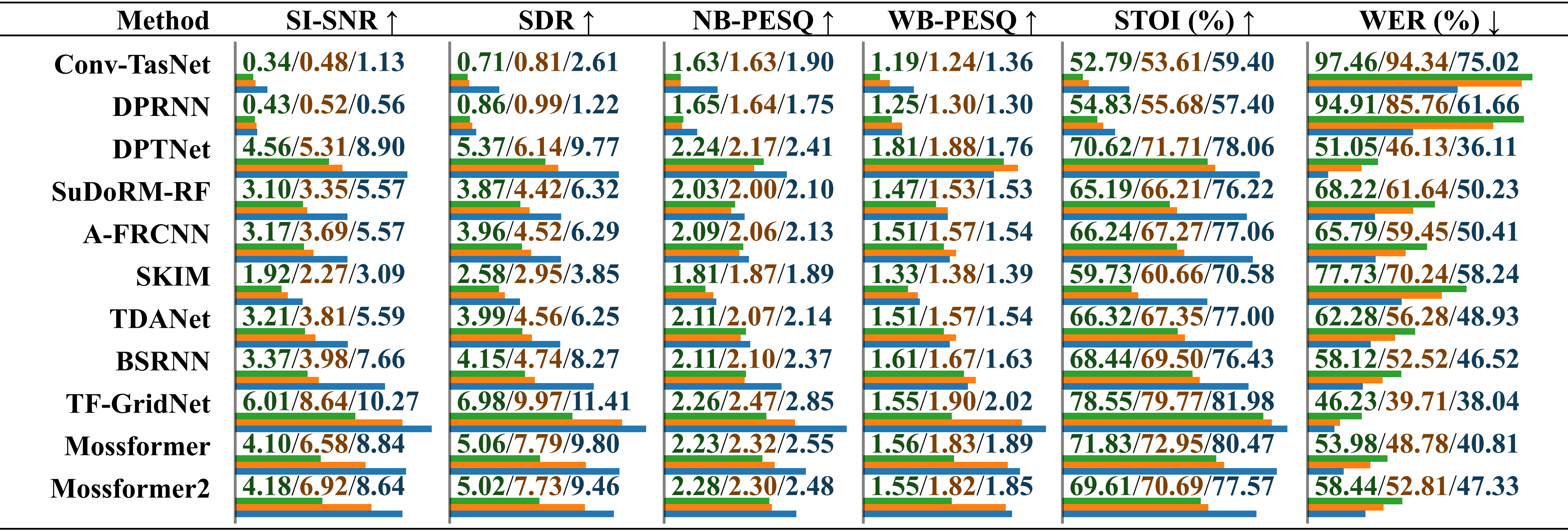

Сравнительная оценка производительности моделей, обученных на разных наборах данных с использованием реального записанного звука и шума окружающей среды . Результаты сообщаются отдельно для «обученных на LRS2-2Mix», «обученных на Libri2Mix» и «обученных на SonicSet», отмеченных косой чертой. Относительная длина указывается под значением горизонтальными полосами.

Сравнительная оценка производительности моделей, обученных на разных наборах данных с использованием реального записанного звука с музыкальным шумом . Результаты сообщаются отдельно для «обученных на LRS2-2Mix», «обученных на Libri2Mix» и «обученных на SonicSet», отмеченных косой чертой.

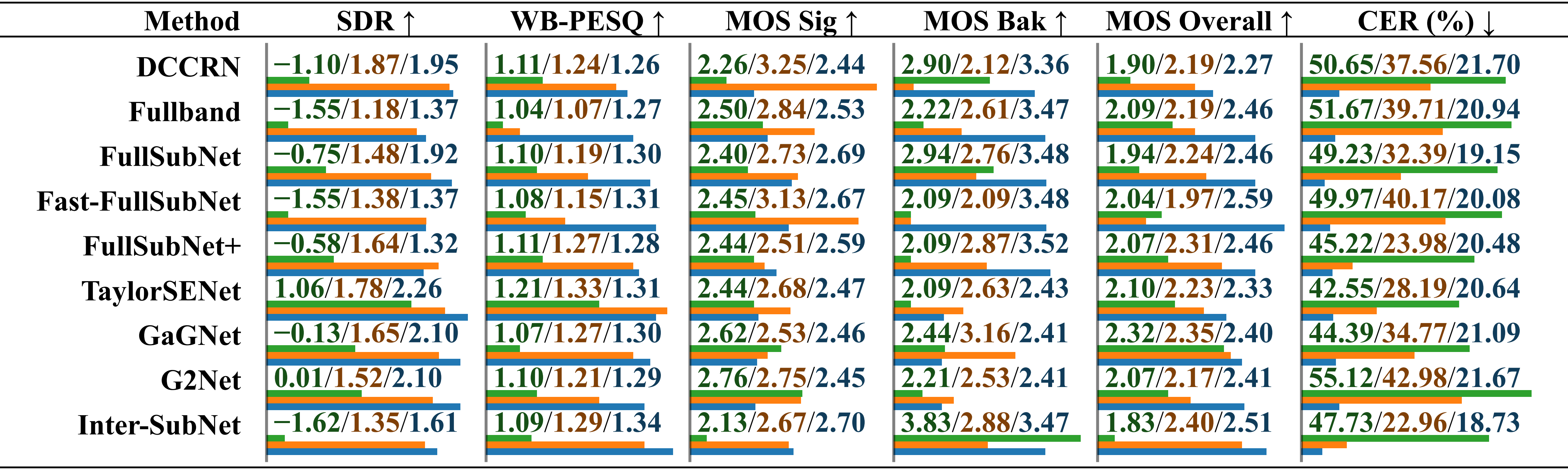

Сравнительная оценка производительности моделей, обученных на разных наборах данных с использованием набора данных RealMAN. Результаты сообщаются отдельно для «обученных на VoiceBank+DEMAND», «обученных на DNS Challenge» и «обученных на SonicSet», отмеченных косой чертой.

Мы обучили модели разделения и улучшения на наборе данных SonicSet. Результаты следующие:

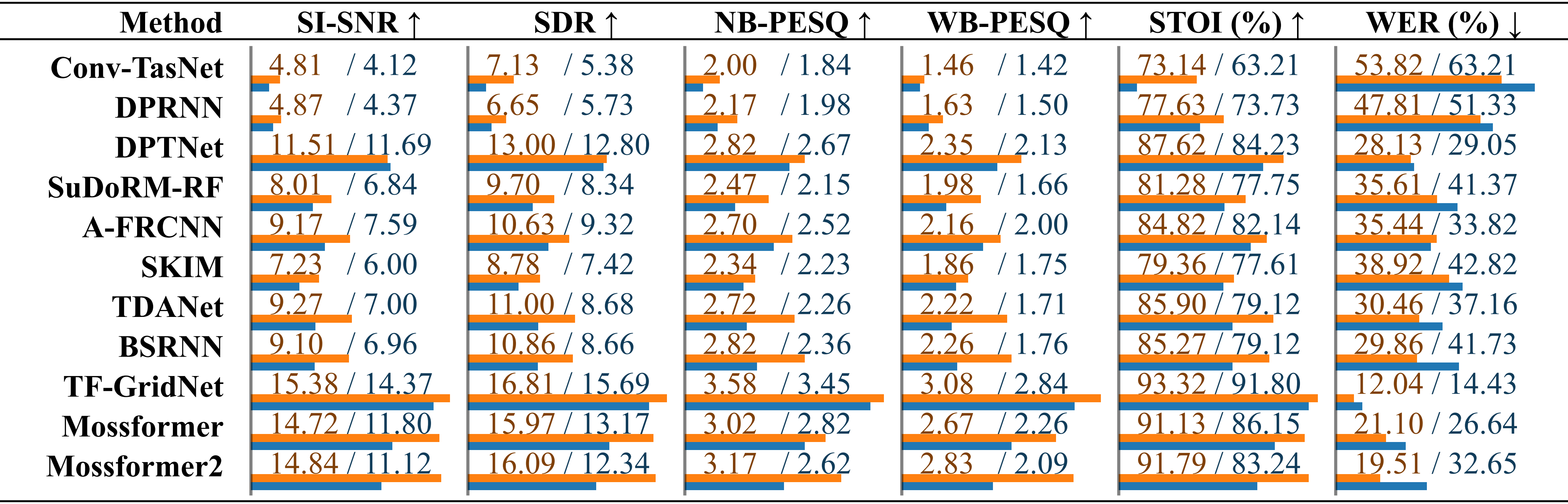

Сравнение существующих методов разделения речи в наборе данных SonicSet. Производительность каждой модели указана отдельно для результатов в разделах «шум окружающей среды» и «музыкальный шум», отмеченных косой чертой.

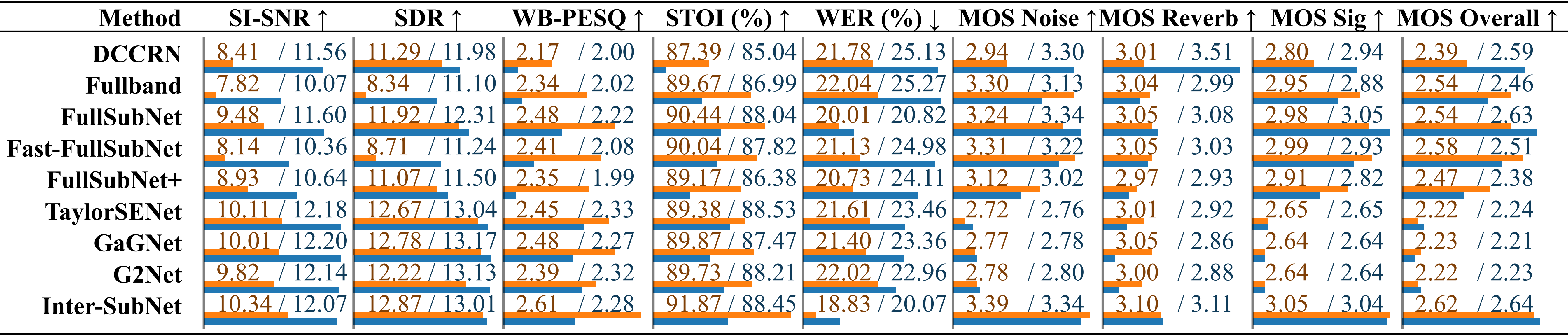

Сравнение существующих методов улучшения речи на сайте Сравнение методов улучшения речи с использованием тестового набора SonicSet. Показатели перечислены отдельно в разделах «Экологический шум» и «Музыкальный шум», отмеченные косой чертой.

Хотим выразить благодарность следующим лицам:

LibriSpeech для предоставления речевых данных.

SoundSpaces для среды моделирования.

Apple за предоставление сценариев динамического синтеза звука.

Эта работа доступна под лицензией Creative Commons Attribution-ShareAlike 4.0 International License.