5/8/2024 .: Обновите код вывода GPT-3.5 и LLama2 и результаты для рисунка 6, который показывает зарождающуюся природу когнитивной синергии.3/15/2024 .: Эта статья была принята в качестве основного доклада конференции NAACL2024! pip install -r requirements.txt

config_template.sh и запустите source config_template.sh чтобы настроить переменные env (обратите внимание, что в наших экспериментах мы используем Azure API). Мы предоставляем сценарии запуска для каждой из трех задач. Дополнительную информацию см. в комментариях к сценариям «.sh»:

bash scripts/trivia_creative_writing.shbash scripts/codenames_collaborative.shbash scripts/logic_grid_puzzle.sh Все подсказки можно найти в папке prompts/ .

Все наборы данных можно найти в папке data/ .

Результаты экспериментов в статье по каждой задаче можно найти в папке logs/ . gpt4_w_sys_mes и gpt4_wo_sys_mes содержат результаты, соответствующие таблице 2 нашей статьи. Мы также включили результаты gpt-3.5 и llama2-13b, соответствующие результатам на рисунке 6, где гиперпараметры, такие как добавление системного сообщения, соответствуют наиболее эффективным вариантам в экспериментах gpt4.

"test_output_infos" : содержит показатели оценки для каждого экземпляра, например, # упомянутых правильных ответов."*raw_responses" : необработанные ответы от каждого вызова API."*parsing_flag" : успешно ли анализируется необработанный ответ. (для задачи «Кодовые имена» это поле разделено на «parsing_success_flag_spymaster» и «parsing_success_flag_guesser»)"unwrapped_output" : проанализированный вывод, который будет использоваться для вычисления показателей оценки. (для задачи «Кодовые имена» это поле разделено на «spymaster_output» и «guesser_output»; существует дополнительное поле с именем «hint_word», которое анализируется из выходных данных Spymaster и вставляется во входные данные Guesser; метрика оценки вычисляется на основе « догадавшийся_выход")"task data" : данные для текущего экземпляра задачи, например, вопросы, ответы, целевые слова и т. д."usage" : регистрация количества токенов и затрат, потраченных на данный момент.Пожалуйста, цитируйте статью и отмечайте этот репозиторий, если вы считаете эту работу интересной/полезной.

@article{wang2023unleashing,

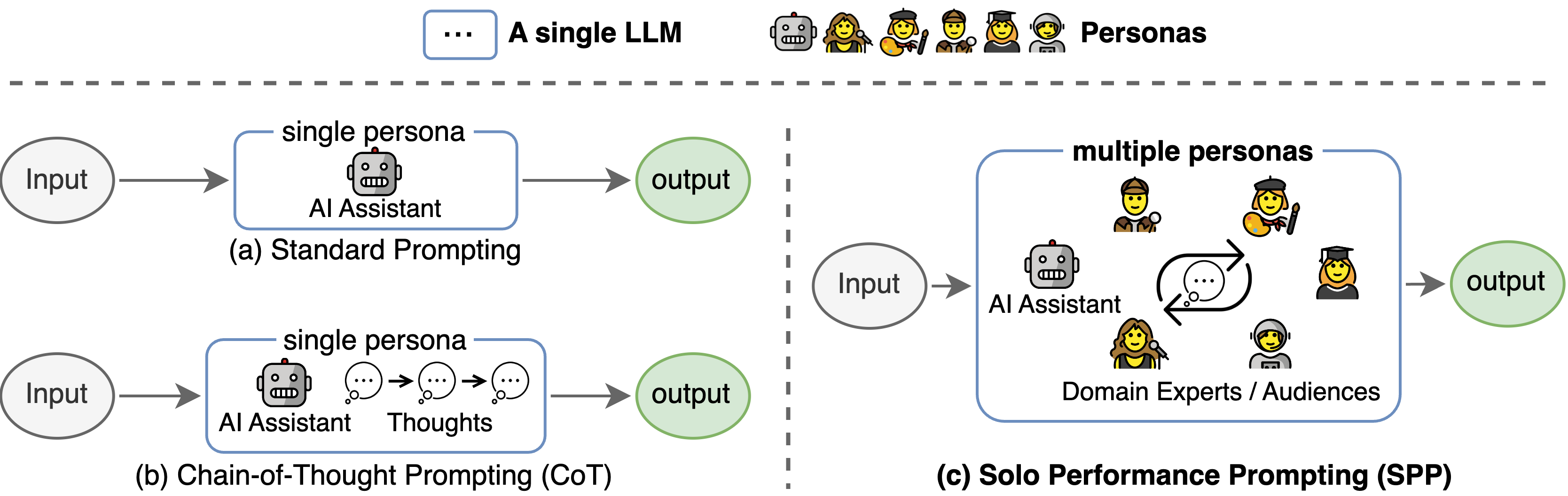

title={Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration},

author={Wang, Zhenhailong and Mao, Shaoguang and Wu, Wenshan and Ge, Tao and Wei, Furu and Ji, Heng},

journal={arXiv preprint arXiv:2307.05300},

year={2023}

}

Эта кодовая база ссылается на структуру официального репозитория Tree-of- Thought. Мы благодарим авторов за их усилия по открытию исходного кода.