Оглядываясь назад на прошлый процесс обучения, можно сказать, что видео учителей Нг Энда и Ли Хонги оказали мне большую помощь на моем пути углубленного обучения. Их юмористические методы объяснения, а также простые и интуитивно понятные объяснения делают скучное теоретическое обучение живым и интересным.

Однако на практике многие студенты сначала будут беспокоиться о том, как получить API крупных иностранных моделей. Хотя в конечном итоге они могут найти решение, страх перед трудностями в первый раз всегда будет задерживать прогресс в обучении и постепенно меняться. «просто смотрю видео». Я часто вижу подобные обсуждения в зоне комментариев, поэтому решил использовать свое свободное время, чтобы помочь студентам преодолеть этот порог. Это также первоначальная цель проекта.

Этот проект не будет предоставлять учебные пособия по научному доступу в Интернет и не будет опираться на интерфейсы, адаптированные к платформе. Вместо этого он будет использовать более совместимый OpenAI SDK, чтобы помочь каждому получить более общие знания.

Проект начнется с простых вызовов API и постепенно приведет вас в мир больших моделей. В процессе вы овладеете такими навыками, как обобщение видео AI , тонкая настройка LLM и генерация изображений AI .

Для одновременного обучения настоятельно рекомендуется просмотреть курс преподавателя Ли Хунъи «Введение в генеративный искусственный интеллект»: быстрый доступ к ссылкам по курсу.

Теперь в проекте также есть CodePlayground. Вы можете настроить среду согласно документации, запустить скрипт одной строкой кода и ощутить прелести ИИ.

«Эссе диссертаций находятся в PaperNotes, а основные статьи, связанные с большими моделями, будут загружаться постепенно.

Базовый образ готов. Если вы еще не настроили собственную среду глубокого обучения, вы можете попробовать Docker.

Желаю хорошей поездки!

--- : Базовые знания, смотрите по мере необходимости или временно пропустите. Результаты файла кода будут показаны в статье, но все равно рекомендуется запускать код вручную. Могут быть требования к видеопамяти.API : в статье используется API только больших моделей, на него не распространяются ограничения по устройствам и его можно запускать без графического процессора.LLM : Практика, связанная с большими языковыми моделями, файлы кода могут иметь требования к видеопамяти.SD : Стабильная диффузия, практика, связанная с диаграммами Винсента, и файлы кода имеют требования к видеопамяти.File , и эффект обучения будет таким же.Setting -> Accelerator ->选择GPU .代码执行程序->更改运行时类型->选择GPU .| Гид | Ярлык | Описывать | Файл | Онлайн |

|---|---|---|---|---|

| 00. Этапы получения API большой модели Alibaba | API | Мы проведем вас шаг за шагом, чтобы получить API. Если вы регистрируетесь впервые, вам необходимо выполнить проверку личности (распознавание лиц). | ||

| 01. Первое знакомство с LLM API: настройка среды и демонстрация многораундового диалога. | API | Это вводная конфигурация и демонстрация. Код диалога изменен из документации по разработке Alibaba. | Код | Каггл Колаб |

| 02. Легко начать: создавайте приложения искусственного интеллекта с помощью API и Gradio. | API | Руководство по использованию Gradio для создания простого приложения искусственного интеллекта. | Код | Колаб |

| 03. Расширенное руководство: настройка подсказки для улучшения возможностей решения проблем с большими моделями | API | Вы научитесь настраивать подсказку, чтобы улучшить способность больших моделей решать математические задачи. Также будут предоставлены версии Gradio и не-Gradio, а также будут показаны детали кода. | Код | Каггл Колаб |

| 04. Понимание LoRA: от линейного слоя к механизму внимания | --- | Прежде чем официально приступить к практике, вам необходимо знать основные концепции LoRA. Эта статья проведет вас от реализации LoRA на линейном уровне к механизму внимания. | ||

05. Познакомьтесь с серией AutoModel Hugging Face: классы автоматической загрузки моделей для различных задач. | --- | Модуль, который мы собираемся использовать, — это AutoModel в Hugging Face. Эта статья также является обязательным знанием (конечно, вы можете пропустить ее и прочитать позже, если у вас есть сомнения). | Код | Каггл Колаб |

| 06. Начало работы: разверните свою первую языковую модель | Магистр права | Реализуя очень простое развертывание языковой модели, проект пока не предъявляет каких-либо жестких требований к графическому процессору, вы можете продолжать обучение. | Код app_fastapi.py app_flask.py | |

| 07. Изучите взаимосвязь между параметрами модели и видеопамятью, а также влияние различной точности. | --- | Понимание соответствия параметров модели и видеопамяти, а также владение методами импорта различной точности сделают выбор модели более умелым. | ||

| 08. Попробуйте настроить LLM: пусть он пишет стихи Тан. | Магистр права | Эта статья аналогична статье 03. Расширенное руководство: Настройка подсказок для улучшения возможностей решения проблем с большими моделями. В основном основное внимание уделяется «использованию», а не «написанию». Вы можете получить представление об общем процессе, как и раньше. раздел гиперпараметров, чтобы увидеть влияние на точную настройку. | Код | Каггл Колаб |

| 09. Глубокое понимание Beam Search: принципы, примеры и реализация кода. | --- | Переходя от примеров к демонстрации кода и объяснению математики поиска луча, это должно прояснить некоторую путаницу из предыдущего чтения и, наконец, предоставить простой пример использования библиотеки Hugging Face Transformers (вы можете попробовать ее, если пропустили предыдущую статью). . | Код | Каггл Колаб |

| 10. Top-K против Top-P: стратегия выборки и влияние температуры в генеративных моделях | --- | Далее, чтобы показать вам другие стратегии генерации. | Код | Каггл Колаб |

| 11. Пример тонкой настройки DPO: оптимизация модели большого языка LLM в соответствии с предпочтениями человека. | Магистр права | Пример тонкой настройки с использованием DPO. | Код | Каггл Колаб |

| 12. Атрибуция функций Inseq: визуально интерпретируйте результаты LLM | Магистр права | Наглядные примеры задач по переводу и генерации текста (заполните пробелы). | Код | Каггл Колаб |

| 13. Поймите возможные предубеждения в ИИ | Магистр права | Не нужно разбираться в коде, его можно использовать как увлекательное исследование в свободное время. | Код | Каггл Колаб |

| 14. PEFT: быстрое применение LoRA к большим моделям. | --- | Узнайте, как добавить слои LoRA после импорта модели. | Код | Каггл Колаб |

| 15. Используйте API для реализации сводки видео с искусственным интеллектом: создайте своего собственного видеопомощника с искусственным интеллектом. | API и LLM | Вы изучите принципы, лежащие в основе обычных помощников по составлению сводок видео с помощью искусственного интеллекта, и начнете внедрять обобщение видео с помощью искусственного интеллекта. | Код - полная версия Код — облегченная версия ? сценарий | Каггл Колаб |

| 16. Используйте LoRA для точной настройки стабильной диффузии: разберите алхимическую печь и создайте свою первую картину с помощью ИИ. | СД | Используйте LoRA для точной настройки модели диаграммы Винсента, и теперь вы также можете предоставлять свои файлы LoRA другим. | Код Код – облегченная версия | Каггл Колаб |

| 17. Краткое обсуждение квантования модели RTN: асимметричный и симметричный.md. | --- | Чтобы лучше понять количественное поведение модели RTN, в этой статье в качестве примера для объяснения используется INT8. | Код | Каггл Колаб |

| 18. Обзор технологии количественной оценки модели и анализ формата файлов GGUF/GGML. | --- | Это обзорная статья, которая может развеять некоторые ваши сомнения при использовании GGUF/GGML. | ||

| 19a. От загрузки к разговору: запуск квантованных больших моделей LLM (GPTQ и AWQ) локально с помощью Transformers. 19б. От загрузки к диалогу: локальный запуск квантованных больших моделей LLM (GGUF) с использованием Llama-cpp-python. | Магистр права | Вы развернете на своем компьютере количественную модель с 7 миллиардами (7B) параметров. Обратите внимание, что для этой статьи не требуется видеокарта. 19 a Использование преобразователей, включающее загрузку модели в форматах GPTQ и AWQ. 19 б. Использование Llama-cpp-python с загрузкой модели в формате GGUF. Кроме того, вы также завершите функцию взаимодействия с диалогом локальной большой модели. | Код-Трансформеры Код-Llama-cpp-python ? сценарий | |

| 20. Вводная практика RAG: от разделения документов до векторной базы данных и построения вопросов и ответов. | Магистр права | Практика, связанная с RAG. Узнайте, как работает рекурсивное разделение текста. | Код | |

| 21. BPE против WordPiece: понимание принципа работы Tokenizer и метода сегментации подслов. | --- | Основные операции Tokenizer. Узнайте об распространенных методах сегментации подслов: BPE и WordPiece. Ознакомьтесь с маской внимания (Attention Mask) и идентификаторами типов токенов (Token Type ID). | Код | Каггл Колаб |

| 22. Задание – Берт дорабатывает экстрактивный ответ на вопрос. | Это задание, в котором используется BERT для точной настройки последующих задач с вопросами и ответами. Вы можете попробовать его и попытаться присоединиться к «конкурсу» Kaggle. Через неделю вам будет предоставлена статья-руководство со всеми советами. Вы можете начать обучение прямо сейчас. или оставьте это на потом. Во вступительной статье не будет описания задания, а для изучения будут загружены две версии кода, так что не волнуйтесь. Здесь не будет никаких сроков. | Код — Назначение | Каггл Колаб |

Кончик

Если вы предпочитаете использовать хранилище для локального чтения .md , то при возникновении ошибки формулы используйте Ctrl+F или Command+F , найдите \_ и замените все на _ .

Дальнейшее чтение:

| Гид | Описывать |

|---|---|

| а. Используйте HFD для ускорения загрузки моделей и наборов данных Hugging Face. | Если вы чувствуете, что загрузка модели происходит слишком медленно, вы можете обратиться к этой статье для настройки. Если вы столкнулись с ошибкой 443, связанной с прокси-сервером, вы также можете попробовать прочитать эту статью. |

| б. Быстрая проверка основных команд командной строки (применимо к Linux/Mac). | Быстрая проверка командной строки в основном содержит все команды, задействованные в текущем складе. Проверьте ее, если вы запутались. |

| в. решения некоторых проблем. | Здесь мы решим некоторые проблемы, с которыми можно столкнуться в ходе работы проекта. - Как вытащить удаленный склад, чтобы перезаписать все локальные модификации? - Как просмотреть и удалить файлы, загруженные Hugging Face, и как изменить путь сохранения? |

| d. Как загрузить модель GGUF (решение проблемы Shared/Shared/Split/00001-of-0000...) | - Узнайте о новых возможностях Трансформеров о GGUF. - Используйте Transformers/Llama-cpp-python/Ollama для загрузки файлов модели в формате GGUF. - Научитесь объединять фрагментированные файлы GGUF. — Решить проблему невозможности выгрузки LLama-cpp-python. |

| e. Улучшение данных: анализ распространенных методов torchvision.transforms. | - Понимать часто используемые методы улучшения данных изображения. Код | |

| f. Функция перекрестной энтропийной потери nn.CrossEntropyLoss() Подробное объяснение и напоминание о ключевых моментах (PyTorch). | - Понимать математические принципы перекрестной энтропии и реализации PyTorch. - Узнайте, на что следует обратить внимание при первом использовании. |

| g. Слой внедрения nn.Embedding(), подробное объяснение и напоминание о ключевых моментах (PyTorch). | - Понимать концепции встраивания слоев и встраивания слов. - Визуализация внедрения с использованием предварительно обученных моделей. Код | |

| h Используйте Docker для быстрой настройки среды глубокого обучения (Linux). h. Знакомство с основными командами Docker и устранение распространенных ошибок. | - Используйте две строки команд для настройки среды глубокого обучения. - Знакомство с основными командами Docker. - Решить три распространенные ошибки во время использования |

Объяснение папки:

Демо

Все файлы кода будут храниться там.

данные

Храните небольшие данные, которые могут быть использованы в коде. На эту папку не нужно обращать внимание.

ГенАИ_PDF

Вот PDF-файлы с заданиями по курсу [Введение в генеративный искусственный интеллект]. Я загрузил их, потому что изначально они были сохранены на Google Диске.

Гид

Там будут храниться все руководящие документы.

ресурсы

Вот изображения, используемые в файле .md. На эту папку не нужно обращать внимание.

БумажныеЗаметки

Эссе диссертации.

КодPlayground

Несколько интересных примеров скриптов кода (игрушечная версия).

README.md

sumr.py ?скрипт

Обобщение видео/аудио/субтитров с помощью AI.

чат.py ?скрипт

Разговор с ИИ.

Введение в учебные ресурсы по генеративному искусственному интеллекту

Домашняя страница курса

Официальное | Авторизованное видео: YouTube Билибили |

Производство и распространение китайской зеркальной версии было разрешено учителем Ли Хунъи. Спасибо учителю за бескорыстный обмен знаниями!

PS Китайский образ полностью реализует все функции кода задания (локальное управление). Kaggle — это онлайн-платформа, которую можно напрямую подключить в Китае. Содержимое китайского Colab и Kaggle соответствует исходному заданию. Просто выберите одного из них, чтобы завершить исследование.

В соответствии с фактическими потребностями выберите метод из приведенных ниже, чтобы подготовить среду обучения, нажмите ► или отправьте текст, чтобы развернуть .

Kaggle (рекомендуется прямое внутреннее соединение): прочитайте статью «Kaggle: бесплатное руководство по использованию графического процессора, идеальная альтернатива Colab», чтобы узнать больше.

Colab (требуется научный доступ в Интернет)

Файлы кода в проекте синхронизируются на обеих платформах.

Линукс (Убунту) :

sudo apt-get update

sudo apt-get install gitmacOS :

Сначала установите Homebrew:

/bin/bash -c " $( curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh ) "Затем запустите:

brew install gitОкна :

Загрузите и установите Git для Windows.

Линукс (Убунту) :

sudo apt-get update

sudo apt-get install wget curlmacOS :

brew install wget curlОкна :

Загрузите и установите с официальных сайтов Wget для Windows и Curl.

Посетите официальный сайт Anaconda, введите свой адрес электронной почты и проверьте свою электронную почту. Вы увидите:

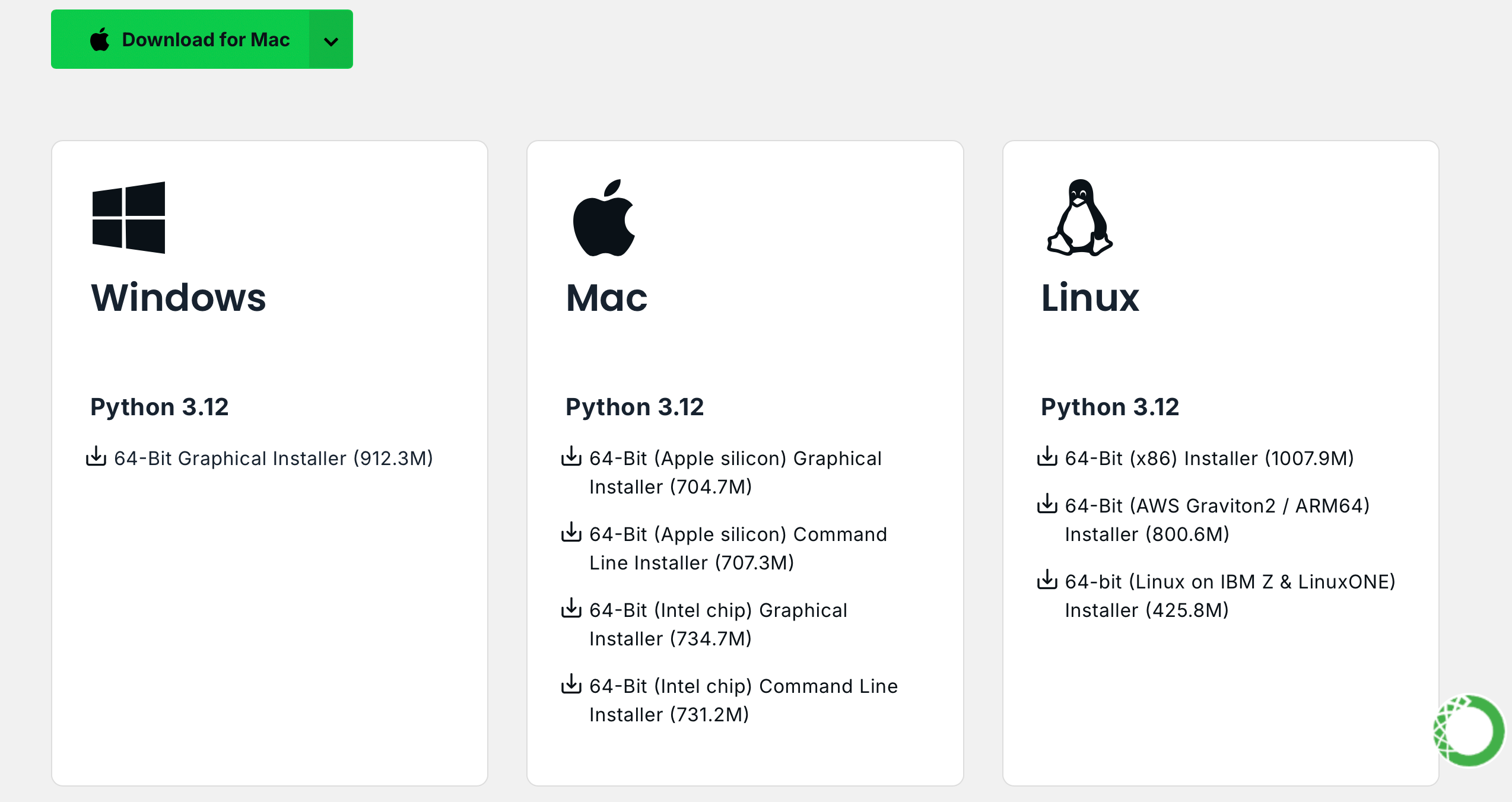

Нажмите Download Now , выберите подходящую версию и загрузите ее (доступны как Anaconda, так и Miniconda):

Линукс (Убунту) :

Установить Анаконду

Посетите repo.anaconda.com для выбора версии.

# 下载 Anaconda 安装脚本(以最新版本为例)

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

# 运行安装脚本

bash Anaconda3-2024.10-1-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcУстановите Miniconda (рекомендуется)

Посетите repo.anaconda.com/miniconda для выбора версии. Miniconda — это упрощенная версия Anaconda, содержащая только Conda и Python.

# 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 运行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcmacOS :

Соответственно замените URL-адрес в команде Linux.

Установить Анаконду

Посетите repo.anaconda.com для выбора версии.

Установите Miniconda (рекомендуется)

Посетите repo.anaconda.com/miniconda для выбора версии.

Введите следующую команду в терминал. Если отображается информация о версии, установка прошла успешно.

conda --versioncat << ' EOF ' > ~/.condarc

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirror.nju.edu.cn/anaconda/pkgs/main

- https://mirror.nju.edu.cn/anaconda/pkgs/r

- https://mirror.nju.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirror.nju.edu.cn/anaconda/cloud

pytorch: https://mirror.nju.edu.cn/anaconda/cloud

EOF[!примечание]

Многие зеркальные источники, которые были доступны в прошлом году, больше не доступны. Чтобы узнать текущую конфигурацию других зеркальных сайтов, вы можете обратиться к этому очень полезному документу от NTU: Помощь по использованию зеркала.

Примечание . Если Anaconda или Miniconda уже установлены, pip будет включен в систему и дополнительная установка не потребуется.

Линукс (Убунту) :

sudo apt-get update

sudo apt-get install python3-pipmacOS :

brew install python3Окна :

Загрузите и установите Python, убедившись, что установлен флажок «Добавить Python в PATH».

Откройте командную строку и введите:

python -m ensurepip --upgradeВведите следующую команду в терминал. Если отображается информация о версии, установка прошла успешно.

pip --versionpip config set global.index-url https://mirrors.aliyun.com/pypi/simpleВытащите проект с помощью следующей команды:

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNОграничений на версию нет, она может быть выше:

conda create -n aigc python=3.9 Нажмите y и Enter, чтобы продолжить. После завершения создания активируйте виртуальную среду:

conda activate aigcДалее вам необходимо установить базовые зависимости. Обратитесь к официальному сайту PyTorch, взяв в качестве примера CUDA 11.8 (если видеокарта не поддерживает 11.8, необходимо изменить команду), выберите одну из двух для установки:

# pip

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# conda

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidiaТеперь мы успешно настроили все необходимые среды и готовы приступить к обучению :) Остальные зависимости будут указаны отдельно в каждой статье.

[!примечание]

Образы Docker имеют предустановленные зависимости, поэтому нет необходимости их переустанавливать.

Сначала установите jupyter-lab , который намного проще в использовании, чем jupyter notebook .

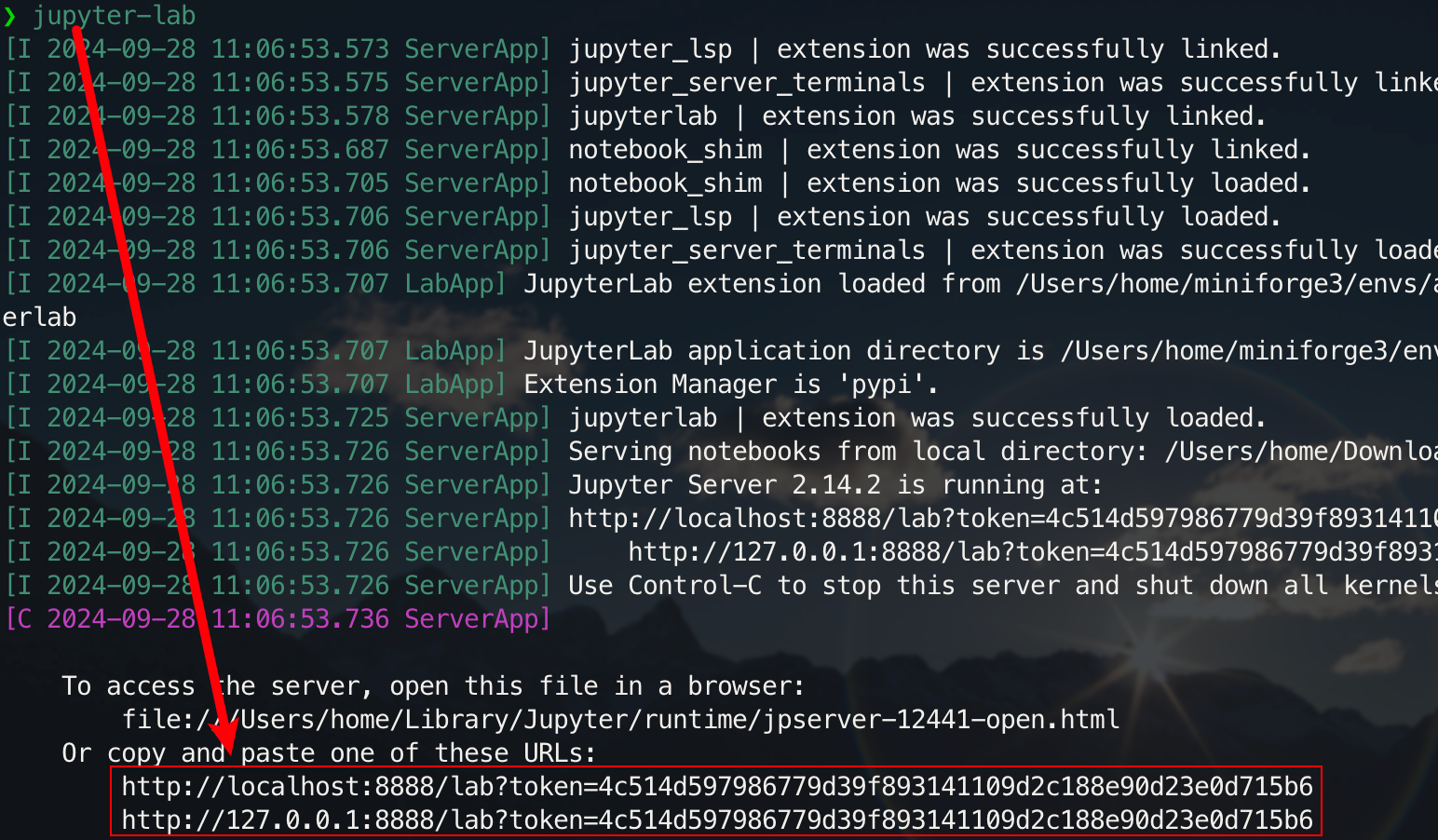

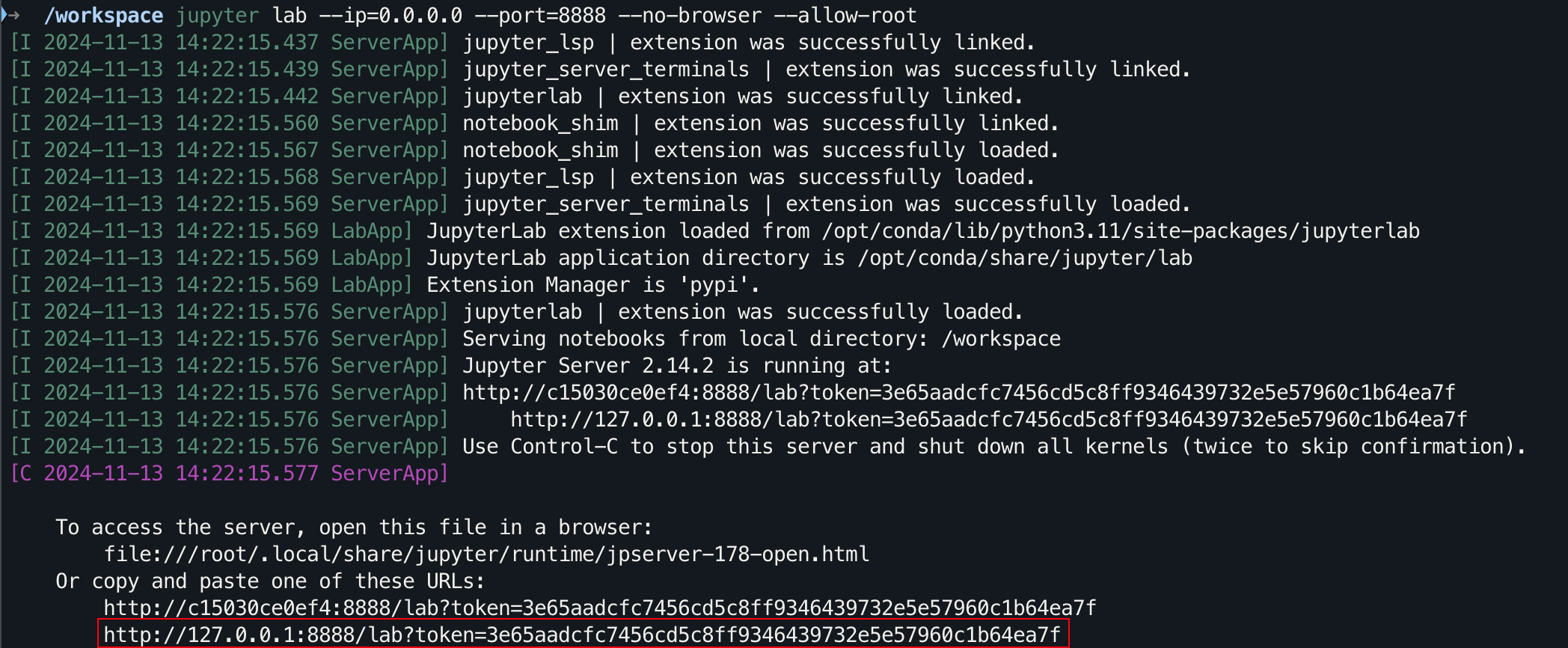

pip install jupyterlabПосле завершения установки выполните следующую команду:

jupyter-lab

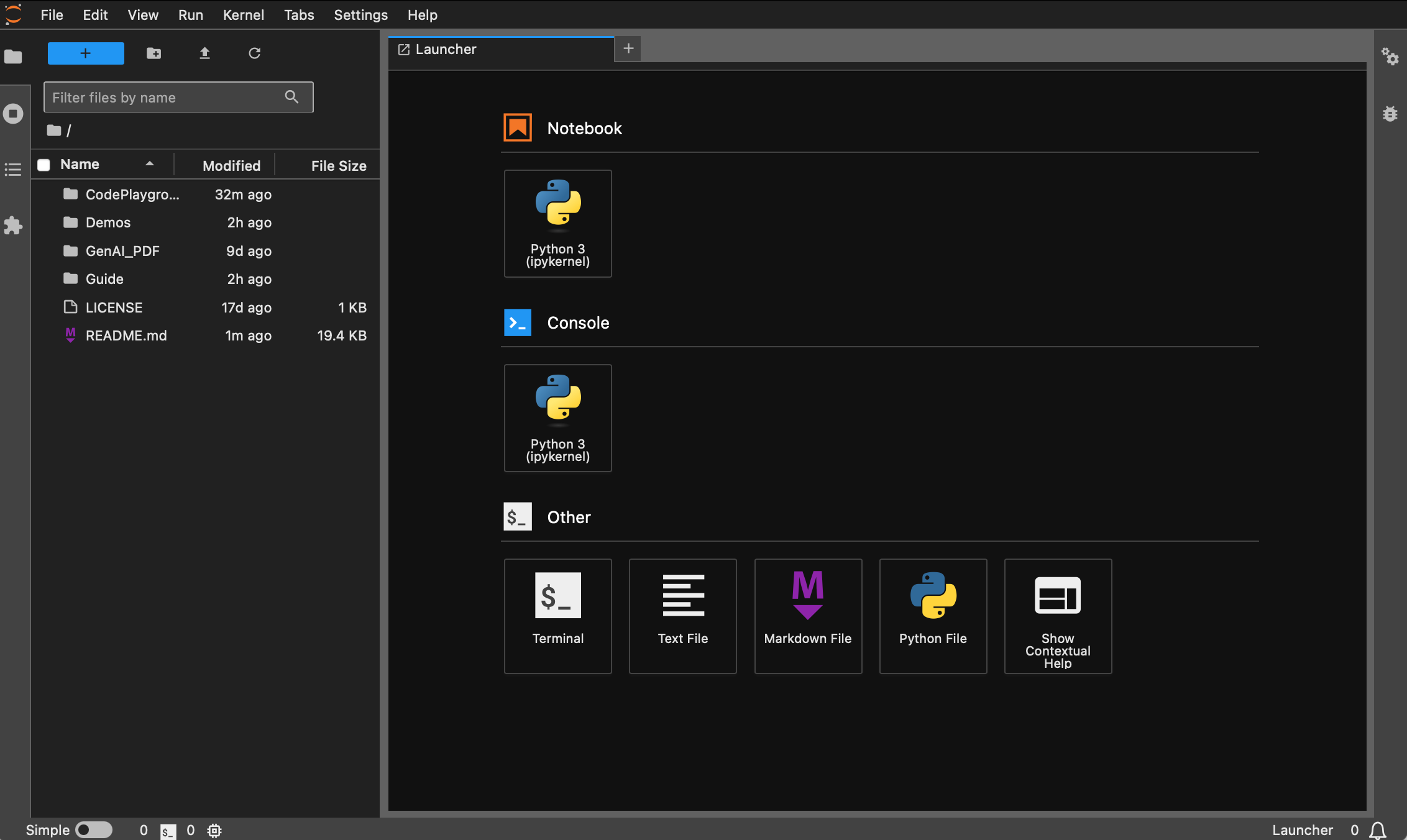

Теперь вы сможете получить к нему доступ через всплывающую ссылку, обычно расположенную на порту 8888. Для графического интерфейса удерживайте нажатой клавишу Ctrl в Windows/Linux, удерживайте нажатой клавишу Command на Mac, а затем щелкните ссылку, чтобы перейти напрямую. На этом этапе вы получите полную картину проекта:

Студенты, у которых не установлен Docker, могут прочитать статью «Использование Docker для быстрой настройки среды глубокого обучения (Linux)». Новичкам рекомендуется прочитать «Введение в основные команды Docker и устранение распространенных ошибок».

Во всех версиях предварительно установлены общие инструменты, такие как sudo , pip , conda , wget , curl и vim , а также настроены внутренние источники изображений pip и conda . В то же время он интегрирует zsh и некоторые практичные плагины командной строки (автозаполнение команд, подсветка синтаксиса и инструмент перехода по каталогу z ). Кроме того, предварительно установлены jupyter notebook и jupyter lab , а в качестве терминала по умолчанию установлен zsh для облегчения разработки в области глубокого обучения. Дисплей на китайском языке в контейнере был оптимизирован, чтобы избежать искажения символов. Внутренний зеркальный адрес Hugging Face также предварительно настроен.

pytorch/pytorch:2.5.1-cuda11.8-cudnn9-devel . Версия python по умолчанию — 3.11.10. Версию можно изменить напрямую через conda install python==版本号.Удачная установка :

wget , curl : инструменты загрузки из командной строкиvim , nano : текстовый редакторgit : инструмент контроля версийgit-lfs : Git LFS (хранилище больших файлов)zip , unzip : инструменты сжатия и распаковки файлов.htop : инструмент мониторинга системыtmux , screen : инструменты управления сеансамиbuild-essential : инструменты компиляции (такие как gcc , g++ )iputils-ping , iproute2 , net-tools : сетевые инструменты (предоставляющие такие команды, как ping , ip , ifconfig , netstat и т. д.)ssh : инструмент удаленного подключенияrsync : инструмент синхронизации файловtree : отображение деревьев файлов и каталогов.lsof : просмотр файлов, открытых в настоящее время в системе.aria2 : инструмент многопоточной загрузкиlibssl-dev : библиотека разработки OpenSSL.установка пипа :

jupyter notebook , jupyter lab : интерактивная среда разработкиvirtualenv : инструмент управления виртуальной средой Python, вы можете использовать conda напрямую.tensorboard : инструмент визуализации обучения глубокому обучениюipywidgets : библиотека виджетов Jupyter для правильного отображения индикаторов выполнения.Плагин :

zsh-autosuggestions : автодополнение командzsh-syntax-highlighting : подсветка синтаксисаz : Быстрый переход в каталог.Версия dl (Deep Learning) основана на базе и дополнительно устанавливает базовые инструменты и библиотеки, которые можно использовать в глубоком обучении:

Удачная установка :

ffmpeg : инструмент для обработки аудио и видео.libgl1-mesa-glx : зависимость графической библиотеки (решает некоторые проблемы, связанные с графикой в рамках глубокого обучения)установка пипа :

numpy , scipy : численные расчеты и научные расчетыpandas : анализ данныхmatplotlib , seaborn : визуализация данныхscikit-learn : инструменты машинного обученияtensorflow , tensorflow-addons : еще одна популярная среда глубокого обучения.tf-keras : реализация TensorFlow интерфейса Keras.transformers , datasets : инструменты НЛП, предоставленные Hugging Face.nltk , spacy : инструменты обработки естественного языкаЕсли необходимы дополнительные библиотеки, их можно установить вручную с помощью следующей команды:

pip install --timeout 120 <替换成库名> Здесь --timeout 120 устанавливает тайм-аут в 120 секунд, чтобы гарантировать, что для установки еще достаточно времени, даже если сеть плохая. Если вы его не настроите, то можете столкнуться с ситуацией, когда установочный пакет не сработает из-за таймаута загрузки в домашней среде.

Обратите внимание, что все изображения не будут загружать склад заранее.

Предполагая, что вы установили и настроили Docker, вам нужно всего две строки команд для завершения настройки среды глубокого обучения. Для текущего проекта вы можете сделать выбор после просмотра описания версии. Соответствующий image_name:tag из двух выглядит следующим образом. следует:

hoperj/quickstart:base-torch2.5.1-cuda11.8-cudnn9-develhoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develКоманда вытягивания:

docker pull < image_name:tag >Ниже в качестве примера используется версия dl . Выберите один из методов для выполнения.

docker pull dockerpull.org/hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develdocker pull hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develФайлы можно загружать через Baidu Cloud Disk (Alibaba Cloud Disk не поддерживает обмен большими сжатыми файлами).

Файлы с одинаковым именем имеют одинаковое содержимое.

.tar.gz— это сжатая версия. После загрузки распакуйте ее с помощью следующей команды:gzip -d dl.tar.gz

Предполагая, dl.tar загружен в ~/Downloads , переключитесь в соответствующий каталог:

cd ~ /DownloadsЗатем загрузите изображение:

docker load -i dl.tarВ этом режиме контейнер будет напрямую использовать конфигурацию сети хоста. Все порты равны портам хоста и не требуют отдельного сопоставления. Если вам нужно сопоставить только определенный порт, замените

--network hostна-p port:port.

docker run --gpus all -it --name ai --network host hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel /bin/zsh Для учащихся, которым необходимо использовать прокси, добавьте -e для установки переменных среды. Вы также можете обратиться к расширенной статье a:

Предположим, что номер порта HTTP/HTTPS прокси — 7890, а SOCKS5 — 7891:

-e http_proxy=http://127.0.0.1:7890-e https_proxy=http://127.0.0.1:7890-e all_proxy=socks5://127.0.0.1:7891Интегрировано в предыдущую команду:

docker run --gpus all -it

--name ai

--network host

-e http_proxy=http://127.0.0.1:7890

-e https_proxy=http://127.0.0.1:7890

-e all_proxy=socks5://127.0.0.1:7891

hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel

/bin/zsh[!кончик]

Предварительно ознакомьтесь с распространенными операциями :

- Запустите контейнер :

docker start <容器名>- Запустите контейнер :

docker exec -it <容器名> /bin/zsh

- Выход из контейнера :

Ctrl + Dилиexit.- Остановите контейнер :

docker stop <容器名>- Удалить контейнер :

docker rm <容器名>

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNjupyter lab --ip=0.0.0.0 --port=8888 --no-browser --allow-root

Для графического интерфейса удерживайте нажатой клавишу Ctrl в Windows/Linux, удерживайте нажатой клавишу Command на Mac, а затем щелкните ссылку, чтобы перейти напрямую.

Спасибо за вашу ЗВЕЗДУ? Надеюсь, это поможет.