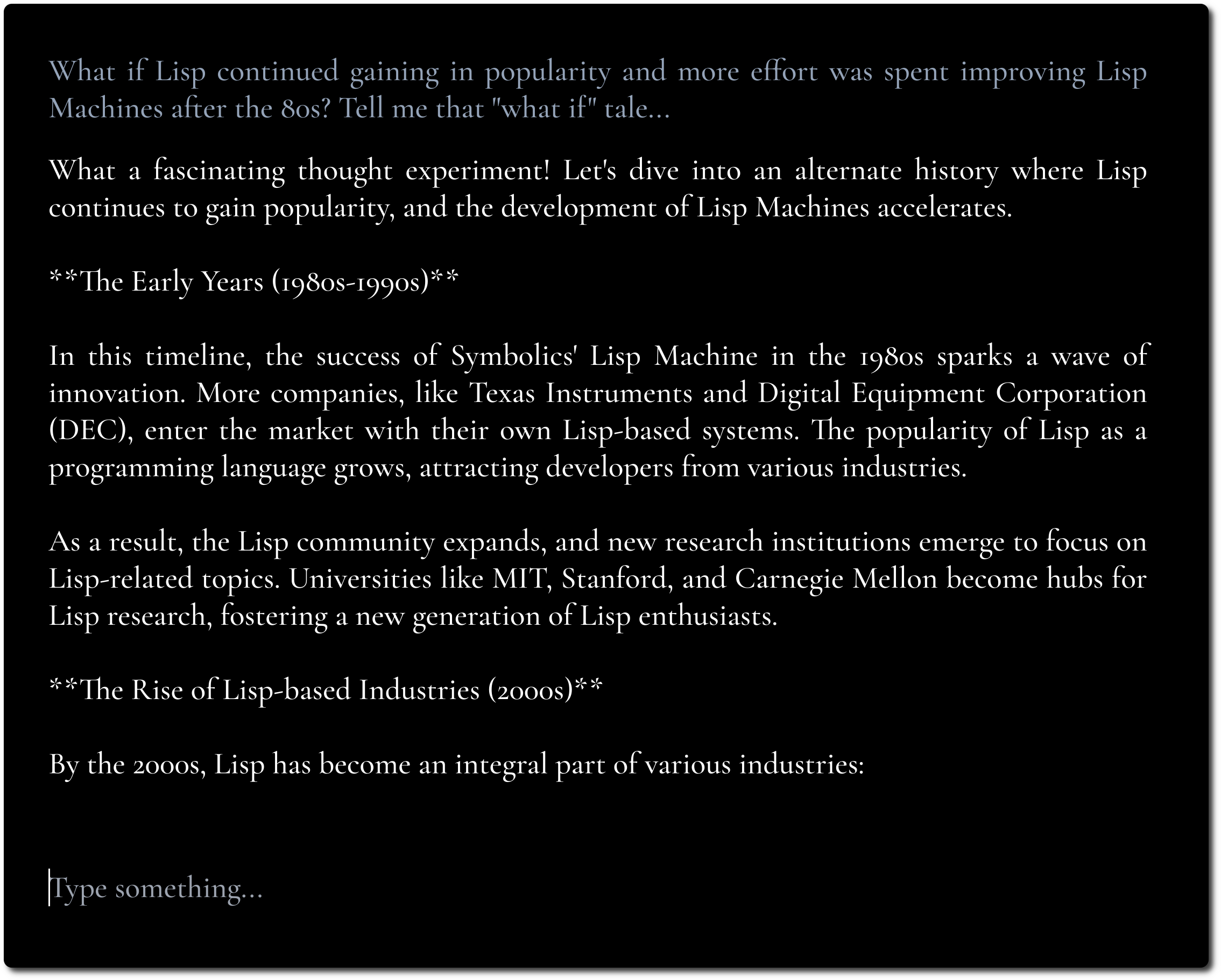

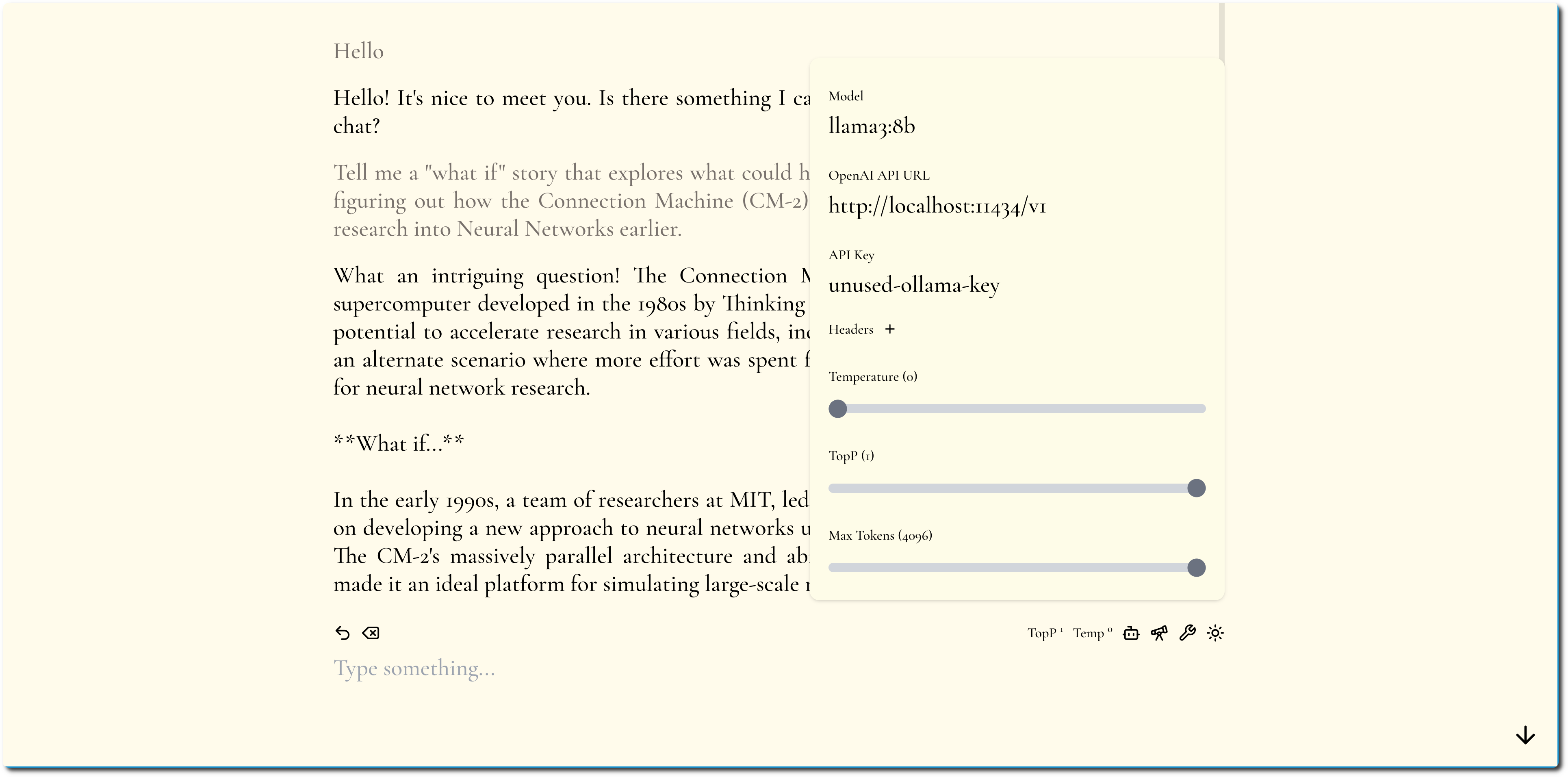

Минималистичный пользовательский интерфейс чата LLM, вдохновленный Fooocus и Pi.

Если у вас есть конечная точка API с поддержкой CORS, вы можете попробовать ее здесь.

Цель состоит в том, чтобы сосредоточиться на содержании и скрыть как можно больше изменений и настроек.

Мы подчеркиваем содержание, используя жирную типографику и минималистичный дизайн.

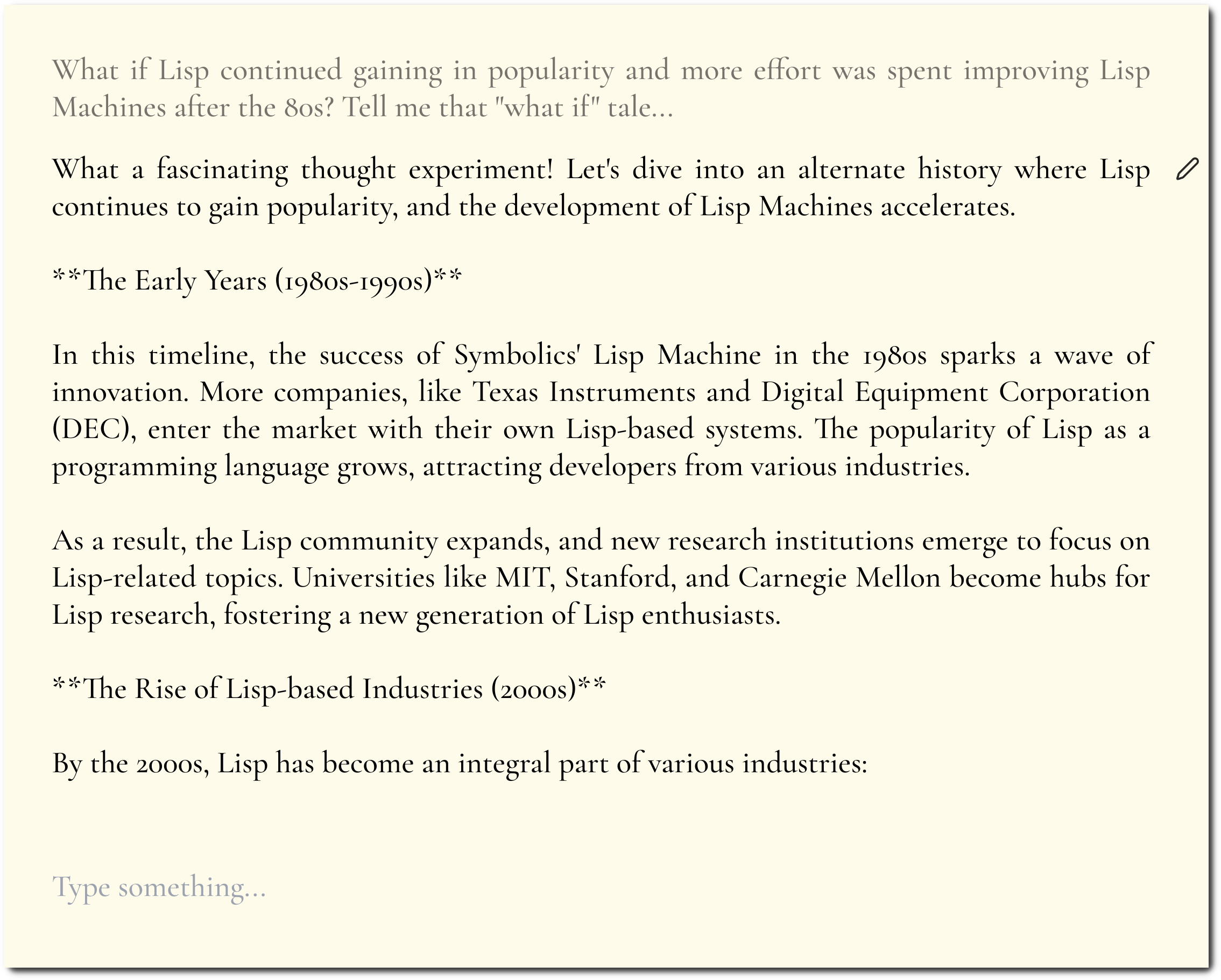

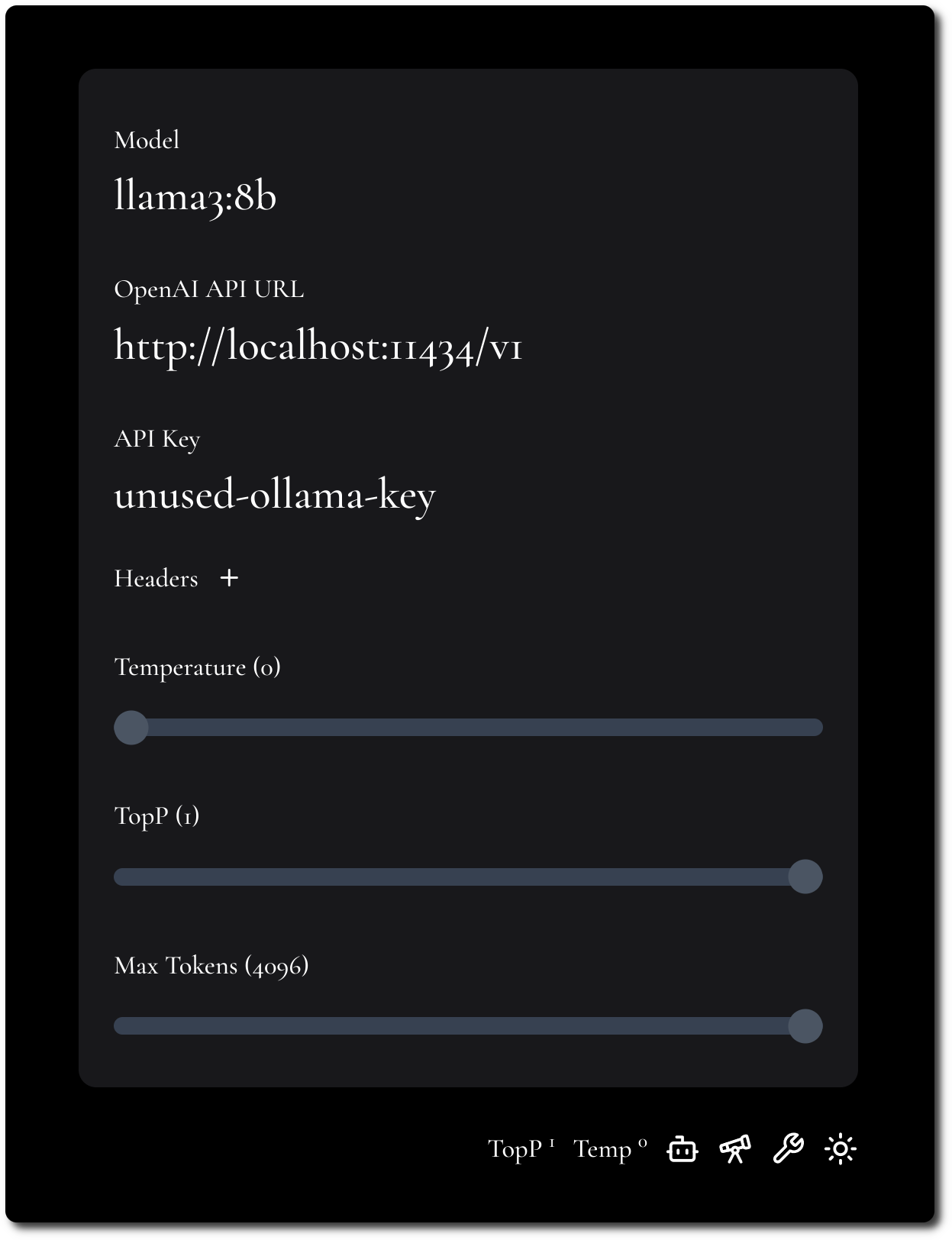

Мы стараемся сделать конфигурацию минимальной, но гибкой.

MiniChat поддерживает API-интерфейсы, совместимые с OpenAI. См. раздел Docker Compose для запуска MiniChat с различными поставщиками моделей с использованием таких шлюзов, как Portkey.

Запустить MiniChat можно с помощью Docker, размер образа меньше 2 МБ.

docker run -p 3216:3216 ghcr.io/functorism/minichat:master

Бегать

docker compose -f docker-compose-ollama.yml up

docker exec minichat-ollama-1 ollama pull llama3:8b

Настройки пользовательского интерфейса:

Бегать

docker compose -f docker-compose-portkey.yml up

Настройки пользовательского интерфейса:

Бегать

docker compose -f docker-compose-tf-tgi.yml up

Настройки пользовательского интерфейса: