| 日本語 | английский | 中文简体 | 中文繁體 |

Код и данные для нашего документа ICLR 2024 SWE-bench: могут ли языковые модели решать реальные проблемы GitHub?

Пожалуйста, посетите наш веб-сайт для просмотра общедоступной таблицы лидеров и журнала изменений для получения информации о последних обновлениях теста SWE-bench.

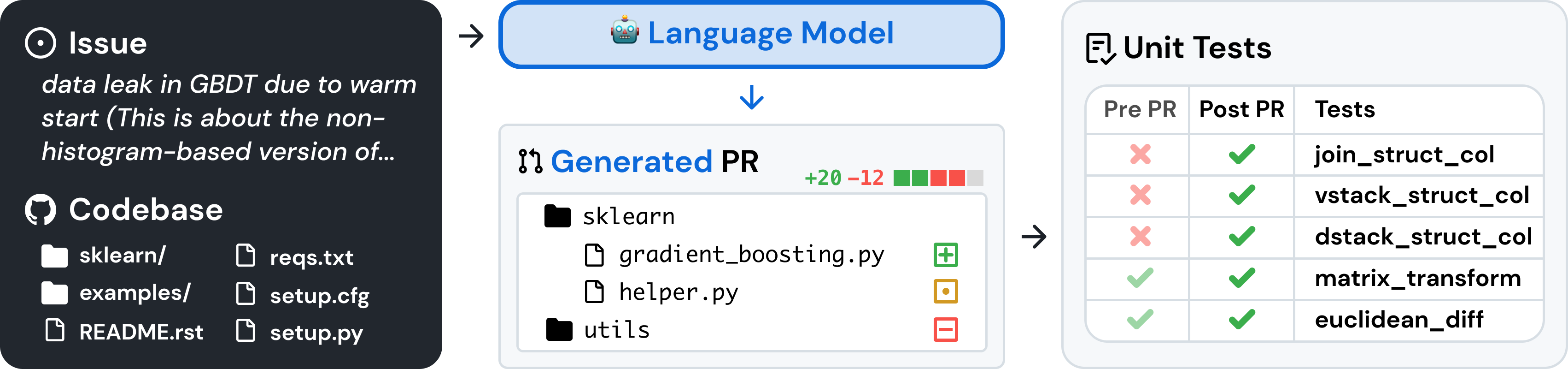

SWE-bench — это эталон для оценки больших языковых моделей реальных проблем программного обеспечения, собранных с GitHub. Учитывая кодовую базу и проблему , языковой модели поручено создать патч , решающий описанную проблему.

Чтобы получить доступ к SWE-bench, скопируйте и запустите следующий код:

from datasets import load_dataset

swebench = load_dataset ( 'princeton-nlp/SWE-bench' , split = 'test' )SWE-bench использует Docker для воспроизводимых оценок. Следуйте инструкциям в руководстве по установке Docker, чтобы установить Docker на свой компьютер. Если вы выполняете настройку в Linux, мы рекомендуем также просмотреть шаги после установки.

Наконец, чтобы собрать SWE-bench из исходного кода, выполните следующие действия:

git clone [email protected]:princeton-nlp/SWE-bench.git

cd SWE-bench

pip install -e .Проверьте установку, запустив:

python -m swebench.harness.run_evaluation

--predictions_path gold

--max_workers 1

--instance_ids sympy__sympy-20590

--run_id validate-goldПредупреждение

Выполнение быстрых оценок на SWE-bench может потребовать больших ресурсов. Мы рекомендуем запускать оценочную программу на машине x86_64 с минимум 120 ГБ свободного места, 16 ГБ ОЗУ и 8 ядрами ЦП. Возможно, вам придется поэкспериментировать с аргументом --max_workers , чтобы найти оптимальное количество рабочих процессов для вашей машины, но мы рекомендуем использовать меньше min(0.75 * os.cpu_count(), 24) .

Если вы используете рабочий стол Docker, обязательно увеличьте пространство на виртуальном диске, чтобы было доступно ~ 120 ГБ свободного места, и установите max_workers в соответствии с указанным выше для процессоров, доступных для Docker.

Поддержка машин arm64 является экспериментальной.

Оцените прогнозы модели на SWE-bench Lite, используя оценочную программу, с помощью следующей команды:

python -m swebench.harness.run_evaluation

--dataset_name princeton-nlp/SWE-bench_Lite

--predictions_path < path_to_predictions >

--max_workers < num_workers >

--run_id < run_id >

# use --predictions_path 'gold' to verify the gold patches

# use --run_id to name the evaluation run Эта команда создаст журналы сборки Docker ( logs/build_images ) и журналы оценки ( logs/run_evaluation ) в текущем каталоге.

Окончательные результаты оценки будут сохранены в каталоге evaluation_results .

Чтобы просмотреть полный список аргументов для оценочной программы, запустите:

python -m swebench.harness.run_evaluation --helpКроме того, репозиторий SWE-Bench может помочь вам:

| Наборы данных | Модели |

|---|---|

| ? SWE-скамья | ? SWE-Лама 13б |

| ? Поиск «Оракула» | ? ШВЕ-Лама 13б (ПЕФТ) |

| ? БМ25 Поиск 13К | ? SWE-Лама 7б |

| ? БМ25 Поиск 27К | ? ШВЕ-Лама 7б (ПЕФТ) |

| ? БМ25 Поиск 40К | |

| ? BM25 Получение 50 тыс. (жетоны ламы) |

Мы также написали следующие статьи в блоге о том, как использовать различные части SWE-bench. Если вы хотите увидеть публикацию на определенную тему, сообщите нам об этом через сообщение.

Мы хотели бы услышать мнение более широких исследовательских сообществ НЛП, машинного обучения и разработки программного обеспечения, и мы приветствуем любые вклады, запросы на включение или проблемы! Для этого отправьте новый запрос на включение или проблему и соответствующим образом заполните соответствующие шаблоны. Мы обязательно последуем в ближайшее время!

Контактное лицо: Карлос Э. Хименес и Джон Янг (электронная почта: [email protected], [email protected]).

Если наша работа окажется для вас полезной, пожалуйста, используйте следующие цитаты.

@inproceedings{

jimenez2024swebench,

title={{SWE}-bench: Can Language Models Resolve Real-world Github Issues?},

author={Carlos E Jimenez and John Yang and Alexander Wettig and Shunyu Yao and Kexin Pei and Ofir Press and Karthik R Narasimhan},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024},

url={https://openreview.net/forum?id=VTF8yNQM66}

}

Массачусетский технологический институт. Проверьте LICENSE.md .