TL;DR: одно портретное изображение ?♂️ + звук ? = видео с говорящей головой ?.

Лицензия обновлена до Apache 2.0, и мы сняли некоммерческое ограничение.

SadTalker теперь официально интегрирован в Discord, где вы можете бесплатно использовать его, отправляя файлы. Вы также можете создавать высококачественные видеоролики из текстовых подсказок. Присоединиться:

Мы опубликовали расширение стабильной диффузии-webui. Более подробную информацию можно найти здесь. Демо-видео

Теперь доступен полноэкранный режим! Подробнее...

| еще+усилитель в версии 0.0.1 | еще + усилитель в v0.0.2 | входное изображение @bagbag1815 |

|---|---|---|

Still_e_n.mp4 | full_body_2.bus_chinese_enhanced.mp4 |  |

Теперь доступно несколько новых режимов (режимы неподвижности, эталонного режима и режима изменения размера)!

Мы рады видеть больше демо-версий от сообщества на bilibili, YouTube и X (#sadtalker).

Предыдущий список изменений можно найти здесь.

[2023.06.12] : В расширение WebUI добавлено больше новых функций, см. обсуждение здесь.

[2023.06.05] : выпущена новая модель лица размером 512x512 пикселей (бета). Исправлены некоторые ошибки и улучшена производительность.

[2023.04.15] : Добавлен блокнот WebUI Colab от @camenduru:

[2023.04.12] : добавлен более подробный документ по установке WebUI и исправлена проблема при переустановке.

[2023.04.12] : исправлены проблемы безопасности WebUI из-за сторонних пакетов и оптимизирован путь вывода в sd-webui-extension .

[2023.04.08] : В версии 0.0.2 мы добавили водяной знак логотипа к сгенерированному видео, чтобы предотвратить злоупотребления. Этот водяной знак был удален в более поздней версии.

[2023.04.08] : В версии 0.0.2 мы добавили функции полной анимации изображения и ссылку для загрузки контрольных точек из Baidu. Мы также оптимизировали логику усилителя.

Мы отслеживаем новые обновления в выпуске №280.

Если у вас возникли проблемы, пожалуйста, прочитайте наши часто задаваемые вопросы, прежде чем открывать проблему.

Руководства сообщества: 中文Windows教程 (учебник по Windows на китайском языке) | 日本語コース (учебник по японскому языку).

Установите Anaconda, Python и git .

Создание окружения и установка требований.

git clone https://github.com/OpenTalker/SadTalker.git

cd SadTalker

conda create -n sadtalker python=3.8

conda activate sadtalker

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txt

# ## Coqui TTS is optional for gradio demo.

# ## pip install TTS

Видеоурок на китайском языке доступен здесь. Вы также можете следовать следующим инструкциям:

scoop install git .ffmpeg , следуя этому руководству или используя scoop: scoop install ffmpeg .git clone https://github.com/Winfredy/SadTalker.git .start.bat из проводника Windows как обычно, без прав администратора, как пользователь, и будет запущена демонстрационная версия WebUI на базе Gradio.Руководство по установке SadTalker на macOS можно найти здесь.

Пожалуйста, ознакомьтесь с дополнительными уроками здесь.

Вы можете запустить следующий скрипт в Linux/macOS, чтобы автоматически загрузить все модели:

bash scripts/download_models.sh Мы также предоставляем автономный патч ( gfpgan/ ), поэтому при создании модель не загружается.

sadt )sadt )Модель объясняет:

| Модель | Описание |

|---|---|

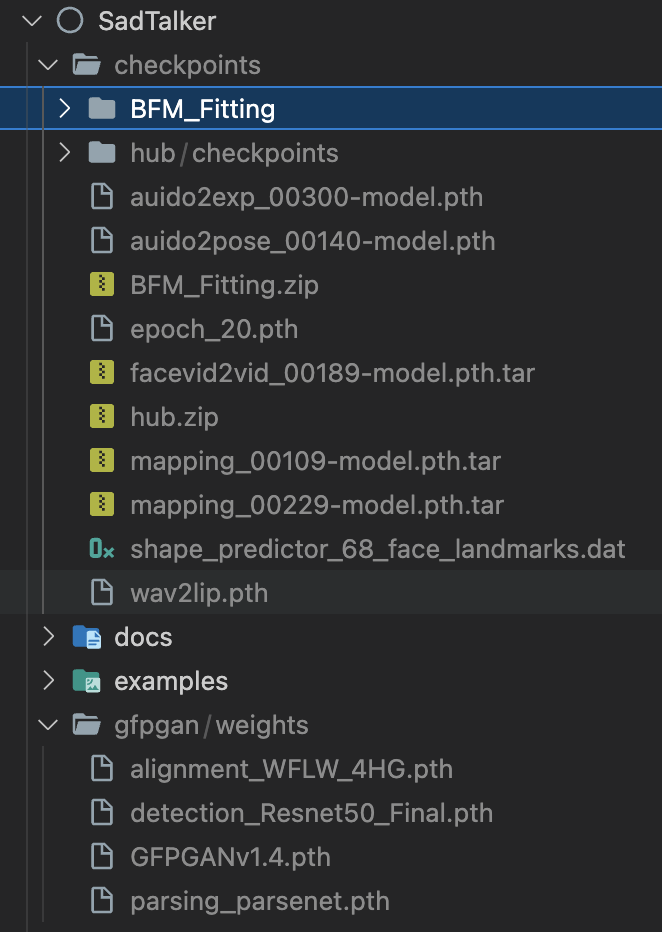

| контрольные точки/mapping_00229-model.pth.tar | Предварительно обученная MappingNet в Sadtalker. |

| контрольные точки/mapping_00109-model.pth.tar | Предварительно обученная MappingNet в Sadtalker. |

| контрольные точки/SadTalker_V0.0.2_256.safetensors | упакованы чекпоинты sadtalker старой версии, 256 рендеров лиц). |

| контрольные точки/SadTalker_V0.0.2_512.safetensors | упакованы чекпоинты sadtalker старой версии, 512 рендеров лиц). |

| gfpgan/веса | Обнаружение лиц и расширенные модели, используемые в facexlib и gfpgan . |

| Модель | Описание |

|---|---|

| контрольные точки/auido2exp_00300-model.pth | Предварительно обученный ExpNet в Sadtalker. |

| контрольные точки/auido2pose_00140-model.pth | Предварительно обучен PoseVAE в Sadtalker. |

| контрольные точки/mapping_00229-model.pth.tar | Предварительно обученная MappingNet в Sadtalker. |

| контрольные точки/mapping_00109-model.pth.tar | Предварительно обученная MappingNet в Sadtalker. |

| контрольные точки/facevid2vid_00189-model.pth.tar | Предварительно обученная модель face-vid2vid после повторного появления face-vid2vid. |

| контрольные точки/epoch_20.pth | Предварительно обученный экстрактор 3DMM в Deep3DFaceReconstruction. |

| контрольные точки/wav2lip.pth | Высокоточная модель синхронизации губ в Wav2lip. |

| контрольные точки/shape_predictor_68_face_landmarks.dat | Модель ориентира лица, используемая в dilb. |

| контрольно-пропускные пункты/МДФ | Файл библиотеки 3DMM. |

| контрольно-пропускные пункты/пересадочный узел | Модели распознавания лиц, используемые при выравнивании лиц. |

| gfpgan/веса | Обнаружение лиц и расширенные модели, используемые в facexlib и gfpgan . |

Последняя папка будет отображаться как:

Пожалуйста, прочитайте наш документ с рекомендациями и советами по настройке.

Онлайн-демо : HuggingFace | SDWebUI-Колаб | Колаб

Локальное расширение WebUI : обратитесь к документации WebUI.

Локальная демонстрация градиента (рекомендуется) . Экземпляр Gradio, аналогичный нашей демонстрации Hugging Face, можно запустить локально:

# # you need manually install TTS(https://github.com/coqui-ai/TTS) via `pip install tts` in advanced.

python app_sadtalker.pyВы также можете запустить его проще:

webui.bat , требования будут установлены автоматически.bash webui.sh , чтобы запустить webui.python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--enhancer gfpgan Результаты будут сохранены в results/$SOME_TIMESTAMP/*.mp4 .

Использование --still для создания естественного видео в полный рост. Вы можете добавить enhancer , чтобы улучшить качество создаваемого видео.

python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--result_dir < a file to store results >

--still

--preprocess full

--enhancer gfpgan Дополнительные примеры, настройки и советы можно найти в >>> документах по передовому опыту <<<.

Если наша работа окажется полезной для вашего исследования, пожалуйста, процитируйте:

@article { zhang2022sadtalker ,

title = { SadTalker: Learning Realistic 3D Motion Coefficients for Stylized Audio-Driven Single Image Talking Face Animation } ,

author = { Zhang, Wenxuan and Cun, Xiaodong and Wang, Xuan and Zhang, Yong and Shen, Xi and Guo, Yu and Shan, Ying and Wang, Fei } ,

journal = { arXiv preprint arXiv:2211.12194 } ,

year = { 2022 }

}Код Facerender во многом заимствован у zhanglonghao, воспроизводящего face-vid2vid и PIRender. Мы благодарим авторов за то, что поделились своим замечательным кодом. В процессе обучения мы также использовали модели Deep3DFaceReconstruction и Wav2lip. Мы благодарим их за прекрасную работу.

Мы также используем следующие сторонние библиотеки:

Это не официальный продукт Tencent.

1. Please carefully read and comply with the open-source license applicable to this code before using it.

2. Please carefully read and comply with the intellectual property declaration applicable to this code before using it.

3. This open-source code runs completely offline and does not collect any personal information or other data. If you use this code to provide services to end-users and collect related data, please take necessary compliance measures according to applicable laws and regulations (such as publishing privacy policies, adopting necessary data security strategies, etc.). If the collected data involves personal information, user consent must be obtained (if applicable). Any legal liabilities arising from this are unrelated to Tencent.

4. Without Tencent's written permission, you are not authorized to use the names or logos legally owned by Tencent, such as "Tencent." Otherwise, you may be liable for legal responsibilities.

5. This open-source code does not have the ability to directly provide services to end-users. If you need to use this code for further model training or demos, as part of your product to provide services to end-users, or for similar use, please comply with applicable laws and regulations for your product or service. Any legal liabilities arising from this are unrelated to Tencent.

6. It is prohibited to use this open-source code for activities that harm the legitimate rights and interests of others (including but not limited to fraud, deception, infringement of others' portrait rights, reputation rights, etc.), or other behaviors that violate applicable laws and regulations or go against social ethics and good customs (including providing incorrect or false information, spreading pornographic, terrorist, and violent information, etc.). Otherwise, you may be liable for legal responsibilities.

ЛОГОТИП: цвет и шрифт: ChatGPT, шрифт логотипа: Montserrat Alternates.

Все авторские права на демо-изображения и аудио принадлежат пользователям сообщества или созданы в результате стабильного распространения. Не стесняйтесь обращаться к нам, если вы хотите их удалить.