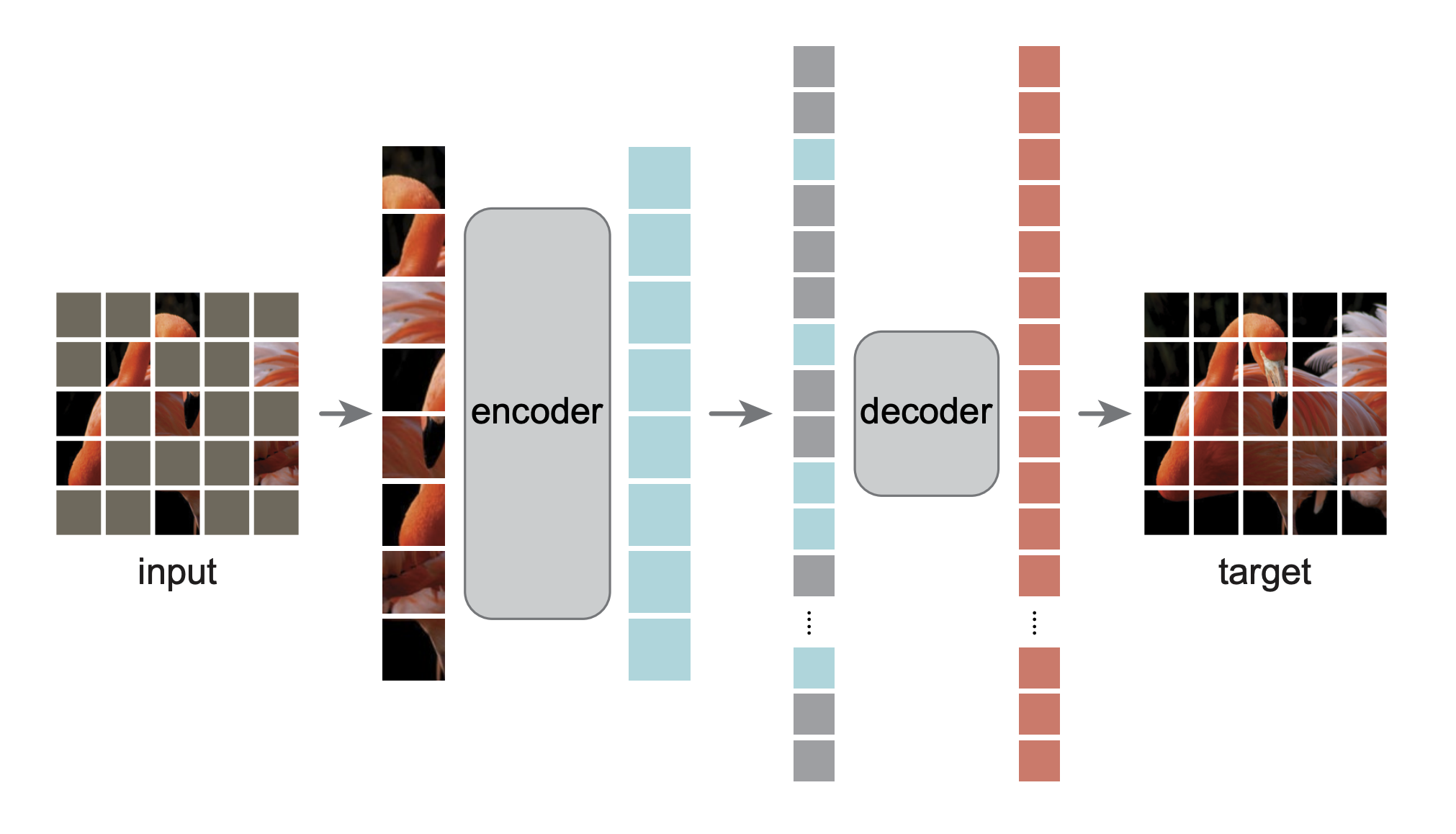

Это повторная реализация PyTorch/GPU статьи «Автоэнкодеры в маске — масштабируемые обучающиеся зрению»:

@Article{MaskedAutoencoders2021,

author = {Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Doll{'a}r and Ross Girshick},

journal = {arXiv:2111.06377},

title = {Masked Autoencoders Are Scalable Vision Learners},

year = {2021},

}

Исходная реализация была в TensorFlow+TPU. Эта повторная реализация находится в PyTorch+GPU.

Этот репозиторий является модификацией репозитория DeiT. Установка и подготовка следуют этому репозиторию.

Этот репозиторий основан на timm==0.3.2 , для которого необходимо исправление для работы с PyTorch 1.8.1+.

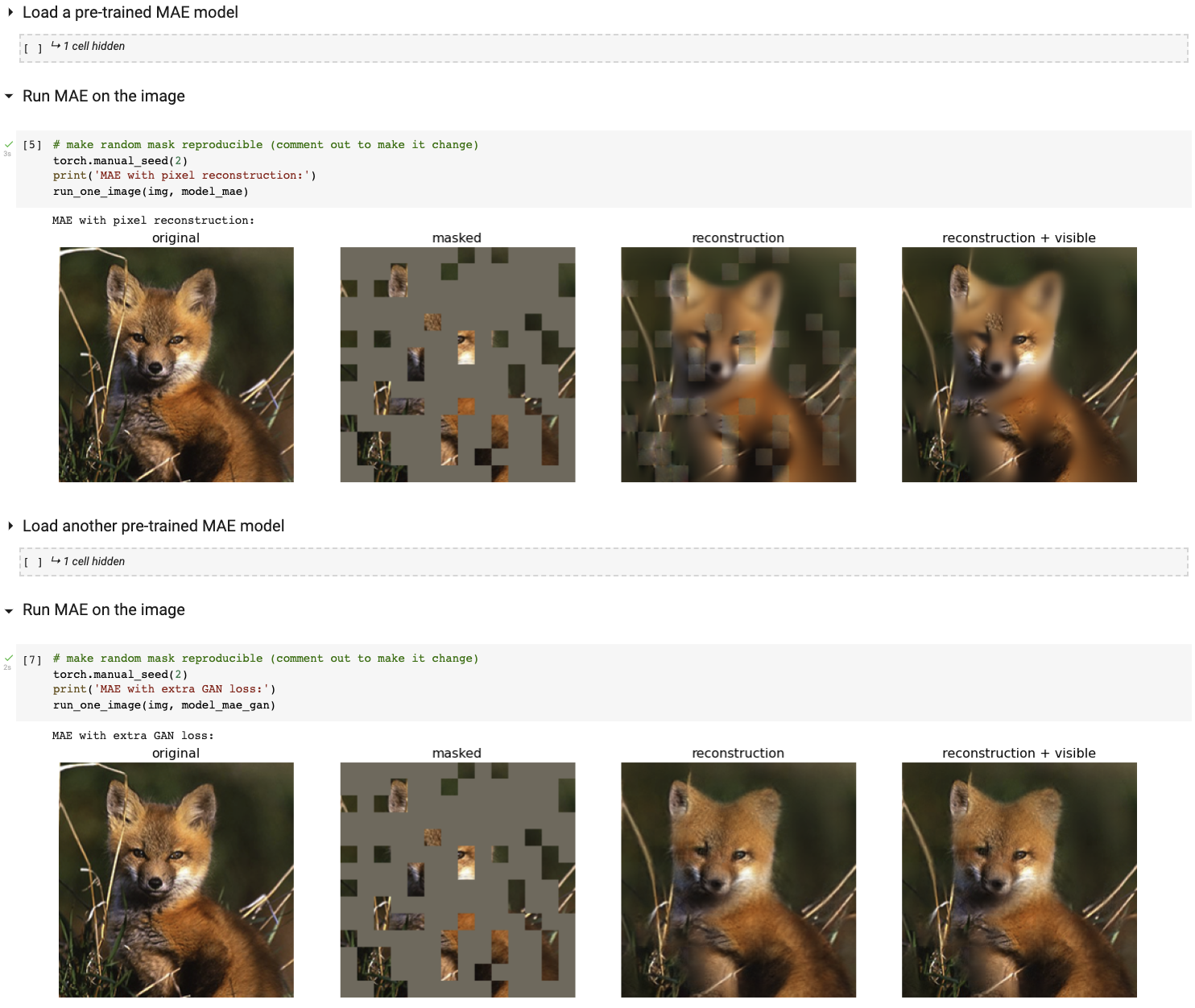

Запустите нашу интерактивную демонстрацию визуализации с помощью ноутбука Colab (графический процессор не требуется):

В следующей таблице представлены предварительно обученные контрольные точки, использованные в статье, преобразованные из TF/TPU в PT/GPU:

| ВИТ-База | ВИТ-Большой | ВИТ-Огромный | |

|---|---|---|---|

| предварительно обученный контрольно-пропускной пункт | скачать | скачать | скачать |

| мд5 | 8cad7c | b8b06e | 9bdbb0 |

Инструкция по тонкой настройке находится в FINETUNE.md.

Путем точной настройки этих предварительно обученных моделей мы занимаем первое место в следующих задачах классификации (подробно описано в статье):

| ВИТ-Б | ВИТ-Л | ВИТ-Х | ВиТ-Н 448 | предыдущий лучший | |

|---|---|---|---|---|---|

| ImageNet-1K (без внешних данных) | 83,6 | 85,9 | 86,9 | 87,8 | 87,1 |

| Ниже приведены оценки весов тех же моделей (точно настроенных в оригинальном ImageNet-1K): | |||||

| ImageNet-Коррупция (частота ошибок) | 51,7 | 41,8 | 33,8 | 36,8 | 42,5 |

| ImageNet-Состязательный | 35,9 | 57,1 | 68,2 | 76,7 | 35,8 |

| ImageNet-Рендеринг | 48,3 | 59,9 | 64,4 | 66,5 | 48,7 |

| ImageNet-Sketch | 34,5 | 45,3 | 49,6 | 50,9 | 36,0 |

| Ниже приведено трансферное обучение путем точной настройки предварительно обученного MAE на целевом наборе данных: | |||||

| iНатуралисты 2017 | 70,5 | 75,7 | 79,3 | 83,4 | 75,4 |

| iНатуралисты 2018 | 75,4 | 80,1 | 83,0 | 86,8 | 81,2 |

| iНатуралисты 2019 | 80,5 | 83,4 | 85,7 | 88,3 | 84,1 |

| Места205 | 63,9 | 65,8 | 65,9 | 66,8 | 66,0 |

| Места365 | 57,9 | 59,4 | 59,8 | 60,3 | 58,0 |

Инструкция по предварительной подготовке находится в PRETRAIN.md.

Этот проект находится под лицензией CC-BY-NC 4.0. Подробности см. в разделе ЛИЦЕНЗИЯ.