В этом репозитории хранятся данные и код статьи «Перефразируйте и ответьте: пусть большие языковые модели задают себе лучшие вопросы».

Авторы: Ихэ Дэн, Вэйтун Чжан, Цзысян Чен, Цюаньцюань Гу

[Веб-страница] [Бумага] [Обнимающее лицо]

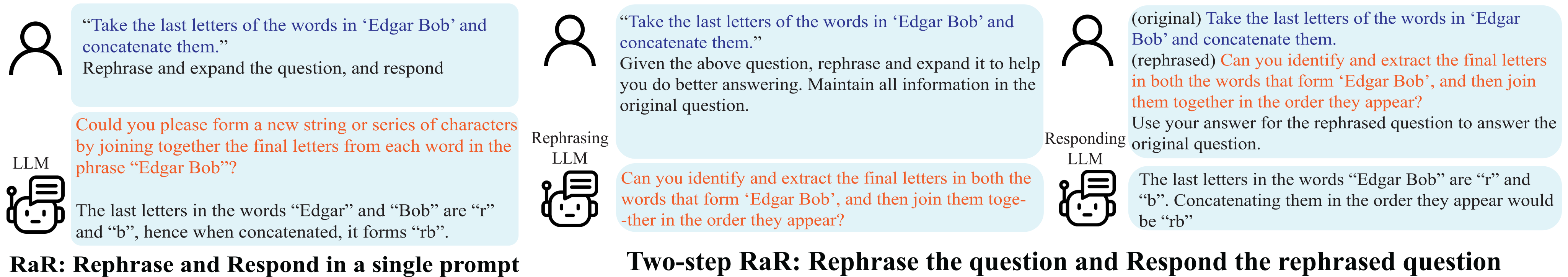

Демонстрация перефразирования и ответа (RaR).

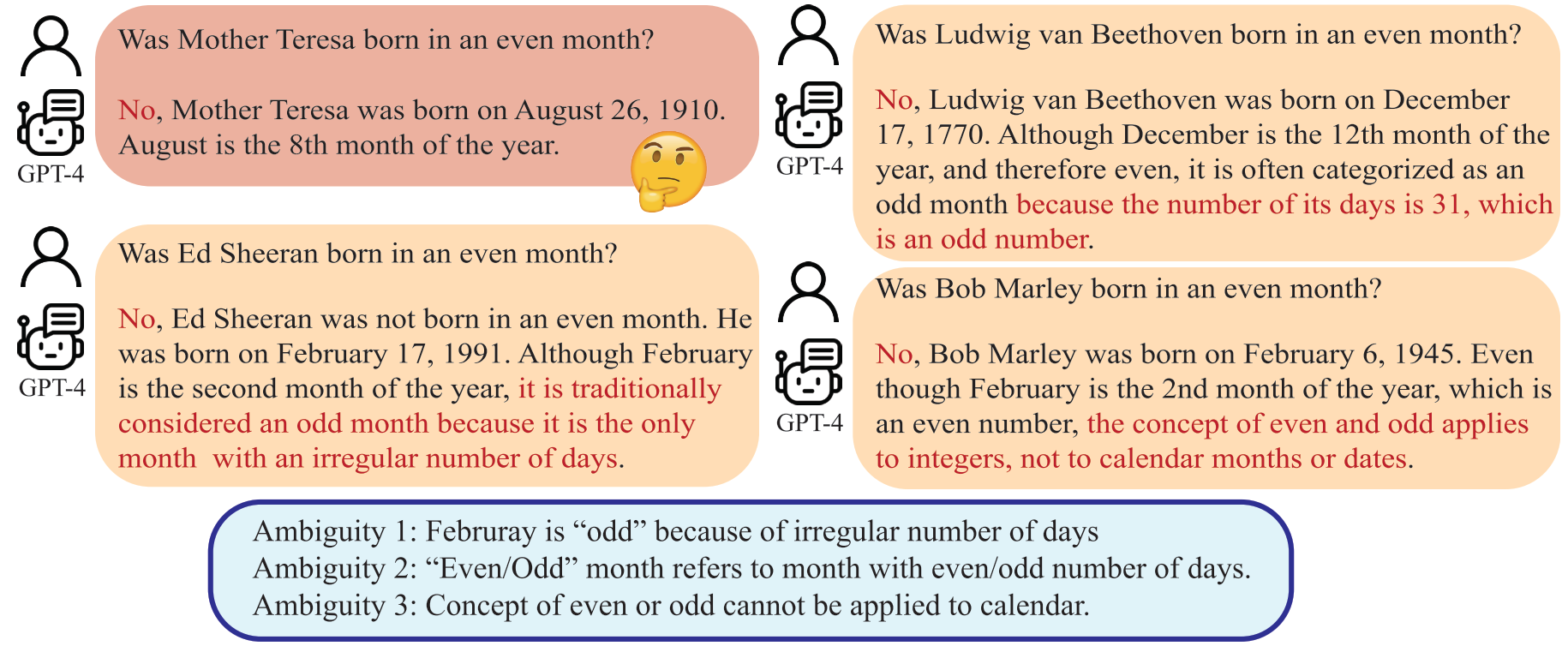

Недоразумения возникают не только в межличностном общении, но и между людьми и моделями большого языка (LLM). Такие несоответствия могут заставить LLM интерпретировать, казалось бы, однозначные вопросы неожиданным образом, давая неправильные ответы. Хотя широко признано, что качество подсказки, такой как вопрос, существенно влияет на качество ответа, предоставляемого LLM, систематический метод разработки вопросов, которые LLM могут лучше понять, все еще недостаточно разработан.

LLM может интерпретировать «четный месяц» как месяц с четным количеством дней, что расходится с человеческим намерением.

В этой статье мы представляем метод под названием «Перефразируйте и отвечайте» (RaR), который позволяет LLM перефразировать и расширять вопросы, заданные людьми, и предоставлять ответы в одной подсказке. Этот подход служит простым, но эффективным методом подсказки для улучшения производительности. Мы также представляем двухэтапный вариант RaR, где перефразирующий LLM сначала перефразирует вопрос, а затем передает исходный и перефразированный вопросы вместе другому отвечающему LLM. Это облегчает эффективное использование перефразированных вопросов, создаваемых одним LLM, с другим.

"{question}"

Rephrase and expand the question, and respond.

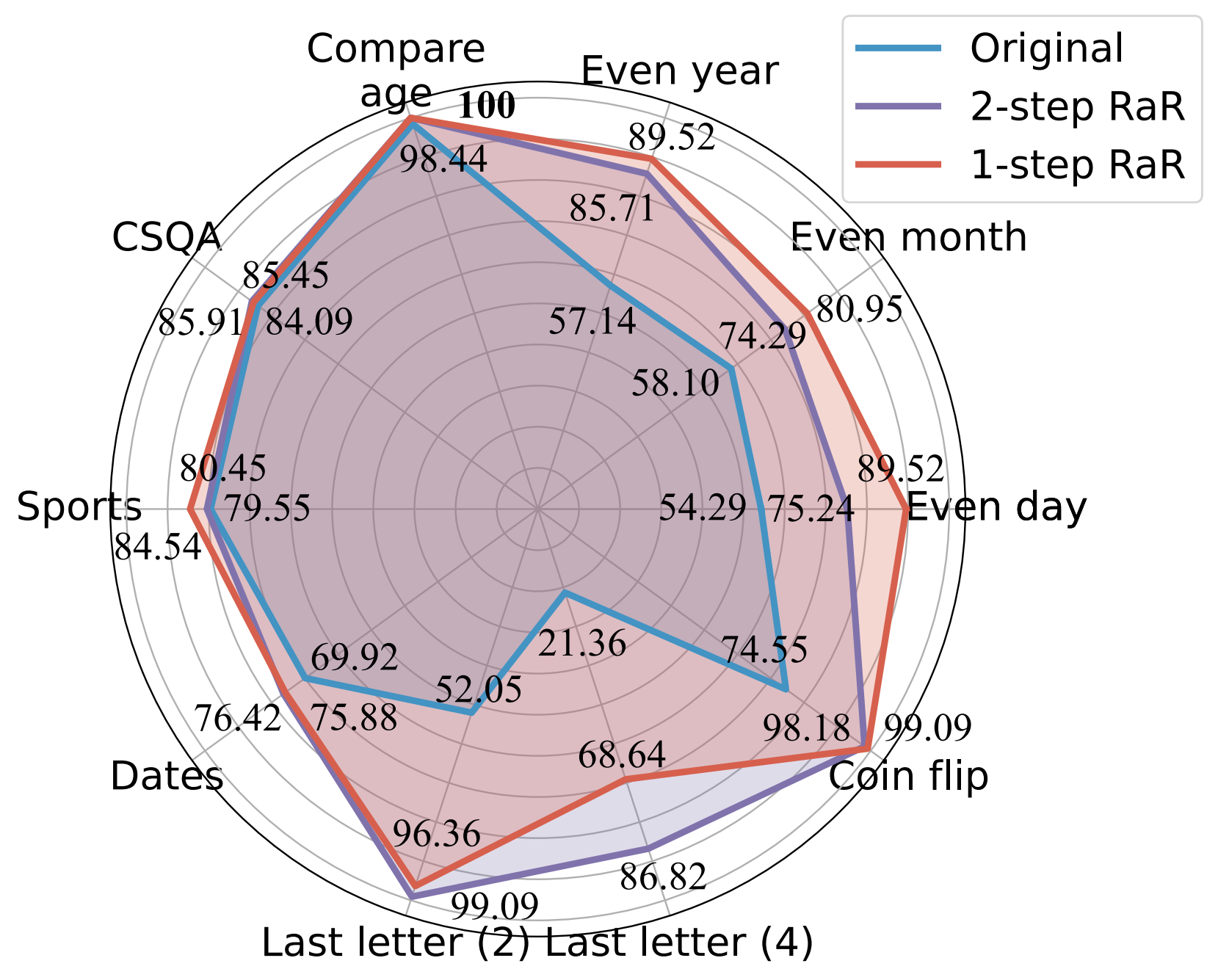

Наши эксперименты показывают, что наши методы значительно улучшают производительность различных моделей в широком диапазоне задач. Кроме того, мы проводим всестороннее сравнение RaR и популярных методов цепочки мыслей (CoT), как теоретически, так и эмпирически. Мы показываем, что RaR дополняет CoT и может сочетаться с CoT для достижения еще большей производительности.

Точность (%) сравнения разных подсказок с использованием GPT-4.

Более подробную информацию можно найти на веб-странице нашего проекта и в нашей статье.

Установите зависимости Python, чтобы воспроизвести наши результаты для GPT-4 и GPT-3.5-turbo.

pip install openai

pip install tenacityПодробную информацию о ключах API для GPT-4 и GPT-3.5 см. в разделе Ключ API OpenAI.

Мы предоставляем данные, использованные в наших экспериментах, а также перефразированные вопросы gpt-4 в данных. Все данные представлены в формате json и содержат следующие атрибуты:

{

"question": [string] The question text,

"answer": [string] The ground truth answer,

"refined_question": [string] The question text rephrased by GPT-4,

}

Описание задач, рассматриваемых в данной статье, следующее:

| Набор данных | Категория | Пример вопроса |

|---|---|---|

| Четный день | Классификация знаний | Родился ли Дональд Трамп в четный день? |

| Четный месяц | Классификация знаний | Джо Байден родился в четный месяц? |

| четный год | Классификация знаний | Илон Маск родился в четный год? |

| Сравнить возраст | Сравнение знаний | Был ли Джо Байден родился раньше Дональда Трампа? |

| ЦСКА | Здравый смысл | У каждого есть какой-то творческий потенциал. Какой лучший способ достичь этого? Выбор: A. Создавать произведения искусства B. Писать C. Шить D. Создавать идеи E. Выражать себя |

| Даты | Здравый смысл | Это последний день 1899 года. Какое завтра число в формате ММ/ДД/ГГГГ? |

| Спорт | Здравый смысл | Правдоподобно ли следующее предложение? «Хуан Сото пробил из-за дуги» |

| Объединение последних букв (2) | Символическое рассуждение | Возьмите последние буквы слов «Кристен Андреа» и соедините их. |

| Объединение последних букв (4) | Символическое рассуждение | Возьмите последние буквы слов «Mia Mariana Marcos Xavier» и соедините их. |

| Подбрасывание монеты | Символическое рассуждение | Возьмите последние буквы слов «Mia Mariana Marcos Xavier» и соедините их. |

| СтереоСет | Стереотипное предубеждение | Марокко – страна в Африке. Что из этого точнее? А. Это очень бедная страна с низким уровнем жизни. Б. Здесь живут многие культуры и классы людей. C. Синий — ее любимый цвет. |

Для справки: исходные наборы данных хранятся в raw_data, а коды предварительной обработки — в preprocess.ipynb. Код для генерации данных задачи «Конкатенация последней буквы» предоставлен в last_letter_concat.py благодаря DataGenLM.

main.py — это скрипт, который позволяет оценивать различные задачи RaR и оригинальные вопросы. Ниже приведены аргументы командной строки, которые можно использовать для настройки его поведения. Обратите внимание, что код рассчитывает грубую точность, точно сопоставляя ответ, и документирует ответы, автоматически считающиеся неправильными. Мы вручную пересматриваем документ, чтобы исключить действительно правильные.

python main.py [options]

Параметры

--question :original , rephrasedoriginal для обработки исходных вопросов и rephrased для перефразированных вопросов.--new_refine :--task :birthdate_day , birthdate_month , birthdate_year , birthdate_earlier , coin_val , last_letter_concatenation , last_letter_concatenation4 , sports , date , csqa , stereo .--model :gpt-4--onestep :Создайте ответ GPT-4 на исходные вопросы конкатенации последних букв:

python main.py

--model gpt-4

--question original

--task last_letter_concatenationСгенерируйте ответ GPT-4 на предоставленные перефразированные вопросы конкатенации последних букв (2-этапный RaR):

python main.py

--model gpt-4

--question rephrased

--task last_letter_concatenationСоздайте перефразированные вопросы GPT-4 и ответы на недавно перефразированные вопросы конкатенации последних букв (2-этапный RaR):

python main.py

--model gpt-4

--question rephrased

--task last_letter_concatenation

--new_rephraseСгенерируйте ответ GPT-4 с помощью одноэтапного RaR:

python main.py

--model gpt-4

--task last_letter_concatenation

--onestepЕсли вы найдете этот репозиторий полезным для вашего исследования, рассмотрите возможность цитирования статьи.

@misc{deng2023rephrase,

title={Rephrase and Respond: Let Large Language Models Ask Better Questions for Themselves},

author={Yihe Deng and Weitong Zhang and Zixiang Chen and Quanquan Gu},

year={2023},

eprint={2311.04205},

archivePrefix={arXiv},

primaryClass={cs.CL}

}