Chinese-ChatBot/Китайский чат-бот

- Автор полностью перешёл на

Направление нейронной сети графа GNN Разработка C++ больше не будет следовать NLP, и код проекта перестанет поддерживаться. Когда проект Юаньсян был завершен, онлайн-ресурсов было очень мало. Автор впервые познакомился с НЛП и глубоким обучением по своей прихоти. Преодолев множество трудностей, он наконец написал эту игрушечную модель. Таким образом, автор знает, что новичкам нелегко, поэтому, даже если проект больше не поддерживается, на вопросы или электронные письма ([email protected]) будут своевременно отвечены, чтобы помочь новичкам в глубоком обучении. (Используемая мной версия Tensorflow слишком старая. Если вы запустите новую версию напрямую, вы обязательно получите различные ошибки. Если вы столкнетесь с трудностями, не утруждайте себя установкой старой версии среды. Рекомендуется использовать Pytorch. реконструировать его по моей логике обработки. Мне лень писать)

- Аспект ГНН:

- Набор эталонных сравнительных моделей: GNNs-Baseline был адаптирован и составлен для облегчения быстрой проверки идей.

- Открытый исходный код моей статьи ACMMM 2023 (CCF-A) находится здесь LSTGM.

- Открытый исходный код моей статьи ICDM 2023 (CCF-B) все еще находится в стадии компиляции. . . ГРН

- Стипендиаты могут добавлять, общаться и учиться.

Конфигурация среды

| программа | Версия |

|---|

| питон | 3,68 |

| тензорный поток | 1.13.1 |

| Керас | 2.2.4 |

| Windows10 | |

| Юпитер | |

Основные справочные материалы

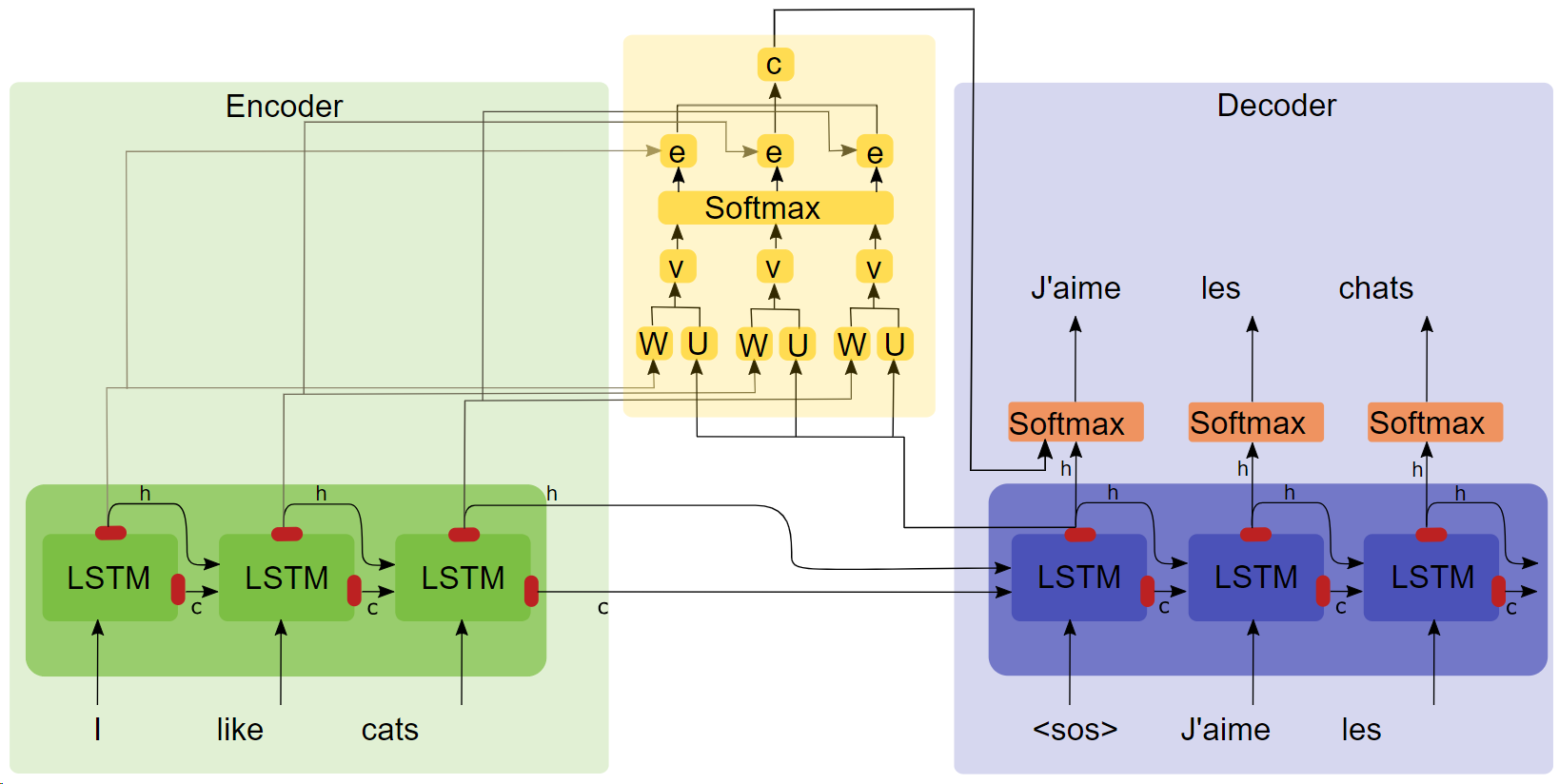

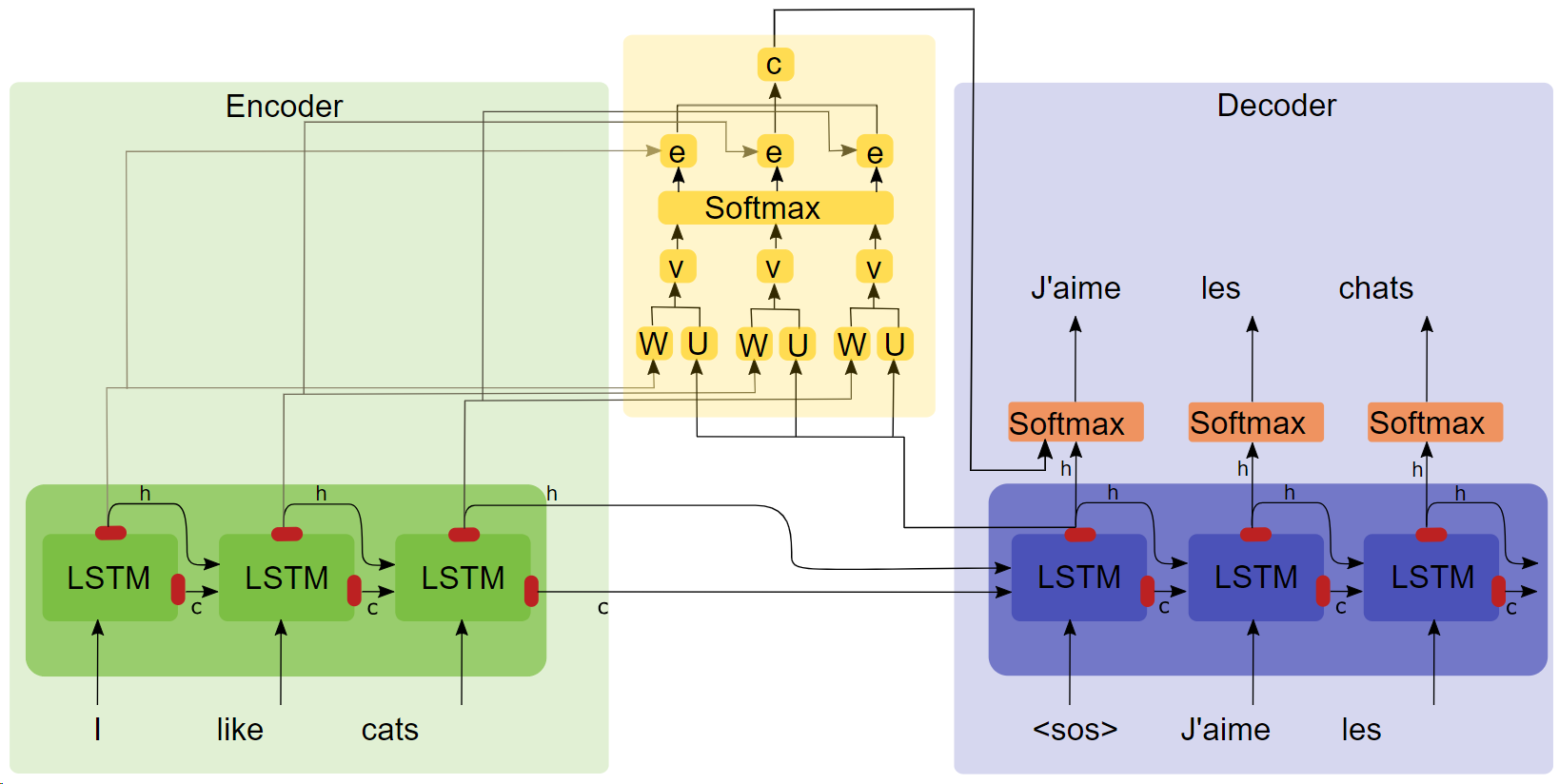

- Диссертация "НЕЙРНО-МАШИННЫЙ ПЕРЕВОД ПУТЕМ СОВМЕСТНОГО ОБУЧЕНИЯ ВЫРАВНИВАНИЮ И ПЕРЕВОДУ ( Нажмите на название, чтобы скачать )"

- Схема структуры внимания

Ключевые моменты

- ЛСТМ

- сек2сек

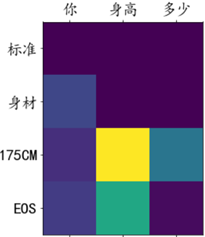

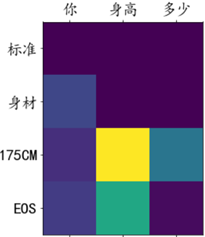

- Эксперименты по вниманию показывают, что после добавления механизма внимания скорость обучения увеличивается, конвергенция быстрее, а эффект лучше.

Корпус и среда обучения

100 000 диалоговых групп из корпуса Qingyun, прошедших обучение в лаборатории Google.

бегать

Способ 1: Полный процесс

- Предварительная обработка данных

get_data

- Модельное обучение

chatbot_train (это версия, смонтированная в Google Colab, локальный путь бега необходимо немного изменить)

- Прогноз модели

chatbot_inference_Attention

Способ 2. Загрузите существующую модель.

- Запустите

chatbot_inference_Attention

- Загрузка

models/W--184-0.5949-.h5

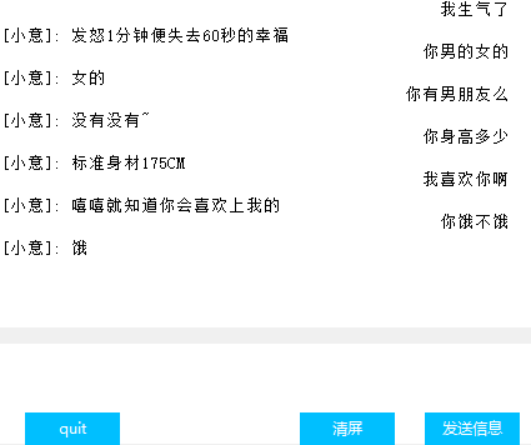

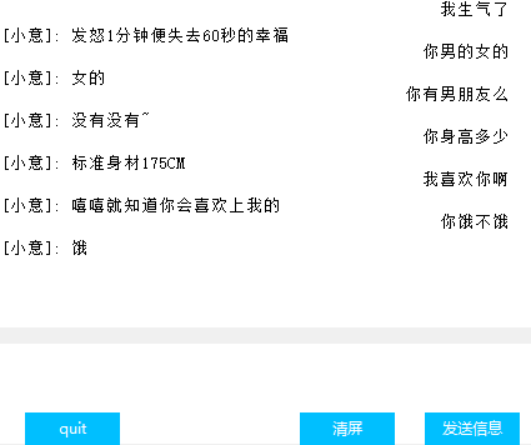

Интерфейс (Ткинтер)

Визуализация веса внимания

другой

- В обучающем файлеchat_bot первые два из трех последних блоков кода используются для монтирования Google Cloud Disk, а последний — для получения этих потерь для облегчения рисования, не знаю, зачем тензорборд в функции обратного вызова. не работает, поэтому я придумал эту стратегию;

- Предпоследний блок кода в файле прогноза имеет только текстовый ввод, но не имеет интерфейса. Последний блок кода — это интерфейс. Один из двух блоков можно запустить немедленно в соответствии с потребностями.

- В коде много промежуточных результатов, надеюсь, это поможет вам понять код;

- Есть модель, которую я обучил на моделях. В нормальной работе проблем быть не должно. Можно и самому обучить.

- Автор имеет ограниченные возможности и не нашел показателя для количественной оценки эффекта диалога, поэтому потери могут лишь приблизительно отражать прогресс обучения.