КСерве

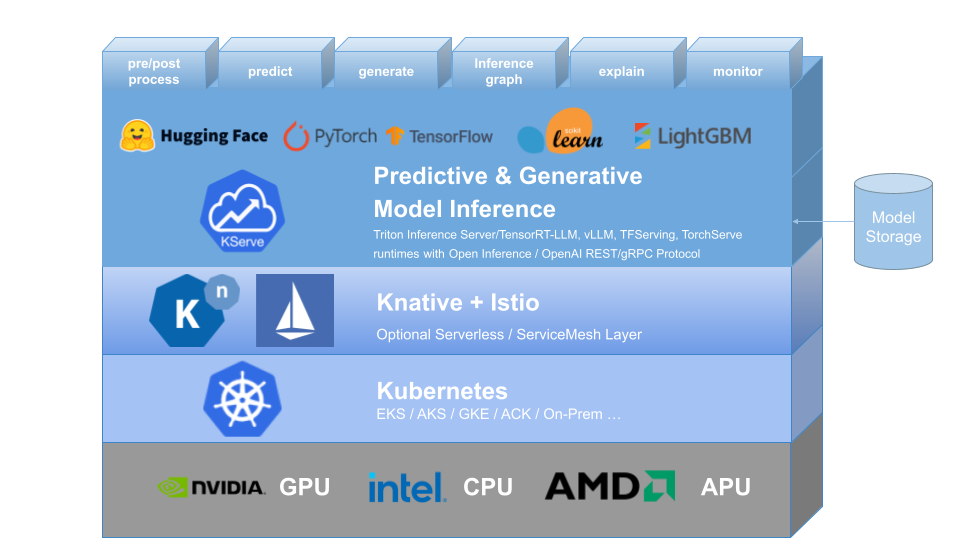

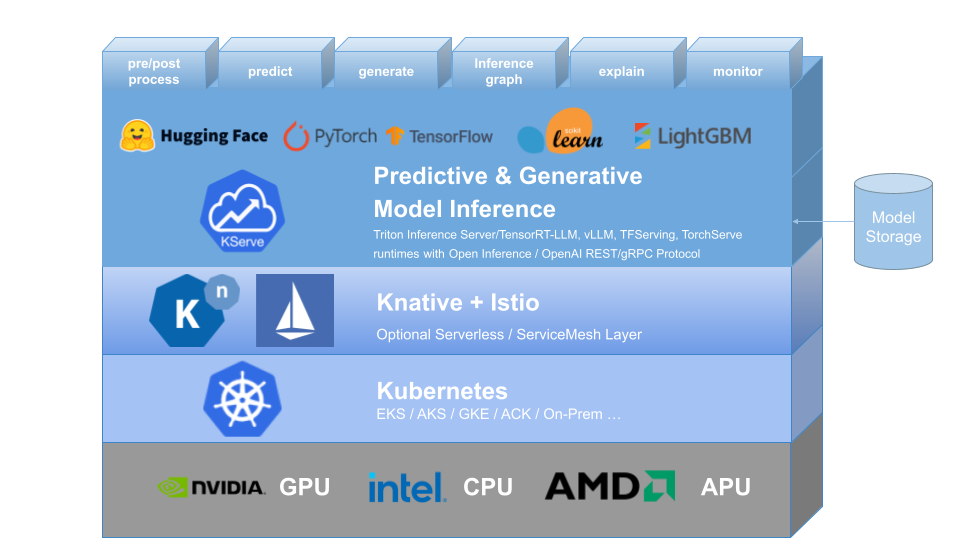

KServe предоставляет определение пользовательского ресурса Kubernetes для обслуживания моделей прогнозного и генеративного машинного обучения (ML). Он направлен на решение сценариев использования производственных моделей, предоставляя интерфейсы с высокой абстракцией для моделей Tensorflow, XGBoost, ScikitLearn, PyTorch, Huggingface Transformer/LLM с использованием стандартизированных протоколов плоскости данных.

Он воплощает в себе сложность автоматического масштабирования, работы в сети, проверки работоспособности и настройки сервера, чтобы обеспечить передовые функции обслуживания, такие как автомасштабирование графического процессора, масштабирование до нуля и канарское развертывание, в ваших развертываниях машинного обучения. Он обеспечивает простую, подключаемую и полную историю для обслуживания производственного машинного обучения, включая прогнозирование, предварительную обработку, постобработку и объяснимость. KServe используется в различных организациях.

Для получения более подробной информации посетите веб-сайт KServe.

KFServing был переименован в KServe начиная с версии 0.7.

Почему KServe?

- KServe — это стандартная, независимая от облака платформа вывода моделей для обслуживания прогнозирующих и генеративных моделей искусственного интеллекта в Kubernetes, созданная для сценариев использования с высокой степенью масштабируемости.

- Обеспечивает производительный стандартизированный протокол вывода для платформ машинного обучения, включая спецификацию OpenAI для генеративных моделей.

- Поддержка современной рабочей нагрузки бессерверного вывода с автоматическим масштабированием на основе запросов, включая масштабирование до нуля на ЦП и ГП .

- Обеспечивает высокую масштабируемость, плотность упаковки и интеллектуальную маршрутизацию с использованием ModelMesh .

- Простое и подключаемое производство, предназначенное для вывода , предварительной и последующей обработки , мониторинга и объяснения .

- Расширенные развертывания для канареечного развертывания , конвейера и ансамблей с InferenceGraph .

Узнать больше

Чтобы узнать больше о KServe, о том, как использовать различные поддерживаемые функции и как участвовать в сообществе KServe, следуйте документации веб-сайта KServe. Кроме того, мы составили список презентаций и демонстраций, чтобы разобраться в различных деталях.

Установка

Автономная установка

- Бессерверная установка : KServe по умолчанию устанавливает Knative для бессерверного развертывания InferenceService.

- Установка с необработанным развертыванием : по сравнению с бессерверной установкой это более легкая установка. Однако этот параметр не поддерживает канареечное развертывание и автоматическое масштабирование на основе запросов с масштабированием до нуля.

- Установка ModelMesh . Вы можете дополнительно установить ModelMesh, чтобы обеспечить крупномасштабные , высокоплотные и часто меняющиеся сценарии использования моделей .

- Быстрая установка : установите KServe на свой локальный компьютер.

Установка Кубефлоу

KServe — важный дополнительный компонент Kubeflow. Подробную информацию можно найти в документации Kubeflow KServe. Ознакомьтесь со следующими руководствами по работе на AWS или на платформе контейнеров OpenShift.

? Создайте свой первый сервис InferenceService.

Дорожная карта

Справочник по API InferenceService

? Руководство разработчика

✍️ Руководство для авторов

? Усыновители