100 дней программирования с помощью машинного обучения, предложенное Сираджем Равалем

Получите наборы данных отсюда

Посмотрите код отсюда.

Проверьте код отсюда.

Проверьте код отсюда.

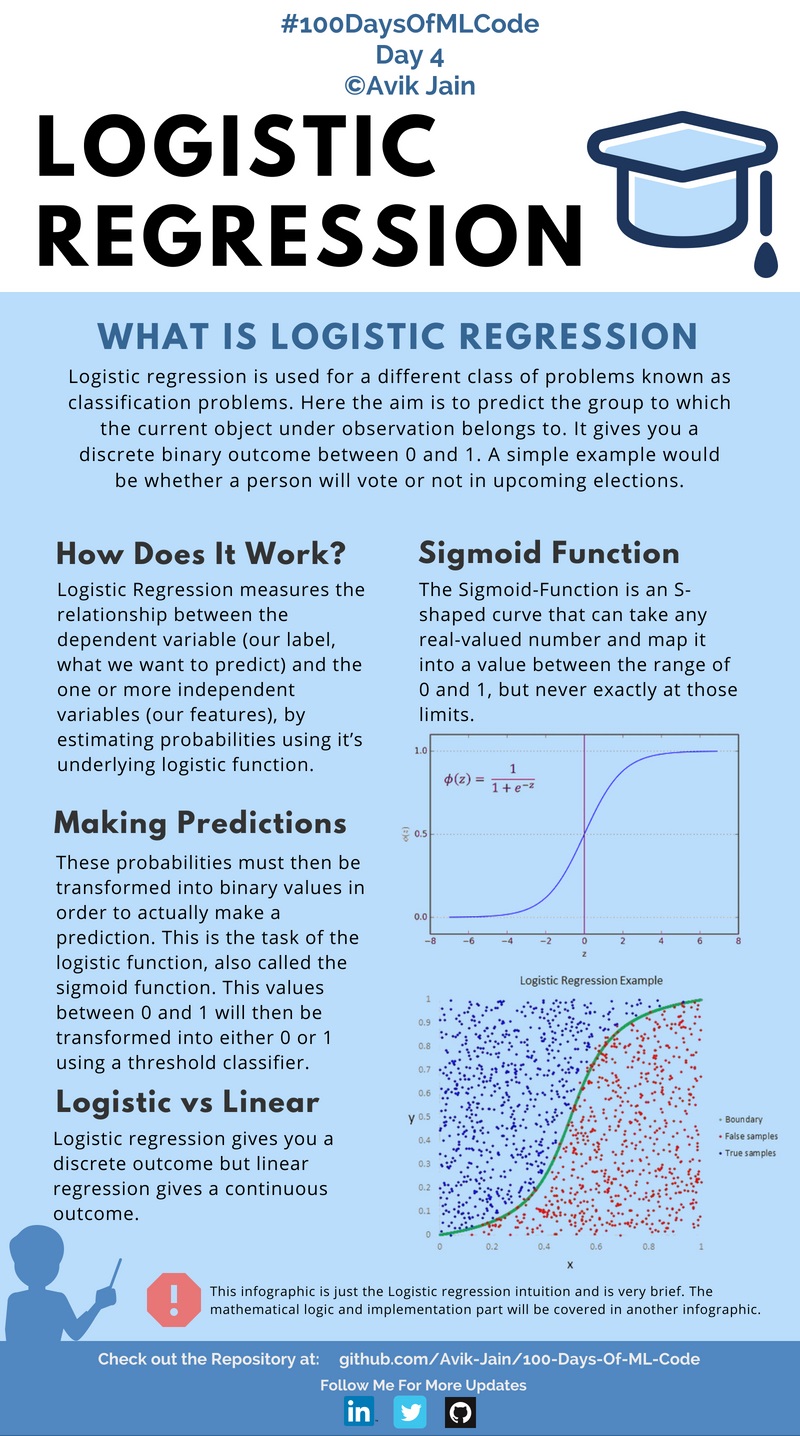

Переходя к #100DaysOfMLCode сегодня, я углубился в то, что на самом деле представляет собой логистическая регрессия и какие математические вычисления стоят за ней. Изучили, как рассчитывается функция стоимости, а затем как применять алгоритм градиентного спуска к функции стоимости, чтобы минимизировать ошибку прогнозирования.

Из-за меньшего количества времени я теперь буду публиковать инфографику через день. Также, если кто-то хочет помочь мне с документацией кода и уже имеет некоторый опыт в этой области и знает Markdown для GitHub, свяжитесь со мной в LinkedIn :).

Ознакомьтесь с кодом здесь

#100DaysOfMLCode Чтобы прояснить свои представления о логистической регрессии, я искал в Интернете какой-нибудь ресурс или статью и наткнулся на эту статью (https://towardsdatascience.com/logistic-reгрессия-detailed-overview-46c4da4303bc) Саишрути Сваминатана.

Он дает подробное описание логистической регрессии. Проверьте это.

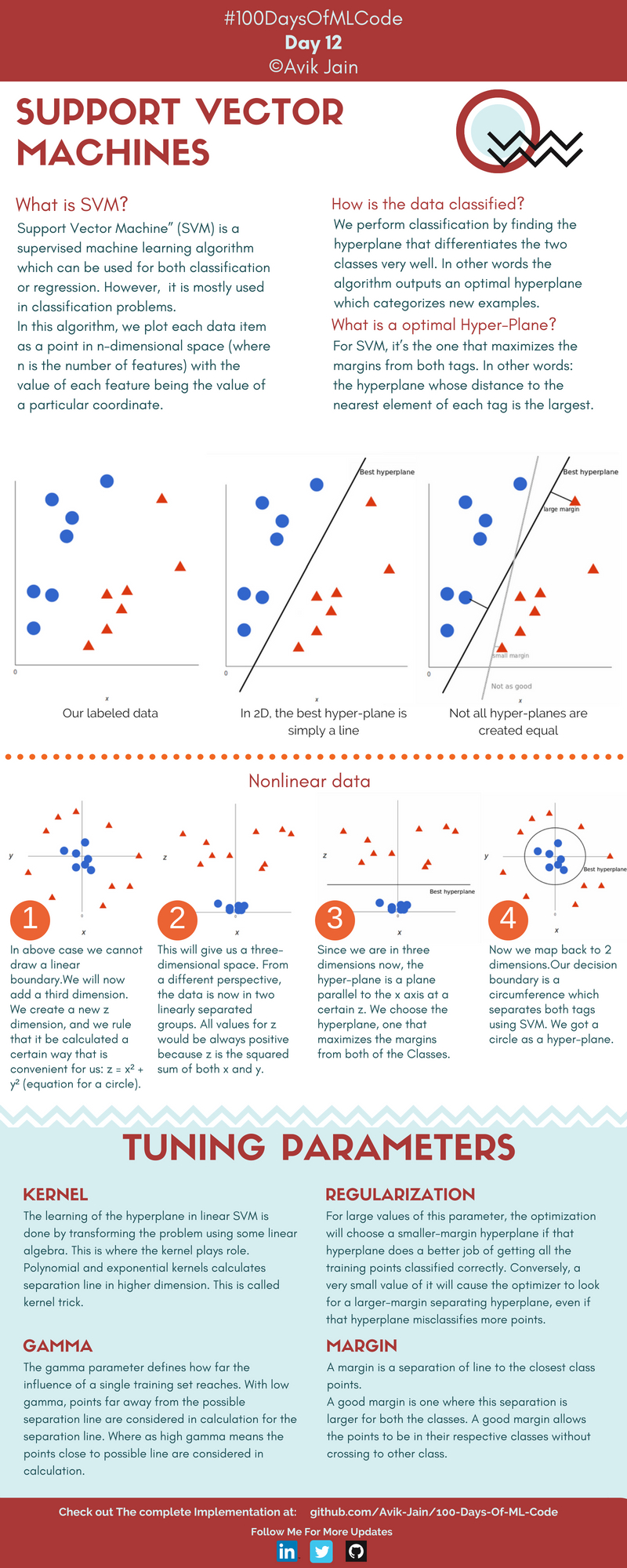

Получил представление о том, что такое SVM и как он используется для решения проблемы классификации.

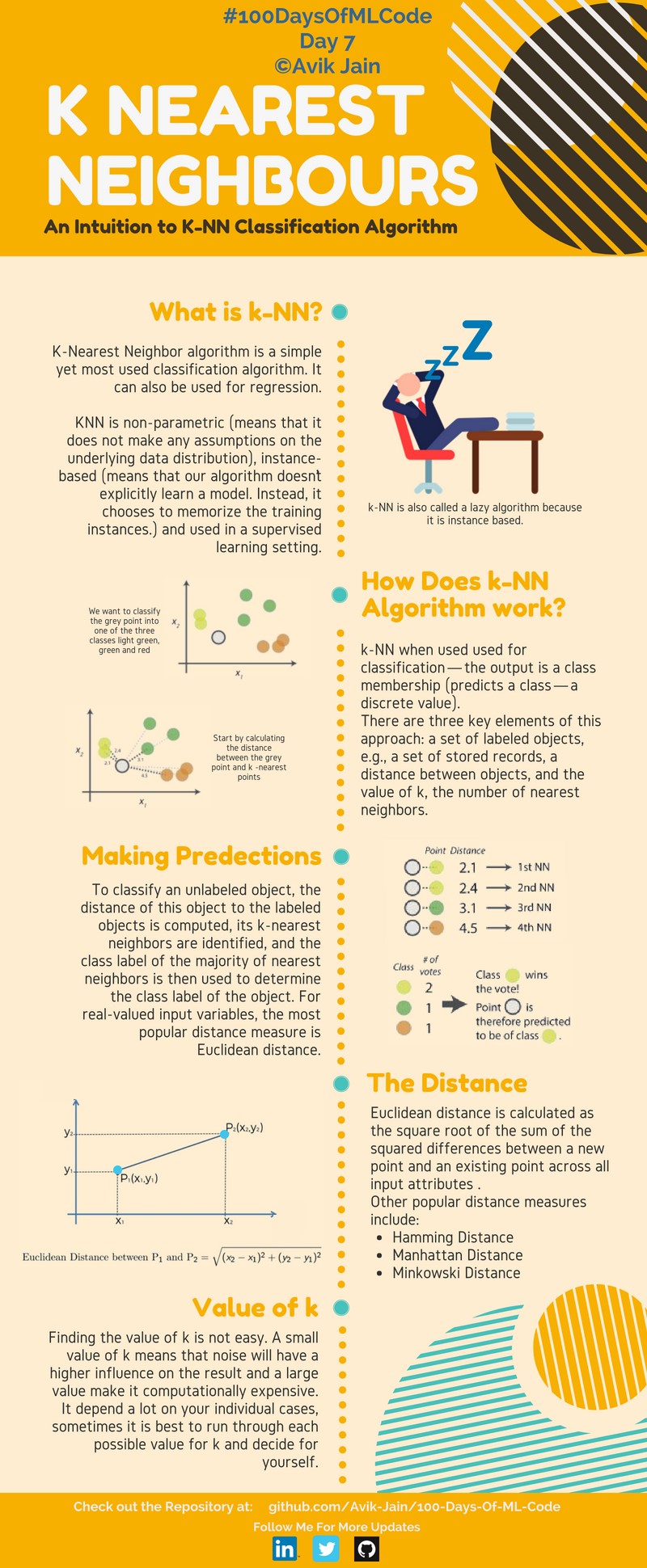

Узнайте больше о том, как работает SVM и о реализации алгоритма K-NN.

Реализован алгоритм классификации K-NN. #100DaysOfMLCode Инфографика машины опорных векторов наполовину завершена. Завтра обновлю.

Продолжая сегодня #100DaysOfMLCode, я рассмотрел наивный байесовский классификатор. Я также реализую SVM в Python, используя scikit-learn. Скоро обновлю код.

Сегодня я реализовал SVM на линейно связанных данных. Использована библиотека Scikit-Learn. В Scikit-Learn у нас есть классификатор SVC, который мы используем для решения этой задачи. В следующей реализации мы будем использовать трюк с ядром. Проверьте код здесь.

Изучили различные типы наивных байесовских классификаторов. Также начались лекции Bloomberg. Первым в плейлисте было «Машинное обучение черного ящика». Он дает полный обзор функций прогнозирования, извлечения признаков, алгоритмов обучения, оценки производительности, перекрестной проверки, систематической ошибки выборки, нестационарности, переобучения и настройки гиперпараметров.

С использованием библиотеки Scikit-Learn реализован алгоритм SVM вместе с функцией ядра, которая отображает точки наших данных в более высоком измерении для поиска оптимальной гиперплоскости.

Пройдена вся неделя 1 и неделя 2 за один день. Изучил логистическую регрессию как нейронную сеть.

Закончил 1 курс по специализации глубокого обучения. Реализовал нейросеть на питоне.

Начата лекция 1 из 18 курса машинного обучения Калифорнийского технологического института — CS 156 профессора Ясера Абу-Мостафы. По сути, это было введение к предстоящим лекциям. Он также объяснил алгоритм перцептрона.

Завершена первая неделя улучшения глубоких нейронных сетей: настройка гиперпараметров, регуляризация и оптимизация.

Просмотрел несколько руководств о том, как выполнять парсинг веб-страниц с помощью Beautiful Soup, чтобы собрать данные для построения модели.

Лекция 2 из 18 курса машинного обучения Калифорнийского технологического института — CS 156 профессора Ясера Абу-Мостафы. Узнал о неравенстве Хёффдинга.

В лекции 3 курса Bloomberg ML были представлены некоторые основные понятия, такие как пространство ввода, пространство действий, пространство результатов, функции прогнозирования, функции потерь и пространства гипотез.

Проверьте код здесь.

Нашёл на YouTube потрясающий канал 3Blue1Brown. В нем есть плейлист под названием «Сущность линейной алгебры». Начал с создания 4 видеороликов, которые дали полный обзор векторов, линейных комбинаций, интервалов, базисных векторов, линейных преобразований и умножения матриц.

Ссылка на плейлист здесь.

В продолжение плейлиста завершены следующие 4 видеоролика, посвященные темам: 3D-преобразования, определители, обратная матрица, пространство столбцов, нулевое пространство и неквадратные матрицы.

Ссылка на плейлист здесь.

В плейлисте 3Blue1Brown пополнились еще 3 видео из сути линейной алгебры. Темами обсуждения были скалярное произведение и перекрестное произведение.

Ссылка на плейлист здесь.

Доделал сегодня весь плейлист, видео 12-14. Действительно потрясающий плейлист, чтобы освежить понятия линейной алгебры. Рассматриваемые темы включали изменение базиса, собственные векторы и собственные значения, а также абстрактные векторные пространства.

Ссылка на плейлист здесь.

Завершаем плейлист - Сущность линейной алгебры от 3blue1brown. На YouTube появилось предложение снова сделать серию видеороликов на том же канале 3Blue1Brown. Будучи уже впечатленным предыдущей серией по линейной алгебре, я сразу же погрузился в нее. Снял около 5 видеороликов по таким темам, как производные, правило цепочки, правило произведения и производная экспоненты.

Ссылка на плейлист здесь.

Посмотрел 2 видео по теме Implicit Diffrentiation and Limits из плейлиста Essence of Calculus.

Ссылка на плейлист здесь.

Просмотрел оставшиеся 4 видеоролика, посвященные таким темам, как интеграция и производные более высокого порядка.

Ссылка на плейлист здесь.

Проверьте код здесь.

Удивительное видео о нейронных сетях от YouTube-канала 3Blue1Brown. Это видео дает хорошее представление о нейронных сетях и использует набор рукописных цифр для объяснения этой концепции. Ссылка на видео.

Вторая часть нейросетей от youtube-канала 3Blue1Brown. В этом видео интересно объясняются концепции градиентного спуска. 169 обязательно посмотрите и настоятельно рекомендую. Ссылка на видео.

Третья часть нейросетей от youtube-канала 3Blue1Brown. В этом видео в основном обсуждаются частные производные и обратное распространение ошибки. Ссылка на видео.

Четвертая часть нейронных сетей от YouTube-канала 3Blue1Brown. Целью здесь является представление, в несколько более формальных терминах, интуитивного понимания того, как работает обратное распространение ошибки, и в видео в основном обсуждаются частные производные и обратное распространение ошибки. Ссылка на видео.

Ссылка на видео.

Ссылка на видео.

Ссылка на видео.

Ссылка на видео.

Перешел на обучение без учителя и изучил кластеризацию. Работаю над своим сайтом, загляните на avikjain.me. Также нашел замечательную анимацию, которая поможет легко понять кластеризацию K - Means.

Реализована кластеризация K означает. Проверьте код здесь.

Получил новую книгу Дж. К. ВандерПласа «Python Data Science Handbook». Проверьте блокноты Jupyter здесь.

Начал с главы 2: Введение в Numpy. Охвачены такие темы, как типы данных, массивы Numpy и вычисления на массивах Numpy.

Проверьте код -

Введение в NumPy

Понимание типов данных в Python

Основы массивов NumPy

Вычисления на массивах NumPy: универсальные функции

Глава 2: Агрегации, сравнения и трансляция

Ссылка на блокнот:

Агрегации: мин, макс и все, что между ними

Вычисления на массивах: вещание

Сравнения, маски и булева логика

Глава 2: Необычное индексирование, сортировка массивов, структурированные данные

Ссылка на блокнот:

Необычное индексирование

Сортировка массивов

Структурированные данные: структурированные массивы NumPy

Глава 3: Манипулирование данными с помощью Pandas

Охвачены различные темы, такие как объекты Pandas, индексирование и выбор данных, работа с данными, обработка отсутствующих данных, иерархическое индексирование, ConCat и добавление.

Ссылка на блокноты:

Манипулирование данными с помощью Pandas

Знакомство с объектами Pandas

Индексирование и выбор данных

Работа с данными в Pandas

Обработка недостающих данных

Иерархическое индексирование

Объединение наборов данных: объединение и добавление

Глава 3: Выполнены следующие темы: «Слияние и объединение», «Агрегация и группировка» и «Сводные таблицы».

Объединение наборов данных: объединить и объединить

Агрегация и группировка

Сводные таблицы

Глава 3. Операции с векторизованными строками, работа с временными рядами

Ссылки на блокноты:

Векторизованные строковые операции

Работа с временными рядами

Высокопроизводительные Pandas: eval() и query()

Глава 4. Визуализация с помощью Matplotlib. Изучены простые линейные графики, простые диаграммы рассеяния, а также графики плотности и контурные графики.

Ссылки на блокноты:

Визуализация с помощью Matplotlib

Простые линейные графики

Простые диаграммы рассеяния

Визуализация ошибок

Графики плотности и контуров

Глава 4. Визуализация с помощью Matplotlib. Узнайте о гистограммах, о том, как настраивать легенды графиков, цветные полосы и создавать несколько подграфиков.

Ссылки на блокноты:

Гистограммы, биннинги и плотность

Настройка легенды графика

Настройка цветовых полос

Несколько подзаголовков

Текст и аннотации

Глава 4. Описано построение трехмерных графиков в Mathplotlib.

Ссылки на блокноты:

Трехмерное построение в Matplotlib

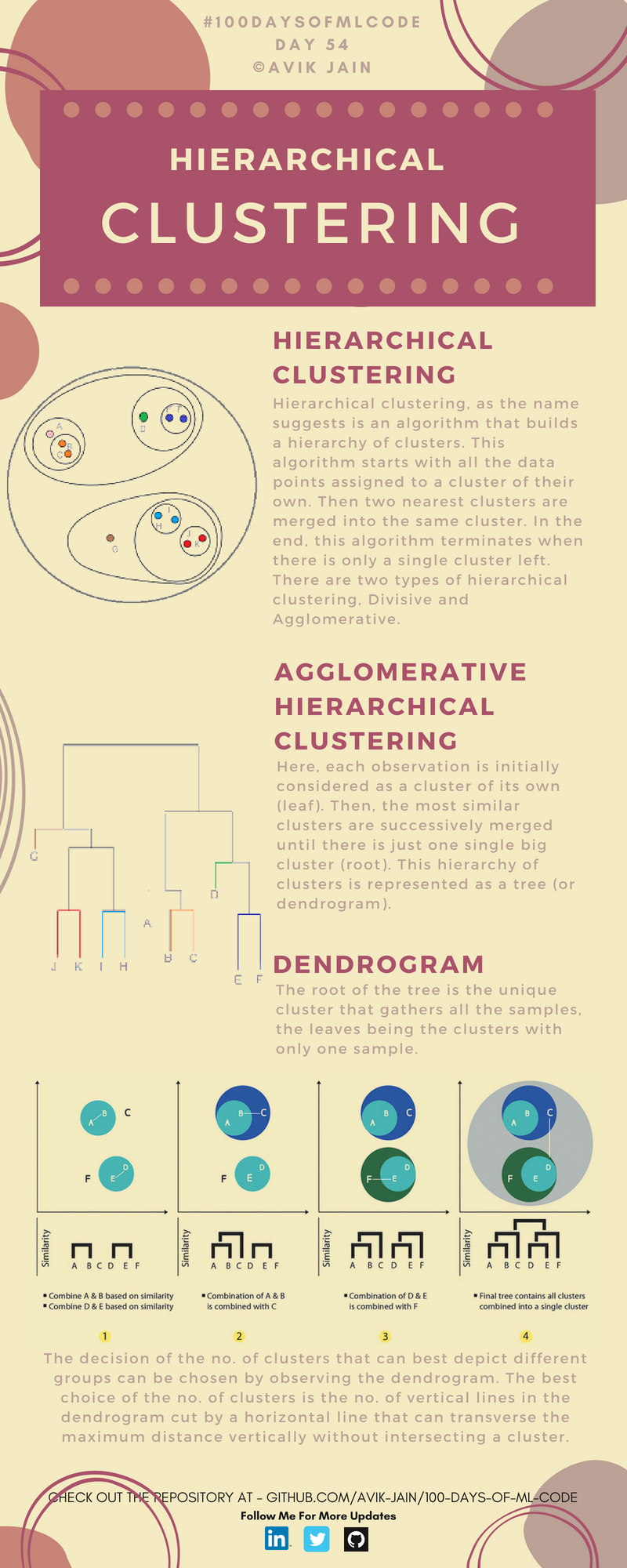

Изучал иерархическую кластеризацию. Взгляните на эту удивительную визуализацию.