Building a RAG System

1.0.0

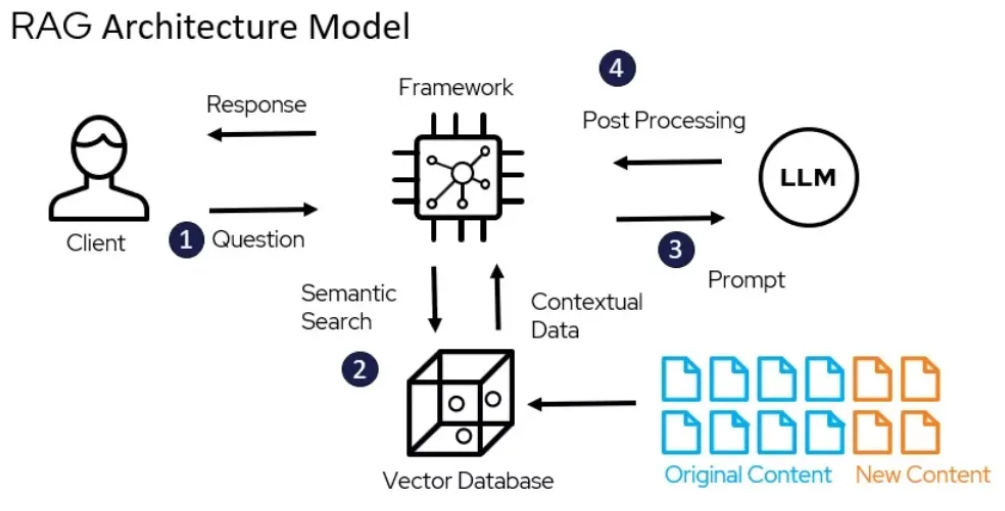

Как мы знаем, таким LLM, как Gemini, не хватает конкретной информации о компании. Но эта последняя информация доступна в PDF-файлах, текстовых файлах и т. д. Теперь, если мы сможем соединить наш LLM с этими источниками, мы сможем создать гораздо лучшее приложение.

Используя структуру LangChain, я создал систему расширенной генерации поиска (RAG), которая может использовать возможности LLM, такие как Gemini 1.5 Pro, для ответа на вопросы в документе «Не оставлять контекст позади», опубликованном Google 10 апреля 2024 года. В этом процессе внешние данные (т. е. документ «Не оставлять контекст») извлекаются, а затем передаются в LLM на этапе генерации.

Вы можете найти бумагу здесь.

Полную реализацию кода можно найти здесь.