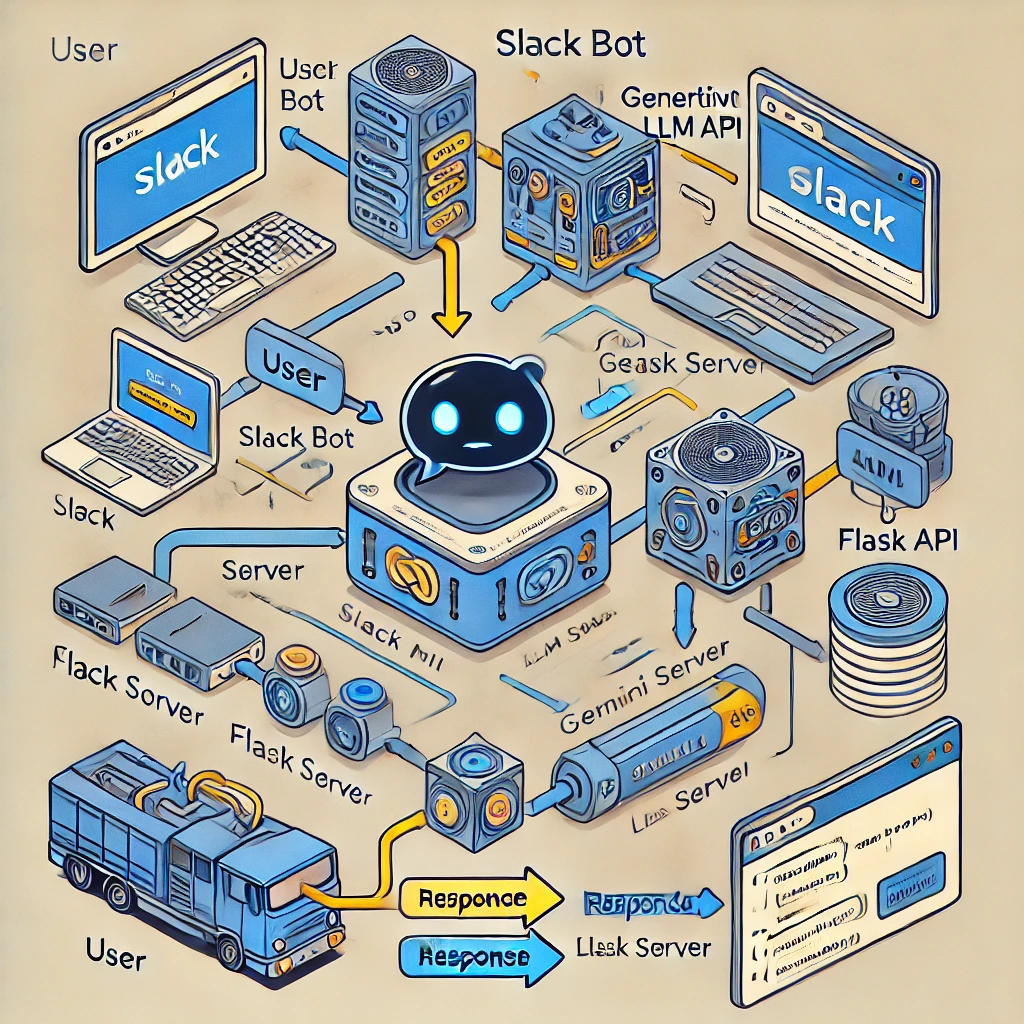

Этот проект демонстрирует, как интегрировать бота Slack с чат-ботом на основе модели большого языка (LLM) с использованием модели Google Gemini. Интеграция обеспечивает интеллектуальное и контекстно-зависимое общение непосредственно внутри Slack.

Бот Slack создан с использованием Python и Flask и интегрирован с чат-ботом на базе LLM, использующим модель Gemini. Эта настройка позволяет боту обрабатывать вводимые пользователем данные в каналах Slack и разумно реагировать на основе новейшей информации по обработке данных.

Используемые библиотеки: slack_sdk, slack_bolt Функциональность: бот прослушивает события app_mention, которые срабатывают, когда кто-то упоминает бота в канале Slack. Конфигурация: токены и секреты безопасно загружаются из файла .env с использованием переменных среды.

Flask App: The Flask app handles incoming HTTP requests from Slack.

Event Processing: Slack events are processed through Flask using SlackRequestHandler from the slack_bolt.adapter.flask module.

Gemini Model: The Gemini model, provided by Google's Generative AI platform, processes and responds to queries.

Python Package: The google.generativeai package is used to interact with the Gemini model, allowing for prompt-based queries.

Configuration: Tokens are securely loaded from a .env file using environment variables for geminiai api.

Использование ngrok: ngrok предоставляет общедоступный URL-адрес, который перенаправляет запросы в локальное приложение Flask, позволяя Slack взаимодействовать с ботом. Команда установки: ngrok http 6060 используется для доступа приложения Flask к Интернету.

В результате интеграции появился бот Slack, способный выполнять расширенный анализ данных и интеллектуально отвечать на запросы пользователей внутри Slack.