flash attention jax

0.3.1

Реализация Flash Attention в Jax. Вероятно, она будет не такой производительной, как официальная версия CUDA, учитывая отсутствие возможности точного управления памятью. Но просто в образовательных целях, а также для того, чтобы увидеть, насколько умен (или нет) компилятор XLA.

$ pip install flash-attention-jax from jax import random

from flash_attention_jax import flash_attention

rng_key = random . PRNGKey ( 42 )

q = random . normal ( rng_key , ( 1 , 2 , 131072 , 512 )) # (batch, heads, seq, dim)

k = random . normal ( rng_key , ( 1 , 2 , 131072 , 512 ))

v = random . normal ( rng_key , ( 1 , 2 , 131072 , 512 ))

mask = random . randint ( rng_key , ( 1 , 131072 ,), 0 , 2 ) # (batch, seq)

out , _ = flash_attention ( q , k , v , mask )

out . shape # (1, 2, 131072, 512) - (batch, heads, seq, dim)Быстрая проверка работоспособности

from flash_attention_jax import plain_attention , flash_attention , value_and_grad_difference

diff , ( dq_diff , dk_diff , dv_diff ) = value_and_grad_difference (

plain_attention ,

flash_attention ,

seed = 42

)

print ( 'shows differences between normal and flash attention for output, dq, dk, dv' )

print ( f'o: { diff } ' ) # < 1e-4

print ( f'dq: { dq_diff } ' ) # < 1e-6

print ( f'dk: { dk_diff } ' ) # < 1e-6

print ( f'dv: { dv_diff } ' ) # < 1e-6Авторегрессионное мгновенное внимание — внимание декодера, подобное GPT.

from jax import random

from flash_attention_jax import causal_flash_attention

rng_key = random . PRNGKey ( 42 )

q = random . normal ( rng_key , ( 131072 , 512 ))

k = random . normal ( rng_key , ( 131072 , 512 ))

v = random . normal ( rng_key , ( 131072 , 512 ))

out , _ = causal_flash_attention ( q , k , v )

out . shape # (131072, 512) Ведущие измерения для варианта причинно-следственной вспышки внимания

выяснить проблему с jit и статическими аргументами

комментарий со ссылками на бумажные алгоритмы и пояснениями

убедитесь, что он может работать с однонаправленными ключами/значениями, как в PaLM

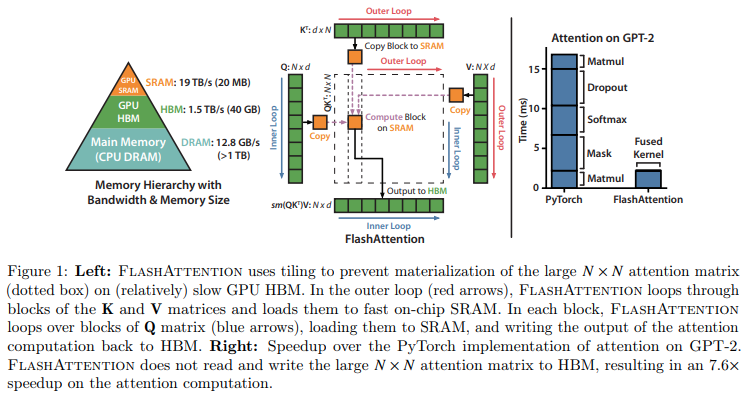

@article { Dao2022FlashAttentionFA ,

title = { FlashAttention: Fast and Memory-Efficient Exact Attention with IO-Awareness } ,

author = { Tri Dao and Daniel Y. Fu and Stefano Ermon and Atri Rudra and Christopher R'e } ,

journal = { ArXiv } ,

year = { 2022 } ,

volume = { abs/2205.14135 }

} @article { Rabe2021SelfattentionDN ,

title = { Self-attention Does Not Need O(n2) Memory } ,

author = { Markus N. Rabe and Charles Staats } ,

journal = { ArXiv } ,

year = { 2021 } ,

volume = { abs/2112.05682 }

}