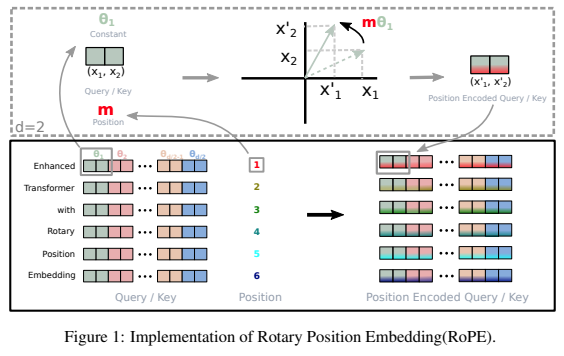

Автономная библиотека для добавления вращающихся вложений к трансформаторам в Pytorch, после ее успеха в качестве относительного позиционного кодирования. В частности, это сделает вращение информации по любой оси тензора простым и эффективным, независимо от того, зафиксировано ли их положение или изучено. Эта библиотека предоставит вам самые современные результаты для позиционного встраивания при небольших затратах.

Моя интуиция также подсказывает мне, что в вращениях есть что-то еще, что можно использовать в искусственных нейронных сетях.

$ pip install rotary-embedding-torch import torch

from rotary_embedding_torch import RotaryEmbedding

# instantiate the positional embedding in your transformer and pass to all your attention layers

rotary_emb = RotaryEmbedding ( dim = 32 )

# mock queries and keys - dimensions should end with (seq_len, feature dimension), and any number of preceding dimensions (batch, heads, etc)

q = torch . randn ( 1 , 8 , 1024 , 64 ) # queries - (batch, heads, seq len, dimension of head)

k = torch . randn ( 1 , 8 , 1024 , 64 ) # keys

# apply the rotations to your queries and keys after the heads have been split out, but prior to the dot product and subsequent softmax (attention)

q = rotary_emb . rotate_queries_or_keys ( q )

k = rotary_emb . rotate_queries_or_keys ( k )

# then do your attention with your queries (q) and keys (k) as usualЕсли вы правильно выполните все вышеперечисленные шаги, вы должны увидеть значительное улучшение во время тренировки.

При работе с кэшами ключей/значений при выводе позиция запроса должна быть смещена с помощью key_value_seq_length - query_seq_length

Чтобы упростить это, используйте метод rotate_queries_with_cached_keys

q = torch . randn ( 1 , 8 , 1 , 64 ) # only one query at a time

k = torch . randn ( 1 , 8 , 1024 , 64 ) # key / values with cache concatted

q , k = rotary_emb . rotate_queries_with_cached_keys ( q , k )Вы также можете сделать это вручную, вот так

q = rotary_emb . rotate_queries_or_keys ( q , offset = k . shape [ - 2 ] - q . shape [ - 2 ])Для удобства использования n-мерного осевого относительного позиционного встраивания, т.е. видеотрансформаторы

import torch

from rotary_embedding_torch import (

RotaryEmbedding ,

apply_rotary_emb

)

pos_emb = RotaryEmbedding (

dim = 16 ,

freqs_for = 'pixel' ,

max_freq = 256

)

# queries and keys for frequencies to be rotated into

# say for a video with 8 frames, and rectangular image (feature dimension comes last)

q = torch . randn ( 1 , 8 , 64 , 32 , 64 )

k = torch . randn ( 1 , 8 , 64 , 32 , 64 )

# get axial frequencies - (8, 64, 32, 16 * 3 = 48)

# will automatically do partial rotary

freqs = pos_emb . get_axial_freqs ( 8 , 64 , 32 )

# rotate in frequencies

q = apply_rotary_emb ( freqs , q )

k = apply_rotary_emb ( freqs , k ) В этой статье они смогли решить проблему экстраполяции длины с помощью вращающихся вложений, придав ей распад, аналогичный ALiBi. Они назвали этот метод XPos, и вы можете использовать его, установив use_xpos = True при инициализации.

Это можно использовать только для авторегрессионных трансформаторов.

import torch

from rotary_embedding_torch import RotaryEmbedding

# instantiate the positional embedding in your transformer and pass to all your attention layers

rotary_emb = RotaryEmbedding (

dim = 32 ,

use_xpos = True # set this to True to make rotary embeddings extrapolate better to sequence lengths greater than the one used at training time

)

# mock queries and keys - dimensions should end with (seq_len, feature dimension), and any number of preceding dimensions (batch, heads, etc)

q = torch . randn ( 1 , 8 , 1024 , 64 ) # queries - (batch, heads, seq len, dimension of head)

k = torch . randn ( 1 , 8 , 1024 , 64 ) # keys

# apply the rotations to your queries and keys after the heads have been split out, but prior to the dot product and subsequent softmax (attention)

# instead of using `rotate_queries_or_keys`, you will use `rotate_queries_and_keys`, the rest is taken care of

q , k = rotary_emb . rotate_queries_and_keys ( q , k )В этом документе MetaAI предлагается простая настройка интерполяции позиций последовательности для расширения контекста до большей длины для предварительно обученных моделей. Они показывают, что это работает намного лучше, чем простая точная настройка тех же позиций последовательности, но расширенная.

Вы можете использовать это, установив interpolate_factor при инициализации на значение больше 1. (например, если предварительно обученная модель была обучена в 2048 году, установка interpolate_factor = 2. позволит выполнить точную настройку до 2048 x 2. = 4096 ).

Обновление: кто-то из сообщества сообщил, что это работает не очень хорошо. пожалуйста, напишите мне, если вы видите положительный или отрицательный результат

import torch

from rotary_embedding_torch import RotaryEmbedding

rotary_emb = RotaryEmbedding (

dim = 32 ,

interpolate_factor = 2. # add this line of code to pretrained model and fine-tune for ~1000 steps, as shown in paper

) @misc { su2021roformer ,

title = { RoFormer: Enhanced Transformer with Rotary Position Embedding } ,

author = { Jianlin Su and Yu Lu and Shengfeng Pan and Bo Wen and Yunfeng Liu } ,

year = { 2021 } ,

eprint = { 2104.09864 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

} @inproceedings { Sun2022ALT ,

title = { A Length-Extrapolatable Transformer } ,

author = { Yutao Sun and Li Dong and Barun Patra and Shuming Ma and Shaohan Huang and Alon Benhaim and Vishrav Chaudhary and Xia Song and Furu Wei } ,

year = { 2022 }

} @inproceedings { Chen2023ExtendingCW ,

title = { Extending Context Window of Large Language Models via Positional Interpolation } ,

author = { Shouyuan Chen and Sherman Wong and Liangjian Chen and Yuandong Tian } ,

year = { 2023 }

} @misc { bloc97-2023

title = { NTK-Aware Scaled RoPE allows LLaMA models to have extended (8k+) context size without any fine-tuning and minimal perplexity degradation. } ,

author = { /u/bloc97 } ,

url = { https://www.reddit.com/r/LocalLLaMA/comments/14lz7j5/ntkaware_scaled_rope_allows_llama_models_to_have/ }

}