Реализация AudioLM, подхода к языковому моделированию генерации аудио, разработанного на основе исследований Google, в Pytorch.

Это также расширяет работу по кондиционированию благодаря бесплатному руководству по классификатору с помощью T5. Это позволяет выполнять преобразование текста в аудио или TTS, что не предлагается в статье. Да, это означает, что ВАЛЛ-И можно обучить из этого хранилища. По сути, это то же самое.

Пожалуйста, присоединяйтесь, если вы заинтересованы в воспроизведении этой работы в открытом доступе.

Этот репозиторий теперь также содержит лицензированную MIT версию SoundStream. Он также совместим с EnCodec, который на момент написания также имеет лицензию MIT.

Обновление: AudioLM по существу использовался для «решения» создания музыки в новом MusicLM.

В будущем этот видеоролик уже не будет иметь никакого смысла. Вместо этого вы бы просто подсказали ИИ.

Stability.ai за щедрую поддержку работы и передовые исследования в области искусственного интеллекта с открытым исходным кодом.

? Huggingface за потрясающие библиотеки ускорений и трансформеров.

MetaAI для Fairseq и либеральная лицензия

@eonglints и Джозефу за профессиональные советы и опыт, а также за запросы на включение!

@djqualia, @yigityu, @inspirit и @BlackFox1197 за помощь в отладке звукового потока.

Аллену и LWprogramming за проверку кода и исправление ошибок!

Илье за обнаружение проблемы с понижением дискретизации многомасштабного дискриминатора и за улучшения трейнера звукового потока.

Андрею за обнаружение недостающих потерь в звуковом потоке и помощь в выборе правильных гиперпараметров мел-спектрограммы.

Алехандро и Илье за то, что поделились своими результатами со звуковым потоком обучения, а также за работу над несколькими проблемами с позиционными встраиваниями локального внимания.

LWprogramming для добавления совместимости с кодеками!

LWprogramming для обнаружения проблем с обработкой токена EOS при выборке из FineTransformer !

@YoungloLee за обнаружение большой ошибки в 1d причинной свертке звукового потока, связанной с заполнением без учета шагов!

Хайдену за указание на некоторые неточности в многомасштабном дискриминаторе Soundstream.

$ pip install audiolm-pytorchСуществует два варианта нейронного кодека. Если вы хотите использовать предварительно обученный кодек 24 кГц, просто создайте объект Encodec следующим образом:

from audiolm_pytorch import EncodecWrapper

encodec = EncodecWrapper ()

# Now you can use the encodec variable in the same way you'd use the soundstream variables below. В противном случае, чтобы оставаться верным оригинальной статье, вы можете использовать SoundStream . Во-первых, SoundStream необходимо обучить на большом массиве аудиоданных.

from audiolm_pytorch import SoundStream , SoundStreamTrainer

soundstream = SoundStream (

codebook_size = 4096 ,

rq_num_quantizers = 8 ,

rq_groups = 2 , # this paper proposes using multi-headed residual vector quantization - https://arxiv.org/abs/2305.02765

use_lookup_free_quantizer = True , # whether to use residual lookup free quantization - there are now reports of successful usage of this unpublished technique

use_finite_scalar_quantizer = False , # whether to use residual finite scalar quantization

attn_window_size = 128 , # local attention receptive field at bottleneck

attn_depth = 2 # 2 local attention transformer blocks - the soundstream folks were not experts with attention, so i took the liberty to add some. encodec went with lstms, but attention should be better

)

trainer = SoundStreamTrainer (

soundstream ,

folder = '/path/to/audio/files' ,

batch_size = 4 ,

grad_accum_every = 8 , # effective batch size of 32

data_max_length_seconds = 2 , # train on 2 second audio

num_train_steps = 1_000_000

). cuda ()

trainer . train ()

# after a lot of training, you can test the autoencoding as so

soundstream . eval () # your soundstream must be in eval mode, to avoid having the residual dropout of the residual VQ necessary for training

audio = torch . randn ( 10080 ). cuda ()

recons = soundstream ( audio , return_recons_only = True ) # (1, 10080) - 1 channel Обученный SoundStream затем можно использовать в качестве универсального токенизатора для аудио.

audio = torch . randn ( 1 , 512 * 320 )

codes = soundstream . tokenize ( audio )

# you can now train anything with the codebook ids

recon_audio_from_codes = soundstream . decode_from_codebook_indices ( codes )

# sanity check

assert torch . allclose (

recon_audio_from_codes ,

soundstream ( audio , return_recons_only = True )

) Вы также можете использовать звуковые потоки, специфичные для AudioLM и MusicLM импортировав AudioLMSoundStream и MusicLMSoundStream соответственно.

from audiolm_pytorch import AudioLMSoundStream , MusicLMSoundStream

soundstream = AudioLMSoundStream (...) # say you want the hyperparameters as in Audio LM paper

# rest is the same as above Начиная с версии 0.17.0 , теперь вы можете вызывать метод класса SoundStream для загрузки из файлов контрольных точек без необходимости запоминать свои конфигурации.

from audiolm_pytorch import SoundStream

soundstream = SoundStream . init_and_load_from ( './path/to/checkpoint.pt' ) Чтобы использовать отслеживание весов и смещений, сначала установите use_wandb_tracking = True в SoundStreamTrainer , затем выполните следующие действия.

trainer = SoundStreamTrainer (

soundstream ,

...,

use_wandb_tracking = True

)

# wrap .train() with contextmanager, specifying project and run name

with trainer . wandb_tracker ( project = 'soundstream' , run = 'baseline' ):

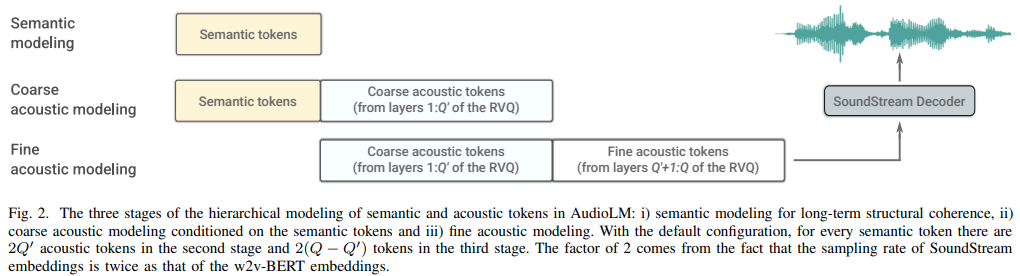

trainer . train () Затем необходимо обучить три отдельных преобразователя ( SemanticTransformer , CoarseTransformer , FineTransformer ).

бывший. SemanticTransformer

import torch

from audiolm_pytorch import HubertWithKmeans , SemanticTransformer , SemanticTransformerTrainer

# hubert checkpoints can be downloaded at

# https://github.com/facebookresearch/fairseq/tree/main/examples/hubert

wav2vec = HubertWithKmeans (

checkpoint_path = './hubert/hubert_base_ls960.pt' ,

kmeans_path = './hubert/hubert_base_ls960_L9_km500.bin'

)

semantic_transformer = SemanticTransformer (

num_semantic_tokens = wav2vec . codebook_size ,

dim = 1024 ,

depth = 6 ,

flash_attn = True

). cuda ()

trainer = SemanticTransformerTrainer (

transformer = semantic_transformer ,

wav2vec = wav2vec ,

folder = '/path/to/audio/files' ,

batch_size = 1 ,

data_max_length = 320 * 32 ,

num_train_steps = 1

)

trainer . train () бывший. CoarseTransformer

import torch

from audiolm_pytorch import HubertWithKmeans , SoundStream , CoarseTransformer , CoarseTransformerTrainer

wav2vec = HubertWithKmeans (

checkpoint_path = './hubert/hubert_base_ls960.pt' ,

kmeans_path = './hubert/hubert_base_ls960_L9_km500.bin'

)

soundstream = SoundStream . init_and_load_from ( '/path/to/trained/soundstream.pt' )

coarse_transformer = CoarseTransformer (

num_semantic_tokens = wav2vec . codebook_size ,

codebook_size = 1024 ,

num_coarse_quantizers = 3 ,

dim = 512 ,

depth = 6 ,

flash_attn = True

)

trainer = CoarseTransformerTrainer (

transformer = coarse_transformer ,

codec = soundstream ,

wav2vec = wav2vec ,

folder = '/path/to/audio/files' ,

batch_size = 1 ,

data_max_length = 320 * 32 ,

num_train_steps = 1_000_000

)

trainer . train () бывший. FineTransformer

import torch

from audiolm_pytorch import SoundStream , FineTransformer , FineTransformerTrainer

soundstream = SoundStream . init_and_load_from ( '/path/to/trained/soundstream.pt' )

fine_transformer = FineTransformer (

num_coarse_quantizers = 3 ,

num_fine_quantizers = 5 ,

codebook_size = 1024 ,

dim = 512 ,

depth = 6 ,

flash_attn = True

)

trainer = FineTransformerTrainer (

transformer = fine_transformer ,

codec = soundstream ,

folder = '/path/to/audio/files' ,

batch_size = 1 ,

data_max_length = 320 * 32 ,

num_train_steps = 1_000_000

)

trainer . train ()Все вместе сейчас

from audiolm_pytorch import AudioLM

audiolm = AudioLM (

wav2vec = wav2vec ,

codec = soundstream ,

semantic_transformer = semantic_transformer ,

coarse_transformer = coarse_transformer ,

fine_transformer = fine_transformer

)

generated_wav = audiolm ( batch_size = 1 )

# or with priming

generated_wav_with_prime = audiolm ( prime_wave = torch . randn ( 1 , 320 * 8 ))

# or with text condition, if given

generated_wav_with_text_condition = audiolm ( text = [ 'chirping of birds and the distant echos of bells' ])Обновление: похоже, это сработает, учитывая «ВАЛЛ-И».

бывший. Семантический преобразователь

import torch

from audiolm_pytorch import HubertWithKmeans , SemanticTransformer , SemanticTransformerTrainer

wav2vec = HubertWithKmeans (

checkpoint_path = './hubert/hubert_base_ls960.pt' ,

kmeans_path = './hubert/hubert_base_ls960_L9_km500.bin'

)

semantic_transformer = SemanticTransformer (

num_semantic_tokens = 500 ,

dim = 1024 ,

depth = 6 ,

has_condition = True , # this will have to be set to True

cond_as_self_attn_prefix = True # whether to condition as prefix to self attention, instead of cross attention, as was done in 'VALL-E' paper

). cuda ()

# mock text audio dataset (as an example)

# you will have to extend your own from `Dataset`, and return an audio tensor as well as a string (the audio description) in any order (the framework will autodetect and route it into the transformer)

from torch . utils . data import Dataset

class MockTextAudioDataset ( Dataset ):

def __init__ ( self , length = 100 , audio_length = 320 * 32 ):

super (). __init__ ()

self . audio_length = audio_length

self . len = length

def __len__ ( self ):

return self . len

def __getitem__ ( self , idx ):

mock_audio = torch . randn ( self . audio_length )

mock_caption = 'audio caption'

return mock_caption , mock_audio

dataset = MockTextAudioDataset ()

# instantiate semantic transformer trainer and train

trainer = SemanticTransformerTrainer (

transformer = semantic_transformer ,

wav2vec = wav2vec ,

dataset = dataset ,

batch_size = 4 ,

grad_accum_every = 8 ,

data_max_length = 320 * 32 ,

num_train_steps = 1_000_000

)

trainer . train ()

# after much training above

sample = trainer . generate ( text = [ 'sound of rain drops on the rooftops' ], batch_size = 1 , max_length = 2 ) # (1, < 128) - may terminate early if it detects [eos] Потому что все классы тренеров используют? Ускоритель, вы можете легко выполнить обучение с использованием нескольких графических процессоров, используя команду accelerate .

В корне проекта

$ accelerate configЗатем в том же каталоге

$ accelerate launch train . py полный грубый трансформатор

используйте fairseq vq-wav2vec для встраивания

добавить кондиционирование

добавить бесплатное руководство по классификатору

добавить уникальную последовательность для

включить возможность использования промежуточных функций Hubert в качестве семантических токенов, рекомендованных eonglints

разместить аудио переменной длины, ввести токен eos

убедитесь, что с трансформатором грубой очистки работает уникальная последовательная работа.

довольно печатать все потери дискриминатора в журнале

обрабатывать при создании семантических токенов, что последние логиты не обязательно могут быть последними в последовательности, учитывая уникальную последовательную обработку

полный код выборки для грубых и точных трансформаторов, что будет сложно

убедитесь, что полный вывод с подсказками или без них работает в классе AudioLM

завершить полный код обучения для звукового потока, позаботившись об обучении дискриминатора

добавить эффективный градиентный штраф для дискриминаторов звукового потока

подключите образец Гц из набора звуковых данных -> преобразователи и выполните правильную повторную выборку во время обучения - подумайте, следует ли разрешить набору данных иметь звуковые файлы с разной частотой или использовать один и тот же образец Гц.

полный код обучения трансформаторов для всех трех трансформаторов

рефакторинг, поэтому семантический преобразователь имеет оболочку, которая обрабатывает уникальные последовательные строки, а также преобразование wav в Hubert или vq-wav2vec

просто не обращайте внимания на токен eos на стороне подсказки (семантика для грубого преобразователя, грубая для точного преобразователя)

добавить структурированное исключение из забывчивой причинной маскировки, что намного лучше, чем традиционные исключения

выясните, как подавить вход в систему fairseq

утверждать, что все три преобразователя, переданные в audiolm, совместимы

позволяют осуществлять специализированные относительные позиционные вложения в точный преобразователь на основе абсолютного совпадения положений квантователей между грубым и точным

разрешить сгруппированный остаточный vq в звуковом потоке (используйте GroupedResidualVQ из библиотеки векторного квантования-pytorch), из hifi-кодека

добавьте мгновенное внимание с помощью NoPE

принять Prime Wave в AudioLM как путь к аудиофайлу и автоматически выполнить повторную выборку для семантического и акустического

добавить кэширование ключей/значений для всех преобразователей, ускорив вывод

спроектировать иерархический преобразователь грубой и точной обработки

изучите декодирование спецификации, сначала протестируйте в x-трансформаторах, затем перенесите, если применимо

переделать позиционные вложения при наличии групп в остатке vq

тест с синтезатором речи для начала

cli, что-то вроде audiolm generate <wav.file | text> и сохраните сгенерированный WAV-файл в локальном каталоге.

вернуть список волн в случае звука переменной длины

просто позаботьтесь о краевом случае при обучении с грубым трансформаторным текстом, где необработанная волна повторно дискретизируется на разных частотах. автоматически определять способ маршрутизации в зависимости от длины

@inproceedings { Borsos2022AudioLMAL ,

title = { AudioLM: a Language Modeling Approach to Audio Generation } ,

author = { Zal{'a}n Borsos and Rapha{"e}l Marinier and Damien Vincent and Eugene Kharitonov and Olivier Pietquin and Matthew Sharifi and Olivier Teboul and David Grangier and Marco Tagliasacchi and Neil Zeghidour } ,

year = { 2022 }

} @misc { https://doi.org/10.48550/arxiv.2107.03312 ,

title = { SoundStream: An End-to-End Neural Audio Codec } ,

author = { Zeghidour, Neil and Luebs, Alejandro and Omran, Ahmed and Skoglund, Jan and Tagliasacchi, Marco } ,

publisher = { arXiv } ,

url = { https://arxiv.org/abs/2107.03312 } ,

year = { 2021 }

} @misc { shazeer2020glu ,

title = { GLU Variants Improve Transformer } ,

author = { Noam Shazeer } ,

year = { 2020 } ,

url = { https://arxiv.org/abs/2002.05202 }

} @article { Shazeer2019FastTD ,

title = { Fast Transformer Decoding: One Write-Head is All You Need } ,

author = { Noam M. Shazeer } ,

journal = { ArXiv } ,

year = { 2019 } ,

volume = { abs/1911.02150 }

} @article { Ho2022ClassifierFreeDG ,

title = { Classifier-Free Diffusion Guidance } ,

author = { Jonathan Ho } ,

journal = { ArXiv } ,

year = { 2022 } ,

volume = { abs/2207.12598 }

} @misc { crowson2022 ,

author = { Katherine Crowson } ,

url = { https://twitter.com/rivershavewings }

} @misc { ding2021cogview ,

title = { CogView: Mastering Text-to-Image Generation via Transformers } ,

author = { Ming Ding and Zhuoyi Yang and Wenyi Hong and Wendi Zheng and Chang Zhou and Da Yin and Junyang Lin and Xu Zou and Zhou Shao and Hongxia Yang and Jie Tang } ,

year = { 2021 } ,

eprint = { 2105.13290 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @article { Liu2022FCMFC ,

title = { FCM: Forgetful Causal Masking Makes Causal Language Models Better Zero-Shot Learners } ,

author = { Hao Liu and Xinyang Geng and Lisa Lee and Igor Mordatch and Sergey Levine and Sharan Narang and P. Abbeel } ,

journal = { ArXiv } ,

year = { 2022 } ,

volume = { abs/2210.13432 }

} @inproceedings { anonymous2022normformer ,

title = { NormFormer: Improved Transformer Pretraining with Extra Normalization } ,

author = { Anonymous } ,

booktitle = { Submitted to The Tenth International Conference on Learning Representations } ,

year = { 2022 } ,

url = { https://openreview.net/forum?id=GMYWzWztDx5 } ,

note = { under review }

} @misc { liu2021swin ,

title = { Swin Transformer V2: Scaling Up Capacity and Resolution } ,

author = { Ze Liu and Han Hu and Yutong Lin and Zhuliang Yao and Zhenda Xie and Yixuan Wei and Jia Ning and Yue Cao and Zheng Zhang and Li Dong and Furu Wei and Baining Guo } ,

year = { 2021 } ,

eprint = { 2111.09883 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @article { Li2021LocalViTBL ,

title = { LocalViT: Bringing Locality to Vision Transformers } ,

author = { Yawei Li and K. Zhang and Jie Cao and Radu Timofte and Luc Van Gool } ,

journal = { ArXiv } ,

year = { 2021 } ,

volume = { abs/2104.05707 }

} @article { Defossez2022HighFN ,

title = { High Fidelity Neural Audio Compression } ,

author = { Alexandre D'efossez and Jade Copet and Gabriel Synnaeve and Yossi Adi } ,

journal = { ArXiv } ,

year = { 2022 } ,

volume = { abs/2210.13438 }

} @article { Hu2017SqueezeandExcitationN ,

title = { Squeeze-and-Excitation Networks } ,

author = { Jie Hu and Li Shen and Gang Sun } ,

journal = { 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition } ,

year = { 2017 } ,

pages = { 7132-7141 }

} @inproceedings { Yang2023HiFiCodecGV ,

title = { HiFi-Codec: Group-residual Vector quantization for High Fidelity Audio Codec } ,

author = { Dongchao Yang and Songxiang Liu and Rongjie Huang and Jinchuan Tian and Chao Weng and Yuexian Zou } ,

year = { 2023 }

} @article { Kazemnejad2023TheIO ,

title = { The Impact of Positional Encoding on Length Generalization in Transformers } ,

author = { Amirhossein Kazemnejad and Inkit Padhi and Karthikeyan Natesan Ramamurthy and Payel Das and Siva Reddy } ,

journal = { ArXiv } ,

year = { 2023 } ,

volume = { abs/2305.19466 }

} @inproceedings { dao2022flashattention ,

title = { Flash{A}ttention: Fast and Memory-Efficient Exact Attention with {IO}-Awareness } ,

author = { Dao, Tri and Fu, Daniel Y. and Ermon, Stefano and Rudra, Atri and R{'e}, Christopher } ,

booktitle = { Advances in Neural Information Processing Systems } ,

year = { 2022 }

} @misc { yu2023language ,

title = { Language Model Beats Diffusion -- Tokenizer is Key to Visual Generation } ,

author = { Lijun Yu and José Lezama and Nitesh B. Gundavarapu and Luca Versari and Kihyuk Sohn and David Minnen and Yong Cheng and Agrim Gupta and Xiuye Gu and Alexander G. Hauptmann and Boqing Gong and Ming-Hsuan Yang and Irfan Essa and David A. Ross and Lu Jiang } ,

year = { 2023 } ,

eprint = { 2310.05737 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

} @inproceedings { Katsch2023GateLoopFD ,

title = { GateLoop: Fully Data-Controlled Linear Recurrence for Sequence Modeling } ,

author = { Tobias Katsch } ,

year = { 2023 } ,

url = { https://api.semanticscholar.org/CorpusID:265018962 }

} @article { Fifty2024Restructuring ,

title = { Restructuring Vector Quantization with the Rotation Trick } ,

author = { Christopher Fifty, Ronald G. Junkins, Dennis Duan, Aniketh Iyengar, Jerry W. Liu, Ehsan Amid, Sebastian Thrun, Christopher Ré } ,

journal = { ArXiv } ,

year = { 2024 } ,

volume = { abs/2410.06424 } ,

url = { https://api.semanticscholar.org/CorpusID:273229218 }

} @inproceedings { Zhou2024ValueRL ,

title = { Value Residual Learning For Alleviating Attention Concentration In Transformers } ,

author = { Zhanchao Zhou and Tianyi Wu and Zhiyun Jiang and Zhenzhong Lan } ,

year = { 2024 } ,

url = { https://api.semanticscholar.org/CorpusID:273532030 }

}