Важный

2024.10.10: хирургическое вмешательство, экстренное восстановление файлового сервера, обеспечивающего пакет WHL

2024.10.8: Версия 3..90 Добавить предварительную поддержку для Llama-Idex, версия 3.80 добавляет функцию вторичного меню подключаемого модуля (подробности см. В Wiki) см. См. См. В вики см. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. См. В вики см. В вики.

2024.5.1: Добавьте функцию перевода DOC2X PLAP PLAP, подробности просмотра

2024.3.11: Полностью поддерживать китайские модели на крупных языках, такие как Qwen, GLM, DeepSeekCoder! Sovits Voice Cloning Module, просмотр подробностей 2024.1.17: При установке зависимостей выберите версию, указанную в requirements.txt . Команда установки: pip install -r requirements.txt . Этот проект полностью открыт и бесплатный.

Если вам нравится этот проект, пожалуйста, дайте ему звезду;

Если multi_language.py нравится этот проект, пожалуйста, дайте ему звезду.

Примечание

1. Функцией каждого файла в этом проекте является отчет о самостоятельном переходе self_analysis.md . Благодаря итерации версии вы также можете нажать на соответствующую функциональную подключение -в любое время, чтобы вызвать отчет GPT Re -Generating Self -Parsing. По общим вопросам, пожалуйста, проверьте Wiki.

2. Этот проект совместим с и поощряет испытания моделей крупных китайских языков, таких как Tongyi Qianqian, Spectrum мудрости GLM и т. Д. Поддержите многочисленное сосуществование Api-Key, вы можете заполнить в файле конфигурации, такой как API_KEY="openai-key1,openai-key2,azure-key3,api2d-key4" . Когда вам нужно временно заменить API_KEY , введите временный API_KEY в области ввода, а затем отправьте его в ключ Ride, чтобы вступить в силу.

| Функция (= последние новые функции) | описывать |

|---|---|

| Новая модель | Baidu Qianfan и Wenxin сказали: Tongyi Qian Qi Qwen, ученый-шанхай AI-Lab, Сюн-Файкс, Ллама2, Скорость мудрости GLM4, Dalle3, DeepSeekCoder |

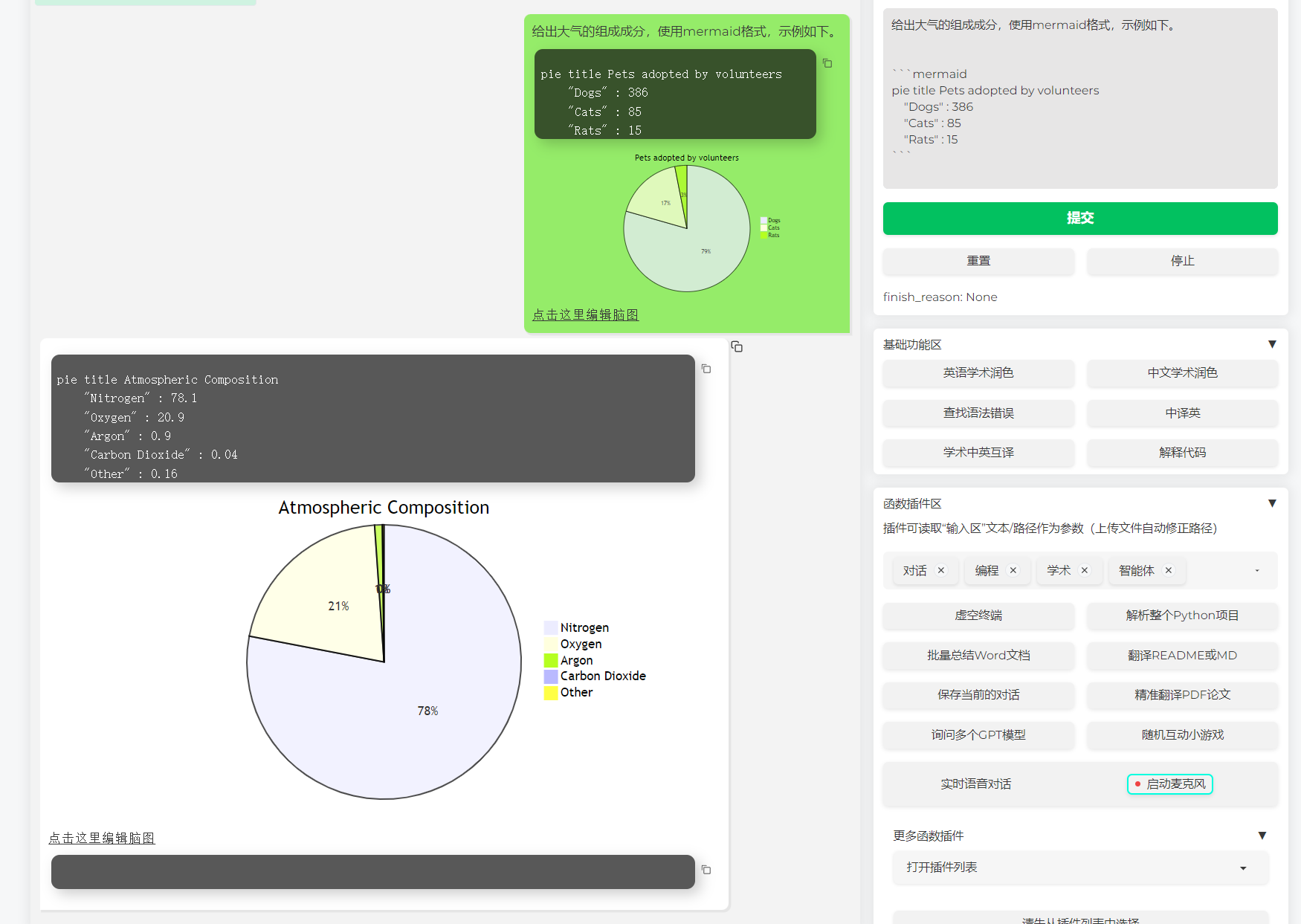

| Поддержать рендеринг изображения русалки | Поддержка, позволяющая GPT генерировать блок -схемы, диаграммы передачи состояния, карты GAND, торты, GitGraph и т. Д. (Версия 3.7) |

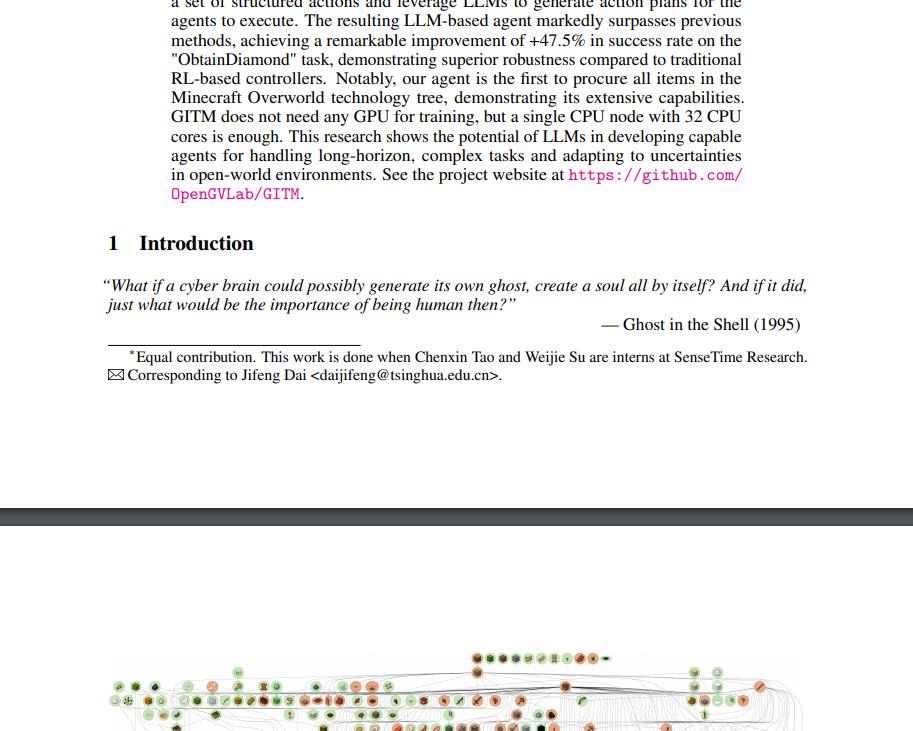

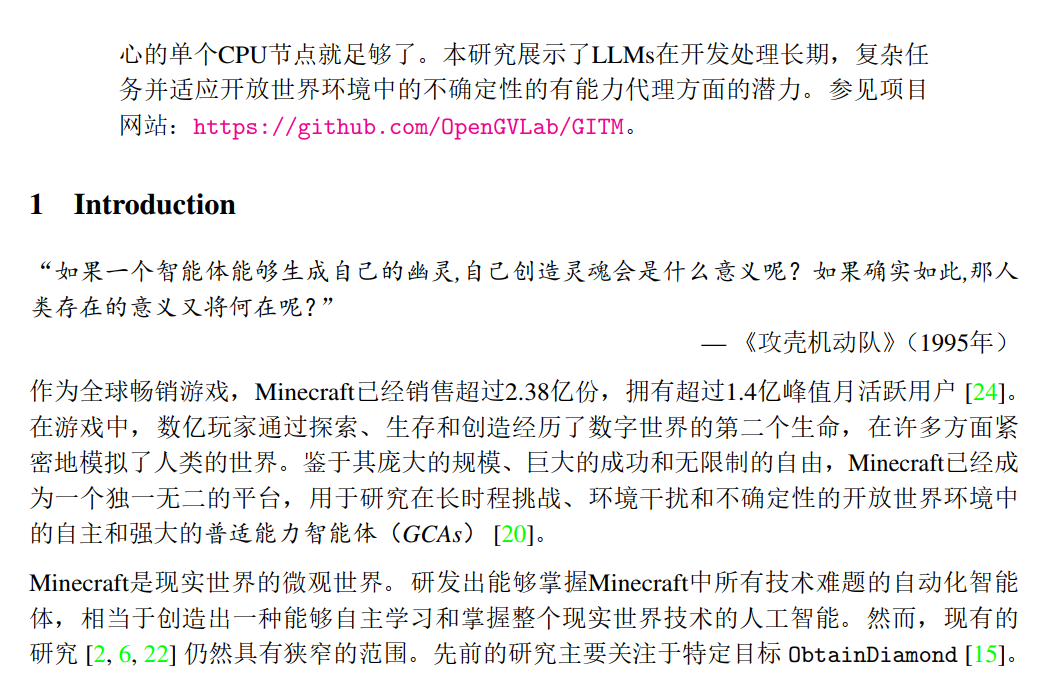

| Арксивский тезис прекрасный перевод (Docker) | [Plug -In] один -кликно перевод тезиса Arxiv с одним -клик, лучший инструмент перевода бумаги в настоящее время |

| Ввод диалога с реальным голосом | [Плагин -ин] асинхронное аудио прослушивания, автоматическое отключение предложений, автоматически находит время для ответа |

| Autogen Multi -Smart Plugin | [Подключение -ин] С помощью Microsoft Autogen исследуйте возможность интеллектуального появления дуэта! |

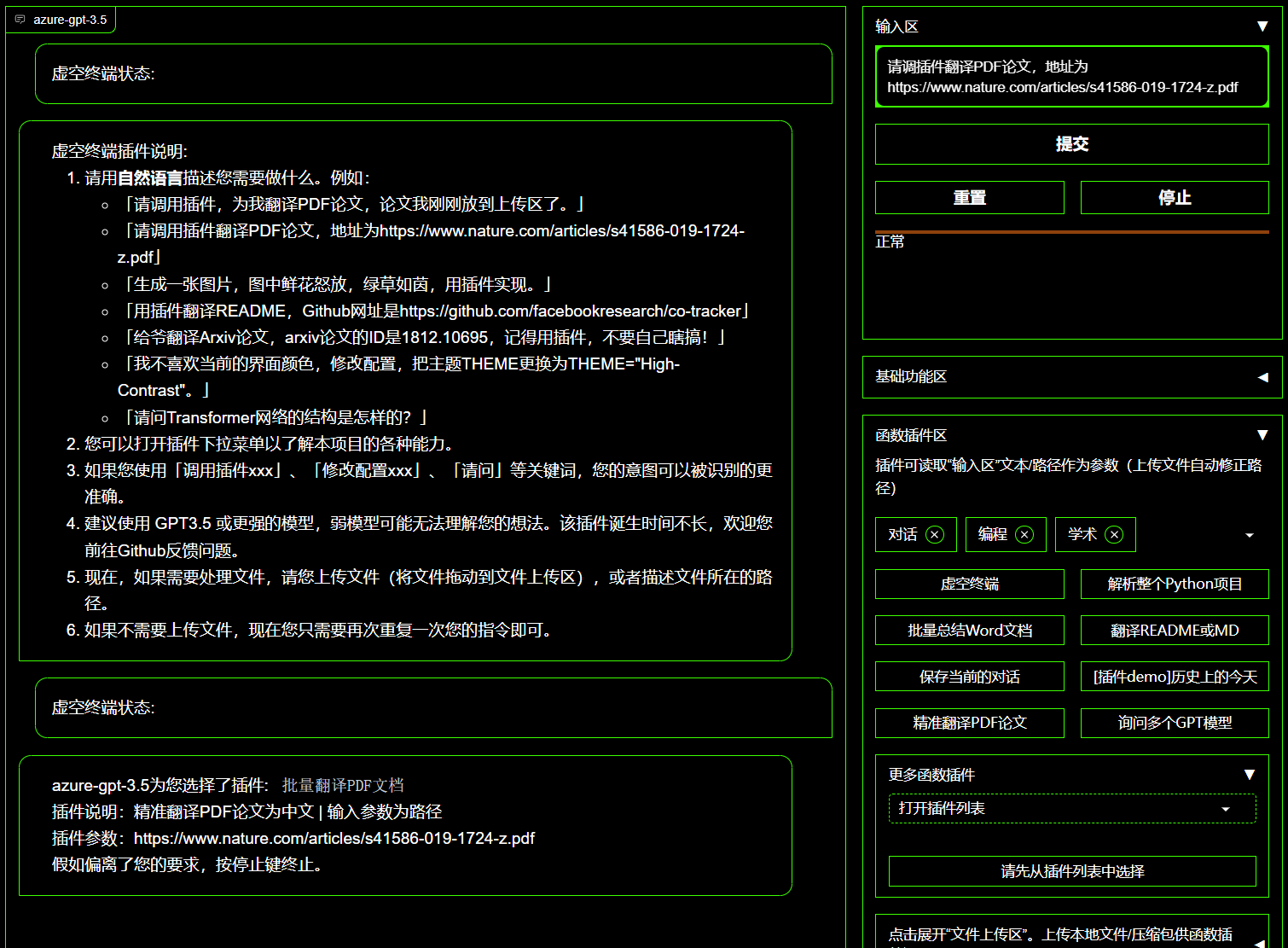

| Плагин пустого терминала | [Plug -In] может напрямую запланировать другие завижки в этом проекте на естественном языке |

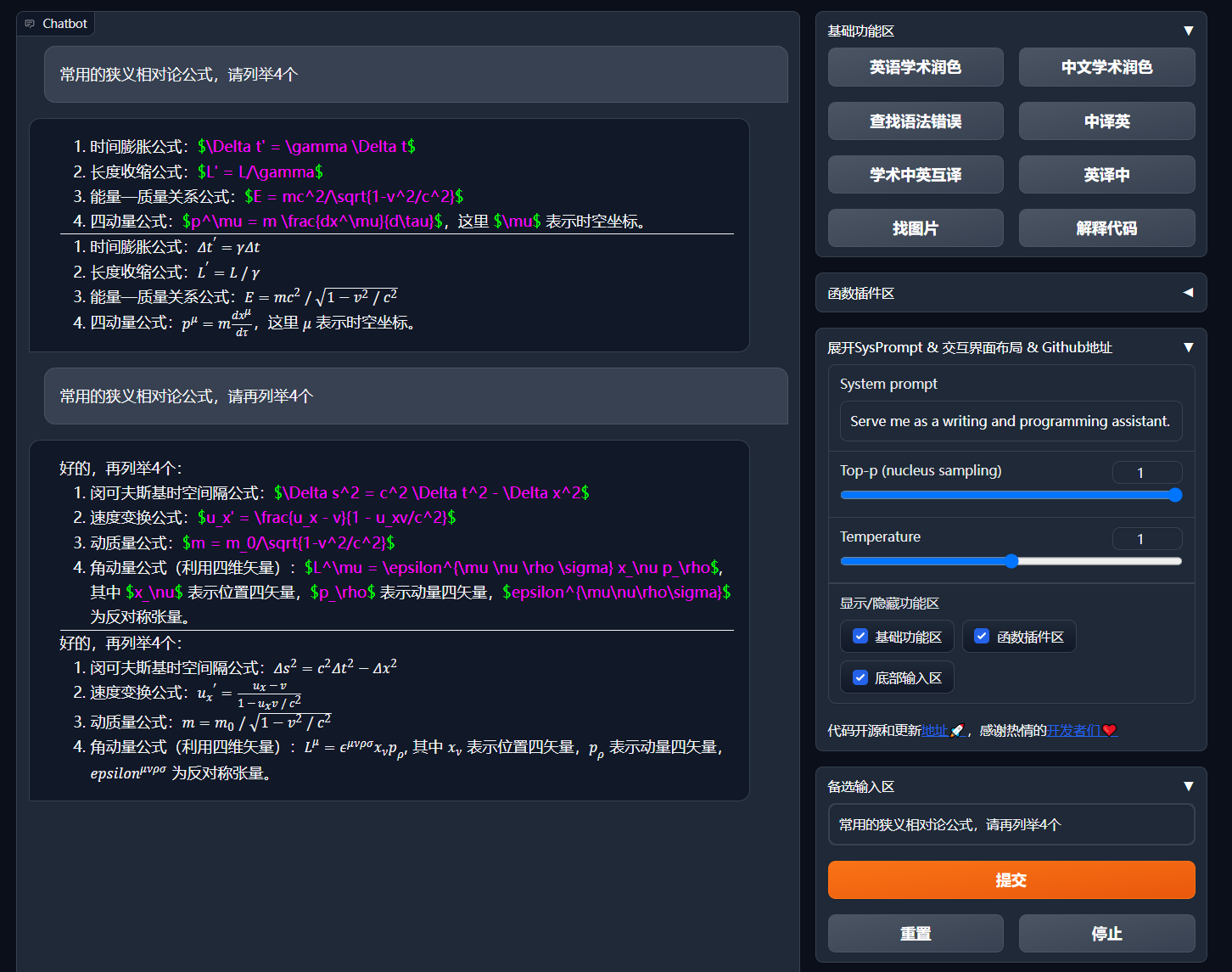

| Интерпретация цвета, перевода, объяснение кода | Один -клик увлажняющий, перевод, поиск документов грамматические ошибки, код интерпретации |

| Пользовательский ярлык | Поддержать пользовательские ярлыки |

| Модульный дизайн | Поддержка Custom Strong Plug -in, Plug -IN поддерживает горячие обновления |

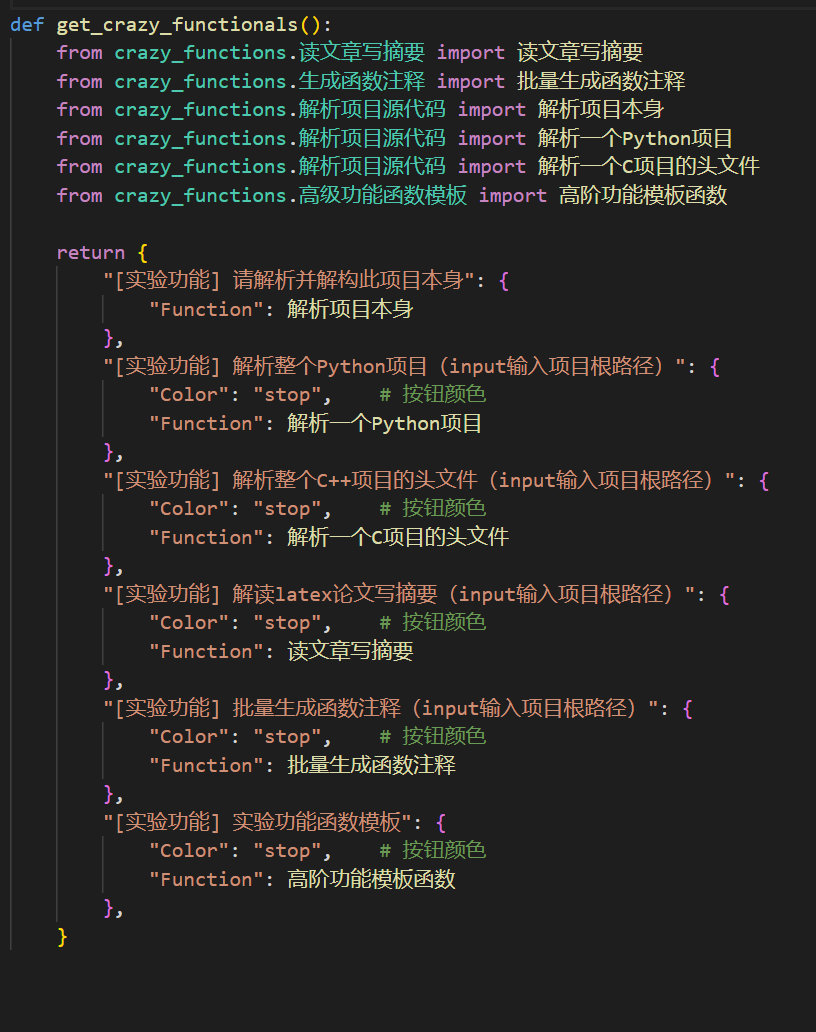

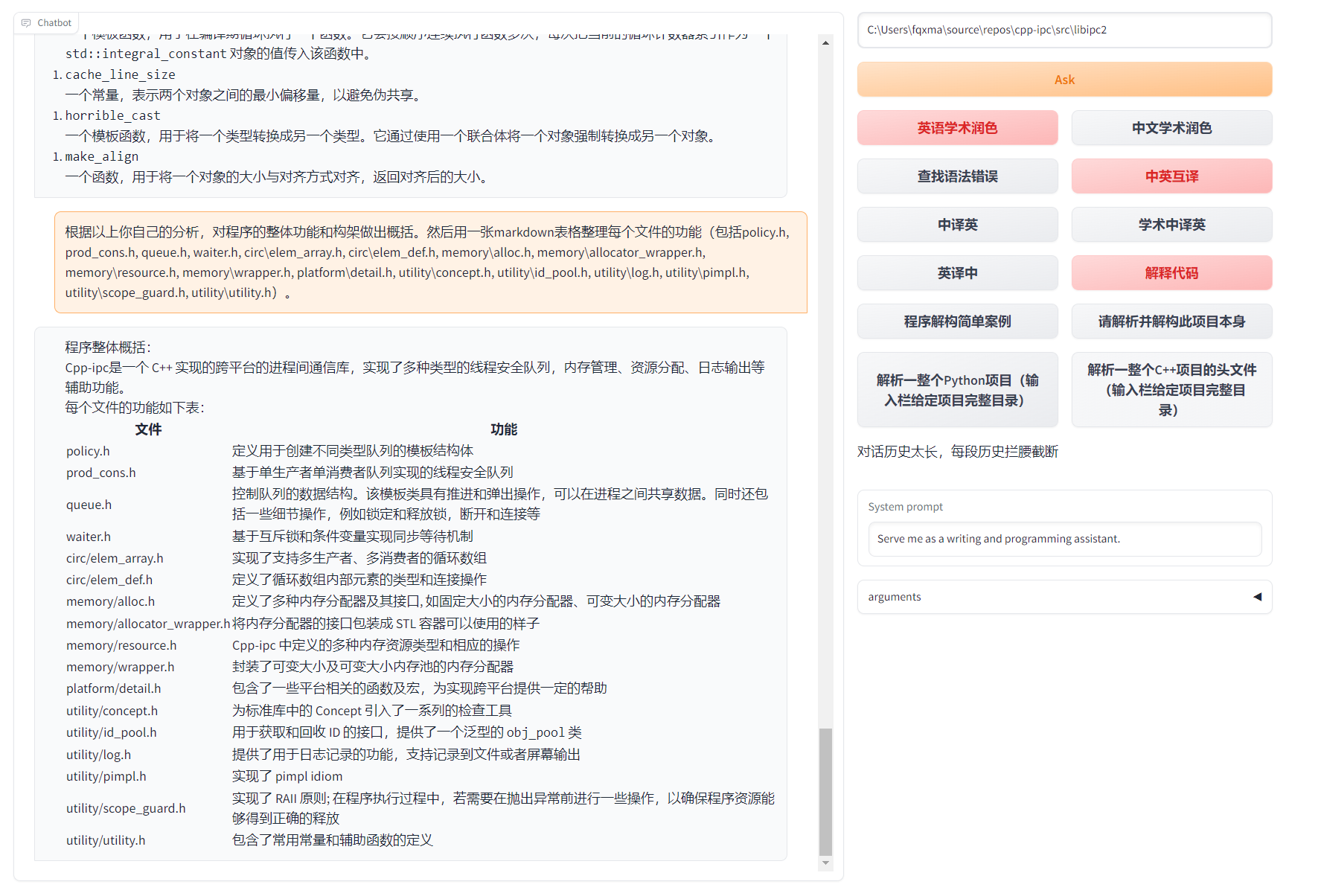

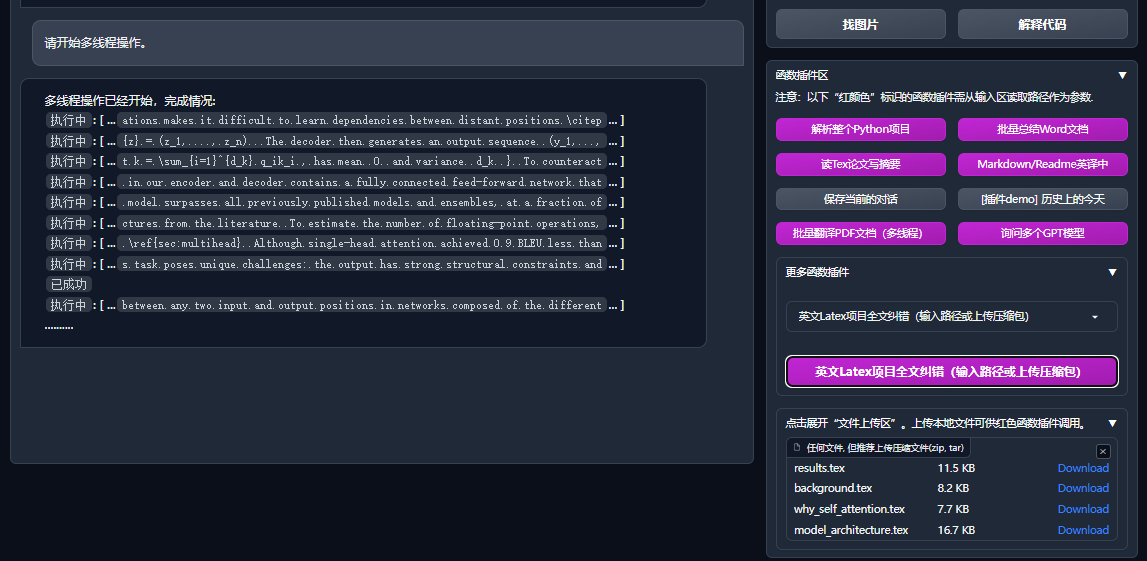

| Программный анализ | [Plug -In] Один -клинический анализ Python/C/C ++/Java/Lua/... Дерево проекта или самостоятельный анализ |

| Прочитайте газету, переведйте тезис | [Plug -In] одна -клика интерпретации латекса/PDF Paper Полный текст и генерация рефератов |

| Латекс полный перевод, увлажняющий | [Plug -In] один -клиник перевода или увлажняющая латексная бумага |

| Партийная аннотация | [Plug -In] один -клик -партия генерировать функциональную аннотацию |

| Маркдаун китайский и британский взаимные переводы | [Plug -In] Вы видите язык чтения 5? Это от почерка |

| PDF бумага Полная функция перевода текста | [Plug -in] PDF Paper Extract Вопросы и резюме+перевод Полный текст (много -thread) |

| Arxiv Assistant | [Plug -in] Введите URL -адрес статьи ARXIV в одно -клик |

| Латексные документы с одной школьной парой | [Плагин -IN] Имитация грамматической массы к синтаксису, коррекции заклинаний+Управление выводом PDF на латексных статьях |

| Google Academic Integration Assistant | [插件] 给定任意谷歌学术搜索页面URL,让gpt帮你写relatedworks |

| Агрегация информации в Интернете+GPT | [插件] 一键让GPT从互联网获取信息回答问题,让信息永不过时 |

| 公式/图片/表格显示 | Вы можете одновременно отобразить формулу и формулу формулы и поддержать формулу и выделение кода |

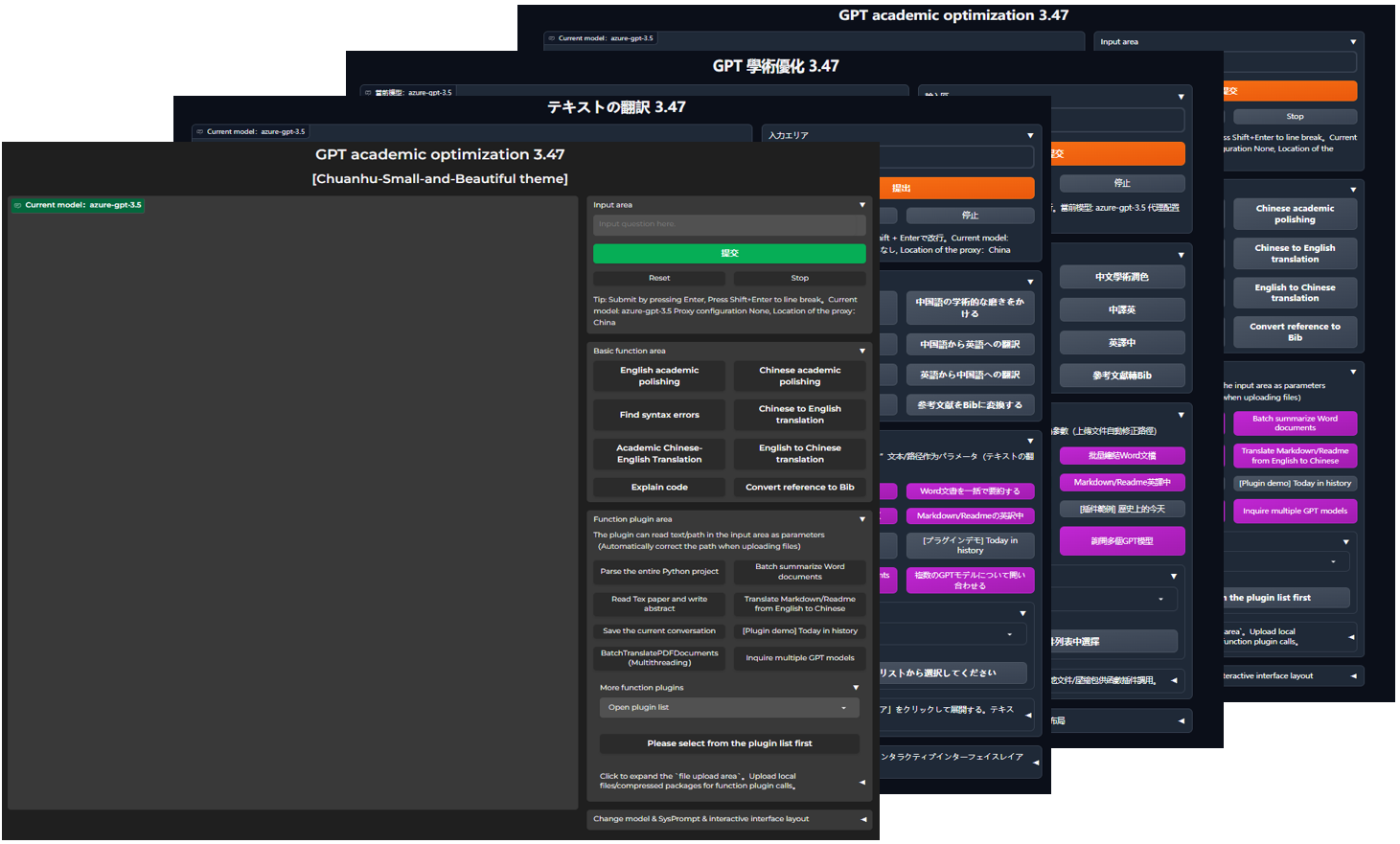

| Начните темную тему | Добавить /?__theme=dark |

| Поддержка модели Multi LLM | В то же время, чувство, как его обслуживают GPT3.5, GPT4, Tsinghua Chatglm2, Fudan Moss, должно быть, очень хорошим? |

| Больше доступа к модели LLM, поддержка развертывания Huggingface | Присоединяйтесь к интерфейсу Newbing (New Old), представьте Tsinghua Jittorllms для поддержки Llama и Pangu α |

| пустотный пакет PIP | Оставив графический интерфейс, напрямую вызовите все функциональные заглушки в элементе в Python (в процессе разработки) |

| Больше нового отображения функций (генерация изображений и т. Д.) ... | Смотрите конец этой статьи ... |

config.py для достижения «левый -правый макет» и «верхний и нижний макет»)

Блок -схема TD

{"Метод установки"} -> w1 ("i.? Запустить напрямую (Windows, Linux или Macos)"))))))))))

W1-> W11 ["1. Зависимость управления пакетами Pyphon PIP"]

W1-> W12 ["2. Anaconda Управление пакетами зависимости (рекомендация)"]]]]

A -> w2 ["ii .?

W2-> K1 ["1. Большое зеркальное изображение развертывает все возможности (рекомендация)"]]]]]

W2-> K2 ["2. только онлайн-модель (GPT, GLM4 и т. Д.) Зеркало"]

W2-> K3 ["3. Online Model+ Latex's Bargy Mirror"]

A -> w4 ["iv. Другие методы развертывания"]]]

W4-> C1 ["1. Windows/Macos One -Lick Installation и запуск Script (Рекомендация)"]

W4-> C2 ["2. Huggingface, удаленное развертывание Sealos"]]]

W4-> C4 ["3. ... другие ..."]]

Скачать проект

git clone --depth=1 https://github.com/binary-husky/gpt_academic.git

cd gpt_academicНастроить API_KEY и другие переменные

В config.py настраивайте переменные, такие как клавиша API. Специальный метод настройки сетевой среды, описание конфигурации Wiki-Project.

«Программа даст приоритет для проверки, существует ли отдельный файл конфигурации с именем config_private.py , и настраивать то же имя с конфигурацией config.py . Если вы можете понять вышеуказанную логику чтения, мы настоятельно рекомендуем вам создать под config_private.py config_private.py путь config.py Path.

«Поддержите элемент конфигурации环境变量, см. Файл docker-compose.yml или нашу страницу Wiki формата записи переменной среды. Приоритет чтения конфигурации:环境变量> config_private.py > config.py ».

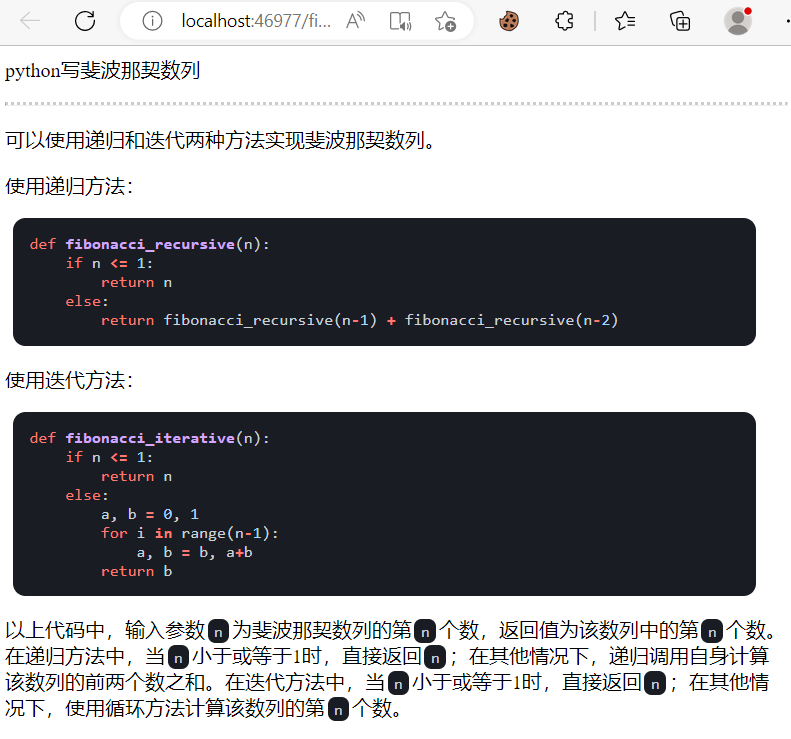

Зависимость установки

# (选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11)备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

python -m pip install -r requirements.txt

# (选择II: 使用Anaconda)步骤也是类似的 (https://www.bilibili.com/video/BV1rc411W7Dr):

conda create -n gptac_venv python=3.11 # 创建anaconda环境

conda activate gptac_venv # 激活anaconda环境

python -m pip install -r requirements.txt # 这个步骤和pip安装一样的步骤[Необязательные шаги] Если вам нужно поддерживать Tsinghua Chatglm3/Fudan Moss в качестве заднего конца, вам необходимо установить больше зависимостей (условие: знакомо с Python + Pytorch + Componturation):

# 【可选步骤I】支持清华ChatGLM3。清华ChatGLM备注:如果遇到"Call ChatGLM fail 不能正常加载ChatGLM的参数" 错误,参考如下: 1:以上默认安装的为torch+cpu版,使用cuda需要卸载torch重新安装torch+cuda; 2:如因本机配置不够无法加载模型,可以修改request_llm/bridge_chatglm.py中的模型精度, 将 AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) 都修改为 AutoTokenizer.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True)

python -m pip install -r request_llms/requirements_chatglm.txt

# 【可选步骤II】支持复旦MOSS

python -m pip install -r request_llms/requirements_moss.txt

git clone --depth=1 https://github.com/OpenLMLab/MOSS.git request_llms/moss # 注意执行此行代码时,必须处于项目根路径

# 【可选步骤III】支持RWKV Runner

参考wiki:https://github.com/binary-husky/gpt_academic/wiki/%E9%80%82%E9%85%8DRWKV-Runner

# 【可选步骤IV】确保config.py配置文件的AVAIL_LLM_MODELS包含了期望的模型,目前支持的全部模型如下(jittorllms系列目前仅支持docker方案):

AVAIL_LLM_MODELS = [ " gpt-3.5-turbo " , " api2d-gpt-3.5-turbo " , " gpt-4 " , " api2d-gpt-4 " , " chatglm " , " moss " ] # + ["jittorllms_rwkv", "jittorllms_pangualpha", "jittorllms_llama"]

# 【可选步骤V】支持本地模型INT8,INT4量化(这里所指的模型本身不是量化版本,目前deepseek-coder支持,后面测试后会加入更多模型量化选择)

pip install bitsandbyte

# windows用户安装bitsandbytes需要使用下面bitsandbytes-windows-webui

python -m pip install bitsandbytes --prefer-binary --extra-index-url=https://jllllll.github.io/bitsandbytes-windows-webui

pip install -U git+https://github.com/huggingface/transformers.git

pip install -U git+https://github.com/huggingface/accelerate.git

pip install peftpython main.py Все возможности развертывания проектов (это большое зеркало, содержащее CUDA и LaTex. Но если у вас медленная скорость сети и небольшой жесткий диск, этот метод не рекомендуется развернуть полный элемент)

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行:

docker-compose up仅ChatGPT + GLM4 + 文心一言+spark等在线模型(推荐大多数人选择)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行:

docker-compose upЕсли PS должен полагаться на функцию Latex -in function, см. Вики. Кроме того, вы также можете напрямую использовать схему 4 или схемы 0 для получения функции латекса.

CHATGPT + GLM3 + MOSS + LLAMA2 + Tongyi Qianwen (нужно быть знакомым с Nvidia Docker во время работы)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行:

docker-compose upWindows One -Click Script во время выполнения . Пользователи Windows, которые совершенно не знакомы с средой Python, могут загрузить один -клик -запущенный сценарий, опубликованный в релизе, для установки версии без локальных моделей. Источник вклада сценария: Oobabooga.

Используйте третью партийную API, Azure и т. Д., Вэнь Синьи, Звездный огонь и т. Д., См.

Облачные серверы удаленно развернули руководящие принципы для избегания ямы. Пожалуйста, посетите вики удаленного развертывания Cloud Server

Развертывание на других платформах и вторичном развертывании URL

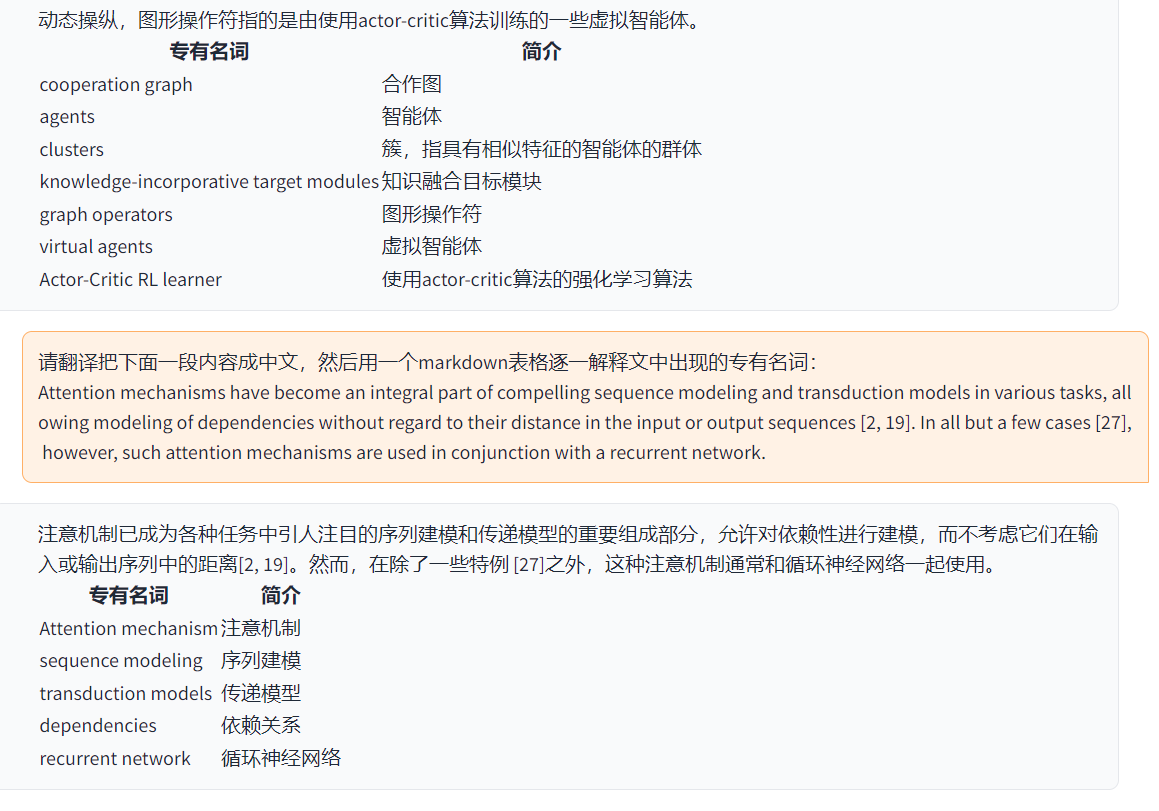

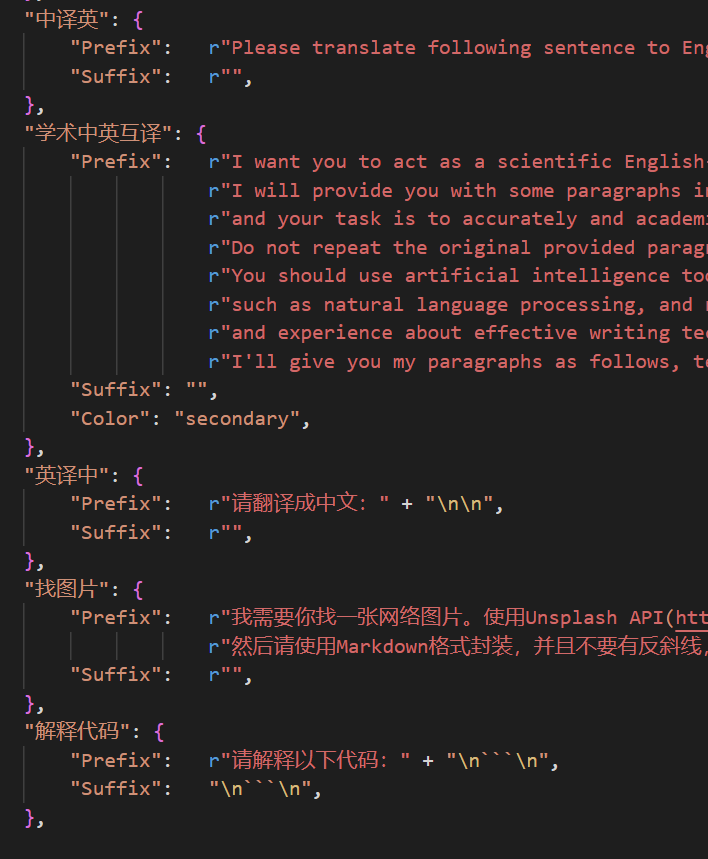

http://localhost/subpath ). Пожалуйста, посетите инструкции по эксплуатации Fastapi Теперь вы можете добавить новую удобную кнопку в自定义菜单в меню界面外观в пользовательском интерфейсе. Если вам нужно определить его в коде, используйте любой текстовый редактор, чтобы открыть core_functional.py , добавьте следующие записи:

"超级英译中" : {

# 前缀,会被加在你的输入之前。例如,用来描述你的要求,例如翻译、解释代码、润色等等

"Prefix" : "请翻译把下面一段内容成中文,然后用一个markdown表格逐一解释文中出现的专有名词: n n " ,

# 后缀,会被加在你的输入之后。例如,配合前缀可以把你的输入内容用引号圈起来。

"Suffix" : "" ,

},

Напишите мощную функциональную подключение -в выполнении любых задач, которые вы хотите и неожиданно. Плавка -в и отладке этого проекта очень низкая. Для получения подробной информации, пожалуйста, обратитесь к руководству -в управлении функции.

保存当前的对话в области функции -в области载入对话历史存档чтобы сохранить текущий диалог, как читаемый+восстанавливаемые HTML -файлы.载入对话历史存档для восстановления предыдущей сессии. Совет: если вы не укажите файл, нажмите载入对话历史存档чтобы просмотреть исторический кэш архива HTML.

===>

===>

config.py )

===>

===>

GPT Academic Developer QQ Group: 610599535

requirement.txt для установки Gradio Временная шкала LR

Название GPT-академического процесса разработки проекта Раздел 2.x

1.0 ~ 2.2: Основная функция: Введите модульную функциональную подключение -IN: складной макет: Функциональная подключение -IN поддерживает термическую нагрузку 2.3 ~ 2.5: Улучшение многоотражаемого взаимодействия: Новый PDF Полный текст 2.6: Реконструирование структуры заглушки -в: Улучшение взаимодействия: Добавьте больше заглушки -ин -в разделе 3.x

3.0 ~ 3.1: Поддержка ChatGLM: Поддержка других небольших LLM: поддержка нескольких моделей GPT одновременно: Поддержите множество Apikey Bload Balancing 3.2 ~ 3.3: Функциональная подключение -IN поддерживает больше параметров интерфейса: Сохранить функцию диалога: Интерпретировать код языка: В то же время, спросите любую комбинацию LLM: Информация Интернета Комплексная функция 3.4: Присоединяйтесь к переводу ARXIV Тезиса: Добавить функцию коррекции тезисов LaTex 3.44: Официально поддерживает Azure: оптимизированный интерфейс. Легкое использование 3.46: Пользовательская модель фильтра ChatGLM2: Реальное голосовое диалог 3.49: Поддержите Alida Mo Yuan Tongyi Qian Qian: Shanghai AI-Lab Scholar: Xun Fei Xinghuo: Поддержка платформы Baidu Qianfan и Wenxin a Word 3.50: void terminal: Поддержка плагина Классификация: Улучшение пользовательского интерфейса: разработка новая тема 3.53: Динамический выбор : Улучшение стабильность: решить проблему многооподобного конфликта 3.55: Динамический интерпретатор кода: реконструкция интерфейса фронта -энд: Введение подвесных окон и строки меню 3.56: Динамическая дополнительная кнопка «Основная базовая функция»: Новый отчет PDF Сводка. Стр. 3.57: GLM3,, Star Fire v3: Поддержка Wenxinyi Speaking v4: Исправьте одновременную ошибку локальной модели

3.60: Введение в автоген

3.70: Введите рисунок русалки: реализация функций, таких как рисунок мозга GPT 3.80 (TODO): оптимизированный плагин Autogen -IN Theme: Design Drovative Plug -in Вы можете изменить темы, изменяя THEME

Chuanhu-Small-and-Beautiful URLmaster分支: 主分支,稳定版frontier Branch: Development Branch, тестовая версия代码中参考了很多其他优秀项目中的设计,顺序不分先后:

# 清华ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

# 清华JittorLLMs:

https://github.com/Jittor/JittorLLMs

# ChatPaper:

https://github.com/kaixindelele/ChatPaper

# Edge-GPT:

https://github.com/acheong08/EdgeGPT

# ChuanhuChatGPT:

https://github.com/GaiZhenbiao/ChuanhuChatGPT

# Oobabooga one-click installer:

https://github.com/oobabooga/one-click-installers

# More:

https://github.com/gradio-app/gradio

https://github.com/fghrsh/live2d_demo