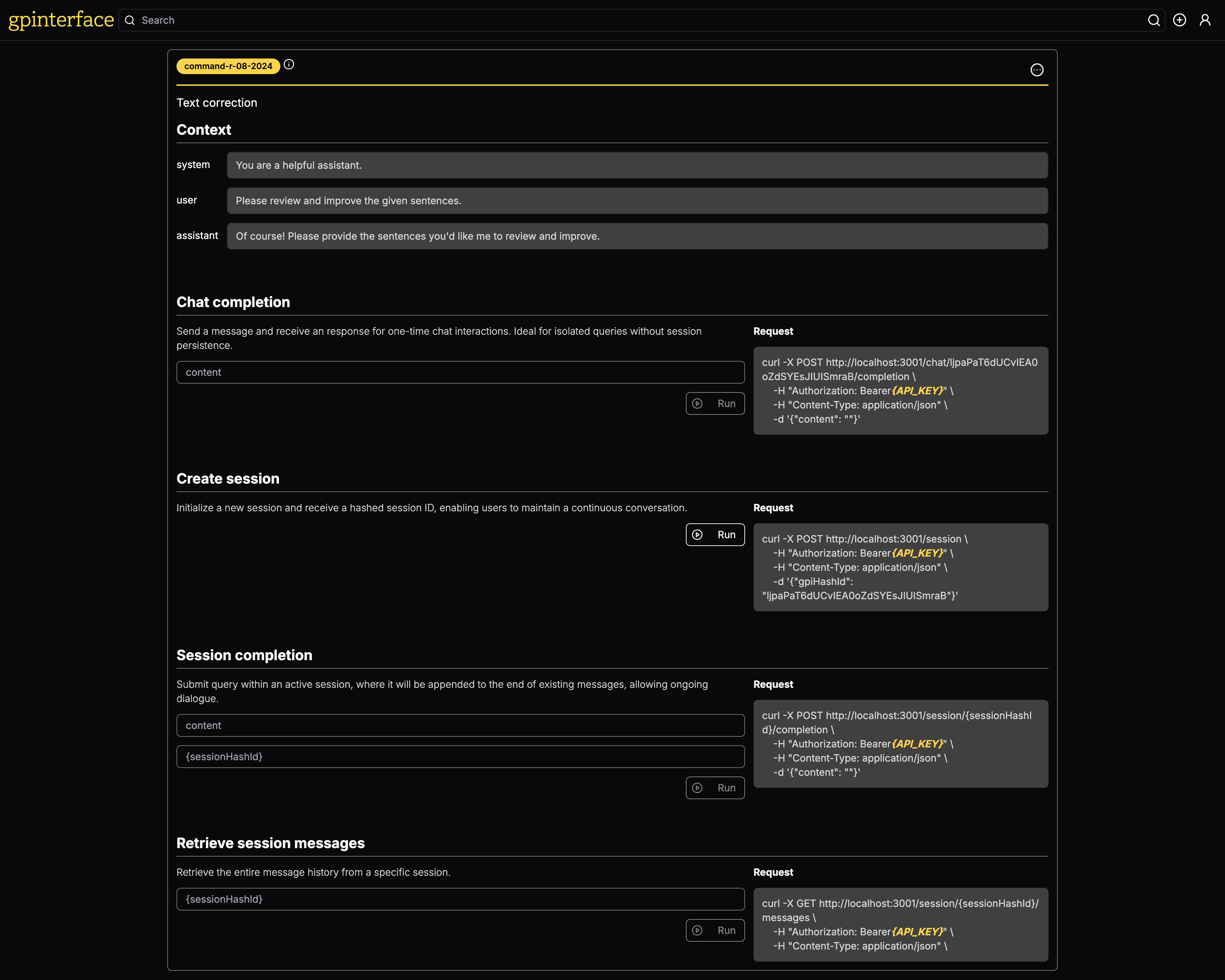

С gpinterface вы можете легко создать API для ваших подсказок.

Живая демонстрация доступна на gpinterface.com.

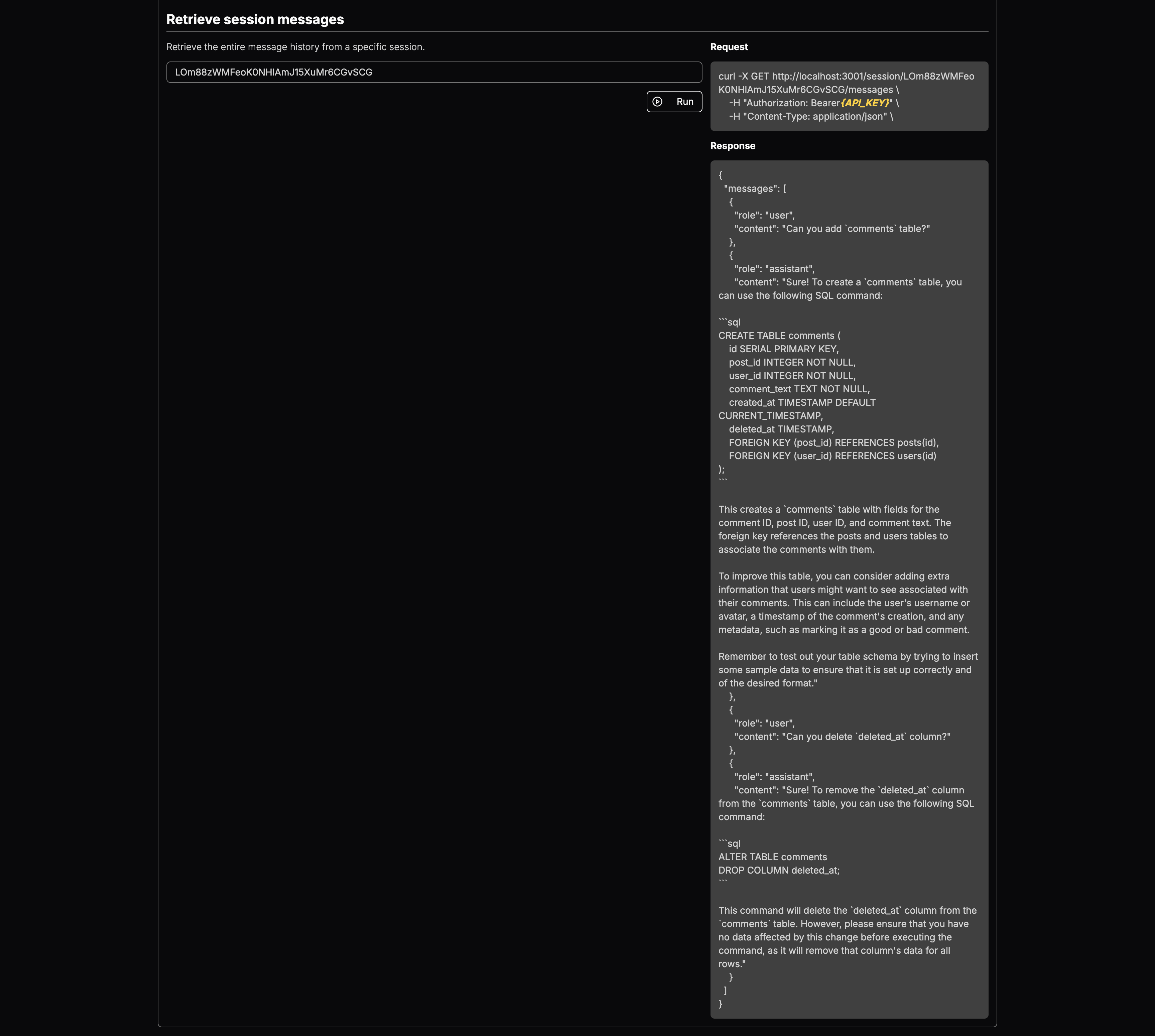

Вот несколько конкретных примеров того, что может сделать gpinterface :

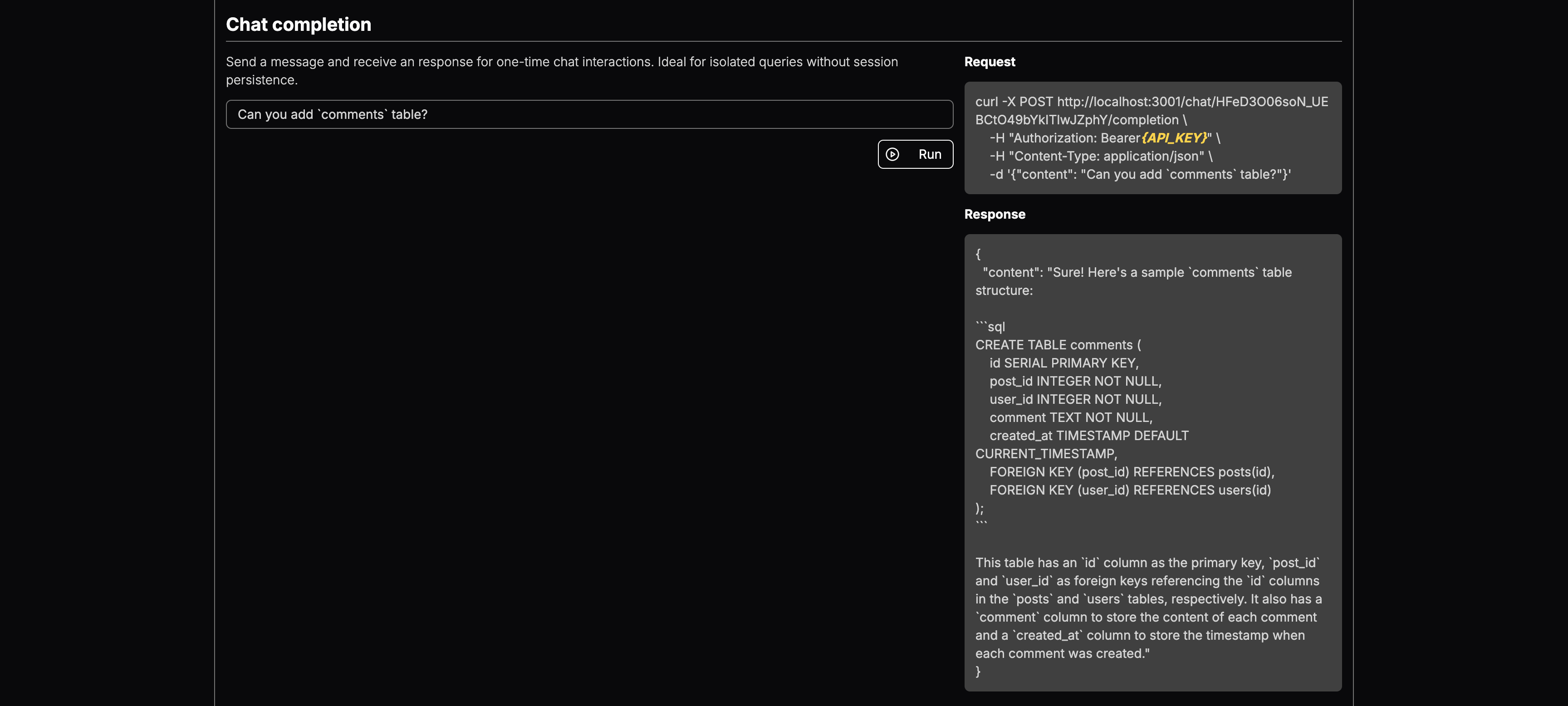

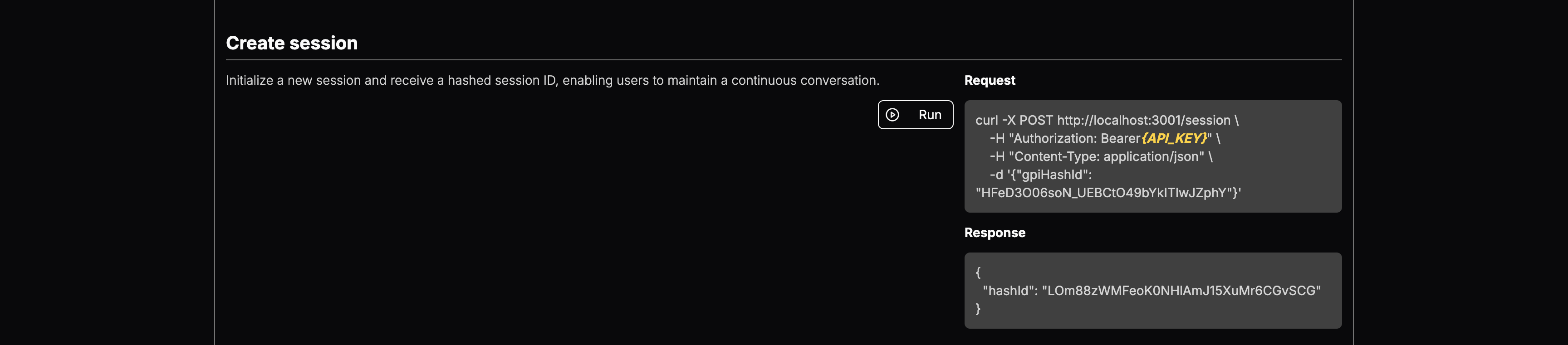

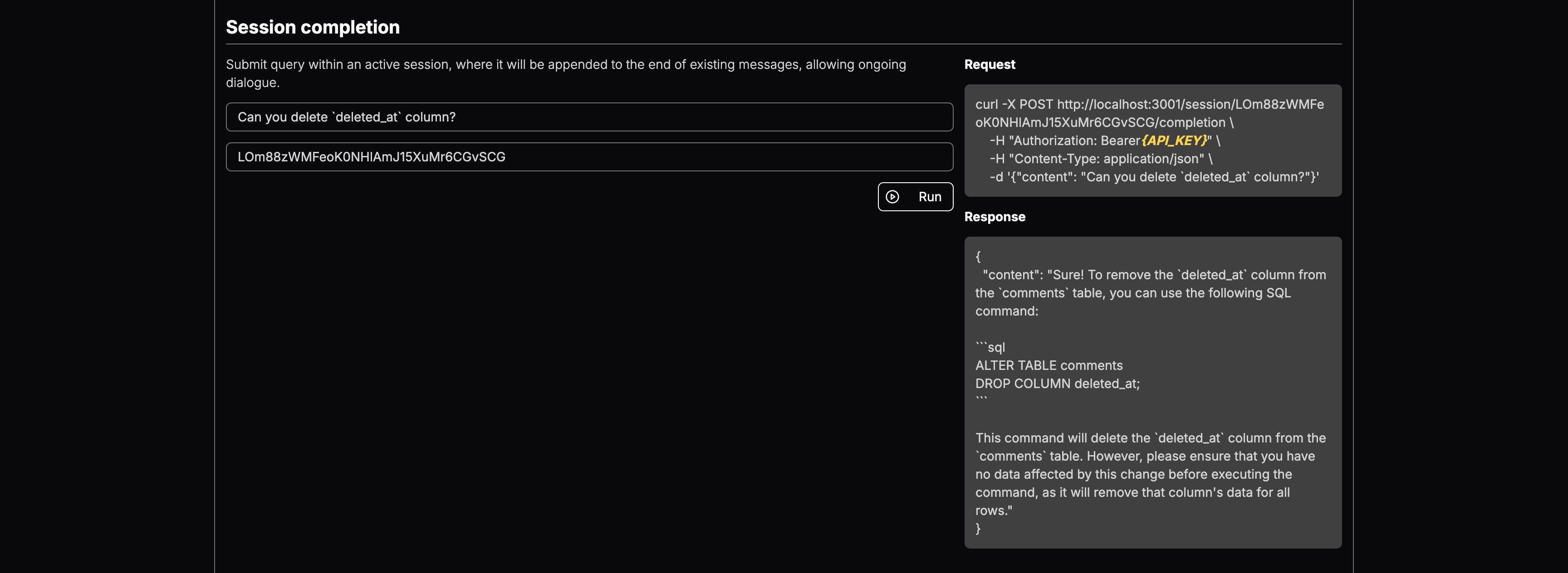

Вы можете выбрать модель LLM и добавить контекст. После развертывания вы получите конечные точки для:

Это мощный инструмент, предназначенный для оптимизации тестирования и развертывания генеративных подсказок для нескольких крупных языковых моделей (LLMS). С помощью простого в использовании веб-интерфейс gpinterface обеспечивает быструю конфигурацию и эксперименты.

gpinterface в настоящее время поддерживает различные ведущие крупные языковые модели, в том числе:

Эта разнообразная поддержка позволяет вам выбрать лучшую модель для ваших конкретных потребностей и требований.

Не видите свою любимую модель? Не стесняйтесь открывать PR или свяжитесь со мной!

Приложение требует базы данных PostgreSQL. Запустите базу данных с помощью Docker:

cd backend

docker-compose up -dБэкэнд использует Prisma для управления схемой базы данных и миграциями. Выполнить следующие команды при инициализации базы данных:

npm run prisma:migrateЧтобы заселить базу данных начальными данными для каждой поддерживаемой большой языковой модели, запустите следующие команды:

npx ts-node prisma/seedБэкэнд

Бэкэнд требует, чтобы следующие переменные среды были установлены:

CLIENT_URL= " http://localhost:3003 "

DATABASE_URL= " postgresql://postgres:[email protected]:5432/postgres " # can be replaced with your DB endpoint

AI21_API_KEY= " YOUR_AI21_API_KEY "

ANTHROPIC_API_KEY= " YOUR_ANTHROPIC_API_KEY "

COHERE_API_KEY= " YOUR_COHERE_API_KEY "

GOOGLE_API_KEY= " YOUR_GOOGLE_API_KEY "

MISTRAL_API_KEY= " YOUR_MISTRAL_API_KEY "

OPENAI_API_KEY= " YOUR_OPENAI_API_KEY "

AWS_ACCESS_KEY_ID= " AWS_ACCESS_KEY " # you need Llama model access in AWS Bedrock

AWS_SECRET_ACCESS_KEY= " AWS_SECRET_KEY " # you need Llama model access in AWS Bedrock

JWT_SECRET= " SECURE_RANDOM_STRING "

COOKIE_SECRET= " SECURE_RANDOM_STRING "

NODE_ENV= " development " # for development logging Убедитесь, что эти переменные устанавливаются в файле .env в каталоге бэкэнд перед началом приложения.

внешний интерфейс

Приложение Frontend требует следующих переменных среды:

NEXT_PUBLIC_API_ENDPOINT= " http://localhost:3000 "

NEXT_PUBLIC_CHAT_ENDPOINT= " http://localhost:3001 "

NEXT_PUBLIC_HOSTNAME= " http://localhost:3003 "

NEXT_PUBLIC_GOOGLE_OAUTH_CLIENT_KEY= " "Они должны быть настроены в соответствии с конечными точками, где доступны сервисы бэкэнд, гарантируя, что фронт может правильно общаться с бэкэндом.

Для запуска компонентов приложения отдельно для целей разработки:

Бежать бэкэнд

cd backend && npm run devЗапустить фронт

cd frontend && npm run devЧтобы создать все компоненты для развертывания производства, выполните следующие действия последовательно

cd shared

npm run build

cd ../backend

npm run build

cd ../frontend

npm run buildЧтобы запустить сервер

Бежать бэкэнд

cd backend && npm run startЗапустите сервер чата (сервер API)

cd backend && npm run start:chatЗапустить фронт

cd frontend && npm run start