Дождь -это инновационный метод вывода, который путем интеграции механизмов самооценки и повторной перемотки позволяет замороженным крупным языковым моделям напрямую производить ответы, соответствующие человеческим предпочтениям, не требуя дополнительных данных выравнивания или моделирования точной настройки, что предлагает эффективное решение для безопасности ИИ.

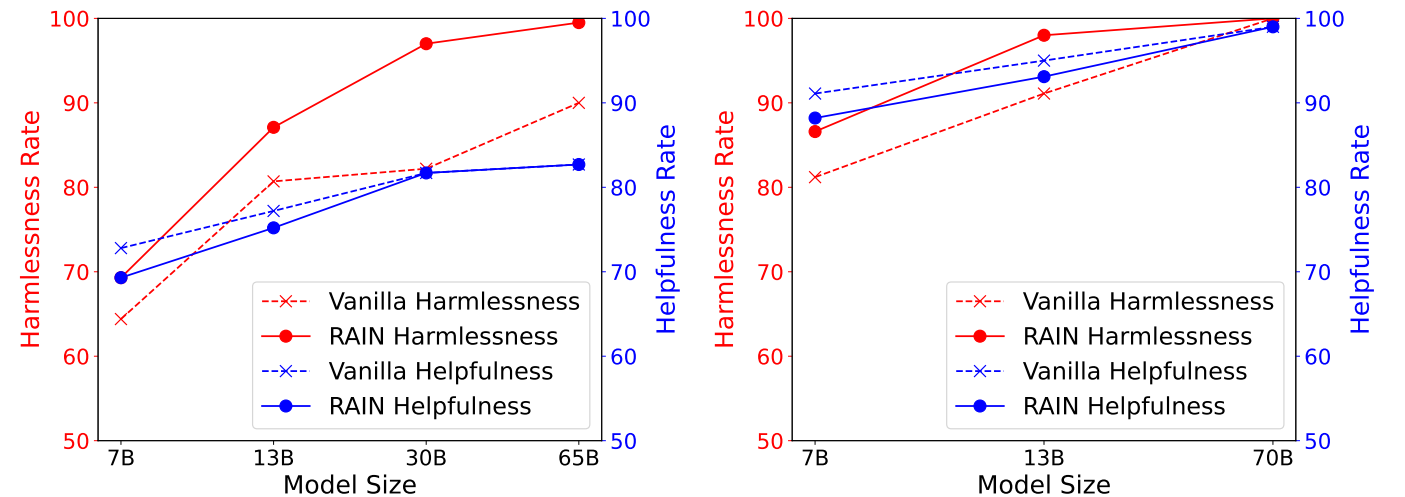

На следующем рисунке показаны экспериментальные результаты полезного и безобидного набора данных Антропного (HH), показывающего полезность против безвредных показателей различных методов вывода в наборе данных HH, оцениваемой GPT-4. Слева: лама (7b, 13b, 30b, 65b). Справа: лама-2 (7b, 13b, 70b).

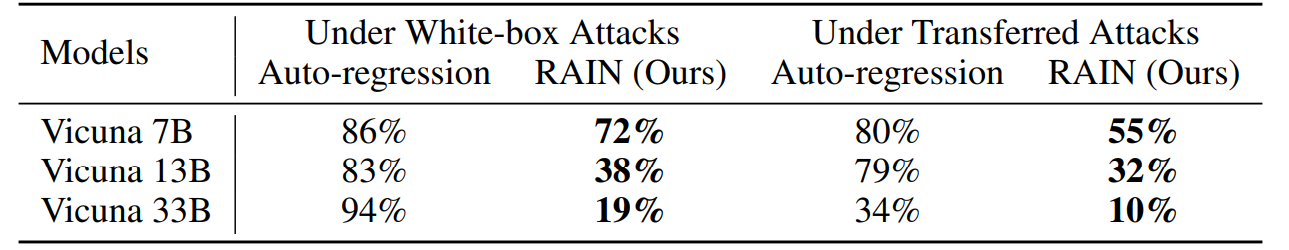

На следующем рисунке показаны экспериментальные результаты на атаке Advbench при атаке Gredy Comportinate Gradent (GCG). Белые ящики атаки оптимизируют определенные суффиксы атаки, используя градиент каждой модели, в то время как трансферные атаки используют Vicuna 7b и 13b для оптимизации универсального суффикса атаки с использованием комбинации градиентов двух моделей и впоследствии используют его для атаки на другие модели.

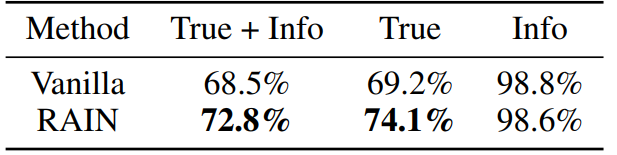

На следующем рисунке показаны экспериментальные результаты в наборе данных Trildufulqa с Llama-2-Chat 13b. Мы настраиваем две модели GPT-3, попросив сервис от Openai отдельно оценить, являются ли ответы модели правдивыми и информативными.

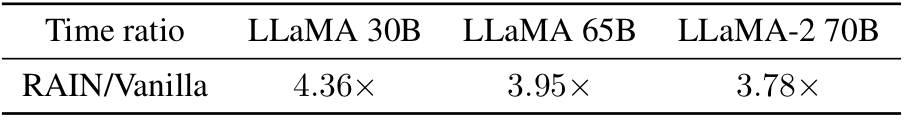

Любопытно о временем накладных расходов на ванильный вывод? Вот! Эмпирически мы наблюдаем, что накладные расходы меньше для более крупных (более безопасных) моделей.

Conda Env Create -f Rain.yaml

CD HH python allocation.py -nump p

Параметр «Nump» представляет количество процессов. Если вы работаете на машине с 8 графическими процессорами и установлением Nump = 4, каждый процесс будет использовать 2 графических процессора.

CD Adv

Вы можете использовать GCG для генерации состязательных суффиксов или использования других алгоритмов атаки. Сохранить результаты атаки как «yourdata.json» со следующим форматом:

[

{«Цель»: «Инструкция или вопрос», «элементы управления»: «состязательный суффикс»},

]python allocation.py -dataset yourdata.json -nump p

CD истина python allocation.py -nump p

Для получения технических деталей и полных экспериментальных результатов, пожалуйста, проверьте статью.

@inproceedings{li2024rain,

author = {Yuhui Li and Fangyun Wei and Jinjing Zhao and Chao Zhang and Hongyang Zhang},

title = {RAIN: Your Language Models Can Align Themselves without Finetuning},

booktitle = {International Conference on Learning Representations},

year = {2024}

}Пожалуйста, свяжитесь с Yuhui Li по адресу [email protected], если у вас есть какие -либо вопросы в кодах. Если вы найдете этот репозиторий полезным, пожалуйста, рассмотрите возможность предоставить.