Трол: обход слоев для больших моделей языка и зрения [arxiv]

Трол: обход слоев для больших моделей языка и зрения [arxiv]

Благодаря персоналу Huggingface мы можем использовать бесплатный Zerogpu (NVIDIA A100) для каждого пользователя, но есть ограниченные запросы, поэтому, если выводы застряли, пожалуйста, подождите несколько минут. (Местная демонстрационная скорость намного быстрее, чем это пространство GPU в Интернете.)

TROL-1.8B теперь доступен в моделях HuggingFace. (Местная демонстрационная Readme включена)

TROL-3.8B теперь доступен в моделях HuggingFace. (Местная демонстрационная Readme включена)

TROL-7B теперь доступен в моделях HuggingFace. (Местная демонстрационная Readme включена)

Онлайн -демонстрация трол теперь доступна в? (Вы можете выбрать размер модели)

Официальный код внедрения Pytorch для реализации технической части обхода слоев (TROL) для улучшения многочисленных языковых характеристик с эффективным размером модели. Этот код разработан с нуля. Поэтому я пытался улучшить задачу и простоту кода по сравнению с Llava, который имеет относительно сложный структурированный код.

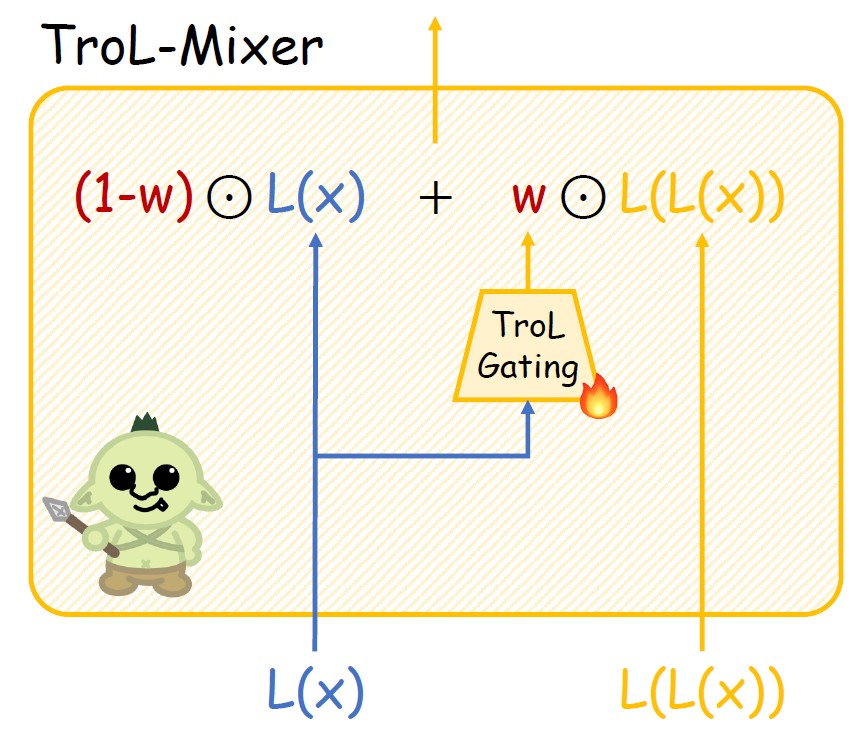

Рисунок 1. Трол слой. Новое распространение.

Рисунок 2. Структура трол-миксера.

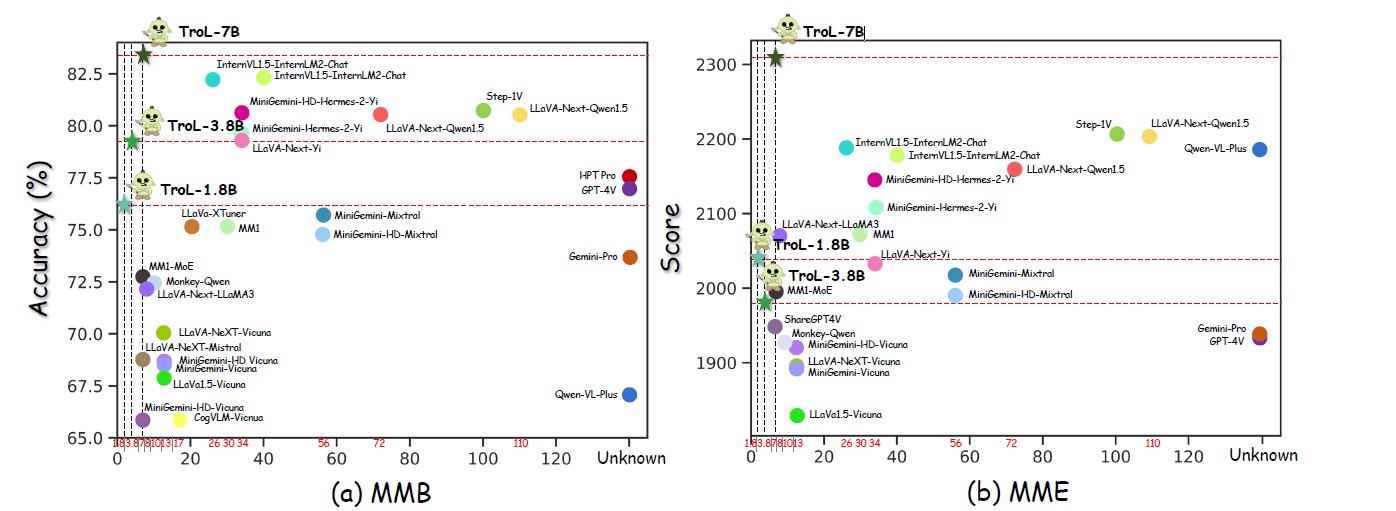

Рисунок 3. Выступления по многочисленным размерам модели.

Рисунок 4. Сравнение с LLVM с закрытым исходным кодом.

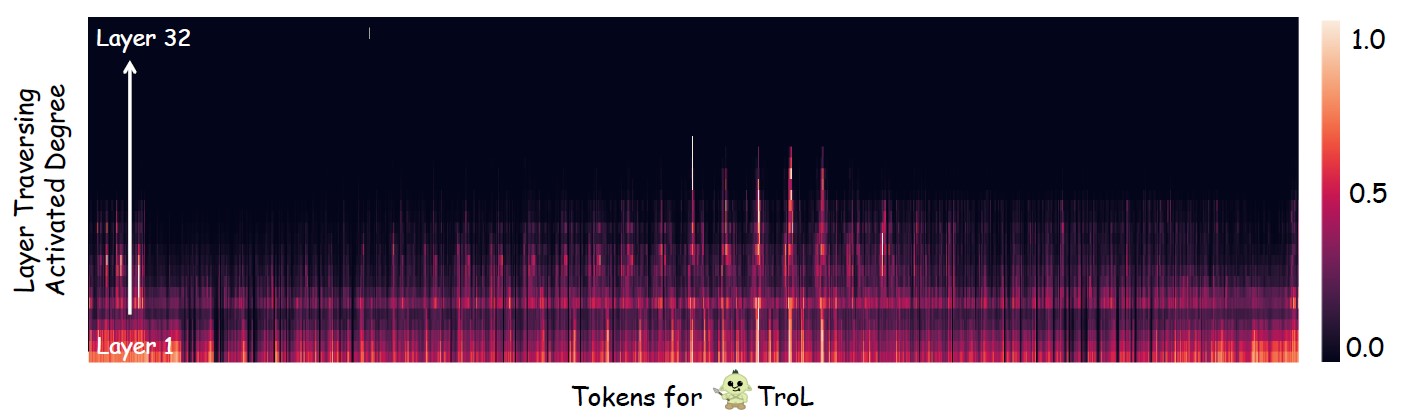

Рисунок 5. Исследование, где в основном происходит прохождение уровня (повторное использование слоев).

LLVMS с открытым исходным кодом со стандартным размером модели

| LLVMS | SQA-IMG | Папа | Май | Ммб | Mathvista | Семя-Имг | Мм-вете | Llava-W |

|---|---|---|---|---|---|---|---|---|

| Yi-vl-6b | 71.7 | 82,5 | 1915 | 64.2 | 29,7 | 67.5 | 32.1 | 51.9 |

| Llava-next-7b | 70.1 | 86.5 | 1851 | 69,6 | 34.6 | 70.2 | 43,9 | 72,3 |

| MM1-7B | 72,6 | 86.6 | 1858 | 72,3 | 35,9 | 70,9 | 42.1 | - |

| Трол-1,8B | 87.5 | 88.6 | 2038 | 76.1 | 45,4 | 69,0 | 45,1 | 69,7 |

| Трол-3,8B | 90.8 | 86.5 | 1980 | 79,2 | 55,1 | 70,5 | 51.1 | 76.6 |

| Трол-7B | 92,8 | 87.8 | 2308 | 51.8 | 75.3 | 54,7 | 92,8 | 87.1 |

LLVM с открытым исходным кодом с большими размерами модели

| LLVMS | Ai2d | Chartqa | Май | Ммб | Mathvista | Мм-вете | Llava-W |

|---|---|---|---|---|---|---|---|

| Internvl1.5-40b | 79,0 | 68.0 | 2175 | 82.2 | 47.7 | 48.9 | - |

| Internvl1.5-26b | 80.7 | 83,8 | 2188 | 82.2 | 53,5 | 62,8 | - |

| MM1-30B | - | - | 2069 | 75,1 | 39,4 | 48.7 | - |

| Minigemini-34b | - | - | 2105 | 79,6 | 38.9 | 53,0 | - |

| Minigemini-HD-34B | - | - | 2141 | 80.6 | 43,3 | 59,3 | - |

| Llava-next-34b | 74,9 | 68.7 | 2030 | 79,3 | 46.0 | 57.4 | 88.8 |

| Llava-next-8b | 71.6 | 69,5 | 1972 | 72.1 | 37.5 | - | 80.1 |

| Llava-next-72b | 77.4 | 77.0 | 2159 | 80.5 | 46.6 | - | 89,2 |

| Llava-next-110b | 80.4 | 80.4 | 2201 | 80.5 | 49,0 | - | 90.4 |

| Трол-1,8B | 68.9 | 64,0 | 2038 | 76.1 | 45,4 | 45,1 | 69,7 |

| Трол-3,8B | 73,6 | 73,8 | 1980 | 79,2 | 55,1 | 51.1 | 76.6 |

| Трол-7B | 78.5 | 71.2 | 2308 | 83,5 | 51.8 | 54,7 | 92,8 |

LLVMS с закрытым исходным кодом

| LLVMS | SQA-IMG | Ai2d | Chartqa | Май | Ммб | Mathvista | Семя-Имг | MMStar |

|---|---|---|---|---|---|---|---|---|

| Qwen-vl-plus | 71.6 | 75,9 | 78.1 | 2183 | 67.0 | 43,3 | 72,7 | 39,7 |

| Близнецы-про | 80.1 | 73,9 | 74.1 | 1933 | 73,6 | 45,2 | 70.7 | 41.6 |

| GPT-4V | 84,6 | 78.2 | 78.5 | 1927 | 77.0 | 49,9 | 69.1 | 46.1 |

| Трол-1,8B | 87.5 | 68.9 | 64,0 | 2038 | 76.1 | 45,4 | 69,0 | 45,5 |

| Трол-3,8B | 90.8 | 73,6 | 73,8 | 1980 | 79,2 | 55,1 | 70,5 | 46.5 |

| Трол-7B | 92,8 | 78.5 | 71.2 | 2308 | 83,5 | 51.8 | 75.3 | 51.3 |

Трол

ТролВсего: 2273830 (2,3 м)

------------------------------* & Sign & Symbol: 627k* Math: 747K

- Математика с видением: 180K

- Математика только с текстом: 566K

---------------------------

- ShareGPT4V-Caption [без SAM] (91021, 91K)

-ShareGPT4V-Instruction [без нескольких образцов OCR-VQA] (664703, 664K)

- Allava4V-Text (143000, 143K)

- Minigemini-Instruction [Docvqa, Chartqa, DVQA, AI2D] (27670, 27K)

- Docdownstream (574268, 574K)

- Docreason (25877, 25K)

- Gllava-Align (60252, 60K)

- Gllava-Qa (117205, 117K)

- Mathvision (3040, 3K)

- Mathinstruct [TextonlyDataset] (262040, 262K)

- Mathplus [TextonlyDataset] (304754, 304K)Мы собираем следующие девять наборов данных. Для Minigemini мы избирательно используем образцы данных только для DocVQA, ChartqA, DVQA и AI2D. Поэтому вам не нужно загружать все образцы данных для Minigemini.

ShareGPT4V [ссылка]

Allava4V-Text [ссылка]

Minigemini [ссылка]

Docdownstream [ссылка]

Docreason [ссылка]

ГЛЛАВА [Ссылка]

Mathvision [ссылка]

Mathinstruct [ссылка]

Mathplus [ссылка]

Собранная макет набора данных

Trol_dataset_path

├ack Llava # sharegpt4v│ └ack

│ └ └мобиляют изображения

├ack Coco # sharegpt4v│ └ack

Sam # sam # sharegpt4v│ └ack

├acke gqa # sharegpt4v│ └ack

├acke ocr_vqa # sharegpt4v│ └ack

TextVqa # sharegpt4v│ └ack

├ack vg # sharegpt4v│ ├ack vg_100k

│ └ack vg_100k_2

├ack vary_textvqa # sharegpt4v│ └ack

├acke Web-Celebrity # sharegpt4v│ └ack

├ack web-landmark # sharegpt4v│ └ack

Wikiart # sharegpt4v│ └ack

├ack vary_textvqa # sharegpt4v│ └ack

Docvqa # minigemini│ └ack

├ack chartqa # minigemini│ └ack

│ └ └мобиляют изображения

Dvqa # minigemini│ └ack

├acke ai2d # minigemini│ └ack

├ack Imgs # docdownstream & docreason│ └ack chartqa

│ └ack ude_benchmark

│ └ack Deepform

│ └ └мобил Docvqa

│ └ack infographicsvqa

│ └ack kLeasterCharity

│ └ackfact

│ └ └мобил

│ └ └мобиляционные шкалы

│ └acke TextVqa

│ └ack visualmrc

├ac geo3k # gllava | Train

├acke geoqa_plus # gllava├~ # mathvision | ├actry charegpt4v_instruct_gpt4-vision_cap100k.json # sharegpt4v-caption├ инструкто -Instruct-gpt4-turbo-143k. json # allava4v-text├íbk ├ jsonl # docdownstream├ack ├ deplaned_explanation.jsonl # docreason├├^ minigemini_instruction.json # minigemini-instruction├--├^ gllava_align.parquet # gllava-align├cy glava_qa.parquet # gllign.parquet # gllava-align├ack Qa├acing. Mathvision.parquet # mathvision├acing ─ mathinstruct.json # mathinstruct└--nd Mathplus.parquet # mathplusЭто список наборов данных оценки. Если вы полностью загружаете их, набор данных должен быть размещен в папке следующим образом ниже.

Q-Bench [ссылка]

SQA-IMG [ссылка]

Ai2d [ссылка]

Chartqa [ссылка]

Семя [ссылка]

Папа [ссылка]

Hallusionbench [ссылка]

Mme [ссылка]

Mathvista [ссылка]

MMB [ссылка]

Мм-вете [ссылка]

Llava-w [ссылка]

MMStar [ссылка]

Mathverse [ссылка]

VisualWebbench [ссылка]

Секции каталога наборов данных оценки

Evaluation_dataset_path ├ack Llvisionqa-qbench # q-bench├├мобильный # Hallusionbench├├мобил mme_benchmark_release_version # mme├--nd Mathvista # Mathvista├íмоби ─ MMStar # MMStar├acking Mathverse # Mathverse└Cyben