中文 Readme 请按此处

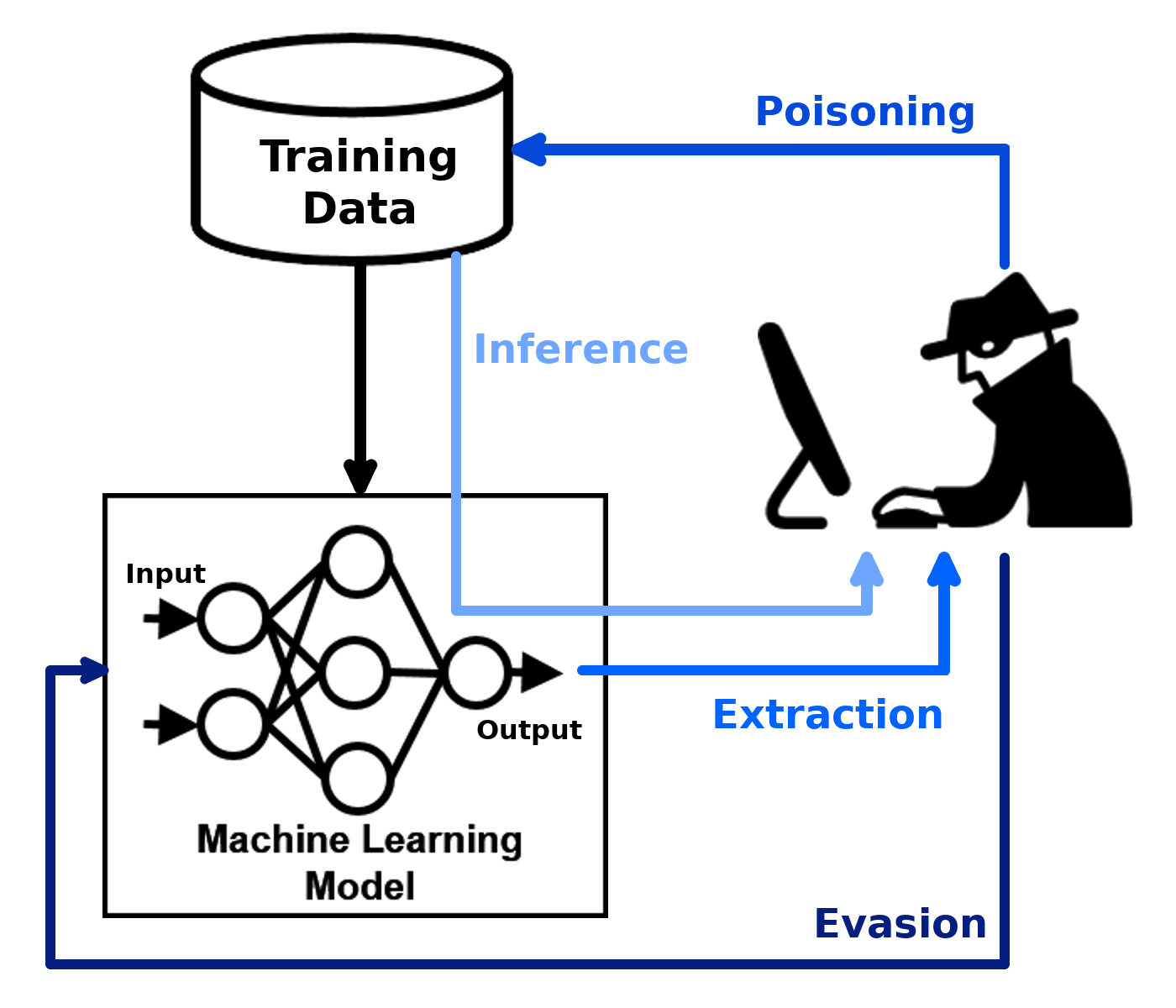

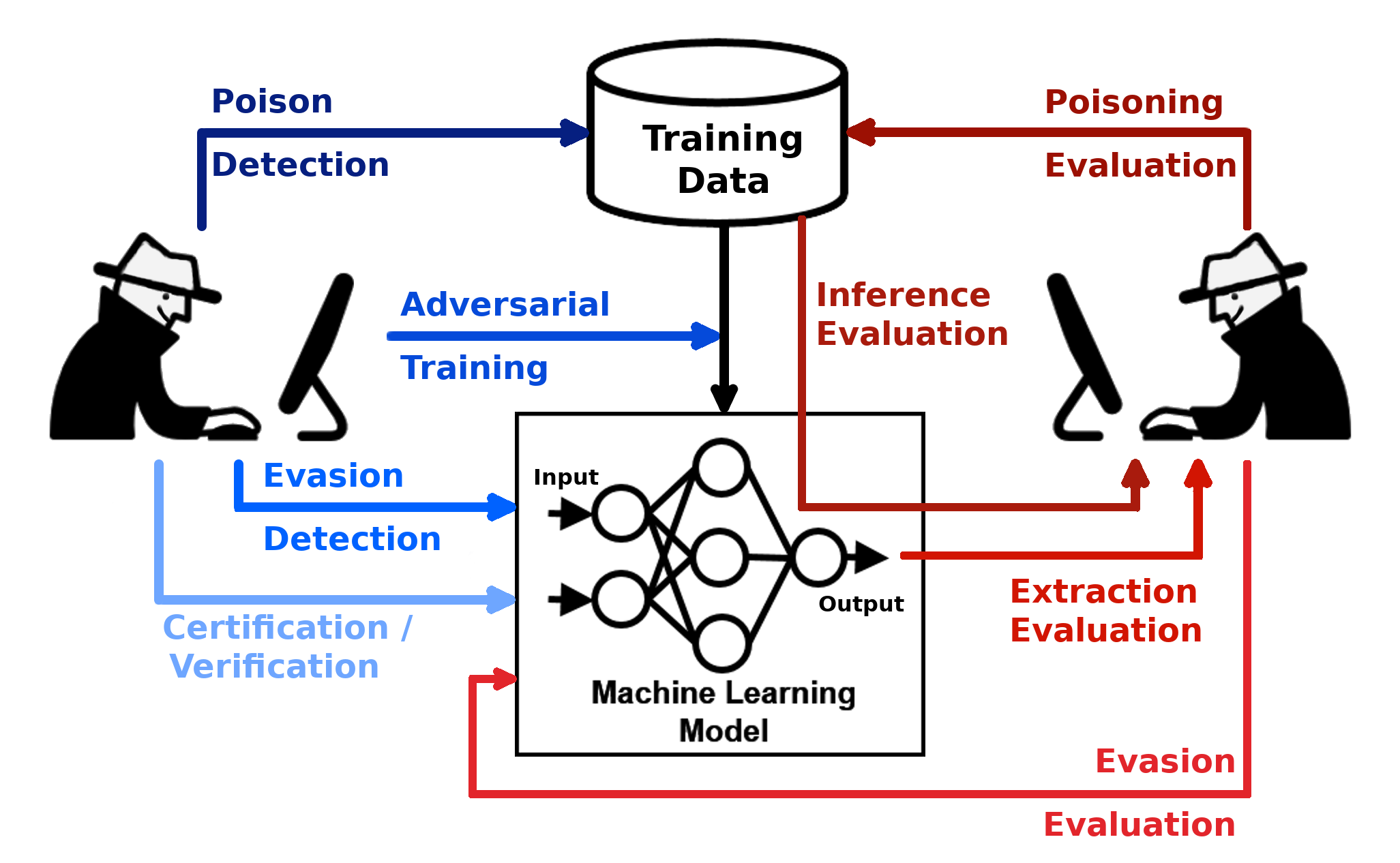

Набор инструментов для устойчивости состязания (ART) - это библиотека Python для безопасности машинного обучения. Искусство размещено Фондом Linux Foundation AI & Data Foundation (LF AI & Data). ART предоставляет инструменты, которые позволяют разработчикам и исследователям защищать и оценивать модели машинного обучения и применения против состязательных угроз уклонения, отравления, извлечения и вывода. Искусство поддерживает все популярные структуры машинного обучения (Tensorflow, Keras, Pytorch, Mxnet, Scikit-Learn, Xgboost, Lightgbm, Catboost, GPY и т. Д.), Все типы данных (изображения, таблицы, аудио, видео и т. Д.) И машинное обучение. Задачи (классификация, обнаружение объекта, распознавание речи, генерация, сертификация и т. Д.).

| Начните | Документация | Внося |

|---|---|---|

| - Установка - Примеры - записные книжки | - атаки - защита - Оценки - Метрики - Техническая документация | - Слаб, Приглашение - Вклад - Дорожная карта - цитируя |

Библиотека находится под постоянным развитием. Отзывы, отчеты об ошибках и взносы очень приветствуются!

Этот материал частично основан на работе, поддерживаемой Агентством Advanced Research Projects (DARPA) в соответствии с контрактом № HR001120C0013. Любые мнения, выводы и выводы или рекомендации, выраженные в этом материале, являются мнениями автора (-ов) и не обязательно отражают взгляды Агентства по передовым исследовательским проектам (DARPA).