Это курируемый список бумаг «Языковая модель-как услуга (LMAAS)», которые в основном поддерживаются Tianxiang Sun. Мы настоятельно рекомендуем исследователям НЛП, которые заинтересованы в этой теме, чтобы сделать запрос на привлечение, чтобы добавить или обновлять документы (см. Вклад). Посмотрите этот репозиторий для последних обновлений!

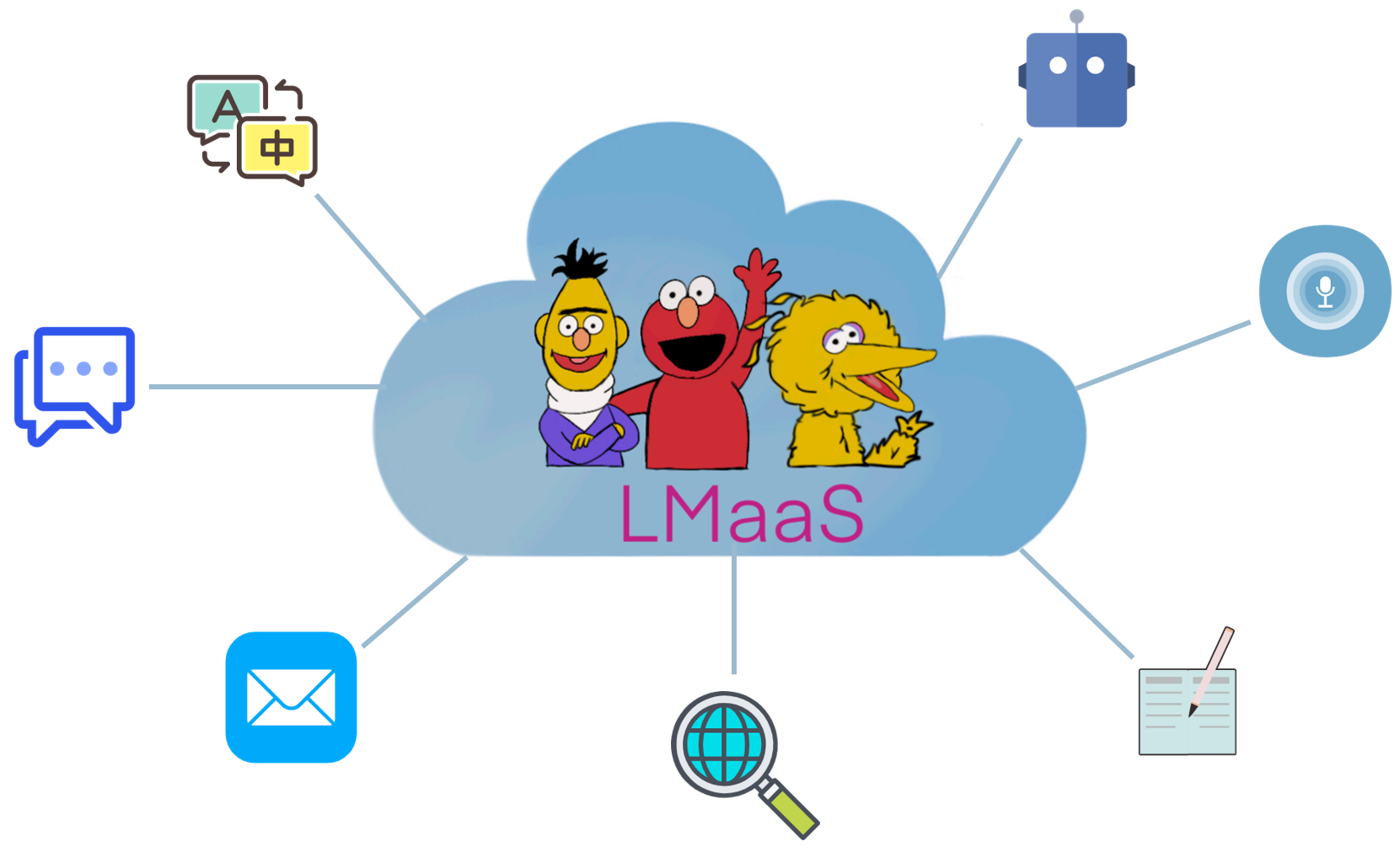

Из-за коммерческих причин и дорогих стоимости настройки предварительно обученные большие языковые модели (LLMS), такие как GPT-3, обычно выпускаются в качестве услуги вместо весов модели с открытым источником. Мы называем этот сценарий « Языковая модель-как услуга (LMAAS) » (термин изначально используется в нашей бумаге ICML'2022). В таком сценарии пользователи могут получить доступ к мощным LLM с помощью своих выводов. Сервис LLMS обеспечила много вариантов использования (см. Демо-3. В отличие от тонкой настройки, LMAAS позволяет LLM единого общего назначения выполнять множество различных задач и, следовательно, является высокоэффективным развертыванием. Тем не менее, как адаптировать LLM к целевым задачам без доступа к их параметрам и градиентам является проблемой. Чтобы заставить LLMS принести пользу более широкой аудитории, мы собираем статьи, которые вписываются в этот сценарий, чтобы облегчить будущие исследования.

Какие бумаги вписываются в сценарий LMAAS? В основном мы рассматриваем документы, которые адаптируются LLM к нижним задачам, не доступа к параметрам модели и градиентам. Хотя тонкие LLMS также могут быть услугами после развертывания, они ограничены, чтобы решить одну задачу для ограниченной аудитории. В нашей масштабах мы предпочитаем обслуживать модели общего назначения для различных пользователей.

В существующей литературе есть несколько линий исследований, которые вписываются в LMAAS:

Граница между текстовой подсказкой и в контексте обучения немного размыта. В этом репо, категория Text Reclempting содержит документы, в которых не используются помеченные образцы, в то время как в категории обучения в контексте состоит из документов, которые включают в себя помеченные образцы в подсказках.

ПРИМЕЧАНИЕ. Связанная (и частично перекрывающаяся) тема является обучением на основе быстрого обучения , которое направлено на решение задач вниз по течению с использованием LLM общего назначения путем преобразования ввода и вывода с некоторым шаблоном и вербализатором соответственно. Тем не менее, большинство работ в обучении на основе быстрого обучения требует доступа к параметрам и градиентам модели, и, следовательно, не вписывается в нашу область. Для быстрого обучения, которые не подходят для LMAAS, мы рекомендуем внести свой вклад в другой удивительный список бумаги: rompletpaper.

По сравнению с тонкой настройкой LLMS, LMAAS имеет следующие преимущества:

Сокращение работы.

Ключевая особенность работы.

Основная экспериментальная обстановка работы.

Языковые модели как базы знаний? EMNLP 2019

Фабио Петрони, Тим Рокташель, Патрик Льюис, Антон Бахтин, Юсиан Ву, Александр Х. Миллер, Себастьян Ридель . [PDF] [Код]

Как мы можем узнать, какие языковые модели знают? TACL 2020

Чжэнбао Цзян, Фрэнк Ф. Сюй, Джун Араки, Грэм Нойбиг . [PDF] [Код]

Языковые модели-это несколько выстрелов. Neurips 2020

Том Б. Браун, Бенджамин Манн, Ник Райдер, Мелани Суббия, Джаред Каплан, Прафулла Дхаривал, Арвинд Нилакантан, Пранав Шьям, Гириш Састри, Аманда Аскелл, Сандхини Агарвал, Ариэль Герберт-Вус, Гретхен Кру, Том Хэниген, Ревон, Адита Арберт-Вус, Гретхен Кру. Рамеш, Даниэль М. Зиглер, Джеффри Ву, Клеменс Винтер, Кристофер Хесс, Марк Чен, Эрик Сиглер, Матеуш Литвин, Скотт Грей, Бенджамин Шахмат, Джек Кларк, Кристофер Бернер, Сэм МакКандлиш, Алек Рэдфорд, Илью Сатскевер, Дарио Амодеей . [PDF]

Адаптация языковых моделей для нулевого обучения с помощью мета-подъема на наборе данных и приглашенных коллекциях . Результаты EMNLP 2021

Руики Чжун, Кристи Ли, Чжэн Чжан, Дэн Кляйн . [PDF] [Код]

Созданные языковые модели являются учениками с нулевым выстрелом . ICLR 2022

Джейсон Вэй, Мартен Босма, Винсент Ю. Чжао, Кельвин Гу, Адамс Вэй Ю, Брайан Лестер, Нэн Д.У., Эндрю М. Дай, Кук В. Ле . [PDF] [Код]

Многозадачность, вызванная обучением, позволяет обобщать задачи с нулевым выстрелом . ICLR 2022

Виктор Санх, Альберт Вебсон, Колин Раффель, Стивен Х. Бах, Линтанг Сутавика, Заид Алифей, Антуан Чаффин, Арно Стиглер, Тевен Ле Скао, Арун Раджа, Манан Дей, М. Сайфул Бари, Канвен Сюм, Урмиш Таккер, Шани Шарма Шарма, М. Элиза Шечла, Таевон Ким, Гунджан Чхаблани, Нихал Наяк, Дебаджёти Датта, Джонатан Чанг, Майк Тянь-Цзян Цзян, Хан Ван, Маттео Маника, Шенг Шен, Чжэн Синь Юн, Харшит Пандей, Рэйчел Бауден, Томас Ванг, Тришала Нирадж, Жос Рузен, Абхен, Абхт. Андреа Сантилли, Тибо Феври, Джейсон Алан Фрис, Райан Тихан, Тали Берс, Стелла Бидерман, Лео Гао, Томас Вольф, Александр М. Раш . [PDF] [Код]

Обучающие языковые модели, чтобы следовать инструкциям с отзывом человека . Препринт 2022.3

Лонг Оуян, Джефф Ву, Сюй Цзян, Диого Алмейда, Кэрролл Л. Уэйнрайт, Памела Мишкин, Чонг Чжан, Сандхини Агарвал, Катарина Слама, Алекс Рэй, Джон Шульман, Джейкоб Хилтон, Фрейзер Келтон, Луке Миллер, Мэдди Сименс, Аманда Аскал, Асалл, Асал. Питер Велдер, Пол Кристиан, Ян Лейк, Райан Лоу . [PDF] [Код]

Большие языковые модели-это с нулевые выстрелы . Препринт 2022.6

Такеши Кодзима, Шиксиан Шейн Гу, Мачел Рейд, Ютака Мацуо, Юсуке Ивасава . [PDF] [Код]

Ответ на видео с нулевым выстрелом с помощью замороженных двунаправленных языковых моделей . Препринт 2022.6

Антуан Ян, Антуан Мич, Йозеф Сивич, Иван Лаптев, Корделия Шмид . [PDF] [Код]

Языковые модели-это интерфейсы общего назначения . Препринт 2022.6

Яру Хао, Хаою Сонг, Ли Донг, Шаохан Хуан, Зуэн Чи, Венхуй Ван, Шуминг М.А., Фуру Вэй . [PDF] [Код]

Заглавное генерация на уровне репозитория для больших языковых моделей кода. Препринт 2022.6

Disha Shrivastava, Hugo Larochelle, Daniel Tarlow [PDF] [Code], 2022.6

Игнорируйте предыдущую подсказку: методы атаки для языковых моделей. Best Paper Award @ Neurips ML Safety Workshop 2022.

Фабио Перес, Ян Рибейро [PDF] [Project], 2022.11

Языковые модели-это несколько выстрелов. Neurips 2020

Том Б. Браун, Бенджамин Манн, Ник Райдер, Мелани Суббия, Джаред Каплан, Прафулла Дхаривал, Арвинд Нилакантан, Пранав Шьям, Гириш Састри, Аманда Аскелл, Сандхини Агарвал, Ариэль Герберт-Вус, Гретхен Кру, Том Хэниген, Ревон, Адита Арберт-Вус, Гретхен Кру. Рамеш, Даниэль М. Зиглер, Джеффри Ву, Клеменс Винтер, Кристофер Хесс, Марк Чен, Эрик Сиглер, Матеуш Литвин, Скотт Грей, Бенджамин Шахмат, Джек Кларк, Кристофер Бернер, Сэм МакКандлиш, Алек Рэдфорд, Илью Сатскевер, Дарио Амодеей . [PDF]

Калибровать перед использованием: улучшение производительности языковых моделей . ICML 2021

Тони З. Чжао, Эрик Уоллес, Ши Фэн, Дэн Кляйн, Самир Сингх . [PDF] [Код]

Объяснение в контекстовом обучении как неявный байесовский вывод . ICLR 2022

Санг Майкл Си, Адити Рагхунатан, Перси Лян, Тенгю Ма . [PDF] [Код]

Цепочка мыслительного подсказки вызывает рассуждения в крупных языковых моделях . Препринт 2022.1

Джейсон Вей, Сюэжи Ван, Дейл Шуурманс, Мартен Босма, Брайан Ихтер, Фей Ся, Эд Чи, Кук Ле, Денни Чжоу . [PDF]

Обобщение по перекрестной задаче с помощью инструкций по краудсорсингу естественного языка . ACL 2022

Сваруп Мишра, Даниэль Хашаби, Читта Барал, Ханнане Хаджиширзи . [PDF] [Код]

Фантастически упорядоченные подсказки и где их найти: преодоление чувствительности к быстрому удару . ACL 2022

Яо Лу, Макс Бартоло, Аластер Мур, Себастьян Рид, Понтус Стентерп . [PDF]

Чудому каналу языковой модели подсказка для нескольких выстрелов классификации текста . ACL 2022

Sewon Min, Майк Льюис, Ханнане Хаджиширзи, Люк Зеттлемуер . [PDF] [Код]

Мета-обучение через языковую модель в контексте настройки . ACL 2022

Янда Чен, Руики Чжун, Шэн Чжа, Джордж Карипис, он . [PDF] [Код]

Что делает хорошие примеры в контексте для GPT-3? Deelio@acl 2022

Цзячан Лю, Дингхан Шен, Йиже Чжан, Билл Долан, Лоуренс Карин, Вейху Чен . [PDF]

Обучение для получения подсказок для обучения в контексте . NAACL 2022

Охад Рубин, Джонатан Херциг, Джонатан Берант . [PDF] [Код]

Metaicl: научиться учиться в контексте . NAACL 2022

Sewon Min, Майк Льюис, Люк Зеттлемуер, Ханнане Хаджиширзи . [PDF] [Код]

Улучшение встроенного обучения с небольшим выстрелом с помощью самоотверженного обучения . NAACL 2022

Mingda Chen, Jingfei Du, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva . [PDF]

Самогенерированное встроенное обучение: использование авторегрессивных языковых моделей в качестве демонстрационного генератора . LPLM@NAACL 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee . [PDF]

Переосмысление роли демонстраций: что делает в условиях обучения в контексте? Препринт 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [Код]

Внутреннее обучение для отслеживания состояния диалога с несколькими снимками. Препринт 2022.3

Юши Ху, Чиа-Хсуан Ли, Тянбао Си, Тао Ю, Ноа А. Смит, Мари Остендорф . [PDF] [Код]

Самосогласованность улучшает цепочку мышления в языковых моделях . Препринт 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc Le, Ed Chi, Denny Zhou . [PDF]

Звезда: Самоучка рассуждения по начальной загрузке с рассуждением . Препринт 2022.3

Эрик Зеликман, Юхуай Ву, Ноа Д. Гудман . [PDF]

Обобщение сравнительного анализа с помощью инструкций в контексте по 1600+ языковыми задачами . Препринт 2022.4

Йихонг Ванг, Сваруп Мишра, Пега Алипормолабаши, Йегане Корди, Амирреза Мирзаи, Анджана Арункумар, Арджун Ашок, Арут Сельван Дханасекаран, Атхарва Наик, Дэвид Стап, Эшаан Патхак, Джаннис Карамананалак, Гаа -Газар, Лай -Лай -Лай -Газар Ишани Мондал, Джейкоб Андерсон, Кирби Кузняя, Крима Доши, Майтрея Патель, Кунтал Кумар Пал, Мехрад Морадшахи, Михир Пармар, Мирали Пурохит, Нирадж Варшни, Фани Рохита Каза, Пулкит Верма, Равсаджа Синдха, Рашанг -Каза Сампат, Саван -Доши, Сиддхартха Мишра, Суджан Редди, Суманта Патро, Танай Диксит, Ксудонг Шен, Читта Барал, Йеджин Чой, Ноа А. Смит, Ханнане Хаджиширзи, Даниэль Хашаби . [PDF] [Код]

Могут ли языковые модели учиться на объяснениях в контексте? Полем Препринт 2022.4

Эндрю К. Лампинен, Ишита Дасгупта, Стефани Сай Чан, Кори Мэтьюсон, Майкл Генри Тесслер, Антония Кресвелл, Джеймс Л. Макклелланд, Джейн Х. Ван, Феликс Хилл . [PDF]

Метки-территорию земли имеют значение: более глубокий взгляд на демонстрации ввода-маршрута . Препринт 2022,5

Junyeob Kim, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol Jo, Sang-Woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim . [PDF]

Ненадежность объяснений в нескольких выстрелах в контексте обучения . Препринт 2022,5

Xi Ye, Грег Дурретт . [PDF]

Наименьшее количество подсказок позволяет сложные рассуждения в крупных языковых моделях . Препринт 2022,5

Денни Чжоу, Натанаэль Шарли, Ле Хоу, Джейсон Вей, Натан Шелкс, Сюэжи Ван, Дейл Шуурманс, Оливье Букет, Кук Ле, Эд Чи . [PDF]

Маеутическое подсказка: логически последовательные рассуждения с рекурсивными объяснениями . Препринт 2022,5

Jaehun Jung, Lianhui Qin, Sean Welleck, Faeze Brahman, Chandra Bhagavatula, Ronan Le Bras, Yejin Choi . [PDF]

На продвижение языковых моделей лучшими обоснователями . Препринт 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weizhu Chen . [PDF] [Код]

Возникающие способности крупных языковых моделей . Препринт 2022.6

Джейсон Вей, Йи Тай, Риши Боммасани, Колин Раффель, Баррет Зоф, Себастьян Борги, Дани Йогатама, Маартен Босма, Денни Чжоу, Дональд Метцлер, Эд Х. Чи, Тацунори Хашимото, Иройо Виньялы, Перси Лианг, Джиф Дейн, Уильям Феду . [PDF]

Языковые модели-это интерфейсы общего назначения . Препринт 2022.6

Яру Хао, Хаою Сонг, Ли Донг, Шаохан Хуан, Зуэн Чи, Венхуй Ван, Шуминг М.А., Фуру Вэй . [PDF] [Код]

Что могут научиться трансформаторам в контексте? Тематическое исследование простых классов функций . Препринт 2022.8

Шивам Гарг, Димитрис Ципрас, Перси Лян, Грегори Валиант . [PDF] [Код]

Обучение путем дистилляции контекста . Препринт 2022.9

Чарли Снелл, Дэн Кляйн, Руики Чжун . [PDF]

Привязывающие языковые модели на символических языках . Препринт 2022.10

Zhoujun Cheng*, Tianbao Xie*, Peng Shi, Chengzzu Li, Rahul Nadkarni, Yushi Hu, Caiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettlemoyer, Ноа А. Смит, Тао Ю. [PDF] [CODE] [Веб -сайт]

Сохранение способностей к контексту в обучении в большой языковой модели тонкая настройка . Препринт 2022.11

Йихан Ван, Си С.И., Даляниг Ли, Михал Лукасик, Феликс Ю, Чо-Юи Сьи, Индерджит С. Дхиллон, Санджив Кумар . [PDF]

Обучение алгоритмическим рассуждениям с помощью встроенного обучения . Препринт 2022.11

Хэтти Чжоу, Азаде Нова, Хьюго Ларошель, Аарон Курвилл, Бехнам Нейшабур, Хани Седги . [PDF]

Какой алгоритм обучения в контексте обучения? Исследования с линейными моделями . Препринт 2022.11

Экин Акюрек, Дейл Шуурманс, Джейкоб Андреас, Тенгю М.А., Денни Чжоу . [PDF]

Черная настройка для языковой модели как услуга . ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, Xipeng Qiu. [PDF] [Код]

Черное яблоко быстрое обучение для предварительно обученных языковых моделей . TMLR 2023.2

Shizhe Diao, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang . [PDF]

Захваты: без градиентов, редактируя поиск инструкций для подсказки больших языковых моделей . Препринт 2022.3

Архики Прасад, Питер Хасе, Сян Чжоу, Мохит Бансал . [PDF] [Код]

Несколько выстрелов в направлении управляемого генерации ответов . Препринт 2022.6

Hsuan Su, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-tse Chen, Hung-Yi Lee . [PDF]

BBTV2: к будущему без градиента с большими языковыми моделями . EMNLP 2022

Tianxiang Sun, Zhengfu He, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu . [PDF] [Код]

RLPROMPT: оптимизация дискретных текстовых подсказок при обучении подкреплению . EMNLP 2022

Мингкай Денг, Цзянью Ван, Ченг-Пин Хси, Ихан Ван, Хан Го, Тяньмин Шу, Менг Сонг, Эрик П. Син, Читинс Ху . [PDF] [Код]

Настройка клипа: к быстрому обучению без производной со смесью вознаграждений . Результаты EMNLP 2022

Йекун Чай, Шуууан Ван, Ю Сан, Хао Тянь, Хуа Ву, Хайфенг Ван . [PDF]

Tempa: Редактирование времени тестирования с помощью обучения подкреплению . Препринт 2022.11

Тяньджун Чжан, Сюэжи Ван, Денни Чжоу, Дейл Шуурманс, Джозеф Э. Гонсалес. [PDF] [Код]

Щепленок: Классификация текста черного ящика с десятью проходами вперед . Препринт 2022.12

Байру Хоу, Джо О'Коннор, Джейкоб Андреас, Шию Чанг, Ян Чжан . [PDF]

Многозадачное предварительное обучение модульной подсказки для китайского обучения . ACL 2023

Tianxiang Sun, Zhengfu HE, Qin Zhu, Xipeng Qiu, Xuanjing Huang . [PDF]

Когда градиент спуск соответствует оптимизации без производной: матч, сделанный в сценарии черного ящика . ACL 2023

Ченгченг Хан, Ликинг Куй, Ренеу Чжу, Цзяньинг Ван, Нуо Чен, Цюши Сан, Сян Ли, Мин Гао . [PDF]

Сделайте быстрого настройки черной коробки на основе быстрого настройки: повышение обобщения модели с трех ортогональных точек зрения . Lrec-Coling 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao . [PDF]

Настройка или не настроить? Адаптация предварительно проведенных представлений к разнообразным задачам . Repl4nlp@acl 2019

Мэтью Э. Питерс, Себастьян Рудер, Ноа А. Смит . [PDF]

Могут ли объяснения быть полезными для калибровки моделей черного ящика? ACL 2022

Xi Ye, Грег Дурретт . [PDF] [Код]

Совместное обучение улучшает быстрое обучение на основе крупных языковых моделей . ICML 2022

Хантер Ланг, Моника Агравал, Юн Ким, Дэвид Сонтаг . [PDF]

Y-Tuning: эффективная парадигма настройки для крупномасштабных предварительно обученных моделей с помощью обучения представлению метки . Препринт 2022.2

Йитао Лю, Ченксин А.Н., Xipeng Qiu . [PDF]

LST: Лестница боковой настройки для параметров и эффективного переноса памяти . Neurips 2022

Yi-Lin Sung, Jaemin Cho, Mohit Bansal . [PDF] [Код]

Настройка декодера: эффективное понимание языка как декодирование . Препринт 2022.12

Ganqu Cui, Wonao Li, Ning Ding, Longtao Huang, Zhiyuan Liu, Maosong Sun. [PDF]

Создание наборов данных с предварительно проведенными языковыми моделями . EMNLP 2021

Тимо Шик, Хинрих Шютце . [PDF] [Код]

GPT3MIX: использование крупномасштабных языковых моделей для увеличения текста . Результаты EMNLP 2021

Кан Мин Ю, парк Дунджу, Jaewook Kang, Sang-Woo Lee, Woomyeong Park . [PDF] [Код]

Сгенерированные знания, подсказывающие здравый смысл рассуждения . ACL 2022

Jiacheng Liu, Alisa Liu, Ximing Lu, Sean Welleck, Peter West, Ronan Le Bras, Yejin Choi, Hannaneh Hajishirzi . [PDF] [Код]

Зероген: эффективное обучение с нулевым выстрелом с помощью генерации наборов данных . EMNLP 2022

Jiacheng Ye, Jiahui Gao, Qintong Li, Hangued, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong . [PDF] [Код]

Зероген+: самостоятельно качественная генерация данных при эффективном обучении с нулевым выстрелом . Препринт 2022.2

Jiahui Gao, Renjie Pi, Yong Lin, Hange Xu, Jiacheng Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo Li, Lingpeng Kong . [PDF]

AUGESC: увеличение диалога с большими языковыми моделями для эмоциональной поддержки разговора . Результаты ACL 2023

Chujie Zheng, Sahand Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang . [PDF]

Создание учебных данных с языковыми моделями: к пониманию языка с нулевым выстрелом . Neurips 2022

Ю Менг, Джиасин Хуанг, Ю Чжан, Цзявей Хан [PDF] [Код]

?? Во -первых, спасибо, что нашли время внести свой вклад! ??

Шаги, чтобы внести свой вклад:

PaperNumber в верхней части страницы и отправьте запрос на вытяжение. Мы рекомендуем дать очень краткое объяснение, почему вы думаете, что бумага должна быть добавлена или изменена.Не волнуйтесь, если вы сделаете что -то не так, мы исправим их для вас. Просто внесите и продвигайте свою потрясающую работу здесь!

В дополнение к следующим участникам, которые подали запросы на привлечение, мы также хотели бы поблагодарить Охад Рубин и Кан Мин Ю за рекомендацию документов.