Редактор Downcodes узнал, что Hugging Face сегодня выпустила SmolLM2 — серию компактных языковых моделей, впечатляющих производительностью и требующих гораздо меньше вычислительных ресурсов, чем большие модели. Это, несомненно, хорошая новость для разработчиков, которые хотят развертывать приложения искусственного интеллекта на устройствах с ограниченными ресурсами. SmolLM2 выпускается под лицензией Apache 2.0 и предоставляет три модели с разными размерами параметров, которые можно гибко адаптировать к различным сценариям применения.

Hugging Face сегодня выпустила SmolLM2, новый набор компактных языковых моделей, которые достигают впечатляющей производительности, требуя при этом гораздо меньше вычислительных ресурсов, чем более крупные модели. Новая модель выпущена под лицензией Apache 2.0 и поставляется в трёх размерах — с параметрами 135M, 360M и 1,7B — подходящих для развертывания на смартфонах и других периферийных устройствах с ограниченной вычислительной мощностью и памятью.

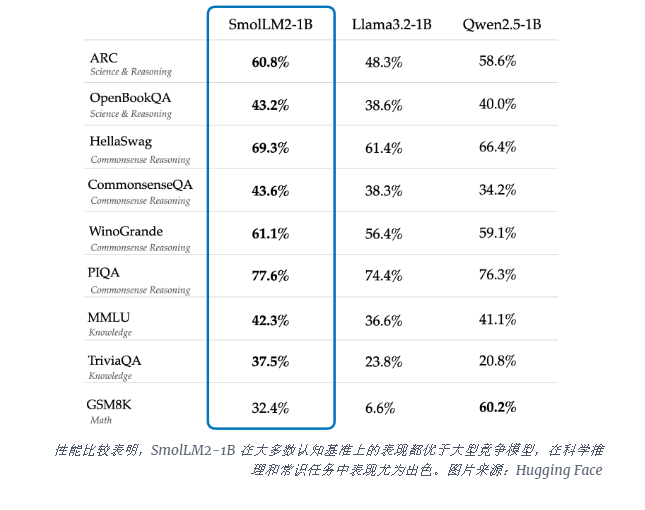

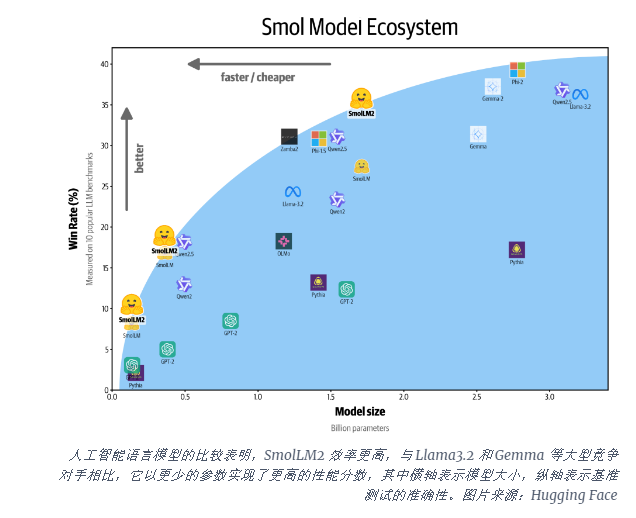

Модель SmolLM2-1B превосходит модель Llama1B компании Meta в нескольких ключевых тестах, особенно хорошо справляясь с научными рассуждениями и задачами здравого смысла. Модель превосходит крупные конкурирующие модели по большинству когнитивных тестов, используя разнообразную комбинацию наборов данных, включая FineWeb-Edu, а также специализированные наборы математических данных и данных по кодированию.

Выпуск SmolLM2 произошел в критический момент, когда индустрия искусственного интеллекта сталкивается с вычислительными потребностями при запуске больших языковых моделей (LLM). В то время как такие компании, как OpenAI и Anthropic, продолжают расширять границы масштаба моделей, растет признание необходимости в эффективном и легком ИИ, который может работать на устройстве изначально.

SmolLM2 предлагает другой подход к внедрению мощных возможностей искусственного интеллекта непосредственно в персональные устройства, указывая на будущее, в котором передовые инструменты искусственного интеллекта будут доступны большему количеству пользователей и компаний, а не только технологическим гигантам с огромными центрами обработки данных. Эти модели поддерживают ряд приложений, включая переписывание текста, суммирование и вызов функций, и подходят для развертывания в сценариях, где ограничения конфиденциальности, задержки или подключения делают облачные решения ИИ непрактичными.

Хотя эти меньшие модели по-прежнему имеют ограничения, они представляют собой часть более широкой тенденции к более эффективным моделям ИИ. Выпуск SmolLM2 показывает, что будущее искусственного интеллекта может принадлежать не только все более крупным моделям, но и более эффективным архитектурам, которые могут обеспечить высокую производительность с меньшими ресурсами.

Появление SmolLM2 открывает новые возможности для разработки легких приложений искусственного интеллекта, а также указывает на то, что технология искусственного интеллекта станет более популярной и принесет пользу большему количеству пользователей. Редактор Downcodes считает, что в будущем появятся более эффективные и экономичные модели искусственного интеллекта, которые будут способствовать развитию технологий искусственного интеллекта.