Быстрое развитие генеративного ИИ принесло удобство, но также привело к проблеме распространения ложной информации. Чтобы решить эту проблему, Microsoft запустила новый инструмент под названием «Коррекция», который предназначен для исправления дезинформации в контенте, созданном ИИ. Редактор Downcodes поможет вам глубже понять принципы, применение и проблемы этого инструмента.

Сегодня, с быстрым развитием искусственного интеллекта, хотя генеративный ИИ принес много удобств, генерируемая им ложная информация также стала проблемой, которую нельзя игнорировать. В ответ на эту проблему технологический гигант Microsoft недавно запустил новый инструмент под названием «Коррекция», который предназначен для исправления ложной информации в контенте, созданном искусственным интеллектом.

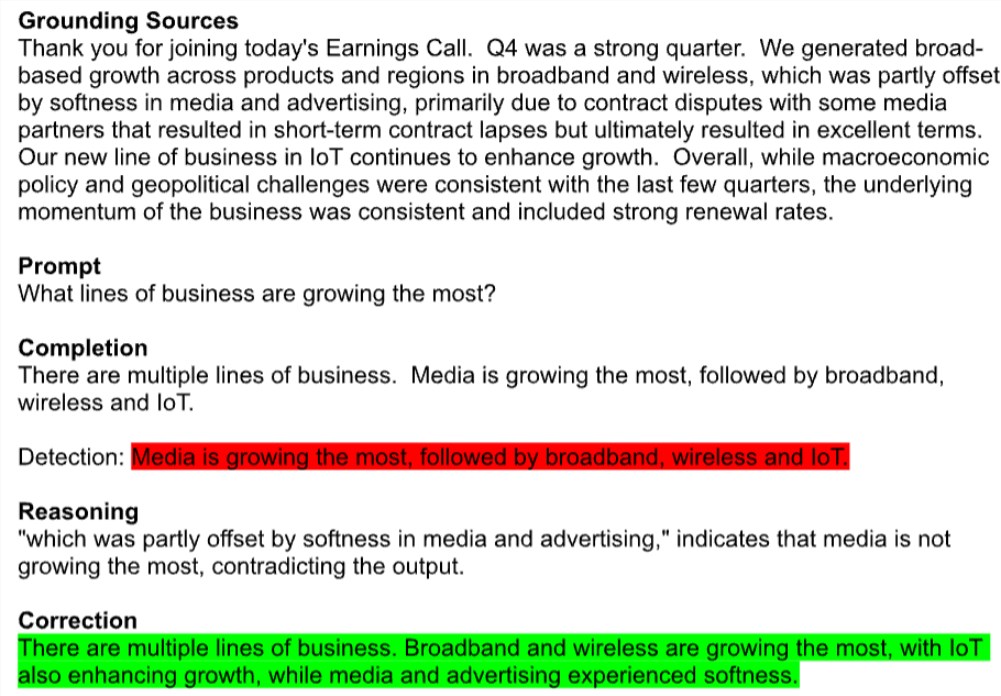

В настоящее время исправление находится в предварительной версии в рамках API Microsoft Azure AI Content Security. Инструмент автоматически отмечает потенциально ошибочный текст, например неверно цитируемые отчеты о квартальных доходах компании, и сравнивает его с заслуживающими доверия источниками для исправления этих ошибок. Примечательно, что эта технология работает во всех моделях искусственного интеллекта для генерации текста, включая Llama от Meta и GPT-4 от OpenAI.

Представитель Microsoft заявил, что «Коррекция» гарантирует, что сгенерированный контент соответствует реальным документам, комбинируя небольшие языковые модели с большими языковыми моделями. Они надеются, что эта новая функция поможет разработчикам в таких областях, как медицина, повысить точность реагирования.

Однако эксперты осторожны. Ос Кейс, докторант Вашингтонского университета, считает, что попытка устранить иллюзию создания искусственного интеллекта подобна попытке удалить водород из воды, что является фундаментальной частью работы технологии. Фактически, модели генерации текста выдают ложную информацию, поскольку на самом деле они ничего не знают и просто делают предположения на основе обучающего набора. Одно исследование показало, что ChatGPT OpenAI имеет частоту ошибок до 50% при ответах на медицинские вопросы.

Решение Microsoft состоит в том, чтобы идентифицировать и исправить эту ложную информацию с помощью пары метамоделей редактирования с перекрестными ссылками. Модель классификации ищет возможные ошибки, вымышленные или нерелевантные фрагменты текста, и если они обнаружены, вводится модель второго языка, чтобы попытаться исправить ее на основе конкретного базового документа.

Хотя Microsoft утверждает, что исправление может значительно повысить надежность и достоверность контента, созданного ИИ, у экспертов все еще есть сомнения. Майк Кук, исследователь из Университета Королевы Марии, отметил, что даже если коррекция работает так, как рекламируется, она может усугубить проблемы доверия и объяснимости в ИИ. Сервис может вызвать у пользователей ложное чувство безопасности, заставляя их поверить, что модель более точна, чем есть на самом деле.

Стоит отметить, что Microsoft также имела скрытые бизнес-расчеты при запуске «Коррекции». Хотя сама функция бесплатна, существует ежемесячный лимит на использование базовых возможностей обнаружения документов, необходимых для обнаружения дезинформации, а за любое дополнительное использование взимается плата.

Microsoft явно находится под давлением необходимости доказать ценность своих инвестиций в искусственный интеллект. Во втором квартале этого года компания потратила почти 19 миллиардов долларов на капитальные затраты и оборудование, связанные с ИИ, но пока получила скромный доход от ИИ. Недавно некоторые аналитики с Уолл-стрит понизили рейтинг акций Microsoft, поставив под сомнение осуществимость ее долгосрочной стратегии в области искусственного интеллекта.

Потенциальный риск точности и дезинформации стал одной из самых больших проблем для бизнеса при пилотировании инструментов искусственного интеллекта. Кук пришел к выводу, что если бы это был нормальный жизненный цикл продукта, генеративный ИИ все еще должен находиться на стадии академических исследований и разработок, чтобы продолжать улучшать и понимать свои сильные и слабые стороны. Однако мы внедрили его во многих отраслях.

Инструмент Microsoft Correction, несомненно, является попыткой решить проблему дезинформации ИИ, но сможет ли он действительно преодолеть кризис доверия к генеративному ИИ, еще неизвестно. Хотя технологии искусственного интеллекта быстро развиваются, вопрос о том, как сбалансировать инновации и риски, станет важной проблемой, стоящей перед всей отраслью.

В целом, появление инструмента Microsoft Correction отмечает растущее внимание отрасли к проблеме ложной информации ИИ, но также заставляет задуматься о надежности и бизнес-модели ИИ. В будущем, как лучше использовать технологию искусственного интеллекта, эффективно контролируя при этом ее риски, станет серьезной проблемой, стоящей перед каждым.