Способность к рассуждению больших языковых моделей (LLM) является горячей точкой исследований в области искусственного интеллекта. Исследовательская группа Apple по искусственному интеллекту недавно опубликовала статью, в которой раскрываются ограничения программ LLM в математических рассуждениях. Редактор Downcodes интерпретирует основное содержание статьи и анализирует ее влияние на развитие технологий искусственного интеллекта.

В мире искусственного интеллекта рассуждения моделей машинного обучения, особенно моделей больших языков (LLM), всегда были в центре внимания ученых.

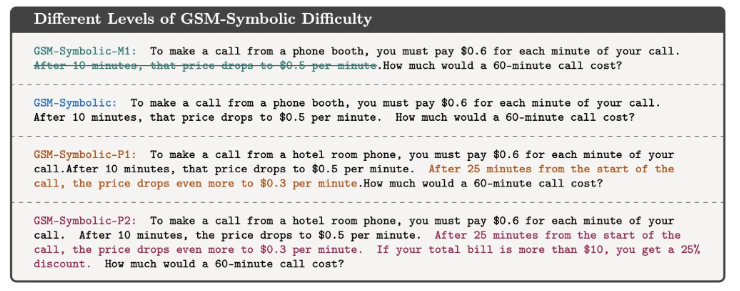

Недавно исследовательская группа Apple по искусственному интеллекту опубликовала статью под названием «Понимание ограничений больших языковых моделей в математических рассуждениях», в которой были раскрыты ограничения этих моделей при решении логических задач.

В статье исследователи демонстрируют это с помощью простой математической задачи. Сначала они задали вопрос об Оливере, собирающем киви:

Как показано ниже:

В пятницу Оливер собрал 44 киви. В субботу он собрал еще 58 плодов киви. В воскресенье он собрал вдвое больше киви, чем в пятницу. Сколько всего киви у Оливера?

Очевидно, что ответ 44+58+(44*2)=190. Хотя большие языковые модели на самом деле не являются математически совершенными, они могут достаточно надежно решать подобные проблемы.

Но если вы добавите некоторую ненужную информацию для наблюдения за реакцией модели, например:

В пятницу Оливер собрал 44 киви. В субботу он выбрал еще 58. В воскресенье он собрал вдвое больше киви, чем в пятницу, но пять из них были чуть меньше среднего размера. Сколько киви у Оливера?

Хотя это не меняет математической природы проблемы, даже самые современные LLM дают неправильные ответы при этом небольшом возмущении. Например, GPT-o1-mini неправильно вычел 5 маленьких киви из общего количества киви, собранных в воскресенье.

Этот эксперимент показывает, что хотя LLM и могут дать правильный ответ в некоторых случаях, они не совсем понимают природу проблемы.

Исследователи полагают, что характер сбоев этих моделей указывает на то, что они не выполняют истинные логические рассуждения, а повторяют этапы рассуждения, которые они наблюдали в обучающих данных. Это похоже на то, как выпускник магистратуры может посчитать, что за словами «Я люблю тебя» обычно следует «Я тоже тебя люблю», но это не значит, что он действительно понимает значение любви.

Мехрдад Фараджтабар, один из соавторов статьи, подробно объяснил выводы в социальных сетях. Он отмечает, что, хотя в некоторых простых случаях можно улучшить производительность модели за счет более качественной разработки подсказок, для сложных возмущений модели может потребоваться больше контекстных данных для правильной обработки, и эти возмущения могут быть вообще невозможны для маленького ребенка. . Не проблема.

Это исследование напоминает нам, что, хотя студенты LLM преуспевают в языковой обработке, их способности к логическому рассуждению все еще ограничены. Это не просто академический вопрос. Поскольку технология искусственного интеллекта становится все более важной частью нашей повседневной жизни, ответы на эти вопросы становятся все более важными.

Мы не можем просто предполагать, что ИИ может понимать и выполнять сложные задачи, но должны иметь более глубокое понимание того, как они работают и их ограничения. Это исследование дает нам более глубокое понимание технологий искусственного интеллекта, а также дает ценную информацию о том, как мы используем и развиваем эти технологии.

Ссылка: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-тривиальные-changes/

В целом, исследование команды Apple подчеркивает ограничения больших языковых моделей в логических рассуждениях, напоминая нам, что нам нужно быть осторожными в отношении возможностей ИИ и продолжать обращать внимание на направление его развития, чтобы избежать чрезмерной зависимости от его возможностей. В будущем нам необходимо более глубоко изучить, как улучшить рассуждения LLM, чтобы они могли по-настоящему понять суть проблемы, а не просто имитировать существующие шаблоны.