Шанхайская лаборатория искусственного интеллекта представила последнюю версию модели серии Scholar Puyu, InternLM2.5, на главном форуме WAIC Science Frontier 4 июля 2024 года. Возможности этой версии для рассуждения в сложных сценариях были значительно улучшены, она поддерживает сверхдлинный контекст 1M и может самостоятельно осуществлять поиск в Интернете и интеграцию информации, что является большим прорывом. Редактор Downcodes подробно объяснит функции и информацию об открытом исходном коде InternLM2.5.

Шанхайская лаборатория искусственного интеллекта представила новую версию модели серии Scholar Puyu, InternLM2.5, на главном форуме WAIC Science Frontier 4 июля 2024 года. Возможности этой версии для рассуждения в сложных сценариях были полностью расширены, она поддерживает сверхдлинный контекст 1M и может самостоятельно выполнять поиск в Интернете и интегрировать информацию с сотен веб-страниц.

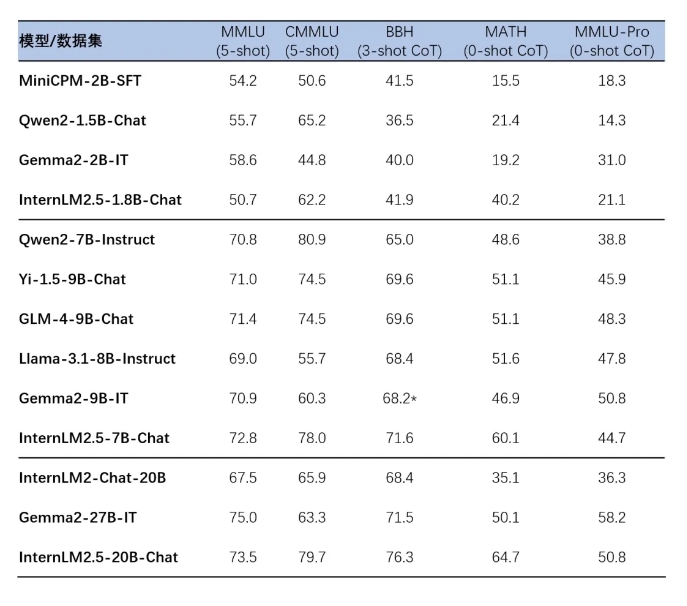

InternLM2.5 выпустил три версии модели с параметрами, а именно 1.8B, 7B и 20B, для адаптации к различным сценариям применения и потребностям разработчиков. Версия 1.8B представляет собой сверхлегкую модель, а версия 20B обеспечивает более высокую производительность и поддерживает более сложные практические сценарии. Все эти модели имеют открытый исходный код, и их можно найти на домашней странице больших моделей серии Scholar·Puyu, домашней странице ModelScope и домашней странице Hugging Face.

InternLM2.5 использует несколько технологий синтеза данных, значительно улучшая возможности рассуждения модели. В частности, точность набора математических оценок MATH достигла 64,7%. Кроме того, модель улучшает возможности обработки длины контекста за счет эффективного обучения на этапе предварительного обучения.

Модели серии InternLM2.5 также обеспечивают плавную интеграцию с последующими платформами вывода и тонкой настройки, включая среду тонкой настройки XTuner и структуру вывода LMDeploy, независимо разработанные Шанхайской лабораторией искусственного интеллекта, а также другие платформы с обширной базой пользователей в сообщество, такое как vLLM и Ollama и llama.cpp. Инструмент SWIFT, запущенный сообществом Moda, также поддерживает вывод, тонкую настройку и развертывание моделей серии InternLM2.5.

Опыт применения этих моделей включает в себя многоэтапное сложное рассуждение, точное понимание намерений многоходового разговора, гибкие операции управления форматом и способность следовать сложным инструкциям. Предоставляются подробные руководства по установке и использованию, которые помогут разработчикам быстро приступить к работе.

Домашняя страница большой модели серии Scholar·Puyu:

https://internlm.intern-ai.org.cn

Домашняя страница ModelScope:

https://www.modelscope.cn/organization/Shanghai_AI_Laboratory?tab=model

Домашняя страница «Обнимающее лицо»:

https://huggingface.co/internlm

Ссылка на открытый исходный код InternLM2.5:

https://github.com/InternLM/InternLM

Выпуск InternLM2.5 с открытым исходным кодом открывает новые возможности для исследований и приложений в области искусственного интеллекта. Считается, что его высокая производительность и простота использования привлекут многих разработчиков к исследованиям и инновациям. Редактор Downcodes с нетерпением ждет новых отличных приложений на базе InternLM2.5!