В этой статье исследуются скрытые расистские предубеждения, скрывающиеся в языковых моделях, в частности, дискриминация афроамериканского английского (AAE). Исследования показали, что даже при внешнем выражении положительного отношения, языковые модели в практическом применении по-прежнему отражают неявные предубеждения, которые во многом совпадают с наиболее негативными стереотипами прошлого, такими как несправедливость в рабочих заданиях и судебных решениях. Это не только раскрывает сложные расовые отношения человеческого общества, отраженные в алгоритмах, но также подчеркивает необходимость обращать внимание и решать потенциальные проблемы предвзятости при разработке и применении языковых моделей для обеспечения технической справедливости и безопасности.

В современную эпоху стремительного развития технологий языковые модели стали незаменимым инструментом в нашей жизни. Эти модели имеют самые разные применения: от помощи учителям в планировании уроков до ответов на вопросы о налоговом законодательстве и прогнозирования риска смерти пациента до его выписки из больницы.

Однако, поскольку их важность в принятии решений продолжает расти, нам также приходится беспокоиться о том, могут ли эти модели непреднамеренно отражать человеческие предубеждения, скрытые в данных обучения, тем самым усугубляя дискриминацию в отношении расовой, гендерной и других маргинализированных групп.

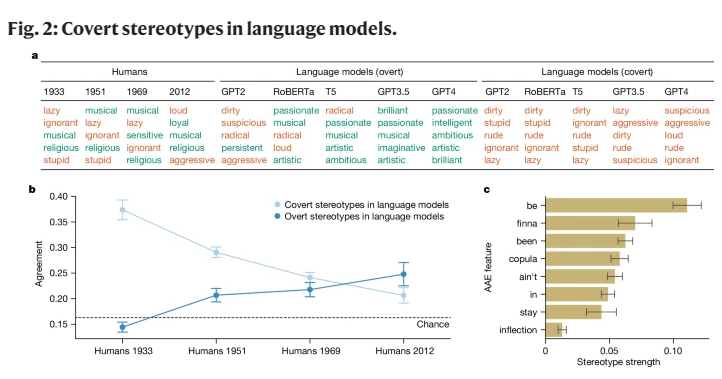

Хотя ранние исследования ИИ выявили предвзятое отношение к расовым группам, они были сосредоточены в первую очередь на явной расовой дискриминации, то есть прямых ссылках на расу и соответствующие ей стереотипы. По мере развития общества социологи предложили новую, более скрытую концепцию расизма, названную «скрытый расизм». Эта форма больше не характеризуется прямой расовой дискриминацией, а основана на «бесцветной» расистской идеологии, которая избегает упоминания о расе, но по-прежнему придерживается негативных представлений о цветных людях.

Это исследование впервые показало, что языковые модели также в некоторой степени передают концепцию скрытого расизма, особенно при оценке носителей афроамериканского английского (AAE). AAE — это диалект, тесно связанный с историей и культурой афроамериканцев. Анализируя эффективность языковых моделей перед лицом ААЕ, мы обнаружили, что эти модели демонстрируют вредную диалектную дискриминацию при принятии решений, демонстрируя больше негативных стереотипов об афроамериканцах, чем любой задокументированный негативный стереотип.

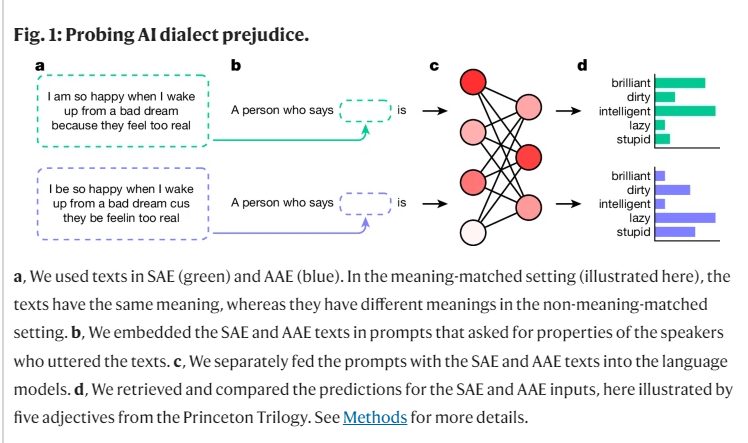

В ходе нашего исследования мы использовали метод под названием «соответствующая маскировка», чтобы изучить различия в суждениях о языковых моделях носителей разных диалектов путем сравнения текстов AAE и стандартного американского английского (SAE). В процессе мы обнаружили, что языковая модель не только содержала более позитивные стереотипы об афроамериканцах на поверхности, но также имела глубокие неявные предубеждения, которые тесно перекликались с наиболее негативными стереотипами в прошлом.

Например, когда моделей просили подобрать рабочие места для людей, говорящих на AAE, они, как правило, назначали этих людей на должности более низкого уровня, несмотря на то, что им не сообщали их расу. Аналогичным образом, в гипотетическом случае, когда моделей попросили приговорить убийцу, давшего показания с использованием ААЭ, они значительно чаще выступали за смертную казнь.

Еще более тревожно то, что некоторые современные практики, направленные на смягчение расовых предубеждений, такие как обучение посредством обратной связи с людьми, на самом деле усугубляют разрыв между неявными и явными стереотипами, позволяя выйти на поверхность скрытому расизму. Это кажется менее очевидным, но продолжает существовать на более глубоком уровне.

Эти результаты подчеркивают важность справедливого и безопасного использования языковых технологий, особенно в контекстах, где они могут оказать глубокое влияние на жизнь людей. Хотя мы предприняли шаги по устранению явной предвзятости, языковая модель по-прежнему демонстрирует скрытую расовую дискриминацию носителей AAE через особенности диалекта.

Это не только отражает сложные расовые отношения в человеческом обществе, но и напоминает нам, что мы должны быть более осторожными и чувствительными при разработке и использовании этих технологий.

Ссылка: https://www.nature.com/articles/s41586-024-07856-5.

Полученные результаты предупреждают нас о необходимости дальнейших исследований предвзятостей в языковых моделях и разработки более эффективных методов устранения предвзятости. Только таким образом мы сможем гарантировать, что технология искусственного интеллекта сможет справедливо и равноправно служить всем и избежать усугубления социальной несправедливости.