Команда Alibaba Tongyi Qianwen выпустила потрясающую математическую модель Qwen2-Math. Ее производительность превзошла GPT-4 в нескольких тестах производительности и даже превзошла версию модели NuminaMath с открытым исходным кодом с 72B в версии с 7B. Эта модель может не только решать математические задачи, введенные в виде текста, но и распознавать формулы на картинках и скриншотах, что делает ее мощным вспомогательным инструментом для изучения математики. Различные версии (72B, 7B и 1,5B) предоставляют варианты для разных нужд, демонстрируя высокую производительность и адаптируемость.

Команда Tongyi Qianwen из Alibaba сделала еще одну большую новость! Они только что выпустили демо-версию Qwen2Math. Эта математическая модель просто маленький монстр, даже GPT-4 попирается.

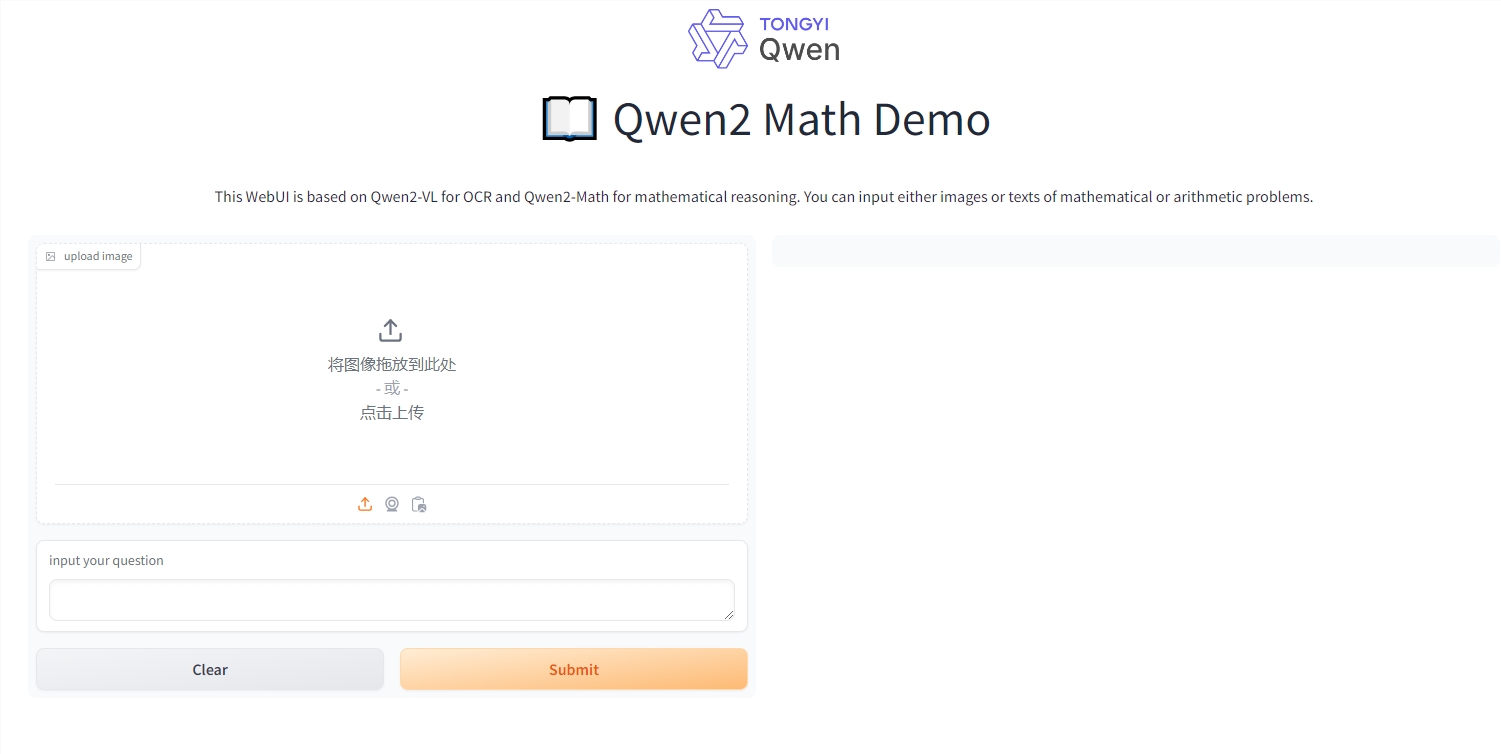

Эта модель способна не только решать математические задачи ввода текста, но и понимать формулы на картинках и скриншотах. Представьте, что вы сфотографировали расчет и он может дать вам ответ. Это просто инструмент для решения задач на уроке математики (конечно, мы не сторонники обмана).

Qwen2-Math выпущен в трех версиях: 72B, 7B и 1.5B. Среди них версия 72B является просто математическим гением. Она набрала на 7 баллов больше, чем GPT-4 в наборе данных MATH, то есть на 9,6%. Это похоже на то, как будто вы набрали 145 баллов на вступительном экзамене по математике в колледж, но лучший ученик рядом с вами набрал только 132 балла.

Что еще более удивительно, так это то, что версия 7B использует менее одной десятой параметров, превосходя математическую модель 72B с открытым исходным кодом NuminaMath. Знаете, NuminaMath — это модель, получившая награду на первом в мире AIMO, и эту награду лично вручал Теренс Тао, высшая фигура в мире математики.

Линь Цзюньян, старший эксперт по алгоритмам Alibaba, взволнованно объявил, что они превратили модель Qwen2 в математического мастера. Как они это сделали? Они использовали специальное математическое дополнение для мозга — тщательно разработанный математический корпус. Это дополнение для мозга содержит большое количество высококачественных онлайн-текстов по математике, книг, кодов, экзаменационных вопросов и даже вопросов по математике, составленных с помощью модели Qwen2.

Результат? На классических наборах тестов по математике, таких как GSM8K и MATH, Qwen2-Math-72B оставил позади 405B Llama-3.1. Эти наборы тестов — не шутка. Они содержат различные математические задачи, такие как алгебра, геометрия, теория вероятностей и теория чисел.

Мало того, Qwen2-Math также бросил вызов китайскому набору данных CMATH и вопросам вступительных экзаменов в колледж. На китайском наборе данных даже версия 1.5B может превзойти 70B Llama3.1. При этом независимо от версии, по сравнению с базовой моделью Qwen2 того же масштаба, производительность значительно улучшена.

Кажется, на этот раз Тонги Цяньвэнь действительно задал этот вопрос математическому гению! Можем ли мы задать его при решении математических задач в будущем? Но помните, это всего лишь инструмент, не обманывайтесь его интеллектом. Смущенные глаза, вам все равно нужно практиковаться? ваши математические способности!

Адрес онлайн-опыта: https://huggingface.co/spaces/Qwen/Qwen2-Math-Demo.

Появление Qwen2-Math знаменует собой значительный прогресс в крупномасштабных языковых моделях в области математики. Хотя это мощный инструмент, гораздо важнее развивать свои собственные математические способности и никогда не полагаться на инструмент и не игнорировать процесс обучения. Мы надеемся, что Qwen2-Math сможет сыграть роль в большем количестве областей в будущем, обеспечивая больше удобства для обучения и научных исследований.