Недавно выпущенная языковая модель Zyphra Zamba2-2.7B производит фурор в области малых языковых моделей. Эта модель значительно снижает требования к ресурсам вывода, сохраняя при этом производительность, сравнимую с моделью 7B, что делает ее идеальной для приложений мобильных устройств. Zamba2-2.7B значительно улучшила скорость отклика, использование памяти и задержку, что крайне важно для приложений, требующих взаимодействия в реальном времени, таких как виртуальные помощники и чат-боты. Его улучшенный механизм чередования общего внимания и проектор LoRA обеспечивают эффективную обработку сложных задач.

Недавно Zyphra выпустила новую языковую модель Zamba2-2.7B. Этот релиз имеет большое значение в истории разработки малых языковых моделей. Новая модель обеспечивает значительное улучшение производительности и эффективности: ее набор обучающих данных достигает примерно 3 триллионов токенов, что делает ее сопоставимой по производительности с Zamba1-7B и другими ведущими моделями 7B.

Самое удивительное, что требования к ресурсам Zamba2-2.7B во время вывода значительно снижены, что делает его эффективным решением для приложений мобильных устройств.

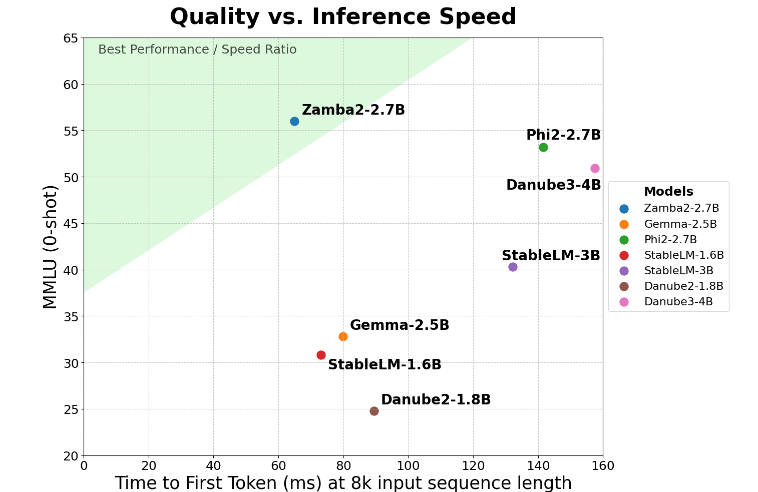

Zamba2-2.7B достигает двукратного улучшения ключевого показателя «время первого ответа», что означает, что он может генерировать первоначальные ответы быстрее, чем конкуренты. Это критически важно для таких приложений, как виртуальные помощники и чат-боты, требующие взаимодействия в реальном времени.

Помимо улучшения скорости, Zamba2-2.7B также отлично справляется с использованием памяти. Это снижает нагрузку на память на 27 %, что делает его идеальным для развертывания на устройствах с ограниченными ресурсами памяти. Такое интеллектуальное управление памятью гарантирует, что модель может эффективно работать в средах с ограниченными вычислительными ресурсами, расширяя область ее применения на различных устройствах и платформах.

Zamba2-2.7B также имеет значительное преимущество — меньшую задержку сборки. По сравнению с Phi3-3.8B у него задержка снижена в 1,29 раза, что делает взаимодействие более плавным. Низкая задержка особенно важна в приложениях, требующих бесперебойной и непрерывной связи, таких как боты обслуживания клиентов и интерактивные образовательные инструменты. Таким образом, Zamba2-2.7B, несомненно, является лучшим выбором для разработчиков с точки зрения улучшения пользовательского опыта.

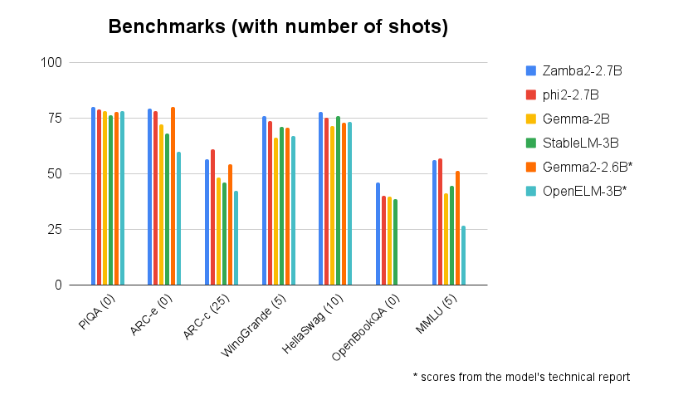

Zamba2-2.7B неизменно превосходит другие модели аналогичного размера в тестовых сравнениях. Его превосходные характеристики доказывают инновации и усилия Zyphra по содействию развитию технологий искусственного интеллекта. Эта модель использует улучшенный механизм чередования общего внимания и оснащена проектором LoRA на общем модуле MLP, чтобы обеспечить высокую производительность при обработке сложных задач.

Вход модели: https://huggingface.co/Zyphra/Zamba2-2.7B

Основные моменты:

Модель Zamba2-27B удваивает время первого отклика, что делает ее подходящей для интерактивных приложений реального времени.

? Эта модель снижает нагрузку на память на 27% и подходит для устройств с ограниченными ресурсами.

С точки зрения задержки генерации Zamba2-2.7B превосходит аналогичные модели, улучшая взаимодействие с пользователем.

Короче говоря, Zamba2-2.7B установил новый стандарт для небольших языковых моделей благодаря своей превосходной производительности и эффективности, предоставляя разработчикам более мощные и гибкие инструменты искусственного интеллекта и, как ожидается, сыграет важную роль в мобильных приложениях. Эффективное использование ресурсов и удобство работы с пользователем делают его ключевой движущей силой для разработки будущих приложений искусственного интеллекта.