Метаученый Томас Сиалом подробно объяснил процесс разработки Llama 3.1 в подкасте Latent Space и представил направление разработки Llama 4. Llama 3.1 — это не простое стекирование параметров, а компромисс между размером параметра, временем обучения и аппаратными ограничениями. Размер параметра 405B — это ответ на GPT-4o. Хотя огромный размер модели затрудняет ее работу на обычных компьютерах, функция открытого исходного кода позволяет большему количеству людей участвовать и способствовать технологическому развитию.

Рождение Llama3.1 — это идеальный баланс между масштабом параметров, временем обучения и аппаратными ограничениями. Огромный корпус 405B — это не случайный выбор, а вызов, брошенный Метой GPT-4o. Хотя аппаратные ограничения не позволяют Llama3.1 работать на каждом домашнем компьютере, мощь сообщества открытого исходного кода делает все возможным.

Во время разработки Llama 3.1 Сиалом и его команда пересмотрели закон масштабирования. Они обнаружили, что размер модели действительно имеет решающее значение, но более важным является общий объем обучающих данных. Llama3.1 решила увеличить количество обучающих жетонов, даже если это означало бы затраты большей вычислительной мощности.

В архитектуре Llama 3.1 нет кардинальных изменений, но Meta приложила большие усилия с точки зрения масштаба и качества данных. Океан токенов 15T дал Llama3.1 качественный скачок в глубину и широту знаний.

Что касается отбора данных, Scialom твердо уверен, что в общедоступном Интернете слишком много текстового мусора, а настоящее золото — это синтетические данные. В процессе постобучения Llama3.1 вообще не использовались написанные вручную ответы, а полностью полагались на синтетические данные, сгенерированные Llama2.

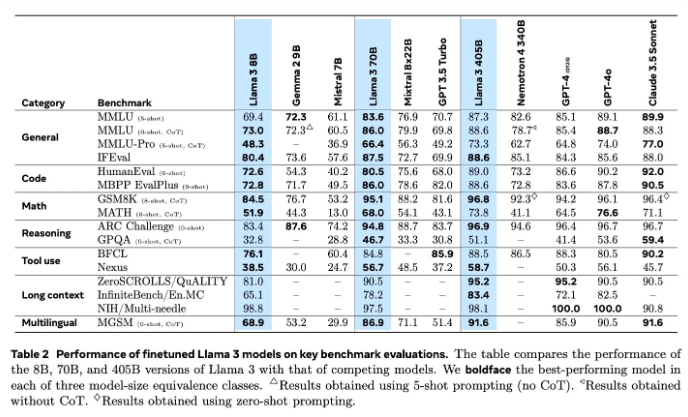

Оценка моделей всегда была сложной проблемой в сфере ИИ. В Llama3.1 было опробовано множество методов оценки и улучшения, включая модели вознаграждения и разнообразные тесты производительности. Но настоящая задача заключается в поиске правильных подсказок, которые смогут победить мощные модели.

Meta начала обучение Llama4 в июне, и на этот раз они сосредоточились на агентных технологиях. Разработка агентских инструментов, таких как Toolformer, знаменует собой новое исследование Meta в области искусственного интеллекта.

Открытый исходный код Llama3.1 — это не только смелая попытка Meta, но и глубокие размышления о будущем ИИ. С запуском Llama4 у нас есть основания полагать, что Meta продолжит лидировать в области искусственного интеллекта. Давайте с нетерпением ждем, как Llama4 и агентные технологии изменят будущее искусственного интеллекта.

Благодаря глубокому пониманию процесса исследований и разработок Llama 3.1 мы можем видеть постоянные инновации и усилия Meta в области крупномасштабных языковых моделей, а также ее упор на сообщество открытого исходного кода. Направление исследований и разработок Llama 4 также указывает на будущую тенденцию развития технологий искусственного интеллекта, которую стоит подождать и посмотреть. Давайте посмотрим, как технология искусственного интеллекта будет развиваться в будущем.