Что произошло бы, если бы ИИ переобучился с помощью сгенерированных им изображений Недавно исследователи из Стэнфордского университета и Калифорнийского университета в Беркли провели такой эксперимент, и результаты оказались удивительными.

Исследователи обнаружили, что когда модели искусственного интеллекта, генерирующие изображения, были переобучены для использования изображений, которые они генерировали сами, модели создавали сильно искаженные изображения. Хуже того, это искажение не ограничивается текстовыми репликами, используемыми для переобучения. Если модель «загрязнена», ее трудно полностью восстановить, даже если позже она будет переобучена только с использованием реальных изображений.

Отправной точкой эксперимента является модель с открытым исходным кодом под названием Stable Diffusion (SD). Исследователи сначала выбрали 70 000 высококачественных изображений лиц из набора данных лиц FFHQ и автоматически классифицировали их. Затем они использовали эти реальные изображения в качестве входных данных для создания 900 изображений, соответствующих характеристикам конкретной группы людей, с помощью модели стабильной диффузии.

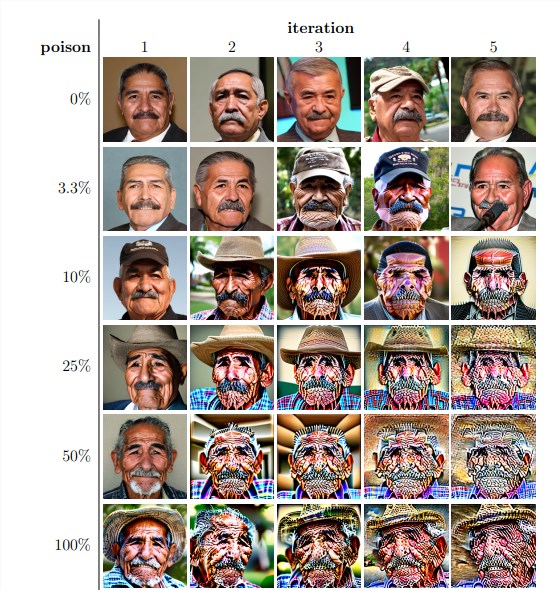

Затем исследователи использовали эти сгенерированные изображения для итеративного переобучения модели. Они обнаружили, что независимо от доли самостоятельно сгенерированных изображений в наборе данных переобучения, модель в конечном итоге разрушилась, и качество сгенерированных изображений резко упало. Даже когда данные переобучения содержат только 3% самостоятельно сгенерированных изображений, явление коллапса модели все еще существует.

Результаты экспериментов показывают, что базовая версия модели Stable Diffusion генерирует изображения, соответствующие текстовым подсказкам и имеющие высокое визуальное качество. Но по мере итеративной переобучения модели сгенерированные изображения начали проявлять семантические несоответствия и визуальные искажения. Исследователи также обнаружили, что коллапс модели не только повлиял на качество изображения, но и привел к отсутствию разнообразия в сгенерированных изображениях.

Чтобы убедиться в этом, исследователи также провели контролируемые эксперименты, чтобы попытаться смягчить последствия коллапса модели путем корректировки цветовой гистограммы сгенерированных изображений и удаления изображений низкого качества. Но результаты показывают, что эти меры не эффективны для предотвращения краха модели.

Исследователи также выяснили, возможно ли восстановление модели путем переобучения после «загрязнения». Они обнаружили, что хотя в некоторых случаях качество полученных изображений восстанавливалось после нескольких итераций переобучения, признаки разрушения модели оставались. Это показывает, что если модель «загрязнена», последствия могут быть долгосрочными или даже необратимыми.

Это исследование раскрывает важную проблему: популярные в настоящее время системы искусственного интеллекта для генерации текста в изображения на основе диффузии очень чувствительны к «загрязнению» данных. Это «загрязнение» может произойти непреднамеренно, например, в результате неразборчивого извлечения изображений из онлайн-источников. Это также может быть целенаправленная атака, например намеренное размещение «испорченных» данных на веб-сайте.

Столкнувшись с этими проблемами, исследователи предложили некоторые возможные решения, такие как использование детекторов подлинности изображений для исключения изображений, сгенерированных ИИ, или добавление водяных знаков к сгенерированным изображениям. Хотя эти методы несовершенны, в совокупности эти методы могут значительно снизить риск «загрязнения» данных.

Это исследование напоминает нам, что развитие технологий искусственного интеллекта не лишено рисков. Нам нужно быть более осторожными с контентом, созданным ИИ, чтобы гарантировать, что он не окажет долгосрочного негативного воздействия на наши модели и наборы данных. Будущие исследования должны продолжить изучение того, как сделать системы искусственного интеллекта более устойчивыми к такому типу «загрязнения» данных или разработать методы, которые могут ускорить «исцеление» моделей.