После того, как Meta выпустила Llama 3.1, Mistral AI выпустила свою флагманскую модель Mistral Large 2 с объемом параметров 123 миллиарда, контекстным окном ошеломляющих 128 тысяч и производительностью, сравнимой с Llama 3.1. Модель поддерживает несколько языков и языков программирования, предназначена для одноузлового вывода, эффективна и экономична. В этой статье будут подробно рассмотрены различные показатели производительности Mistral Large 2, методы использования и его отличные характеристики при многоязычной обработке, понимании кода и следовании инструкциям, а также проанализирован его потенциал в коммерческих приложениях и областях исследований.

После вчерашнего объявления Meta о выпуске самой сильной модели с открытым исходным кодом Llama3.1, Mistral AI сегодня рано утром торжественно представила свою флагманскую модель Mistral Large2. Этот новый продукт имеет 123 миллиарда параметров и большое контекстное окно в 128 тысяч. В этом отношении это выглядит так. сравнимо с Ламой3.1.

Подробности о модели Mistral Large2

Mistral Large2 имеет контекстное окно размером 128 тыс. и поддерживает десятки языков, включая французский, немецкий, испанский, итальянский, португальский, арабский, хинди, русский, китайский, японский и корейский, а также Python, Java, C, C++, более 80 языков программирования, включая JavaScript и Bash.

Mistral Large2 предназначен для вывода на одном узле и ориентирован на приложения с длинным контекстом: размер его параметров в 123 миллиарда позволяет ему работать с высокой пропускной способностью на одном узле. Mistral Large2 выпускается под лицензией Mistral Research License и предназначен для исследовательского и некоммерческого использования. При наличии коммерческой необходимости пользователям необходимо связаться для получения коммерческой лицензии;

Общая производительность:

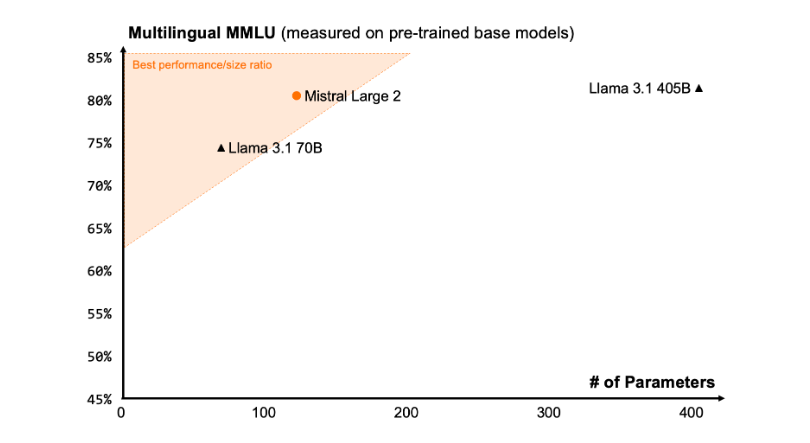

Что касается производительности, Mistral Large2 установила новый эталон показателей оценки, в частности достигнув точности 84,0% в эталонном тесте MMLU, продемонстрировав сильный баланс между производительностью и стоимостью обслуживания.

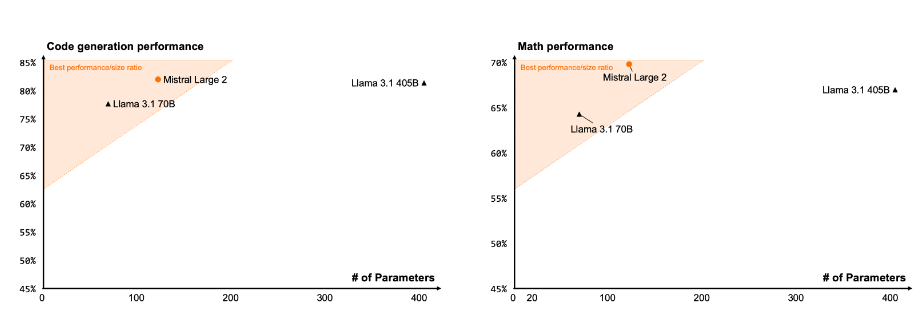

Кодекс и рассуждения

Благодаря опыту обучения Codestral22B и Codestral Mamba, Mistral Large2 демонстрирует хорошие результаты в обработке кода, даже сравнимые с такими ведущими моделями, как GPT-4o, Claude3Opus и Llama3405B.

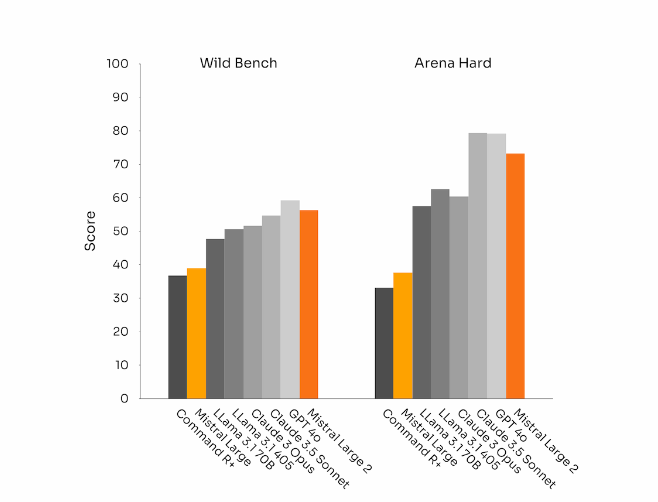

Соблюдение инструкций и согласованность

Mistral Large 2 также добился значительного прогресса в возможностях отслеживания команд и диалога, особенно при более гибкой обработке сложных многоходовых диалогов. В некоторых тестах более длинные ответы имеют тенденцию улучшать результаты. Однако во многих коммерческих приложениях простота имеет решающее значение: более короткое создание модели помогает ускорить взаимодействие и делает вывод более экономичным.

языковое разнообразие

Новый Mistral Large2 обучен работе с большими объемами многоязычных данных, в частности на английском, французском, немецком, испанском, итальянском, португальском, голландском, русском, китайском, японском, корейском, арабском и хинди. Отличная производительность. Ниже приведены результаты производительности Mistral Large2 в многоязычном тесте MMLU по сравнению с предыдущими моделями Mistral Large, Llama3.1 и Cohere's Command R+.

Использование инструментов и вызовы функций

Mistral Large2 оснащен расширенными возможностями вызова и извлечения функций и обучен умело выполнять параллельные и последовательные вызовы функций, что позволяет ему служить мощной основой для сложных бизнес-приложений.

Как использовать:

В настоящее время пользователи могут использовать Mistral Large2 под именем mistral-large-2407 a la Plateforme (https://console.mistral.ai/) и протестировать его в le Chat. Он доступен в версии 24.07 (система контроля версий YY.MM, которую мы применяем ко всем моделям) и под названием API mistral-large-2407 . Веса для модели инструкций доступны и также размещены на HuggingFace (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407).

Продукция La Plateforme включает две универсальные модели — Mistral Nemo и Mistral Large, а также две профессиональные модели — Codestral и Embed. Поскольку мы постепенно отказываемся от старых моделей на La Plateforme, все модели Apache (Mistral7B, Mixtral8x7B и 8x22B, Codestral Mamba, Mathstral) по-прежнему можно развертывать и настраивать с помощью SDK mistral-inference и mistral-finetune.

С сегодняшнего дня в продукте будут расширены возможности тонкой настройки по типу Plateforme: эти возможности теперь доступны для Mistral Large, Mistral Nemo и Codestral.

Mistral AI также заключила партнерские отношения с несколькими ведущими поставщиками облачных услуг, чтобы сделать Mistral Large2 доступным по всему миру, в частности, в Vertex AI на Google Cloud Platform.

** Основные моменты: **

Mistral Large2 имеет 128 тысяч контекстных окон и поддерживает до десяти языков и более 80 языков программирования.

Достижение точности 84,0 % в эталонном тесте MMLU при превосходных характеристиках и стоимости.

«Пользователи могут получить доступ к новым моделям через La Plateforme, и они широко используются на платформах облачных сервисов.

В целом, Mistral Large 2 продемонстрировал сильную конкурентоспособность в области больших языковых моделей благодаря своей высокой производительности, обширной языковой поддержке и удобному использованию, предоставляя новые возможности для исследований и коммерческих приложений. Открытый исходный код также способствует инновационному развитию в области искусственного интеллекта.