Команда Alibaba Qwen выпустила новый тест под названием «PROCESSBENCH», целью которого является более полная оценка способности языковых моделей к математическим рассуждениям, уделяя особое внимание способности модели выявлять ошибки процесса. Существующие тесты имеют ограничения, например, они слишком упрощены для моделей высокого уровня или обеспечивают только двоичную оценку корректности без подробного анализа ошибок. Появление «PROCESSBENCH» восполняет этот пробел и предоставляет новый инструмент для более глубокого понимания и улучшения механизма рассуждения языковых моделей.

Недавно исследователи из команды Qwen компании Alibaba запустили новый тест под названием «PROCESSBENCH», который предназначен для измерения способности языковых моделей выявлять ошибки процесса в математических рассуждениях. Поскольку языковые модели добились значительного прогресса в решении сложных задач рассуждения, исследователи в этой области обнаружили, что, несмотря на их отличную производительность, они все еще сталкиваются с проблемами при решении некоторых сложных задач. Поэтому особенно важно разработать эффективный метод надзора.

Текущие критерии оценки языковых моделей имеют некоторые недостатки. С одной стороны, некоторые наборы задач становятся слишком простыми для расширенных моделей, а с другой стороны, существующие методы оценки часто обеспечивают только двоичные оценки корректности без подробных аннотаций ошибок. Это явление подчеркивает острую необходимость в более комплексных системах оценки для более глубокого изучения механизмов вывода сложных языковых моделей.

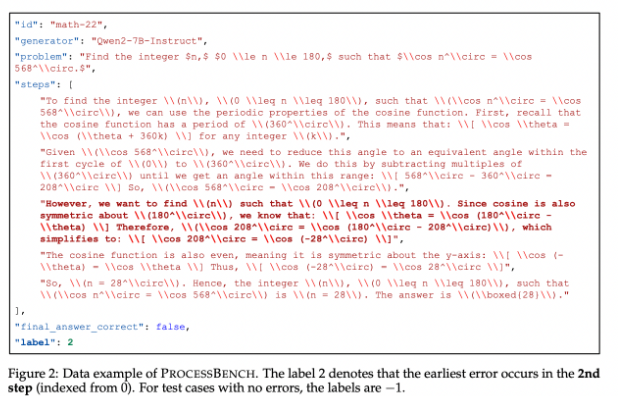

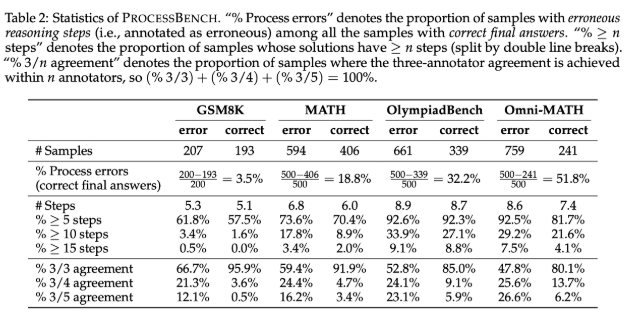

Чтобы восполнить этот пробел, исследователи разработали PROCESSBENCH — тест, направленный на выявление ошибочных шагов в математических рассуждениях. Его принципы проектирования включают сложность проблемы, разнообразие решений и всестороннюю оценку. Тест нацелен на математические задачи соревновательного и олимпиадного уровня, используя несколько языковых моделей с открытым исходным кодом для генерации решений, демонстрирующих различные подходы к решению задач. PROCESSBENCH содержит в общей сложности 3400 тестовых примеров, которые были тщательно аннотированы несколькими экспертами для обеспечения качества данных и надежности оценки.

В ходе разработки исследовательская группа собрала математические задачи из четырех известных наборов данных (GSM8K, MATH, OlympiadBench и Omni-MATH), гарантируя, что будет охвачен широкий диапазон трудностей — от начальной школы до соревновательного уровня. Они использовали модели с открытым исходным кодом для создания до 12 различных решений для увеличения разнообразия решений. Кроме того, чтобы унифицировать формат шагов решения, команда приняла метод переформатирования, обеспечивающий логически завершенное пошаговое рассуждение.

Результаты исследований показывают, что существующие модели вознаграждения процессов плохо работают при решении сложных проблем, особенно при работе с более простыми наборами задач, а модель принятия решений, основанная на подсказках, работает более заметно. Исследование выявляет ограничения существующих моделей в оценке математических рассуждений, особенно когда модель достигает правильного ответа с помощью неправильных промежуточных шагов, что затрудняет точную оценку.

Являясь новаторским эталоном для оценки способности языковых моделей выявлять ошибки математических рассуждений, PROCESSBENCH обеспечивает важную основу для будущих исследований и способствует пониманию и совершенствованию ИИ в процессе рассуждения.

Вход для бумаги: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file.

Код: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

В целом, запуск теста PROCESSBENCH предоставляет более комплексный и углубленный инструмент для оценки способности языковых моделей к математическому мышлению, помогая способствовать развитию исследований в этой области и, в конечном итоге, улучшать производительность языковых моделей в сложных задачах рассуждения.