Google официально выпустила TPU шестого поколения Trillium и открыла его для клиентов Google Cloud. Trillium — это самый мощный TPU Google на сегодняшний день, который используется для обучения Gemini 2.0, самой мощной модели искусственного интеллекта. Это значительно повышает производительность обучения, производительность вывода, энергоэффективность и позволяет снизить затраты. В этой статье будут подробно рассмотрены улучшения производительности, ключевые функции и выдающаяся производительность Trillium TPU в различных рабочих нагрузках искусственного интеллекта, а также продемонстрированы примеры его практического применения среди таких клиентов, как AI21Labs.

Ранее в этом году Google выпустила Trillium, шестое поколение и самый мощный на сегодняшний день TPU. Сегодня Trillium официально доступен клиентам Google Cloud.

Google использовала Trillium TPU для обучения новейшей модели Gemini2.0, которая на сегодняшний день является самой мощной моделью искусственного интеллекта Google. Теперь как предприятия, так и стартапы могут воспользоваться одной и той же надежной, эффективной и устойчивой инфраструктурой.

Ядро суперкомпьютера AI: Trillium TPU

Trillium TPU — ключевой компонент гиперкомпьютера Google Cloud AI. Гиперкомпьютер с искусственным интеллектом — это революционная архитектура суперкомпьютера, в которой используются оптимизированное по производительности оборудование, открытое программное обеспечение, ведущие платформы машинного обучения и гибкие системы интеграции моделей потребления. С официальным запуском Trillium TPU Google также внесла ключевые улучшения в уровень открытого программного обеспечения гиперкомпьютера искусственного интеллекта, включая оптимизацию компилятора XLA и популярных платформ, таких как JAX, PyTorch и TensorFlow, для достижения лучшего соотношения цены и производительности в обучении искусственного интеллекта. , тюнинг и услуги.

Кроме того, такие функции, как разгрузка хоста с использованием массивной DRAM хоста (дополнительная память с высокой пропускной способностью или HBM), обеспечивают более высокий уровень эффективности. Гиперкомпьютер с искусственным интеллектом позволяет вам извлечь максимальную выгоду из беспрецедентного развертывания более 100 000 чипов Trillium на сетевую архитектуру Jupiter с двунаправленной полосой пропускания 13 петабит/секунду и возможностью масштабировать одно распределенное задание обучения на сотни тысяч ускорителей.

Такие клиенты, как AI21Labs, уже используют Trillium для более быстрого предоставления значимых решений искусственного интеллекта своим клиентам:

Барак Ленц, технический директор AI21Labs, сказал: «В AI21 мы постоянно работаем над повышением производительности и эффективности языковых моделей Mamba и Jamba. Как давние пользователи TPU v4, мы впечатлены возможностями Google Cloud Trillium. По масштабу, скорости и стоимости. Повышение эффективности является значительным. Мы считаем, что Trillium сыграет жизненно важную роль в ускорении разработки следующего поколения сложных языковых моделей, что позволит нам предоставлять нашим клиентам более мощные и доступные решения в области искусственного интеллекта».

Показатели Trillium значительно улучшились, а многие показатели установили новые рекорды.

По сравнению с предыдущим поколением, Trillium внес существенные улучшения в:

Результативность тренировок улучшилась более чем в 4 раза

3-кратное улучшение производительности вывода

Энергоэффективность выросла на 67%

Улучшение пиковой производительности вычислений на один чип в 4,7 раза

Память с высокой пропускной способностью (HBM) удваивает емкость

Межчиповое соединение (ICI) удваивает пропускную способность

Единая сетевая архитектура Jupiter содержит 100 000 чипов Trillium.

Улучшение эффективности обучения в 2,5 раза на доллар и улучшение эффективности вывода в 1,4 раза на доллар.

Эти улучшения позволяют Trillium хорошо работать при различных рабочих нагрузках искусственного интеллекта, в том числе:

Масштабирование рабочих нагрузок по обучению ИИ

Обучайте LLM, включая плотные модели и модели «Сочетание экспертов» (MoE).

Производительность вывода и коллективное планирование

Встраивание плотных моделей

Обеспечить обучение и сделать вывод о экономической эффективности

Как Trillium работает при различных рабочих нагрузках?

Масштабирование рабочих нагрузок по обучению ИИ

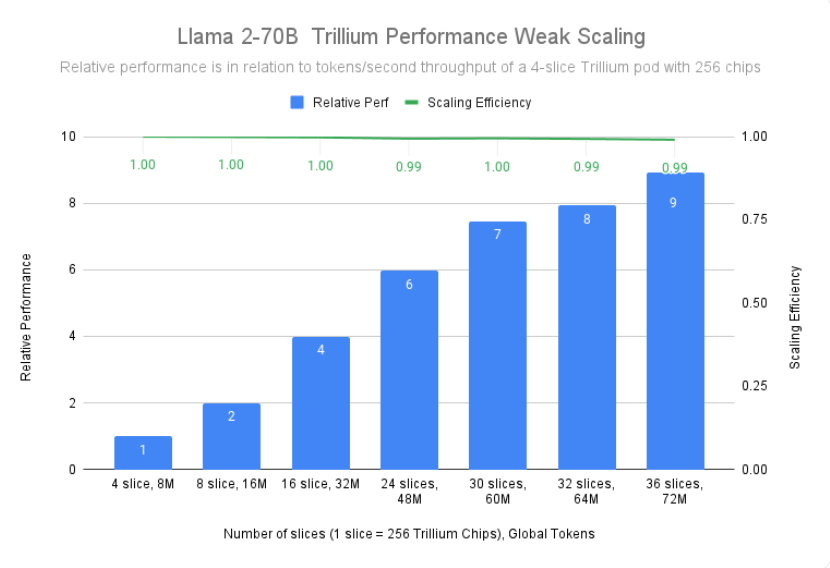

Обучение большой модели, такой как Gemini2.0, требует большого количества данных и вычислений. Почти линейная масштабируемость Trillium позволяет обучать эти модели значительно быстрее за счет эффективного и результативного распределения рабочих нагрузок между несколькими хостами Trillium, подключенными через высокоскоростные межчиповые соединения в 256-чиповых модулях и наших современных сеть дата-центров Юпитер. Это достигается за счет многочиповой полностековой технологии TPU для крупномасштабного обучения и дальнейшей оптимизации с помощью Titanium, динамической системы разгрузки на уровне центра обработки данных, которая варьируется от хост-адаптеров до сетевой архитектуры.

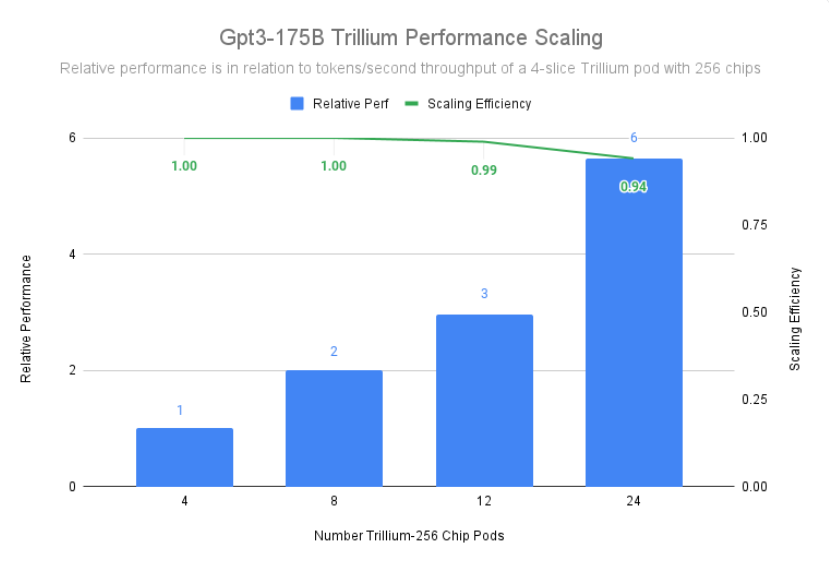

Компания Trillium достигла эффективности масштабирования 99 % при развертывании 12 модулей с 3072 чипами и продемонстрировала эффективность масштабирования 94 % в 24 модулях с 6 144 чипами для предварительного обучения gpt3-175b даже в сетях центров обработки данных.

Обучайте LLM, включая плотные модели и модели «Сочетание экспертов» (MoE).

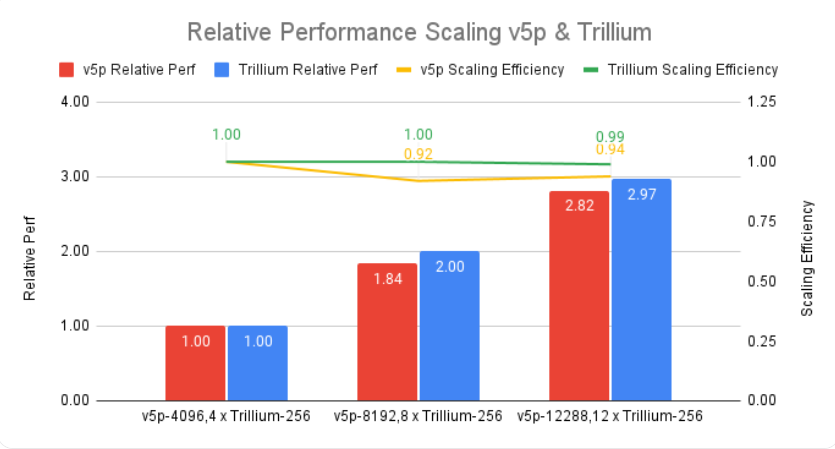

LLM, такие как Gemini, по своей сути мощные и сложные, с миллиардами параметров. Обучение такому интенсивному LLM требует огромных вычислительных мощностей, а также совместной оптимизации программного обеспечения. Trillium в 4 раза быстрее, чем Cloud TPU v5e предыдущего поколения, при обучении интенсивных LLM, таких как Llama-2-70b и gpt3-175b.

Помимо интенсивного LLM, все более популярным подходом становится обучение LLM с использованием смешанной экспертной (MoE) архитектуры, которая объединяет несколько «экспертных» нейронных сетей, каждая из которых специализируется на разных аспектах задачи ИИ. Управление и координация этих экспертов во время обучения усложняет обучение по сравнению с обучением одной монолитной модели. Trillium в 3,8 раза быстрее, чем Cloud TPU v5e предыдущего поколения, при обучении моделей MoE.

Кроме того, Trillium TPU обеспечивает в три раза больше динамической оперативной памяти (DRAM) хоста по сравнению с Cloud TPU v5e. Это перекладывает часть вычислений на хост, помогая максимизировать крупномасштабную производительность и хорошую пропускную способность. Функция разгрузки хоста Trillium обеспечивает повышение производительности более чем на 50% при использовании FLOP модели (MFU) при обучении модели Llama-3.1-405B.

Производительность вывода и коллективное планирование

Растущая важность многоэтапного вывода требует ускорителей, способных эффективно справляться с возросшими вычислительными требованиями. Trillium обеспечивает значительные улучшения для рабочих нагрузок вывода, обеспечивая более быстрое и эффективное развертывание моделей искусственного интеллекта. Фактически, Trillium обеспечивает лучшую производительность вывода TPU для диффузии изображений и плотного LLM. Наши тесты показывают, что Stable Diffusion XL имеет более чем в 3 раза большую относительную пропускную способность вывода (изображений в секунду) по сравнению с Cloud TPU v5e, а у Llama2-70B — почти в 2 раза.

Trillium — наш самый производительный TPU для сценариев использования в автономном режиме и на сервере. На рисунке ниже показано, что по сравнению с Cloud TPU v5e относительная пропускная способность Stable Diffusion XL (изображений в секунду) для автономного вывода в 3,1 раза выше, а его относительная пропускная способность для серверного вывода — в 2,9 раза выше.

Помимо повышения производительности, Trillium также предоставляет новые возможности коллективного планирования. Эта функция позволяет системе планирования Google принимать интеллектуальные решения по планированию заданий, чтобы повысить общую доступность и эффективность рабочих нагрузок вывода, когда в коллекции существует несколько реплик. Он обеспечивает способ управления несколькими слайсами TPU, выполняющими рабочие нагрузки вывода на одном или нескольких хостах, в том числе через Google Kubernetes Engine (GKE). Группировка этих предметов в коллекцию позволяет легко регулировать количество реплик в соответствии со спросом.

Встраивание плотных моделей

Добавляя SparseCore третьего поколения, Trillium повышает производительность моделей с интенсивным внедрением в 2 раза, а DLRM DCNv2 — в 5 раз.

SparseCore — это процессор потока данных, который обеспечивает более адаптируемую архитектурную основу для интенсивных встроенных рабочих нагрузок. SparseCore третьего поколения Trillium превосходно ускоряет динамические операции и операции с данными, такие как сбор разброса, суммирование разреженных сегментов и секционирование.

Обеспечить обучение и сделать вывод о экономической эффективности

Помимо высокой производительности и масштабируемости, необходимых для обучения некоторых из крупнейших в мире рабочих нагрузок искусственного интеллекта, Trillium предназначен для оптимизации производительности на доллар. На сегодняшний день Trillium добился в 2,1 раза большей производительности на доллар, чем Cloud TPU v5e, и в 2,5 раза выше, чем Cloud TPU v5p, при обучении интенсивных LLM, таких как Llama2-70b и Llama3.1-405b.

Trillium превосходно справляется с экономичной параллельной обработкой больших моделей. Он предназначен для того, чтобы позволить исследователям и разработчикам создавать мощные и эффективные модели изображений с гораздо меньшими затратами, чем раньше. Стоимость создания тысячи изображений в Trillium на 27 % ниже, чем в Cloud TPU v5e для автономного вывода и на 22 % ниже, чем в Cloud TPU v5e для серверного вывода на SDXL.

Выводим инновации в области искусственного интеллекта на новый уровень

Trillium представляет собой большой шаг вперед в инфраструктуре искусственного интеллекта Google Cloud, обеспечивая невероятную производительность, масштабируемость и эффективность для различных рабочих нагрузок искусственного интеллекта. Благодаря способности масштабироваться до сотен тысяч чипов с использованием программного обеспечения мирового класса для совместного проектирования Trillium позволяет вам быстрее достигать прорывов и предлагать превосходные решения искусственного интеллекта. Кроме того, исключительное соотношение цены и производительности Trillium делает его экономически эффективным выбором для организаций, стремящихся максимизировать отдачу от своих инвестиций в ИИ. Поскольку сфера искусственного интеллекта продолжает развиваться, Trillium демонстрирует стремление Google Cloud предоставлять передовую инфраструктуру, которая поможет предприятиям раскрыть весь потенциал искусственного интеллекта.

Официальное введение: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga.

В целом, появление Trillium TPU знаменует собой значительное улучшение возможностей облачных вычислений искусственного интеллекта. Его высокая производительность, масштабируемость и экономические преимущества будут способствовать более быстрому развитию в области искусственного интеллекта и предоставлению более мощных решений искусственного интеллекта для предприятий и исследовательских учреждений.