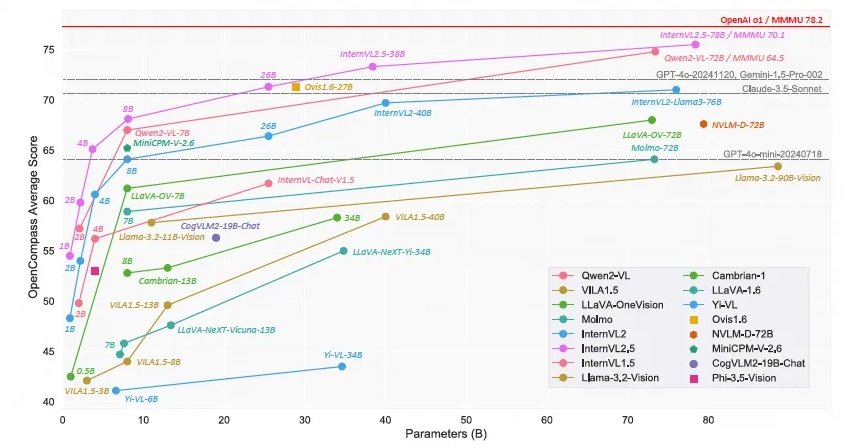

Шанхайская лаборатория искусственного интеллекта запустила мультимодальную крупномасштабную языковую модель с открытым исходным кодом — Scholar·Wanxiang InternVL2.5. Ее производительность достигла точности более 70% в тесте мультимодального понимания (MMMU), что сопоставимо с тестом мультимодального понимания (MMMU). Модели GPT-4o и Claude-Commercial, такие как 3.5-Sonnet, имеют сопоставимые характеристики. Модель InternVL2.5 использует технологию цепного мышления, чтобы продемонстрировать высокую производительность в нескольких тестах производительности, особенно в междисциплинарном рассуждении, понимании документов и обнаружении мультимодальных галлюцинаций. Открытый характер этой модели будет в значительной степени способствовать развитию и инновациям мультимодальной технологии искусственного интеллекта.

Недавно Шанхайская лаборатория искусственного интеллекта объявила о выпуске модели Scholar·Wanxiang InternVL2.5. Благодаря своей выдающейся производительности эта мультимодальная крупномасштабная языковая модель с открытым исходным кодом стала первой моделью с открытым исходным кодом, точность которой превысила 70% в тесте мультимодального понимания (MMMU), конкурируя с коммерческими моделями, такими как GPT-4o и Claude. -3,5-Сонет Сопоставимое исполнение.

Модель InternVL2.5 достигла улучшения на 3,7 процентных пункта благодаря технологии рассуждений Chain of Thinking (CoT), продемонстрировав сильный потенциал масштабируемости времени тестирования. Модель доработана на основе InternVL2.0, что еще больше повышает производительность за счет совершенствования стратегий обучения и тестирования, а также улучшения качества данных. Проводятся углубленные исследования визуальных кодировщиков, языковых моделей, размеров наборов данных и конфигураций времени тестирования, чтобы изучить взаимосвязь между размером модели и производительностью.

InternVL2.5 демонстрирует конкурентоспособную производительность в нескольких тестах, особенно в междисциплинарном рассуждении, понимании документов, понимании нескольких изображений/видео, понимании реального мира, обнаружении мультимодальных галлюцинаций, визуальном заземлении, многоязычных возможностях и обработке чистого языка. и другие поля. Это достижение не только предоставляет сообществу открытого исходного кода новый стандарт для разработки и применения мультимодальных систем искусственного интеллекта, но также открывает новые возможности для исследований и приложений в области искусственного интеллекта.

InternVL2.5 сохраняет ту же архитектуру модели, что и его предшественники InternVL1.5 и InternVL2.0, следует парадигме «ViT-MLP-LLM» и реализует интеграцию нового инкрементального предварительно обученного InternViT-6B или InternViT-300M с различными Предварительно обученные LLM разных размеров и типов объединяются вместе с помощью случайно инициализированных двухслойных проекторов MLP. Чтобы повысить масштабируемость обработки высокого разрешения, исследовательская группа применила операцию перемешивания пикселей, чтобы уменьшить количество визуальных токенов до половины исходного числа.

Характер модели с открытым исходным кодом означает, что исследователи и разработчики могут свободно получать доступ и использовать InternVL2.5, что будет значительно способствовать развитию и инновациям в области мультимодальных технологий искусственного интеллекта.

Ссылка на модель:

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

Ожидается, что версия InternVL2.5 с открытым исходным кодом предоставляет ценные ресурсы для мультимодальных исследований в области искусственного интеллекта. Ее превосходная производительность и масштабируемость будут способствовать дальнейшим прорывам в этой области и рождению более инновационных приложений. Надеемся увидеть в будущем еще более удивительные результаты на основе InternVL2.5.