Новейшая модель открытого визуального языка NVIDIA, NVILA, добилась значительного прорыва в точности и эффективности, став еще одной вехой в области визуального ИИ. По сравнению с другими крупномасштабными моделями машинного зрения NVILA добилась значительного снижения затрат на обучение, использования памяти и задержки. Она также продемонстрировала отличную производительность в многочисленных тестах производительности, даже превзойдя некоторых конкурентов. В статье подробно представлены технические детали NVILA, включая технологию «сначала развернуть, а затем сжать», а также динамическое расширение S2, сокращение набора данных на основе DeltaLoss и другие стратегии оптимизации, направленные на баланс точности и эффективности модели. Это знаменует собой развитие технологии визуальной языковой модели в более экономичном и эффективном направлении.

Недавно NVIDIA выпустила новое поколение модели открытого визуального языка — NVILA. Разработанный для оптимизации точности и эффективности, он стал лидером в области визуального искусственного интеллекта благодаря своей выдающейся производительности.

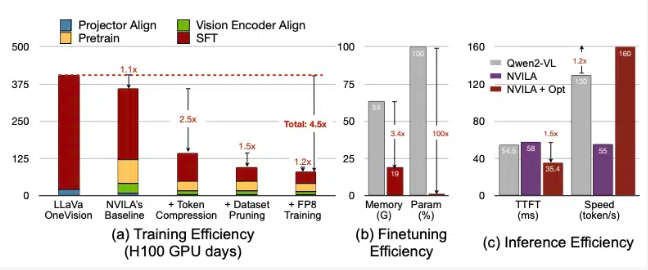

По данным NVIDIA, NVILA снижает затраты на обучение в 4,5 раза, уменьшает объем памяти, необходимой для тонкой настройки, в 3,4 раза и уменьшает задержки предварительного заполнения и декодирования почти в 2 раза. Эти данные сравниваются с другой крупной моделью машинного зрения, LLaVa OneVision.

В видеотестах NVILA превзошла GPT4o Mini, а также показала хорошие результаты в сравнении с GPT4o, Sonnet3.5 и Gemini1.5Pro. Кроме того, NVILA также одержала небольшую победу в сравнении с Llama3.2. Несмотря на это, в NVIDIA заявили, что модель еще не выпущена на платформу Hugging Face, и пообещали в ближайшее время выпустить код и модель, чтобы способствовать воспроизводимости модели.

NVIDIA отметила, что стоимость обучения моделей визуального языка очень высока. Для обучения модели визуального языка с 7 параметрами требуется около 400 дней использования графического процессора. В то же время точная настройка такой модели также требует большого объема памяти: для модели с параметрами 7B требуется более 64 ГБ памяти графического процессора.

Поэтому NVIDIA использует технику, называемую «расширение, затем сжатие», чтобы сбалансировать точность и эффективность модели. Вместо того, чтобы уменьшать размер фотографий и видео, модель использует несколько кадров из изображений и видео высокого разрешения, чтобы не потерять ни одной детали.

В процессе сжатия модель уменьшает размер входных данных, сжимая визуальную информацию в меньшее количество токенов и группируя пиксели для сохранения важной информации. В документе NVIDIA упомянула, что удвоение разрешения приведет к удвоению количества визуальных токенов, что увеличит затраты на обучение и вывод более чем в 2 раза. Поэтому они снижают эту стоимость за счет сжатия жетонов пространства/времени.

NVIDIA также продемонстрировала демонстрации некоторых моделей, а NVILA может ответить на несколько запросов на основе изображения или видео. Его выходные результаты также сравнивались с моделью VILA1.5, ранее выпущенной NVIDIA. Кроме того, NVIDIA также подробно представила некоторые другие технологии, такие как динамическое расширение S2, сокращение набора данных на основе DeltaLoss, квантование с точностью FP8 и т. д.

Эти методы применяются к модели с параметрами 8B, а конкретные детали можно просмотреть на Arxiv.

Вход для бумаги: https://arxiv.org/pdf/2412.04468.

Основные моменты:

? Модель NVILA снижает затраты на обучение в 4,5 раза, повышая эффективность визуального ИИ.

? Благодаря изображениям и видеокадрам высокого разрешения NVILA обеспечивает целостность входной информации.

? NVIDIA обещает вскоре выпустить код и модели, чтобы обеспечить воспроизводимость исследований.

В целом, появление NVILA открыло новые возможности для разработки моделей визуального языка. Ее эффективный процесс обучения и вывода снизит порог для приложений визуального ИИ и будет способствовать дальнейшему развитию в этой области. Мы с нетерпением ждем скорейшего раскрытия кода и моделей NVIDIA, чтобы больше исследователей могли принять участие и совместно способствовать развитию технологии визуального искусственного интеллекта.