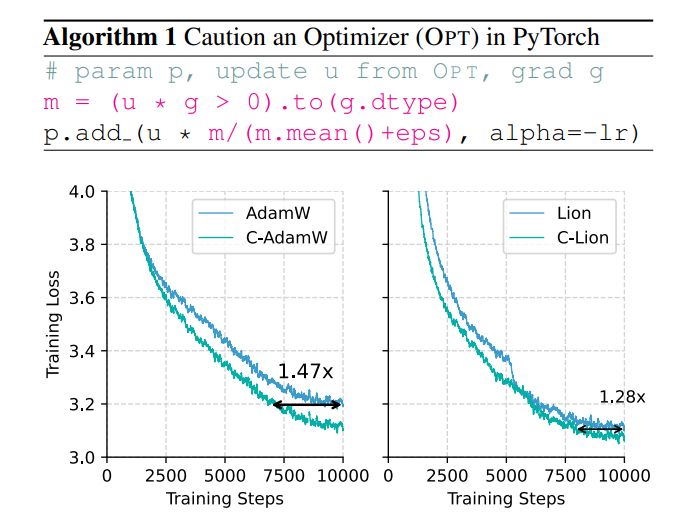

Проблемы эффективности и энергопотребления при обучении больших моделей становятся все более заметными, и традиционный оптимизатор AdamW не может справиться с огромным масштабом модели. Для решения этой проблемы китайская команда предложила новый оптимизатор под названием C-AdamW (Crudent AdamW). Основная идея C-AdamW — «думать, прежде чем действовать». Точно определяя направление обновления, модель может избежать траты ресурсов на неправильном пути, тем самым повышая скорость обучения и снижая энергопотребление. Этот оптимизатор повышает скорость обучения до 1,47 раз при предварительном обучении Llama и MAE практически без дополнительных вычислительных затрат и может быть достигнут с помощью простых модификаций существующего кода.

В мире искусственного интеллекта «Сила может творить чудеса» кажется золотым правилом. Чем больше модель, чем больше данных и чем сильнее вычислительная мощность, тем ближе она к Святому Граалю интеллекта. Однако за этим быстрым развитием стоит также огромное давление на стоимость и потребление энергии.

Чтобы сделать обучение ИИ более эффективным, ученые искали более мощные оптимизаторы, такие как тренер, который будет управлять параметрами модели для непрерывной оптимизации и в конечном итоге достижения наилучшего состояния. AdamW, оптимизатор по умолчанию для предварительного обучения Transformer, уже много лет является эталоном в отрасли. Однако перед лицом все более крупного масштаба модели AdamW также начал казаться неспособным справиться со своими ограничениями.

Нет ли способа увеличить скорость тренировки, одновременно снизив энергопотребление? Не волнуйтесь, здесь присутствует полностью китайская команда со своим «секретным оружием» C-AdamW!

Полное имя C-AdamW — «Осторожный АдамW», а его китайское название — «Осторожный АдамW», не правда ли, это звучит очень «буддистски»? Да, основная идея C-AdamW — «думай, прежде чем действовать».

Представьте, что параметры модели подобны группе энергичных детей, которые все время хотят побегать. AdamW подобен преданному своему делу учителю, пытающемуся направить их в правильном направлении. Но иногда дети слишком волнуются и бегут не в том направлении, тратя время и силы.

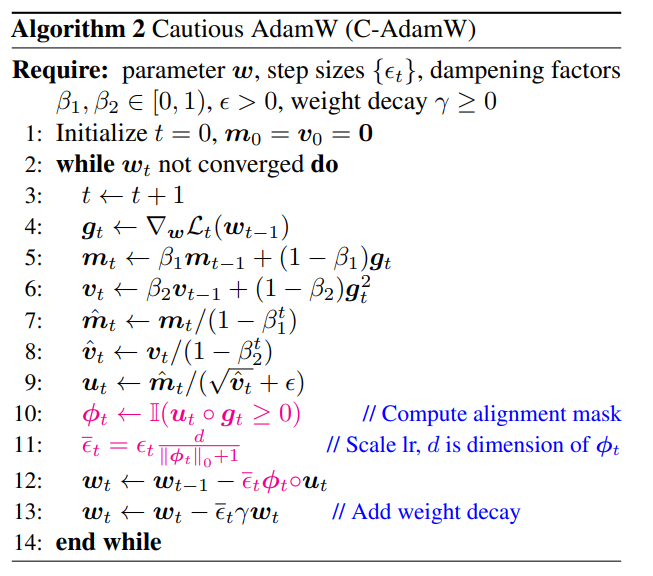

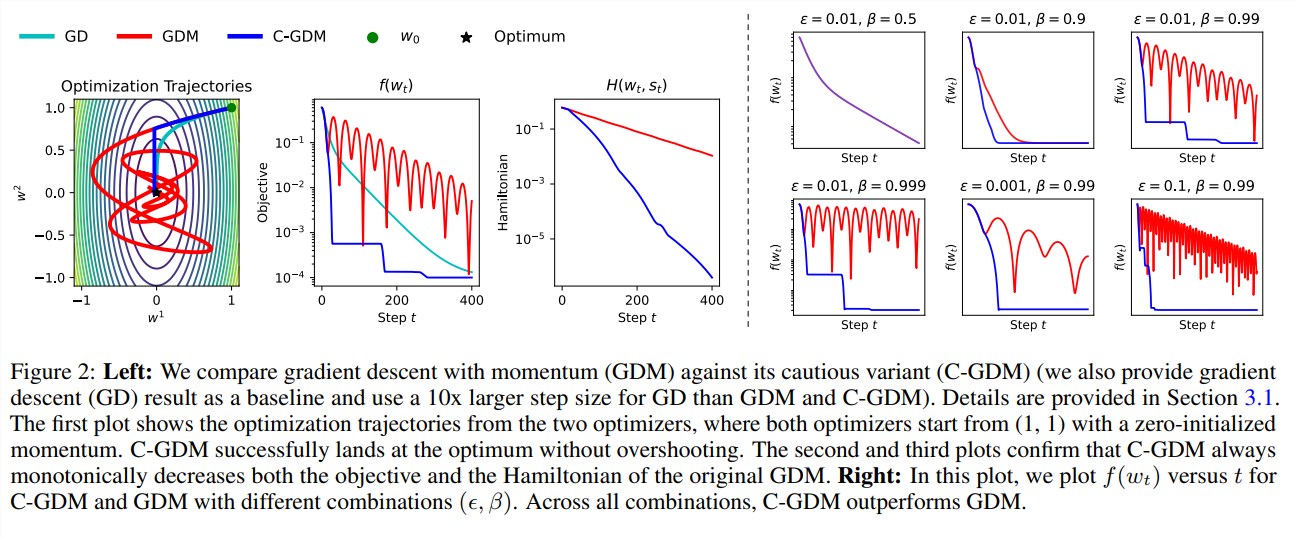

В настоящее время C-AdamW подобен мудрому старейшине с парой «пламенных глаз», которые могут точно определить правильность направления обновления. Если направление неверное, C-AdamW решительно остановит движение, чтобы модель не пошла дальше по неверному пути.

Эта «осторожная» стратегия гарантирует, что каждое обновление может эффективно уменьшить функцию потерь, тем самым ускоряя сходимость модели. Результаты экспериментов показывают, что C-AdamW увеличивает скорость тренировки в 1,47 раза при предварительной тренировке Llama и MAE!

Что еще более важно, C-AdamW практически не требует дополнительных вычислительных затрат и может быть реализован с помощью простой однострочной модификации существующего кода. Это означает, что разработчики могут легко применять C-AdamW для обучения различных моделей и наслаждаться «скоростью и страстью»!

«Буддийский» аспект C-AdamW заключается в том, что он сохраняет гамильтонову функцию Адама и не разрушает гарантию сходимости в рамках анализа Ляпунова. Это означает, что C-AdamW не только быстрее, но и его стабильность гарантирована, и не будет никаких проблем, таких как сбои при обучении.

Конечно, «буддист» не значит «не амбициозный». Исследовательская группа заявила, что они продолжат изучать более широкие функции φ и применять маски в пространстве признаков, а не в пространстве параметров, чтобы еще больше повысить производительность C-AdamW.

Ожидается, что C-AdamW станет новым фаворитом в области глубокого обучения, внеся революционные изменения в обучение больших моделей!

Адрес статьи: https://arxiv.org/abs/2411.16085.

Гитхаб:

https://github.com/kyleliang919/C-Optim

Появление C-AdamW обеспечивает новый подход к решению проблем эффективности и энергопотребления при обучении больших моделей. Его высокая эффективность и низкая стоимость делают его имеющим широкие перспективы применения, и стоит с нетерпением ждать его развития в этой области. глубокого обучения в будущем.