Исследовательский институт Чжиюань и Tencent совместно выпустили LongBench v2, платформу эталонного тестирования для оценки возможностей понимания и рассуждения длинного текста в больших языковых моделях (LLM). LongBench v2 значительно увеличивает длину текста и сложность оценки, включая 503 сложных вопроса с четырьмя вариантами ответов и несколькими вариантами ответов, что затрудняет получение высокой точности за короткое время даже экспертами-людьми. Тест охватывает шесть основных категорий задач и включает усовершенствования методологии оценки для повышения надежности и точности результатов. Этот шаг направлен на содействие развитию больших языковых моделей в обработке длинных текстов и предоставление более эффективного инструмента оценки для соответствующих исследований.

На пресс-конференции 19 декабря 2024 года Исследовательский институт Чжиюань и Tencent объявили о запуске LongBench v2, который предназначен для оценки глубокого понимания и рассуждения возможностей больших языковых моделей (LLM) в реальных многозадачных текстовых задачах. Разработаны эталоны. Платформа призвана способствовать прогрессу моделей длинного текста в понимании и рассуждении и отвечает на текущие проблемы в применении моделей длинного текста и больших языковых моделей.

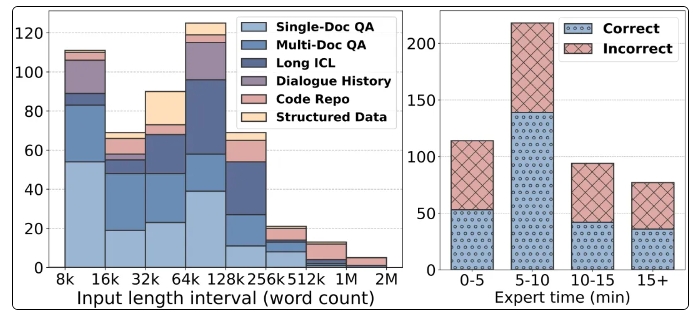

Примечательные особенности LongBench v2 включают поддержку более длинных текстов, от 8 тысяч до 2 миллионов слов, и содержат 503 сложных вопроса с четырьмя вариантами ответов и несколькими вариантами ответов с более высокой сложностью, даже со средней точностью экспертов-людей за 15 минут. Показатель составляет всего 53,7% . Кроме того, тест охватывает шесть основных категорий задач, включая вопросы и ответы по одному документу, вопросы и ответы по нескольким документам, изучение длинного текстового контекста и т. д., обеспечивая широкий спектр сценариев применения.

Чтобы обеспечить надежность оценки, все вопросы в LongBench v2 представлены в форме вопросов с несколькими вариантами ответов и проходят строгий ручной процесс аннотирования и проверки. В процессе сбора данных были наняты аннотаторы из ведущих университетов, чтобы гарантировать качество и сложность вопросов. Вводя контрольные переменные, LongBench v2 улучшает исходный статистический алгоритм Брэдли-Терри, уменьшая влияние мешающих факторов и делая ранжирование моделей более научным и точным.

Что касается результатов оценки, исследовательская группа протестировала 10 LLM с открытым исходным кодом и 6 LLM с закрытым исходным кодом и обнаружила, что производительность модели значительно улучшилась после введения контрольных переменных. В частности, модель GPT-4o хорошо справляется с такими задачами, как ответы на вопросы из нескольких документов и изучение длинного текстового контекста после введения большего количества шагов рассуждения, что показывает важность возможностей рассуждения.

Запуск LongBench v2 не только предоставляет новый инструмент для оценки больших языковых моделей, но также указывает направление будущих исследований, подчеркивая важность улучшения собственных возможностей понимания и рассуждения модели. Сотрудничество между исследовательским институтом Чжиюань и Tencent знаменует собой дальнейшее развитие в области технологий искусственного интеллекта. Ожидается, что этот эталонный тест может способствовать развитию технологий понимания и рассуждения длинных текстов.

Домашняя страница: https://longbench2.github.io

Статья: https://arxiv.org/abs/2412.15204.

Данные и код: https://github.com/THUDM/LongBench.

Выпуск LongBench v2 знаменует собой новый этап в оценке больших языковых моделей. Его более строгие стандарты оценки и более полный тестовый контент будут способствовать постоянному совершенствованию больших языковых моделей в плане понимания и рассуждения длинных текстов. Мы с нетерпением ожидаем появления в будущем новых результатов исследований на основе LongBench v2, которые будут способствовать дальнейшему развитию технологий искусственного интеллекта.