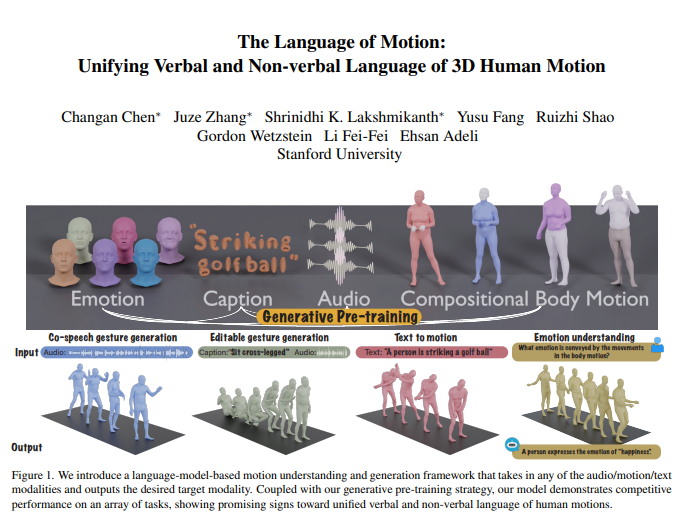

Команда Ли Фейфея недавно опубликовала революционный результат исследования: новую мультимодальную модель, которая может понимать и генерировать человеческие действия, а также умело комбинирует языковые модели для достижения единой обработки вербальной и невербальной речи. Это нововведение не только позволяет машинам понимать человеческие инструкции, но и интерпретировать эмоции, стоящие за действиями, тем самым достигая более естественного и плавного взаимодействия человека с компьютером. Ядро модели лежит в структуре мультимодальной языковой модели, которая может интегрировать несколько входных данных, таких как звук, движение и текст, и выводить соответствующие модальные данные. Он хорошо справляется с такими задачами, как совместная генерация речевых жестов, значительно уменьшает объем данных, необходимых для обучения модели, и расширяет новые сценарии применения, такие как генерация редактируемых жестов и прогнозирование эмоций с помощью действий.

Команда Ли Фейфэя запустила новую мультимодальную модель, которая может понимать и генерировать действия человека, а за счет объединения языковых моделей достигается унифицированная обработка вербального и невербального языка. Это революционное исследование позволяет машинам не только понимать человеческие инструкции, но и считывать эмоции, содержащиеся в действиях, обеспечивая более естественное взаимодействие человека и компьютера.

Ядро модели лежит в структуре мультимодальной языковой модели, которая может принимать различные формы ввода, такие как звук, движение и текст, и выводить необходимые модальные данные. В сочетании с генеративной стратегией предварительного обучения модель демонстрирует отличную производительность при выполнении множества задач. Например, при совместной генерации речевых жестов модель не только превосходит современные достижения, но и значительно сокращает объем данных, необходимых для обучения. Кроме того, модель также открывает новые сценарии применения, такие как генерация редактируемых жестов и прогнозирование эмоций посредством действий.

Человеческое общение носит мультимодальный характер и включает в себя вербальные и невербальные сигналы, такие как речь, мимика и поза тела. Способность этой модели понимать такое мультимодальное поведение имеет решающее значение для создания виртуальных персонажей, которые естественным образом общаются в таких приложениях, как игры, фильмы и виртуальная реальность. Однако существующие модели генерации действий часто ограничиваются конкретными модальностями ввода (речь, текст или данные действия) и не могут в полной мере использовать разнообразие доступных данных.

Эта модель использует языковые модели для объединения вербального и невербального языка по трем основным причинам:

Языковые модели естественным образом соединяют различные модальности.

Речь очень семантическая, и такие задачи, как моделирование ответов на шутки, требуют сильных способностей семантического мышления.

Языковая модель приобретает сильные возможности семантического понимания благодаря обширной предварительной подготовке.

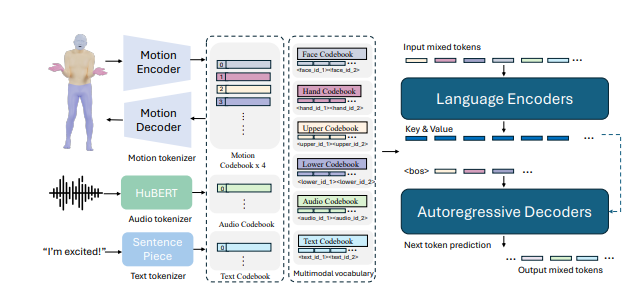

Чтобы добиться этого, исследовательская группа сначала разделила тело на разные части (лицо, руки, верхнюю часть тела, нижнюю часть тела) и пометила каждую часть индивидуально для движения. Комбинируя текстовые и речевые токенизаторы, ввод в любой модальности может быть представлен как серия токенов для использования языковыми моделями. В модели используется двухэтапный процесс обучения: первая предварительная тренировка для достижения согласованности различных модальностей с комбинированными движениями тела, а также согласования звука и текста. После этого последующие задачи преобразуются в инструкции, и модель обучается этим инструкциям, чтобы она могла следовать различным инструкциям по задачам.

Модель показала хорошие результаты в тесте совместной генерации речевых жестов BEATv2, намного превзойдя существующие модели. Эффект стратегии предварительной подготовки также был проверен, особенно когда данных недостаточно, что свидетельствует о сильной способности к обобщению. После обучения задачам речевого и текстового действия модель может не только следовать звуковым и текстовым подсказкам, но и выполнять новые функции, такие как прогнозирование эмоций на основе данных о действиях.

Если говорить о технических деталях, то в модели используются токенизаторы, специфичные для модальности, для обработки различных модальностей ввода. В частности, модель тренирует комбинированное движение тела VQ-VAE, которое преобразует движения лица, рук, верхней части тела и нижней части тела в дискретные маркеры. Эти специфичные для модальности словари (аудио и текст) объединяются в единый мультимодальный словарь. Во время обучения в качестве входных данных используются смешанные токены разных модальностей, а выходные данные генерируются языковой моделью кодера-декодера.

Модель также использует мультимодальный словарь для преобразования различных модальных данных в единый формат для обработки. На этапе предварительного обучения модель изучает соответствие между различными модальностями, выполняя задачи преобразования между модальностями. Например, модель может научиться переводить движения верхней части тела в движения нижней части тела или преобразовывать звук в текст. Кроме того, модель изучает временную эволюцию действий, случайным образом маскируя определенные кадры действий.

На этапе после обучения модель настраивается с использованием парных данных для выполнения последующих задач, таких как совместная генерация речевых жестов или генерация текста в действие. Чтобы модель могла следовать естественным человеческим инструкциям, исследователи создали шаблон многозадачных инструкций, который преобразует такие задачи, как звук в действие, текст в действие и эмоции в действие, в инструкции. Модель также имеет возможность редактировать жесты для создания скоординированных движений всего тела на основе текстовых и звуковых сигналов.

Наконец, модель также открывает новые возможности прогнозирования эмоций от действий. Это имеет важные последствия для таких областей, как психическое здоровье или психиатрия. Эта модель способна более точно предсказывать эмоции, выражаемые в действиях, чем другие модели, демонстрируя сильные способности понимания языка тела.

Исследование показывает, что объединение вербального и невербального языка человеческих действий имеет решающее значение для практических приложений, а языковые модели обеспечивают для этого мощную основу.

Адрес статьи: https://arxiv.org/pdf/2412.10523v1.

В целом, это исследование принесло значительный прогресс в области мультимодального искусственного интеллекта. Потенциал его применения во взаимодействии человека с компьютером, создании виртуальных персонажей и распознавании эмоций огромен и заслуживает дальнейшего внимания и исследований. Ожидается, что в будущем эта модель сыграет роль в большем количестве областей и будет способствовать развитию технологий искусственного интеллекта.