Обучение крупных моделей искусственного интеллекта обходится дорого, а огромные потребности в ресурсах ограничивают их широкое применение и вызывают обеспокоенность по поводу энергоэффективности и воздействия на окружающую среду. Традиционные методы обучения неэффективны, основаны на плотных матрицах и требуют больших объемов памяти и вычислительной мощности. Хотя некоторые существующие методы пытаются облегчить эти проблемы, они все еще имеют ограничения в практическом применении. Поэтому крайне важно разработать подход, который сможет одновременно сократить использование памяти, вычислительные затраты и время обучения без ущерба для производительности.

Обучение крупномасштабных моделей ИИ (таких как Трансформеры и языковые модели) стало незаменимым ключевым звеном в области ИИ, но оно также сталкивается с высокими вычислительными затратами, потреблением памяти и требованиями к энергии. Например, GPT-3 OpenAI имеет 175 миллиардов параметров и требует недель обучения графического процессора. Эта огромная потребность в ресурсах ограничивает применение этой технологии в крупных организациях, богатых вычислительными ресурсами, а также усугубляет обеспокоенность по поводу энергоэффективности и воздействия на окружающую среду. Решение этих проблем имеет решающее значение для обеспечения более широкой доступности и устойчивости развития ИИ.

Традиционные методы обучения неэффективны, и срочно необходимы инновационные решения.

Платформа CoMERA: эффективное обучение посредством адаптивной тензорной оптимизации

В основе CoMERA лежит адаптивное тензорное представление, которое позволяет слоям модели динамически корректировать свои ранги в зависимости от ограничений ресурсов. Изменяя ранг тензора, платформа обеспечивает сжатие без ущерба для операционной целостности нейронной сети. Такая динамическая оптимизация достигается посредством двухэтапного процесса обучения:

Ранние стадии: сосредоточьтесь на стабильной конвергенции.

Последующие этапы: точная настройка ранга для достижения конкретных целей сжатия.

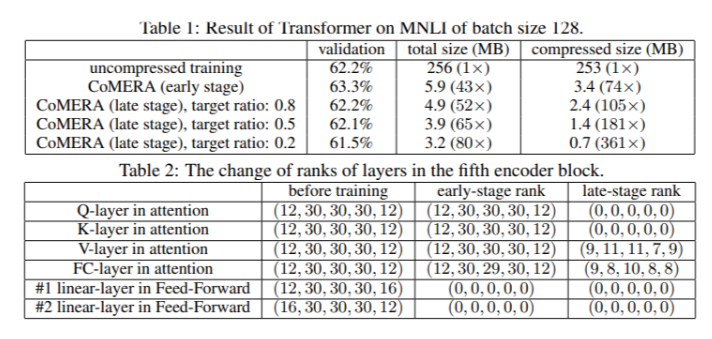

В модели Transformer с шестью кодировщиками компания CoMERA достигла степени сжатия до 43x на ранних этапах и еще более высокой степени сжатия до 361x на более поздних этапах оптимизации. Кроме того, он снижает потребление памяти в 9 раз и увеличивает скорость обучения за раунд в 2-3 раза по сравнению с GaLore.

Результаты многочисленных испытаний показывают, что CoMERA имеет превосходные характеристики.

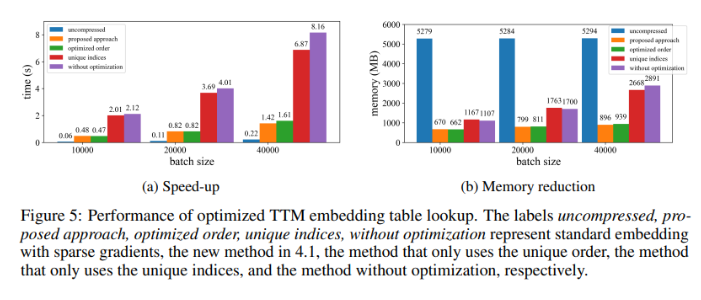

При применении к модели Transformer, обученной на наборе данных MNLI, CoMERA уменьшает размер модели с 256 МБ до 3,2 МБ, сохраняя при этом точность. В крупномасштабных рекомендательных системах, таких как DLRM, CoMERA сжимает модели в 99 раз и снижает пиковое использование памяти в 7 раз. Платформа также показала хорошие результаты при предварительном обучении CodeBERT, предметно-ориентированной крупномасштабной языковой модели, достигнув общего коэффициента сжатия 4,23x и достигнув двукратного ускорения на некоторых этапах обучения. Эти результаты подчеркивают его способность справляться с различными задачами и архитектурами, расширяя его применимость в различных областях.

Краткое изложение основных преимуществ системы CoMERA

Основные выводы данного исследования заключаются в следующем:

CoMERA обеспечивает степень сжатия до 361x для отдельных слоев и 99x для всей модели, что значительно снижает требования к хранению и памяти.

Этот фреймворк сокращает время обучения каждого раунда Трансформера и рекомендательных систем в 2-3 раза, экономя вычислительные ресурсы и время.

Используя тензоризованные представления и графики CUDA, CoMERA снижает пиковое потребление памяти в 7 раз, делая возможным обучение на графических процессорах меньшего размера.

Подход CoMERA поддерживает несколько архитектур, включая трансформеры и большие языковые модели, сохраняя или повышая точность.

Сокращая энергию и ресурсы, необходимые для обучения, CoMERA помогает обеспечить более устойчивые методы искусственного интеллекта и делает передовые модели доступными для более широкой аудитории.

В целом платформа CoMERA представляет собой революционное решение для эффективного обучения больших моделей искусственного интеллекта, которое значительно снижает вычислительные затраты и требования к памяти за счет адаптивной тензорной оптимизации, сохраняя при этом точность модели. Это исследование вносит важный вклад в дальнейшее развитие и более широкую доступность области ИИ.