Magic Square Quantitative недавно выпустила новое поколение большой модели DeepSeek-V3. Ее масштаб в 671 миллиард параметров и архитектура MoE делают ее производительность сопоставимой с лучшими моделями с закрытым исходным кодом. Она также обладает характеристиками низкой стоимости и высокой эффективности, что привлекло широкое распространение. внимание в отрасли. DeepSeek-V3 показал хорошие результаты во многих тестах, особенно превзойдя все существующие модели в тесте на математические способности, и предоставляет услуги API по цене, значительно более низкой, чем такие модели, как GPT-4, предоставляя разработчикам и предприятиям экономически эффективное решение для искусственного интеллекта. В этой статье будут подробно проанализированы производительность, стоимость и стратегия коммерциализации DeepSeek-V3, а также обсуждено его влияние на индустрию искусственного интеллекта.

Вечером 26 декабря Magic Square Quantitative выпустила новое поколение большой модели DeepSeek-V3, продемонстрировав потрясающий технологический прорыв. Эта модель, использующая архитектуру MoE (Mixed Experts), не только сравнима по производительности с лучшими моделями с закрытым исходным кодом, но ее недорогие и высокоэффективные функции привлекли внимание отрасли.

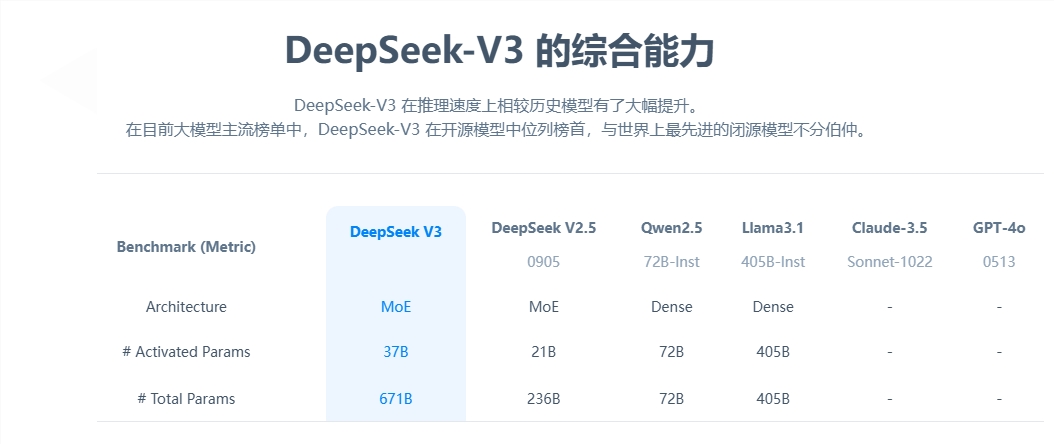

С точки зрения основных параметров DeepSeek-V3 имеет 671 миллиард параметров, из которых 37 миллиардов являются параметрами активации, и завершил предварительное обучение на масштабе данных в 14,8 триллионов токенов. По сравнению с продуктом предыдущего поколения, скорость генерации новой модели увеличена в 3 раза, и она может обрабатывать 60 токенов в секунду, что значительно повышает эффективность практических приложений.

С точки зрения оценки производительности DeepSeek-V3 показывает отличную прочность. Он не только превосходит известные модели с открытым исходным кодом, такие как Qwen2.5-72B и Llama-3.1-405B, но и находится на одном уровне с GPT-4 и Claude-3.5-Sonnet в многочисленных тестах. Особенно в тесте на математические способности модель превзошла все существующие модели с открытым и закрытым исходным кодом, показав отличные результаты.

Самое поразительное — это низкая стоимость DeepSeek-V3. Согласно документам с открытым исходным кодом, общая стоимость обучения модели составляет 2 доллара США за час графического процессора и составляет всего 5,576 миллиона долларов США. Этот прорывной результат стал возможным благодаря совместной оптимизации алгоритмов, инфраструктур и аппаратного обеспечения. Соучредитель OpenAI Карпати высоко оценил это, отметив, что DeepSeek-V3 достиг производительности, превзошедшей Llama3, всего за 2,8 миллиона графических часов, а эффективность вычислений увеличилась примерно в 11 раз.

С точки зрения коммерциализации, хотя цены на услуги API DeepSeek-V3 были увеличены по сравнению с предыдущим поколением, он по-прежнему сохраняет высокие показатели затрат. Цена новой версии составляет 0,5–2 юаня за миллион входных токенов и 8 юаней за миллион выходных токенов, общая стоимость которых составляет около 10 юаней. Для сравнения, эквивалентная цена услуги GPT-4 составляет около 140 юаней, а разница в ценах значительна.

В качестве комплексной крупной модели с открытым исходным кодом выпуск DeepSeek-V3 не только демонстрирует прогресс китайской технологии искусственного интеллекта, но также предоставляет разработчикам и предприятиям высокопроизводительное и недорогое решение искусственного интеллекта.

Появление DeepSeek-V3 знаменует собой крупный прорыв в китайской технологии искусственного интеллекта в области крупномасштабных языковых моделей. Его преимущества в низкой стоимости и высокой производительности делают его очень конкурентоспособным в коммерческих приложениях, и его будущее развитие стоит с нетерпением ждать. . Открытый исходный код этой модели также предоставляет ценные ресурсы мировому сообществу ИИ и способствует обмену и развитию технологий ИИ.