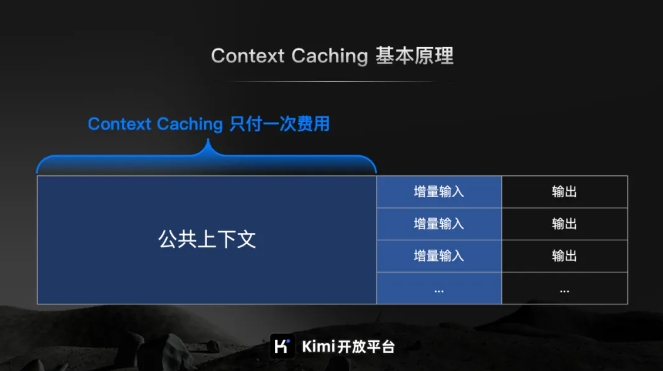

На открытой платформе Kimi скоро начнется долгожданное внутреннее тестирование функции контекстного кэширования. Эта инновационная технология значительно улучшит взаимодействие с пользователем при работе с большими текстовыми моделями. Кэшируя дублирующийся контент токенов, контекстное кэширование может значительно снизить затраты пользователей, запрашивающих один и тот же контент, и значительно повысить скорость ответа интерфейса API. Это особенно важно для сценариев приложений, которые требуют частых запросов и повторных ссылок на большое количество исходных контекстов, таких как крупномасштабные и часто повторяющиеся сценарии подсказок.

Новости с сайта ChinaZ.com от 20 июня: Kimi Open Platform недавно объявила, что долгожданная функция контекстного кэширования скоро начнет внутреннее тестирование. Эта инновационная функция будет поддерживать большие модели длинного текста и предоставит пользователям беспрецедентные возможности благодаря эффективному механизму кэширования контекста.

Согласно официальному представлению открытой платформы Kimi, кэширование контекста — это передовая технология, предназначенная для значительного снижения затрат пользователей, запрашивающих один и тот же контент, путем кэширования дублированного контента токенов. Принцип его работы заключается в интеллектуальном выявлении и сохранении обработанных фрагментов текста. При повторном запросе пользователя система может быстро извлечь его из кэша, что значительно повышает скорость ответа интерфейса API.

Для крупномасштабных и часто повторяющихся сценариев подсказок преимущества функции кэширования контекста особенно значительны. Он может быстро реагировать на большое количество частых запросов и значительно повысить эффективность обработки, одновременно сокращая затраты за счет повторного использования кэшированного контента.

Особо стоит отметить, что функция «Кэширование контекста» особенно подходит для сценариев приложений, требующих частых запросов и повторных обращений к большому количеству исходных контекстов. Благодаря этой функции пользователи могут легко реализовать эффективное кэширование контекста, тем самым повышая эффективность работы и снижая эксплуатационные расходы.

Скоро начнется внутреннее тестирование функции контекстного кэширования, что знаменует собой важный шаг, сделанный открытой платформой Kimi в повышении эффективности больших моделей и снижении затрат пользователей. Будущее многообещающее.