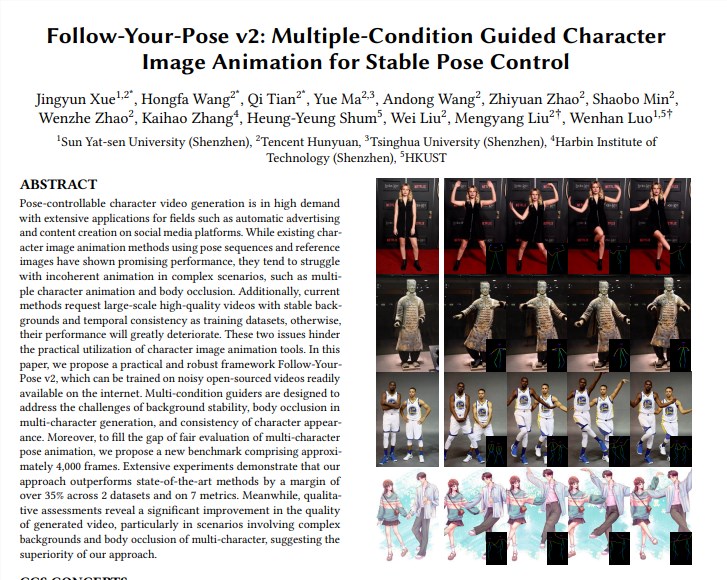

Команда Tencent Hunyuan объединила усилия с Университетом Сунь Ятсена и Гонконгским университетом науки и технологий, чтобы запустить новую видеомодель Tusheng «Follow-Your-Pose-v2», совершив прорыв в технологии генерации видео от одного до нескольких человек. Эта модель может обрабатывать групповые фотографии нескольких людей и заставлять людей на фотографиях одновременно двигаться в сгенерированном видео, что значительно повышает эффективность и качество создания видео. Изюминкой ее технологии является то, что она поддерживает генерацию видеодействий с участием нескольких человек, обладает сильными возможностями обобщения, может обучаться и генерироваться с использованием фотографий/видео из повседневной жизни, а также может правильно решать такие проблемы, как перекрытие персонажей. Модель превосходит существующие методы на нескольких наборах данных, демонстрируя свою высокую производительность и широкие перспективы применения.

Поддержка создания видеодействий для нескольких человек: реализуйте создание видеодействий для нескольких человек с меньшими затратами времени на рассуждения.

Сильная способность к обобщению: высококачественные видеоролики можно создавать независимо от возраста, одежды, расы, фонового беспорядка или сложности действий.

Доступны фотографии/видео из повседневной жизни. При обучении и создании моделей можно использовать фотографии или видео из повседневной жизни (включая снимки) или видео, не ища высококачественных изображений/видео.

Правильно обрабатывайте окклюзию персонажей. Столкнувшись с проблемой, когда тела нескольких персонажей перекрывают друг друга на одном изображении, можно создать изображение окклюзии с правильным соотношением спереди и сзади.

Техническая реализация:

Модель использует «направитель оптического потока» для представления информации о фоновом оптическом потоке, которая может генерировать стабильную фоновую анимацию, даже когда камера трясется или фон нестабильен.

С помощью «Руководства по карте вывода» и «Руководства по карте глубины» модель может лучше понимать пространственную информацию персонажей на изображении и взаимоотношения пространственного положения нескольких персонажей, а также эффективно решать проблемы многосимвольной анимации и окклюзии тела. .

Оцените и сравните:

Команда предложила новый бенчмарк Multi-Character, который содержит около 4000 кадров многосимвольного видео для оценки эффекта генерации многосимволов.

Результаты экспериментов показывают, что «Follow-Your-Pose-v2» превосходит современную версию более чем на 35% по двум общедоступным наборам данных (выступления TikTok и TED) и 7 индикаторам.

Перспективы применения:

Технология преобразования изображения в видео имеет широкие перспективы применения во многих отраслях, таких как производство киноконтента, дополненная реальность, производство игр и реклама. Это одна из технологий искусственного интеллекта, которая привлечет большое внимание в 2024 году.

Дополнительная информация:

Команда Hunyuan из Tencent также анонсировала библиотеку ускорения для большой модели винсентианских графов с открытым исходным кодом (Hunyuan DiT), которая значительно повышает эффективность рассуждений и сокращает время создания графиков на 75%.

Порог использования модели Hunyuan DiT был снижен. Пользователи могут вызвать модель в официальной библиотеке моделей Hugging Face с помощью трех строк кода.

Адрес статьи: https://arxiv.org/pdf/2406.03035.

Страница проекта: https://top.aibase.com/tool/follow-your-pose

Появление модели «Follow-Your-Pose-v2» знаменует собой крупный прорыв в видеотехнологиях Tusheng, и перспективы ее применения во многих областях заслуживают ожидания. Считается, что в будущем, благодаря постоянному развитию и совершенствованию технологий, эта модель будет играть важную роль в большем количестве сценариев и предоставит людям более удобный и интеллектуальный опыт создания видео.