Эффект практического применения генеративных языковых моделей часто ограничивается стратегией декодирования на этапе вывода. Существующие методы, такие как RLHF, в основном ориентированы на вероятность выигрыша модели и игнорируют влияние стратегий декодирования на производительность модели, что приводит к низкой эффективности и трудностям в обеспечении качества вывода. Чтобы решить эту проблему, Google DeepMind и исследовательская группа Google предложили структуру InfAlign, целью которой является объединение стратегии вывода с процессом выравнивания модели для повышения производительности вывода и надежности модели.

Модели генеративного языка сталкиваются со многими проблемами в процессе обучения до практического применения. Один из основных вопросов заключается в том, как добиться оптимальной производительности модели на этапе вывода.

Текущие контрмеры, такие как обучение с подкреплением посредством обратной связи с человеком (RLHF), в основном направлены на повышение вероятности выигрыша модели, но часто игнорируют стратегии декодирования во время вывода, такие как выборка Best-of-N и контролируемое декодирование. Этот разрыв между целями обучения и фактическим использованием может привести к неэффективности и повлиять на качество и надежность результатов.

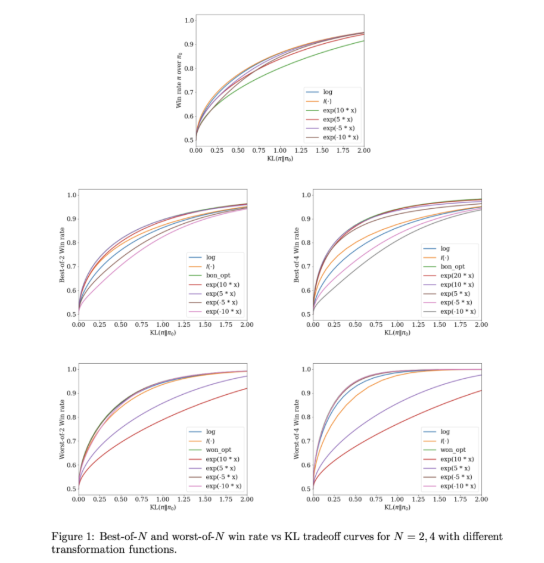

Чтобы решить эти проблемы, Google DeepMind и исследовательская группа Google разработали InfAlign, платформу машинного обучения, предназначенную для объединения со стратегиями вывода. InfAlign включает методы времени вывода в процесс согласования и стремится сократить разрыв между обучением и применением. Он использует калиброванный метод обучения с подкреплением для настройки функции вознаграждения на основе конкретной стратегии вывода. InfAlign особенно эффективен с такими методами, как выборка Best-of-N (генерация нескольких ответов и выбор лучшего) и Worst-of-N (обычно используется при оценке безопасности), гарантируя, что согласованная модель работает как в контролируемых средах, так и в реальных условиях. - мировые сценарии хороши.

Ядром InfAlign является алгоритм обучения с подкреплением калибровки и преобразования (CTRL), который выполняет три этапа: калибровку оценок вознаграждения, преобразование этих оценок в соответствии со стратегией вывода и решение задачи регуляризованной оптимизации KL. InfAlign согласовывает цели обучения с требованиями вывода, адаптируя преобразования вознаграждения к конкретным сценариям. Этот метод не только повышает вероятность выигрыша во время вывода, но и сохраняет эффективность вычислений. Кроме того, InfAlign повышает надежность модели, позволяя ей эффективно справляться с различными стратегиями декодирования и обеспечивать стабильно высокое качество вывода.

Эффективность InfAlign проверена в экспериментах с использованием наборов данных о полезности и безвредности Anthropic. По сравнению с существующими методами InfAlign повышает вероятность успешного вывода на 8–12 % при выборке «Лучший из N» и на 4–9 % при оценке безопасности «Наихудший из N». Эти улучшения обусловлены калиброванным преобразованием вознаграждения, которое эффективно решает проблему неправильной калибровки модели вознаграждения и обеспечивает стабильную производительность в различных сценариях вывода.

InfAlign представляет собой важный шаг вперед в согласовании моделей генеративного языка. Внедряя стратегии, учитывающие логические выводы, InfAlign устраняет критическую разницу между обучением и развертыванием. Его прочная теоретическая основа и эмпирические результаты подчеркивают его потенциал для всестороннего улучшения согласованности систем искусственного интеллекта.

Ссылка: https://arxiv.org/abs/2412.19792.

Основные моменты:

InfAlign — это новая платформа, разработанная Google DeepMind, целью которой является повышение производительности языковых моделей на этапе вывода.

Эта структура корректирует функцию вознаграждения стратегии вывода с помощью калиброванных методов обучения с подкреплением для достижения согласования между целями обучения и требованиями вывода.

Результаты экспериментов показывают, что InfAlign значительно повышает вероятность выигрыша модели в нескольких задачах, демонстрируя хорошую адаптивность и надежность.

Появление платформы InfAlign дает новые идеи для решения проблем эффективности и качества генеративных языковых моделей на этапе вывода. Ее вклад в повышение устойчивости и надежности моделей заслуживает внимания. Будущие исследования могут дополнительно изучить применение InfAlign на различных моделях и задачах, чтобы способствовать дальнейшему развитию технологий генеративного искусственного интеллекта.