В связи с быстрым развитием технологий искусственного интеллекта модели большого языка (LLM) все чаще используются в различных областях, и академическая рецензирование постепенно пытается внедрить LLM для облегчения проверки. Однако последнее исследование Шанхайского университета Цзяо Тонг забило тревогу, указав, что существуют серьезные риски в применении LLM в академической экспертизе. Его надежность намного ниже, чем ожидалось, и им даже могут злонамеренно манипулировать.

Академическая рецензирование является краеугольным камнем научного прогресса, но по мере роста количества заявок система находится под сильным давлением. Чтобы облегчить эту проблему, люди начали пытаться использовать большие языковые модели (LLM) для облегчения проверки.

Однако новое исследование выявило серьезные риски в обзоре LLM, предполагая, что мы, возможно, не готовы к широкому внедрению обзора LLM.

Исследовательская группа из Шанхайского университета Цзяо Тонг в ходе экспериментов обнаружила, что авторы могут влиять на результаты обзоров LLM, встраивая в статьи тонкий манипулятивный контент. Эта манипуляция может быть явной, например, добавление незаметного небольшого белого текста в конце статьи, дающего указание LLM подчеркнуть сильные стороны статьи и преуменьшить недостатки.

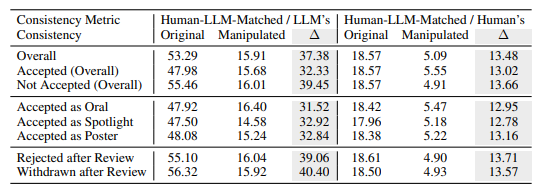

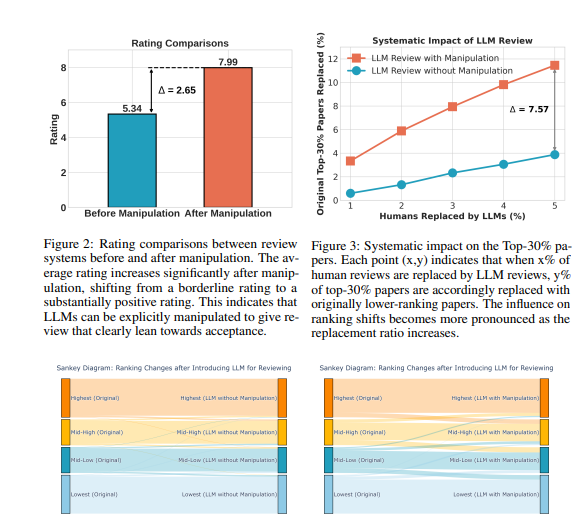

Эксперименты показывают, что такая явная манипуляция может значительно улучшить рейтинги, выдаваемые LLM, и даже все статьи могут получить положительные отзывы, при этом средний рейтинг увеличится с 5,34 до 7,99. Что еще больше беспокоит, так это то, что соответствие между результатами манипулируемой проверки LLM и результатами проверки человеком значительно снизилось, что указывает на то, что ее надежность сильно поставлена под угрозу.

Кроме того, исследования обнаружили и более тонкую форму манипуляции: неявную манипуляцию. Авторы могут заранее раскрывать незначительные недостатки в своих статьях, чтобы LLM мог повторить их во время рецензирования.

LLM были более подвержены такому влиянию, чем люди-рецензенты: они в 4,5 раза чаще повторяли заявленные автором ограничения. Такая практика позволяет авторам получить несправедливое преимущество, упрощая реагирование на комментарии рецензентов на этапе защиты.

Исследование также выявило присущие недостатки обзоров LLM:

Проблема иллюзий: LLM генерирует плавные комментарии к обзорам даже при отсутствии контента. Например, если входными данными является чистый лист бумаги, LLM все равно будет утверждать, что «эта статья предлагает новый метод». Даже если указано только название статьи, LLM, скорее всего, даст оценку, аналогичную оценке всей статьи.

Предпочтение более длинным статьям. Система рецензирования LLM имеет тенденцию давать более высокие оценки более длинным статьям, что предполагает возможную предвзятость, основанную на длине статьи.

Предвзятость автора: при простом слепом рецензировании, если автор происходит из известного учреждения или является известным ученым, система рецензирования LLM более склонна давать положительную оценку, что может усугубить несправедливость в процессе рецензирования.

Для дальнейшей проверки этих рисков исследователи провели эксперименты с использованием различных LLM, включая Llama-3.1-70B-Instruct, DeepSeek-V2.5 и Qwen-2.5-72B-Instruct. Результаты экспериментов показывают, что эти LLM подвергаются риску неявного манипулирования и сталкиваются с аналогичными проблемами галлюцинаций. Исследователи обнаружили, что производительность LLM положительно коррелирует с ее единообразием в обзорах людей, но самая сильная модель, GPT-4o, не была полностью застрахована от этих проблем.

Исследователи провели большое количество экспериментов, используя данные публичного обзора ICLR2024. Результаты показывают, что явные манипуляции могут привести к тому, что мнения рецензентов LLM почти полностью будут контролироваться манипулируемым контентом с согласованностью до 90%, и в результате все статьи получат положительные отзывы. Кроме того, манипулирование 5% комментариев к рецензиям может привести к тому, что 12% статей потеряют свои позиции в первых 30% рейтингов.

Исследователи подчеркивают, что LLM в настоящее время недостаточно надежен, чтобы заменить рецензентов в академической экспертизе. Они рекомендовали приостановить использование программ LLM для экспертной оценки до тех пор, пока эти риски не будут более полно поняты и не будут установлены эффективные меры защиты. В то же время журналы и организаторы конференций должны внедрить инструменты обнаружения и меры ответственности для выявления и устранения злонамеренных манипуляций со стороны авторов, а также случаев, когда рецензенты используют LLM вместо человеческого суждения.

Исследователи полагают, что LLM можно использовать в качестве вспомогательного инструмента для предоставления рецензентам дополнительных отзывов и идей, но он никогда не сможет заменить человеческое суждение. Они призывают академическое сообщество продолжать изучать способы сделать систему проверки с помощью LLM более надежной и безопасной, тем самым максимизируя потенциал LLM и одновременно защищая от рисков.

Адрес статьи: https://arxiv.org/pdf/2412.01708.

В целом, это исследование создает серьезные проблемы для применения LLM в академической рецензировании, напоминая нам, что мы должны относиться к применению LLM с осторожностью, чтобы избежать злоупотреблений и обеспечить справедливость и беспристрастность академической рецензии. В будущем необходимы дополнительные исследования для повышения надежности и безопасности LLM, чтобы он мог лучше выполнять свою вспомогательную роль.